爬虫的概念

**网络爬虫**(WebCrawler),也称为**网络蜘蛛**(WebSpider)或**网络机器人**(WebRobot),是一种自动化程序或脚本,其主要功能是按照一定的规则,自动地抓取和浏览互联网上的信息。爬虫通常用于搜索引擎,通过访问不同的网页,抓取内容并建立索引,从而使用户能够通过搜索引擎快速找到所需的信息。

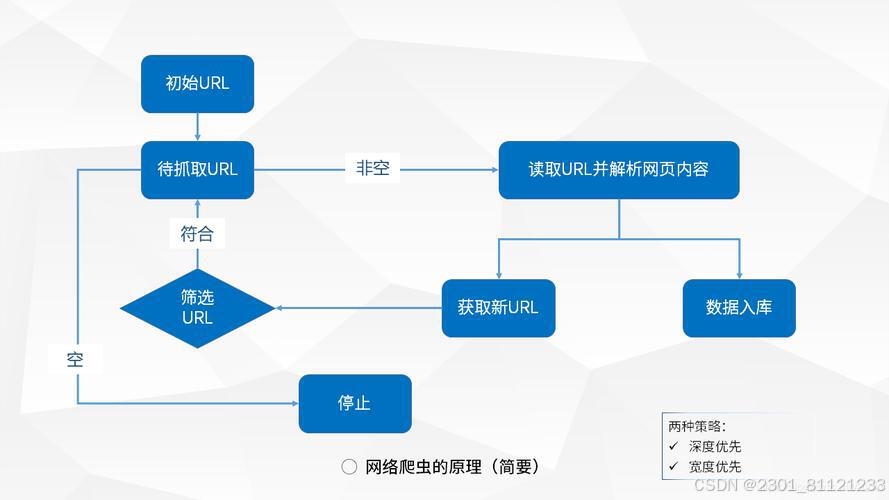

爬虫的工作原理

爬虫的工作原理可以简单地概括为以下几个步骤:

1.**种子URL选择**:

爬虫从一个或多个初始网页的URL(称为“种子URL”)开始工作。这些URL是爬虫开始抓取的起点。

2.**网页下载**:

爬虫访问这些URL对应的网页,并下载网页的内容。下载的内容通常是HTML格式,但也可能包括图片、视频等其他资源。

3.**解析网页内容**:

爬虫解析下载的网页内容,提取出其中的文本信息、链接以及其他有用的数据。解析网页通常使用HTML解析器来分析网页结构。

4.**提取新链接**:

爬虫从解析的网页中提取出所有新的URL链接,并将这些链接加入到待抓取的URL列表中。

5.**重复抓取**:

爬虫从待抓取的URL列表中选择下一个URL,重复步骤2到步骤4,直到满足某种停止条件(例如,抓取了一定数量的网页,或者所有可访问的网页都已被抓取)。

6.**数据存储与索引**:

爬虫将抓取到的有用信息进行存储,并可能建立索引,以便后续检索和分析。

###爬虫的关键技术

1.**URL管理**:

爬虫需要有效地管理已经访问过的URL和待访问的URL,以避免重复抓取和循环抓取。

2.**网页解析**:

爬虫需要能够解析各种格式的网页内容,包括HTML、XML、JSON等。

3.**抓取策略**:

爬虫需要根据一定的策略决定抓取的顺序和优先级,例如广度优先、深度优先、PageRank等。

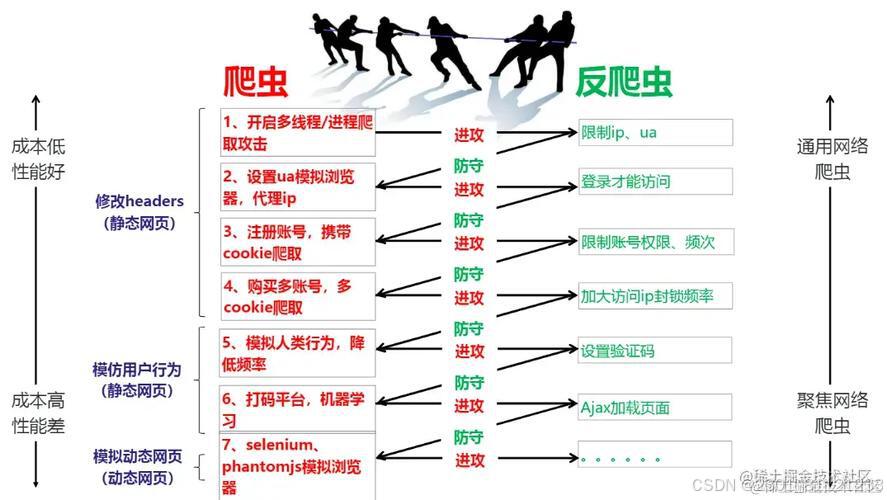

4.**反爬虫机制**:

许多网站为了防止爬虫的过度访问,会设置一些反爬虫机制,例如验证码、IP封禁、JavaScript动态加载等。爬虫需要能够应对这些机制,例如通过模拟用户行为、使用代理IP等方法。

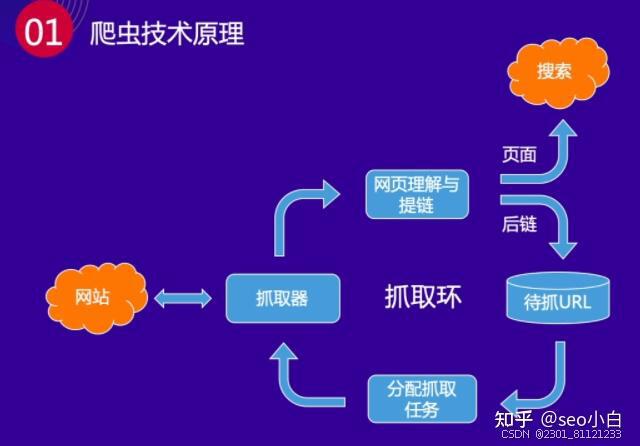

5.**并发与分布式抓取**:

为了提高抓取效率,爬虫通常需要支持并发抓取和分布式抓取,利用多线程、多进程或者分布式系统来加速抓取过程。

###爬虫的应用

1.**搜索引擎**:

搜索引擎使用爬虫抓取和索引互联网上的网页,从而提供搜索服务。

2.**数据挖掘**:

爬虫用于抓取特定网站的数据,进行数据分析和挖掘,例如市场分析、舆情监测等。

3.**价格监控**:

电商网站使用爬虫监控竞争对手的价格变化,从而调整自己的价格策略。

4.**内容聚合**:

新闻聚合应用使用爬虫抓取各个新闻网站的内容,提供统一的阅读体验。

###爬虫的合法性与道德问题

爬虫的使用需要遵循一定的法律和道德规范。未经许可的爬虫行为可能侵犯网站的合法权益,例如侵犯版权、侵犯隐私、破坏网站正常运行等。因此,使用爬虫时需要注意以下几点:

1.**遵守网站的robots.txt文件**:

robots.txt是一个文本文件,位于网站的根目录下,用于指示爬虫哪些页面可以抓取,哪些页面不可以抓取。

2.**尊重网站的使用条款**:

使用爬虫前,应阅读并遵守网站的使用条款,确保爬虫行为不违反网站的规定。

3.**避免对网站造成负担**:

爬虫应设置合理的抓取频率,避免对网站服务器造成过大的负担。

4.**保护用户隐私**:

爬虫抓取的数据中可能包含用户的个人信息,需要注意保护用户隐私,不非法使用这些数据。

###总结

网络爬虫是一种强大的工具,能够自动化地抓取和分析互联网上的信息。然而,使用爬虫需要遵循一定的法律和道德规范,确保不侵犯他人的合法权益。掌握爬虫的工作原理和技术细节,可以帮助我们更好地利用爬虫进行合法的数据抓取和分析。

爬虫(Web crawler)是一种自动化程序,用于在互联网上收集信息。它会按照预定的规则和算法从网页中提取所需的数据,并将其存储或用于其他目的。

爬虫的工作原理通常包括以下步骤:

1. 确定目标:确定需要爬取的网站和页面。

2. 发送请求:爬虫会向目标网站发送HTTP请求,请求获取网页的内容。

3. 获取网页内容:一旦请求被接收,网站会返回HTML或其他类型的数据。爬虫会将这些数据下载到本地进行处理。

4. 解析网页:爬虫使用HTML解析器(如Beautiful Soup),将下载的网页进行解析,提取出需要的数据(例如文本、图片、链接等)。

5. 处理数据:爬虫会对提取的数据进行处理和清洗,以便后续的分析和使用。

6. 存储数据:爬虫可以将提取的数据存储在数据库、文件或其他存储介质中,以备后续使用。

需要注意的是,爬虫在爬取网页时需要遵守一定的道德规范和法律规定。应该尊重网站的使用协议,避免对网站造成过大的访问流量或对网站进行恶意操作。