大规模语言模型从理论到实践:有监督下游任务微调

关键词:大规模语言模型,微调,自然语言处理,预训练,监督学习,Transformer,BERT,NLP,下游任务

文章目录

1. 背景介绍

1.1 问题的由来

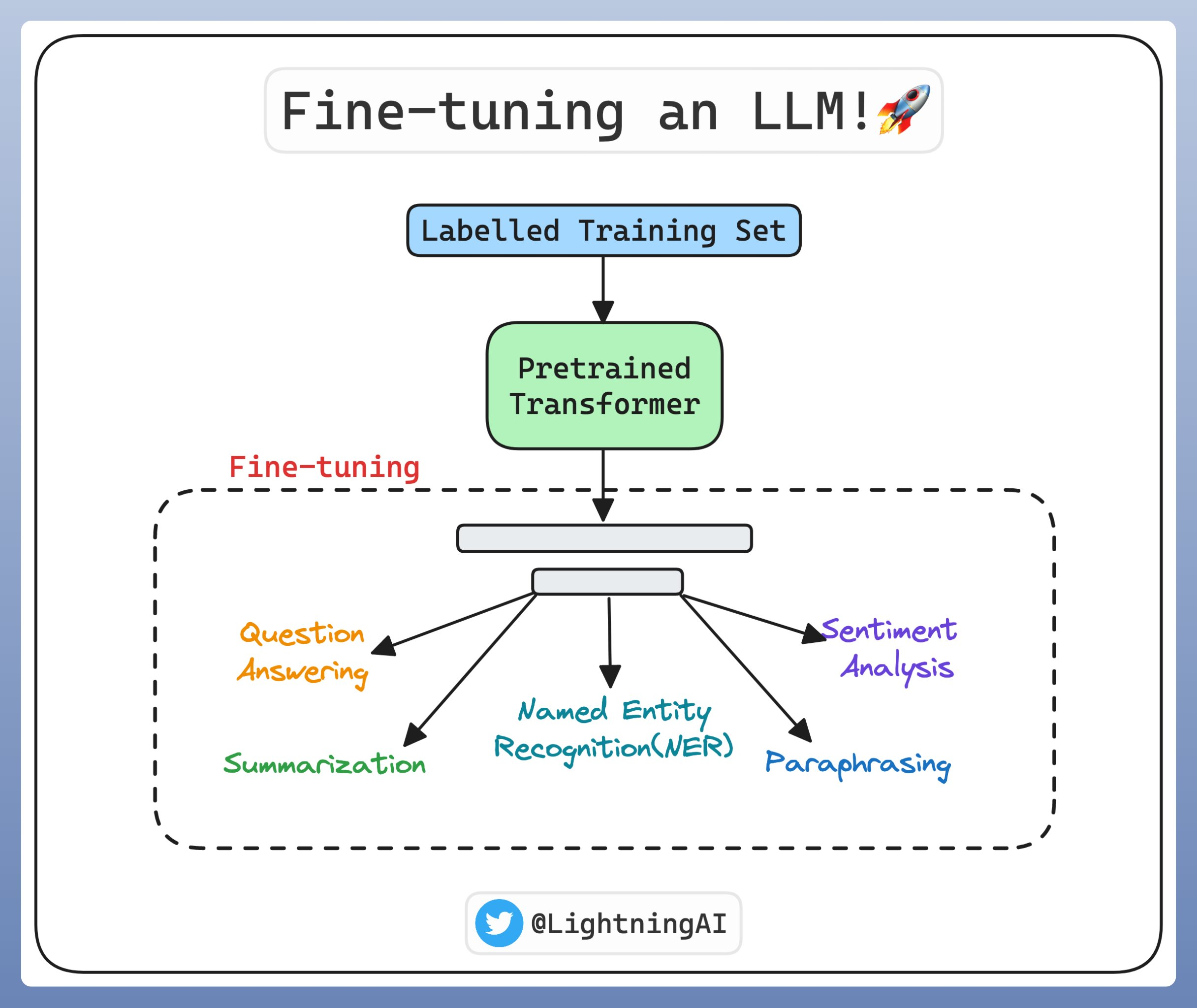

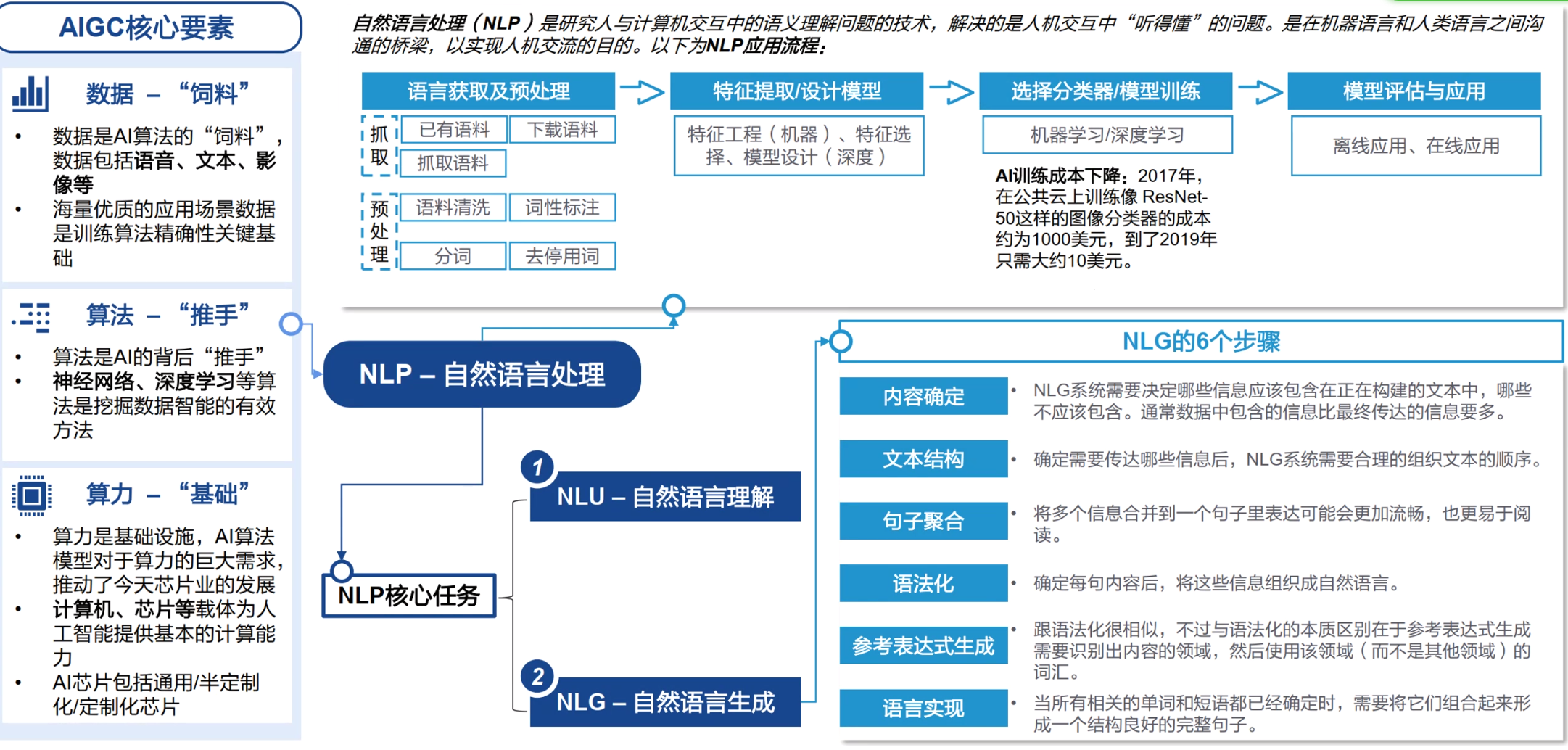

随着深度学习技术的快速发展,大规模语言模型(Large Language Models,LLMs)在自然语言处理(Natural Language Processing,NLP)领域取得了显著的成果。LLMs通过在海量文本语料上进行预训练,学习到了丰富的语言知识和模式,为解决NLP任务提供了强大的能力。

引爆LLM的chatGPT