一、前期工作

1.庹忠曜及其画作简介

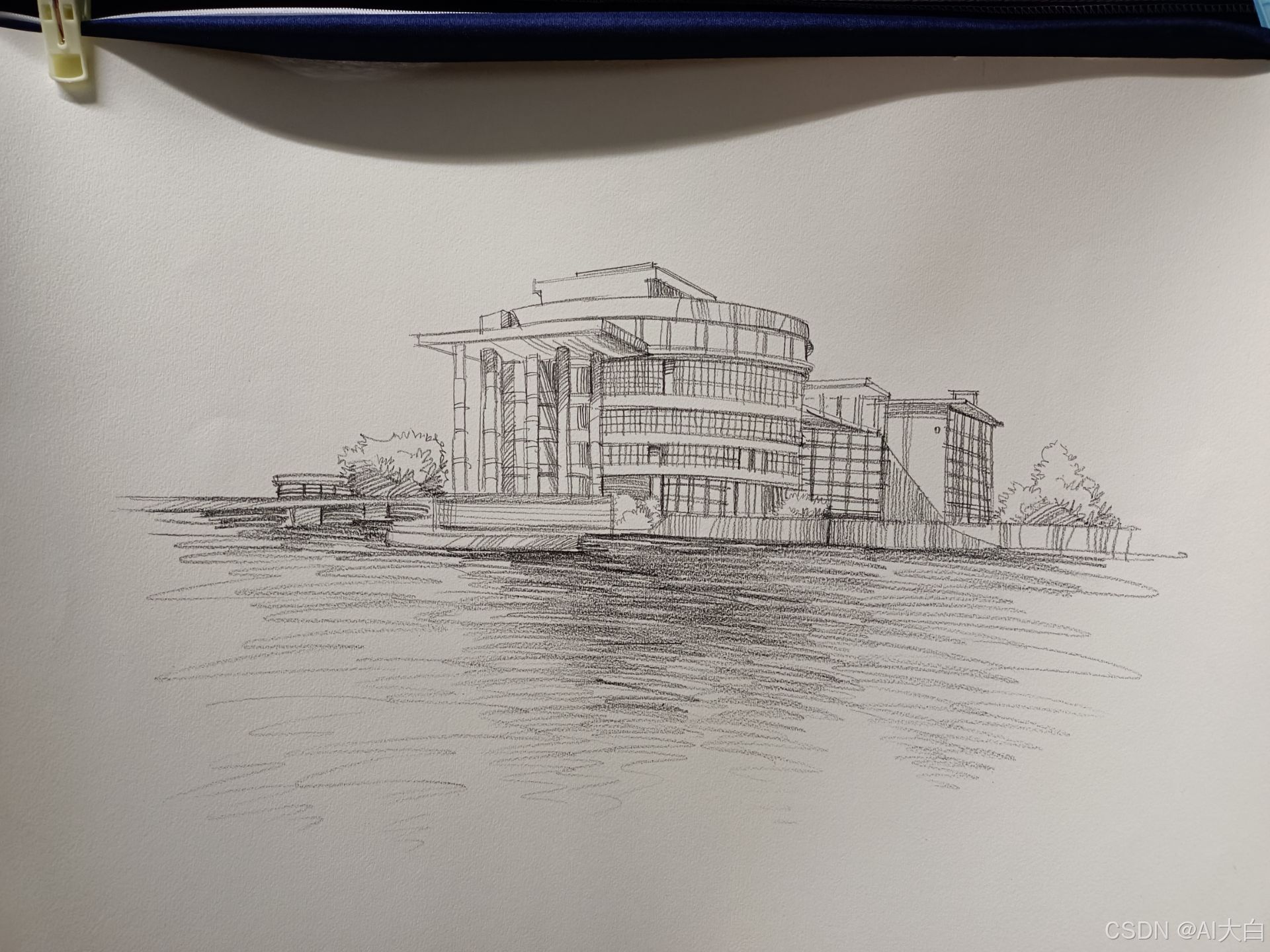

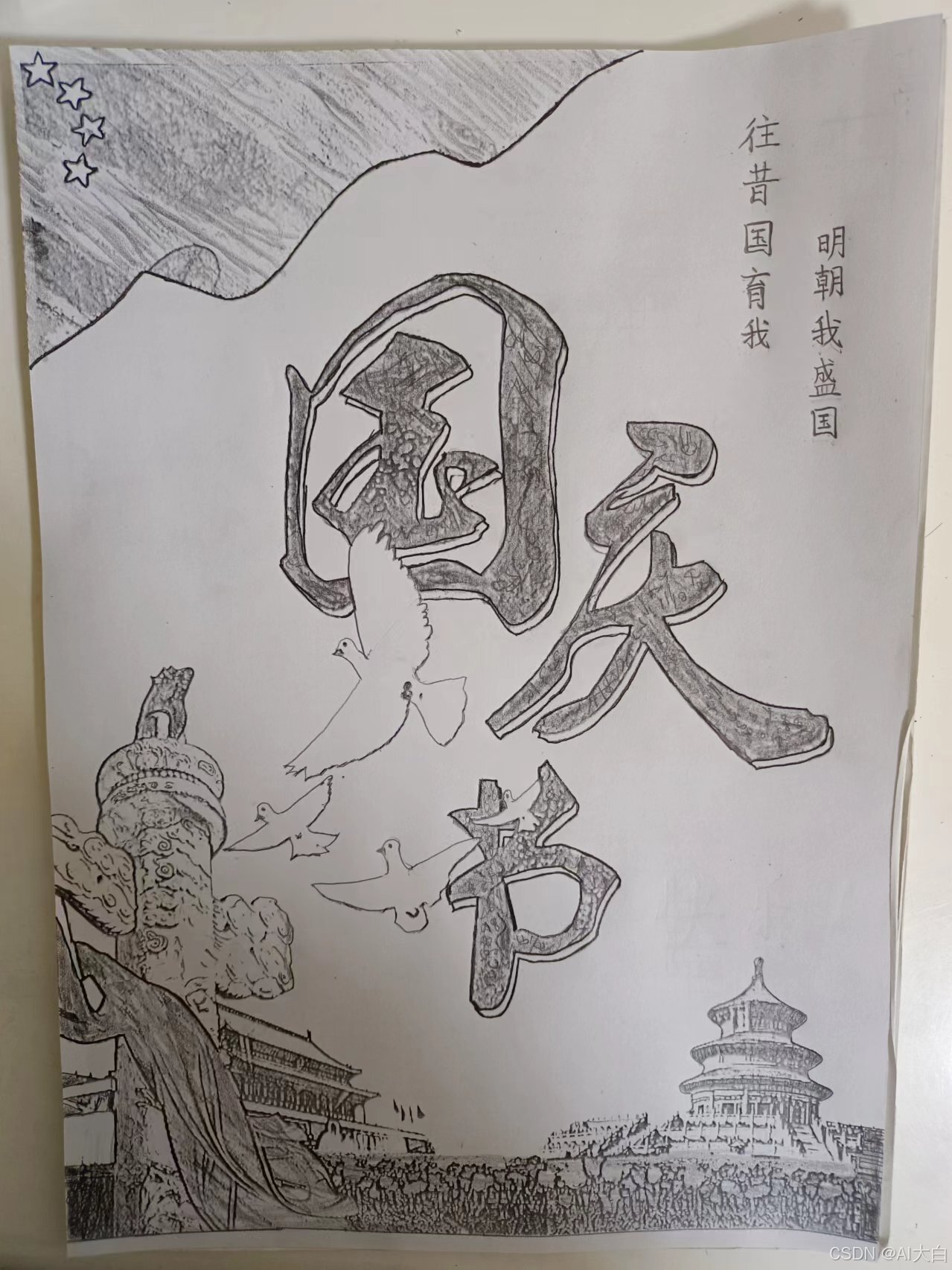

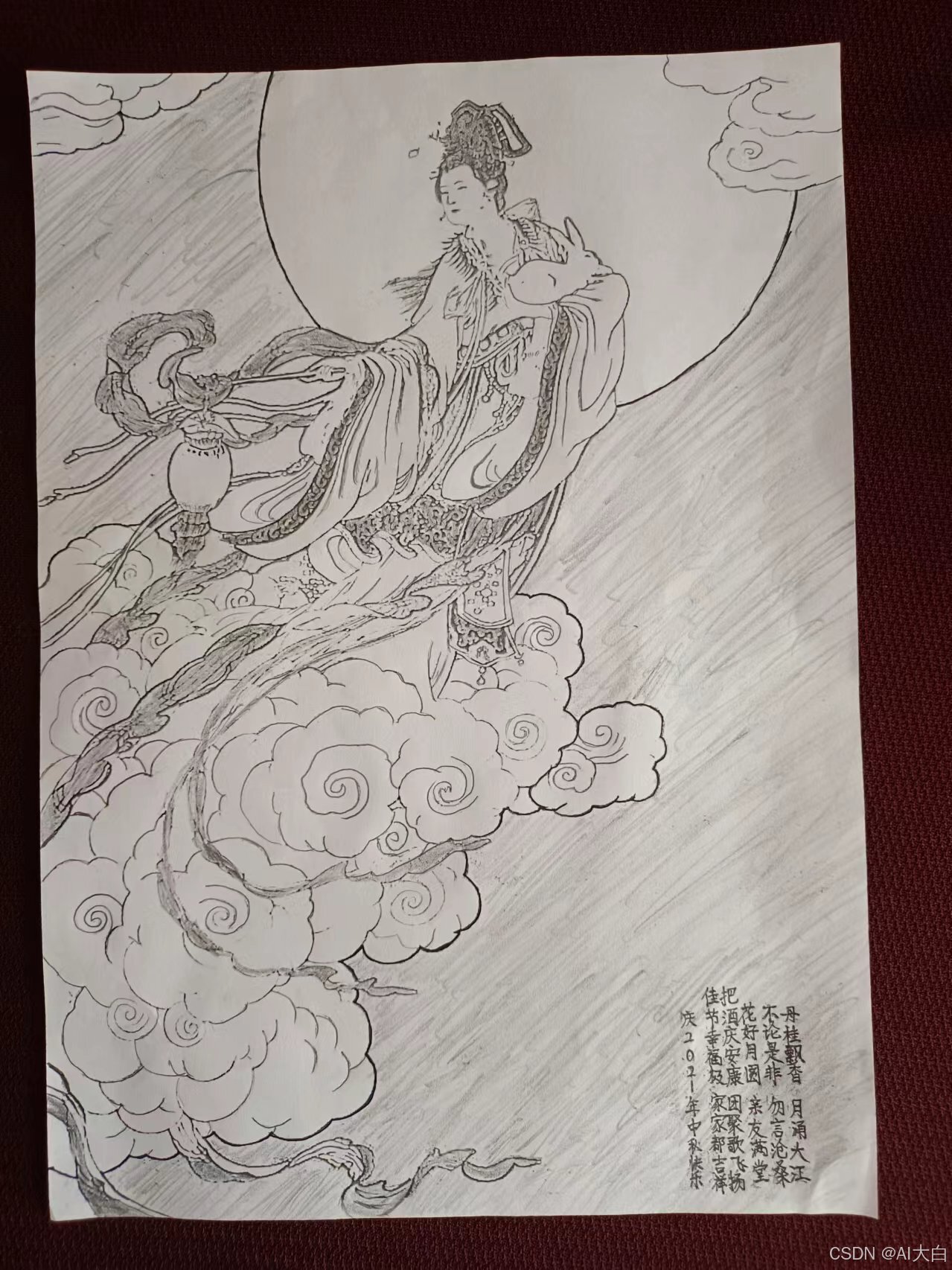

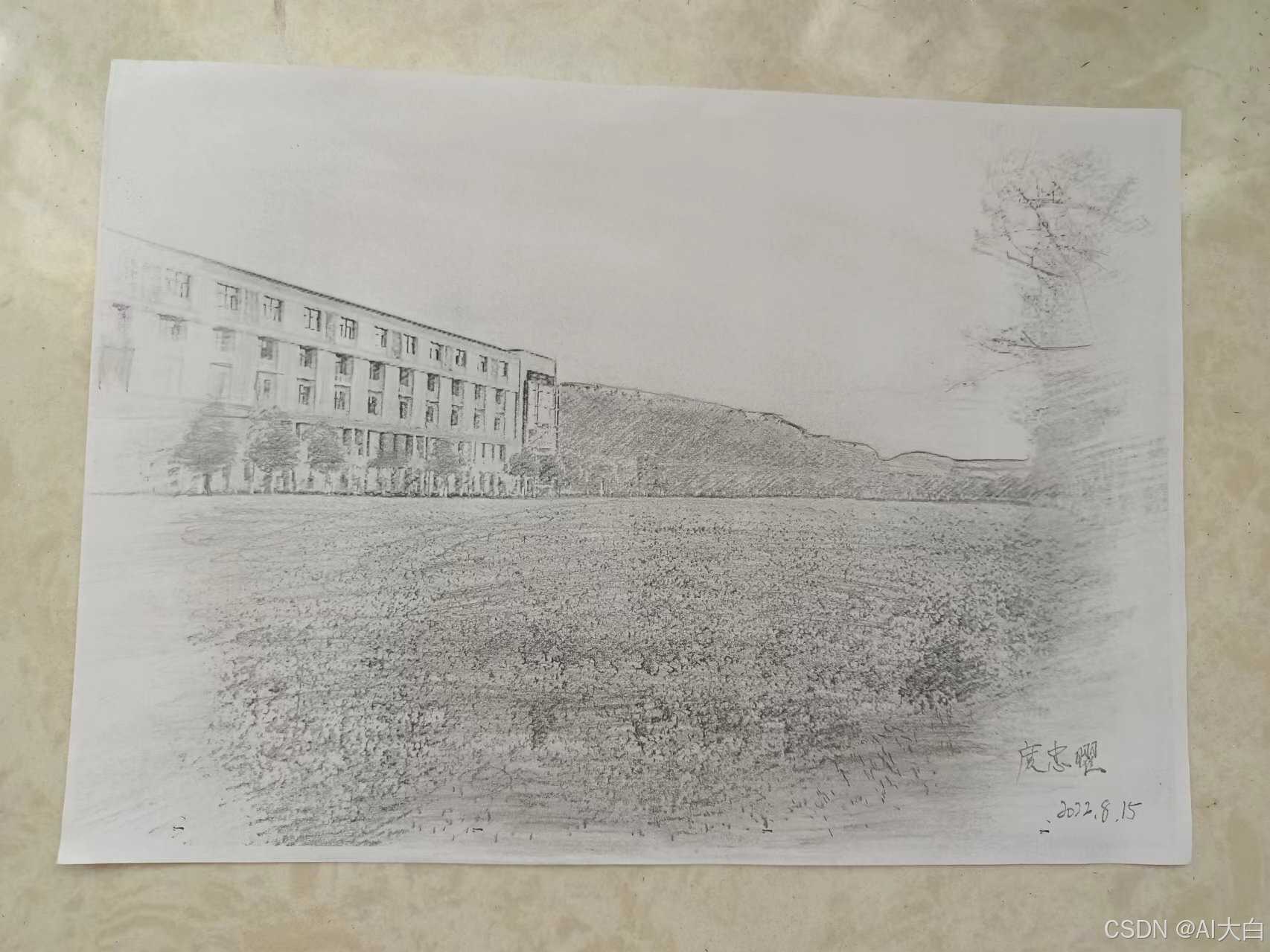

庹忠曜,男,湖北随州人,当代画家,著有《中博湖图》、《朝阳映鼎山》等佳作,其喜好以工笔勾勒山水建筑轮廓,以此表达山水景色与自身意境。庹忠曜的画作具有充沛的艺术鉴赏价值,同时因其画作简约且有神的特点,可作为高质量的图像数据进行计算机视觉分析。

2.图像收集与预处理

在进行庹忠曜画作的图像采集与预处理过程中,首先需要通过高质量的扫描仪或高分辨率相机在无尘无干扰的环境中获取画作的数字图像,以确保图像的清晰度和真实性。在采集过程中,要特别注意避免因扫描或拍摄角度问题导致的几何失真,必要时使用图像处理软件进行校正,以保持画作直线和角度的准确性。接下来,为了减少图像中的随机像素变化,即噪声,可以采用高斯滤波或中值滤波等去噪算法进行处理。为了更好地分析画作中的细节,可能还需要通过直方图均衡化或自适应直方图均衡化(CLAHE)等技术来增强图像的对比度。

如果分析需要关注画作中的特定区域,可以采用图像分割技术,如阈值分割、边缘检测或区域生长等方法,将这些区域从背景中分离出来。在有多幅画作需要比较分析的情况下,图像配准是必要的,通过特征匹配和变换矩阵确保它们在空间上的一致性。此外,在保证图像质量的前提下,可以对图像进行压缩,如使用JPEG、PNG等压缩格式,以减少存储空间和提高处理速度。在预处理的最后阶段,对图像中的特定元素进行标注,无论是手动标注还是使用机器学习模型自动标注,都是为了便于后续的分析和学习。整个预处理过程需要精心设计,以确保最终的分析结果的准确性和可靠性,同时在处理过程中要特别注意保护画作的原始状态,避免造成任何损害。

3.评判指标

1.深度估计(Depth Estimation)

深度估计是一项重要的计算机视觉任务,它旨在从图像中推断出场景中物体的距离信息。这可以通过基于立体匹配的方法、基于结构光的方法或基于单目图像的方法来实现。在艺术作品分析中,深度估计可以帮助理解画作中的三维结构和空间关系。例如,可以使用卷积神经网络(CNN)来从单目图像中估计深度,这种方法在缺乏多个视图的情况下特别有用。

2.特征提取与风格分析

通过深度学习模型,如预训练的ResNet18,可以自动提取画作中的关键特征,如纹理、形状和空间关系。这些特征对于理解庹忠曜的工笔勾勒技巧和个人风格至关重要。风格分析可以通过比较不同画作中的特征分布来实现,从而揭示艺术家的创作习惯和艺术发展。

3.情感分析

利用计算机视觉技术,可以对画作中的视觉元素进行情感分析,推测其可能传达的情感。这涉及到训练机器学习模型来识别和分类画作中的情感色彩,为艺术作品的情感表达提供量化的指标。

二、画作深度估计

1.评估指标

1.Accuracy with Threshold(准确率)

预测深度与真实深度之间的差异在某个阈值范围内的像素比例,用于衡量预测深度的准确率。

2.PSNR(峰值信噪比)

衡量预测深度图与真实深度图之间的相似度,值越高表示预测结果和真实深度图的保真度越高。

3.SSIM(结构相似性指数)

衡量两幅图像之间相似度的一种指标,常用于图像质量评估,更加关注图像的结构信息,即亮度、对比度和结构三方面的相似性。

2.具体算法

基于图像边缘的方法对庹忠曜画作进行分析的实现算法可以采用LapDepth深度估计模型,这是一种利用Laplacian Pyramid-Based Depth Residuals的单目深度估计方法。LapDepth模型首先通过一个backbone网络提取图像的特征,常用的backbone包括ResNet、ResNext101、VGG19、DenseNet161、InceptionV3、MobileNetV2、EfficientNet等。这些特征图包含了图像的多尺度信息,有助于后续的深度估计过程。

在特征提取之后,LapDepth模型使用一个编码器-解码器结构来预测深度。编码器部分进一步提取和融合特征,而解码器部分则逐步恢复图像的空间分辨率,并预测深度残差。这个过程涉及到多次上采样和下采样操作,以及特征图的逐层融合。通过这种方式,模型能够捕捉到图像中的边缘和轮廓信息,这些信息对于深度估计至关重要。

在深度估计过程中,LapDepth模型通过计算不同尺度特征图之间的差异来增强边缘信息,这有助于提高深度估计的准确性。此外,模型还采用了ASPP(Atrous Spatial Pyramid Pooling)模块来进一步提取多尺度特征,这有助于模型更好地理解图像中的不同结构和纹理。

最后,通过一系列的卷积和激活函数,LapDepth模型输出最终的深度图。这个深度图可以用于分析庹忠曜画作中的深度信息,如山水建筑的轮廓和空间关系,从而为艺术作品的分析提供新的视角和深度信息。

3.相关代码

以下提供一个基于Python和OpenCV库的简单示例代码,用于演示如何使用边缘检测来分析图像。请注意,这个示例并不直接实现深度估计,而是展示如何使用边缘检测来分析图像中的边缘信息,这可以作为深度估计中提取图像特征的一步。

import torch

import torch.nn as nn

import torch.nn.functional as F

# 定义一个简单的ASPP模块

class ASPP(nn.Module):

def __init__(self, in_channels, out_channels):

super(ASPP, self).__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, 1, padding=0)

self.conv3_1 = nn.Conv2d(in_channels, out_channels, 3, padding=1, dilation=1)

self.conv3_2 = nn.Conv2d(in_channels, out_channels, 3, padding=2, dilation=2)

self.conv3_3 = nn.Conv2d(in_channels, out_channels, 3, padding=3, dilation=3)

self.conv_pool = nn.Conv2d(in_channels, out_channels, 1, padding=0)

self.global_avg_pool = nn.AdaptiveAvgPool2d(1)

self.conv1x1 = nn.Conv2d(out_channels * 2, out_channels, 1, padding=0)

def forward(self, x):

x1 = self.conv1(x)

x2 = self.conv3_1(x)

x3 = self.conv3_2(x)

x4 = self.conv3_3(x)

x5 = self.global_avg_pool(x)

x5 = self.conv_pool(x5)

x5 = F.interpolate(x5, size=x4.size()[2:], mode='bilinear', align_corners=True)

x5 = self.conv1x1(torch.cat((x5, x4), dim=1))

return F.relu(torch.cat((x1, x2, x3, x4, x5), dim=1))

# 定义LapDepth模型

class LapDepth(nn.Module):

def __init__(self, backbone):

super(LapDepth, self).__init__()

self.backbone = backbone

self.aspp = ASPP(backbone.out_channels, 256)

self.decoder = nn.ModuleList([nn.Conv2d(256, 256, 3, padding=1) for _ in range(5)])

self.final_conv = nn.Conv2d(256, 1, 1)

def forward(self, x):

features = self.backbone(x)

aspp_features = self.aspp(features[-1])

for i in range(len(features) - 1, 0, -1):

aspp_features = F.interpolate(aspp_features, scale_factor=2, mode='bilinear', align_corners=True)

aspp_features = aspp_features + features[i - 1]

aspp_features = self.decoder[i - 1](aspp_features)

depth = self.final_conv(aspp_features)

return depth

# 假设backbone是一个ResNet50模型

class Backbone(nn.Module):

def __init__(self):

super(Backbone, self).__init__()

self.resnet50 = torch.hub.load('pytorch/vision:v0.10.0', 'resnet50', pretrained=True)

self.out_channels = [64, 128, 256, 512]

def forward(self, x):

features = []

for i, block in enumerate(self.resnet50.children()):

x = block(x)

if i in [4, 5, 6, 7]: # 假设我们使用前四个block的输出

features.append(x)

return features

# 实例化模型

backbone = Backbone()

model = LapDepth(backbone)

# 假设输入图像尺寸为256x256

input_image = torch.randn(1, 3, 256, 256)

output_depth = model(input_image)

print(output_depth.shape) # 应该输出[1, 1, 256, 256] 在该代码中,ASPP模块用于提取多尺度特征,它包含多个不同膨胀率的卷积层和一个全局平均池化层。LapDepth模型使用了一个预训练的ResNet50作为backbone来提取特征,然后通过ASPP模块进一步处理特征。decoder是一个包含多个卷积层的模块列表,用于逐步重建深度图。final_conv是一个1x1卷积层,用于将特征图转换为深度图。

三、特征提取与风格分析

1.算法概述

特征提取通常指的是从原始数据中提取出有助于模型学习和泛化的信息。在图像处理中,特征提取可以是通过卷积神经网络(CNN)自动完成的过程,其中网络的卷积层能够学习到图像的局部特征,如边缘、纹理等。深度学习算法,尤其是CNN,在图像处理中能够学习到图像内容的不同层面,包括边缘、纹理、形状等。风格特征则通常由卷积网络的前几层提取,反映图像的基本视觉模式。

风格分析则涉及到识别和量化图像中的艺术风格。在深度学习中,风格分析可以通过神经风格迁移(Neural Style Transfer, NST)技术来实现,该技术建立于CNN基础之上。NST算法通过训练深度卷积网络来捕捉图片风格和内容的特征,并将一种风格迁移到另一张图片上。其中,关键步骤包括内容表示、风格表示和损失函数的定义。在风格表示方面,深度学习网络能够通过分析图像中的不同层来提取不同级别的特征,其中较浅层网络识别基本图案和纹理,而较深层网络则捕捉复杂的对象和场景细节。

2.具体步骤

1.特征提取

特征提取在深度学习中是一个核心过程,它涉及从原始数据中识别和提取有助于模型学习和泛化的关键信息。在图像处理领域,特征提取通常是通过卷积神经网络(CNN)自动完成的,这些网络能够学习到图像的局部特征,如边缘、纹理和形状。深度学习算法,尤其是CNN,能够学习到图像内容的不同层面,从基础的视觉效果到复杂的对象和场景细节。在特征提取的过程中,预训练的深度卷积神经网络,如VGG19或ResNet,被用来处理输入图像。这些模型通过前向传播过程,利用卷积层、池化层和激活函数等组件,共同作用于图像,提取从低级到高级的特征。特征提取的关键步骤包括选择一个合适的预训练模型,将待分析的图像输入到模型中,然后通过模型的前向传播来处理图像。在这个过程中,可以选择模型中的一个或多个层来提取特征,通常是通过获取这些层的激活值来实现。这些特征可以是图像的低级特征,如边缘和纹理,或者是更高级的特征,如对象的部分或整个形状。

2.风格分析

风格分析则是一个更为复杂的过程,它涉及到识别和量化图像中的艺术风格。在深度学习中,风格分析可以通过神经风格迁移(Neural Style Transfer, NST)技术来实现,该技术建立于CNN基础之上。NST算法通过训练深度卷积网络来捕捉图片风格和内容的特征,并将一种风格迁移到另一张图片上。风格分析的关键在于定义风格表示,这通常通过计算图像特征的统计特性来实现,如颜色分布、纹理模式等。在NST中,风格特征通过计算风格图像特征图的格拉姆矩阵来捕捉,这个矩阵描述了特征图中激活值的相关性。然后,构建一个包含风格损失、内容损失和总变异损失的损失函数,通过优化这个损失函数来生成具有目标风格的图像。优化过程涉及到使用梯度下降算法或其他优化技术来最小化损失函数,从而生成具有目标风格特征的图像。这个过程需要迭代更新,直到损失函数达到一个满意的最小值。最后,对生成的图像进行后处理,如色彩校正、锐化等,以提高最终图像的质量,并进行评估与分析,确保风格特征符合预期,内容得到保留。通过这些步骤,风格分析不仅能够为图像处理任务提供强大的工具,还能够深入理解图像的内在特性,为艺术作品的分析和创作提供新的视角。

3.相关代码

由于风格迁移是一个复杂的过程,涉及到深度学习模型的构建和训练,我将提供一个简化的示例代码,展示如何使用PyTorch框架实现神经风格迁移的基本步骤。这个示例将使用VGG19模型作为基础网络来提取内容和风格特征。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import models, transforms

from PIL import Image

import matplotlib.pyplot as plt

# 加载预训练的VGG19模型

vgg = models.vgg19(pretrained=True).features

# 冻结VGG19的参数

for param in vgg.parameters():

param.requires_grad = False

# 定义风格迁移模型

class StyleTransferModel(nn.Module):

def __init__(self, vgg, style_layers, content_layers):

super(StyleTransferModel, self).__init__()

self.vgg = vgg

self.style_layers = style_layers

self.content_layers = content_layers

self.criterion = nn.MSELoss()

def forward(self, x):

style_outputs = []

content_outputs = []

for layer in self.vgg.children():

x = layer(x)

if layer.__class__.__name__ in self.style_layers:

style_outputs.append(x)

if layer.__class__.__name__ in self.content_layers:

content_outputs.append(x)

return style_outputs, content_outputs

# 定义风格和内容层

style_layers = ['4', '9', '18', '27', '36']

content_layers = ['26']

# 实例化模型

model = StyleTransferModel(vgg, style_layers, content_layers)

# 加载图像

def image_loader(image_name, max_size=400, shape=None):

image = Image.open(image_name)

if max(image.size) > max_size:

size = max_size

else:

size = max(image.size)

if shape is not None:

size = shape

in_transform = transforms.Compose([

transforms.Resize(size),

transforms.ToTensor(),

transforms.Normalize((0.485, 0.456, 0.406), (0.229, 0.224, 0.225))

])

image = in_transform(image).unsqueeze(0)

return image

# 加载内容和风格图像

content_image = image_loader('content.jpg')

style_image = image_loader('style.jpg')

# 定义优化器

optimizer = optim.LBFGS([content_image.requires_grad_()])

# 执行风格迁移

def run_style_transfer(content_image, style_image, num_steps=300):

model(content_image)

style_outputs, content_outputs = model(content_image)

style_targets, content_targets = model(style_image)

for step in range(num_steps):

optimizer.zero_grad()

style_outputs, content_outputs = model(content_image)

# 计算风格和内容损失

style_loss = 0

content_loss = 0

for target, output in zip(style_targets, style_outputs):

style_loss += model.criterion(output, target)

for target, output in zip(content_targets, content_outputs):

content_loss += model.criterion(output, target)

loss = style_loss + content_loss

loss.backward()

optimizer.step()

if step % 50 == 0:

print(f"Step {step}, Loss: {loss.item()}")

return content_image

# 运行风格迁移

output_image = run_style_transfer(content_image, style_image)

# 显示结果

plt.imshow(output_image[0].detach().numpy().transpose(1, 2, 0))

plt.show()加载VGG19模型:使用预训练的VGG19模型作为特征提取器。冻结参数:冻结VGG19的参数,以防止在训练过程中更新。定义StyleTransferModel:创建一个模型,用于提取风格和内容特征。加载图像:定义一个函数来加载和预处理图像。定义优化器:使用LBFGS优化器来优化图像。执行风格迁移:定义一个函数来执行风格迁移,包括计算损失和更新图像。显示结果:使用matplotlib显示最终的图像。

四、情感分析

1.算法概述

在对庹忠曜画作进行情感分析的算法概述中,我们首先通过深度学习技术,特别是卷积神经网络(CNN),来自动提取画作中的关键特征,如色彩、纹理和形状。这些特征不仅包括视觉元素,还涉及画作的风格特征,例如工笔勾勒技巧,这些风格特征对于理解画作的情感表达至关重要。

为了深入分析风格特征,我们构建了一个多层聚合的特征重标定网络模块。这个模块能够聚合CNN中不同卷积层的信息,并对特征响应进行重标定,从而增强与情感相关的特征表示。这一过程允许模型更准确地捕捉到画作中影响情感传达的关键视觉元素。

接下来,我们将提取的特征用于情感分类。通过训练一个分类模型,我们能够根据特征将画作分为不同的情感类别,如悲伤、喜悦、平静等。这一步骤是通过学习特征与情感类别之间的映射关系来实现的,使得模型能够识别和区分画作中表达的不同情感。

为了进一步细化情感分析,我们采用了多类别加权激活定位的类判别映射技术。这种方法通过计算各类别相对于卷积层的梯度来获得激活定位,并将这些激活定位加权聚合,以突出显示CNN检测到的情感区域。这不仅实现了情感元素的可视化,而且增强了我们对画作中情感分布的理解。

在模型训练完成后,我们使用准确率、召回率和F1分数等评估指标来评估情感分类模型的性能。这些指标提供了模型在不同情感类别上的表现的量化度量。根据评估结果,我们对模型进行调整和优化,以提高其在情感分析任务上的性能。

最后,我们将情感分析的结果应用于艺术作品的进一步研究,如艺术风格分析、艺术家情感表达研究等。这些应用不仅丰富了我们对庹忠曜画作的理解,而且为艺术史和艺术理论的研究提供了新的视角和工具。

为了使情感分析的结果更加直观和易于理解,我们采用了可视化技术,如热图,来显示画作中情感强烈的区域。这些可视化结果不仅提供了对画作情感分布的直观展示,而且为艺术作品的解释和分析提供了有力的支持。通过这种方式,情感分析不仅增强了我们对艺术作品情感层面的认识,而且为艺术创作和欣赏提供了新的维度。

2.具体步骤

1.风格特征分析

分析画作的风格特征,如工笔勾勒技巧,以及这些特征如何影响情感的传达。这可以通过构建多层聚合的特征重标定网络模块来实现,该模块可以聚合模块内卷积层信息,重标定特征响应。

2.情感分类与定位

将提取的特征用于情感分类。这可以通过训练一个分类模型来完成,该模型能够根据特征将画作分为不同的情感类别,如悲伤、喜悦、平静等。使用多类别加权激活定位的类判别映射技术,分别计算各类别相对于卷积层的梯度获得激活定位,并将其加权聚合以突出显示CNN检测到的情感区域,实现中国画情感元素可视化。

3.模型评估与优化

使用适当的评估指标,如准确率、召回率和F1分数,来评估情感分类模型的性能。根据评估结果,对模型进行调整和优化。将情感分析的结果应用于艺术作品的进一步研究,如艺术风格分析、艺术家情感表达研究等。将情感分析的结果以可视化的方式呈现,如使用热图来显示画作中情感强烈的区域,并提供对这些结果的解释。

3.相关代码

以下是一个基于深度学习的情感分析过程的详细示例代码,包括风格特征分析、情感分类、情感区域定位、模型评估与优化、情感分析结果的应用以及可视化与解释:

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import models, transforms

from PIL import Image

import matplotlib.pyplot as plt

import numpy as np

# 加载预训练的VGG19模型

class VGG19(nn.Module):

def __init__(self, num_classes=1000):

super(VGG19, self).__init__()

self.features = models.vgg19(pretrained=True).features

self.classifier = nn.Sequential(

nn.Linear(512 * 7 * 7, 4096),

nn.ReLU(True),

nn.Dropout(),

nn.Linear(4096, 4096),

nn.ReLU(True),

nn.Dropout(),

nn.Linear(4096, num_classes),

)

def forward(self, x):

x = self.features(x)

x = torch.flatten(x, 1)

x = self.classifier(x)

return x

# 定义情感分析模型

class EmotionAnalysisModel(nn.Module):

def __init__(self):

super(EmotionAnalysisModel, self).__init__()

self.vgg19 = VGG19(num_classes=256) # 假设我们有256个情感类别

self.fc = nn.Linear(256, 3) # 假设我们简化情感为3个类别:悲伤、喜悦、平静

def forward(self, x):

x = self.vgg19(x)

x = self.fc(x)

return x

# 加载和预处理图像

def load_image(image_path):

image = Image.open(image_path)

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

image = transform(image).unsqueeze(0)

return image

# 实例化模型

model = EmotionAnalysisModel()

# 加载图像

content_image = load_image('path_to_your_image.jpg')

# 模型训练(简化示例,实际需要大量数据和更复杂的训练过程)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 假设我们有一个标签

label = torch.tensor([1]) # 假设1代表“喜悦”

# 训练步骤

model.train()

optimizer.zero_grad()

output = model(content_image)

loss = criterion(output, label)

loss.backward()

optimizer.step()

# 模型评估(简化示例)

model.eval()

with torch.no_grad():

output = model(content_image)

_, predicted = torch.max(output, 1)

# 可视化情感区域

# 这里需要一个更复杂的方法来定位情感区域,以下是一个简化的示例

plt.imshow(content_image[0].permute(1, 2, 0).numpy())

plt.title(f'Predicted Emotion: {predicted.item()}')

plt.show()使用预训练的VGG19网络提取画作的风格特征。这些特征包括色彩、纹理和形状等,它们对于理解画作的情感表达至关重要。将提取的特征用于情感分类。通过训练一个分类模型,我们能够根据特征将画作分为不同的情感类别,如悲伤、喜悦、平静等。虽然示例代码中没有直接实现情感区域定位,但在实际应用中,可以使用多类别加权激活定位的类判别映射技术来突出显示CNN检测到的情感区域。