今天给大家推荐一本4月份才新出的大型语言模型(LLM)的权威教程《基于GPT-3、ChatGPT、GPT-4等Transformer架构的自然语言处理》!Google工程总监Antonio Gulli作序,一堆大佬推荐!这含金量不用多说,在这里给大家强烈推荐一波,不多bb开始介绍!

本教程内容主要内容

• 了解用于解决复杂语言问题的新技术

• 将GPT-3与T5、GPT-2和基于BERT的Transformer的结果进行对比

• 使用TensorFlow、PyTorch和GPT-3执行情感分析、文本摘要、非正式语言分析、机器翻译等任务

• 了解ViT和CLIP如何标注图像(包括模糊化),并使用DALL-E从文本生成图像

• 学习ChatGPT和GPT-4的高级提示工程机制

PDF书籍: 完整版本链接获取

😝有需要的小伙伴,可以V扫描下方二维码领取==🆓

《基于GPT-3、ChatGPT、GPT-4等Transformer架构的自然语言处理》分步展示如何微调GPT-3等预训练模型。研究机器翻译、语音转文本、文本转语音、问答等NLP任务,并介绍解决NLP难题的技术,甚至帮助你应对假新闻焦虑(详见第13章)。

从书中可了解到,诸如OpenAI的高级平台将Transformer扩展到语言领域、计算机视觉领域,并允许使用DALL-E 2、ChatGPT和GPT-4生成代码。通过本书,你将了解到Transformer的工作原理以及如何实施Transformer来决NLP问题。

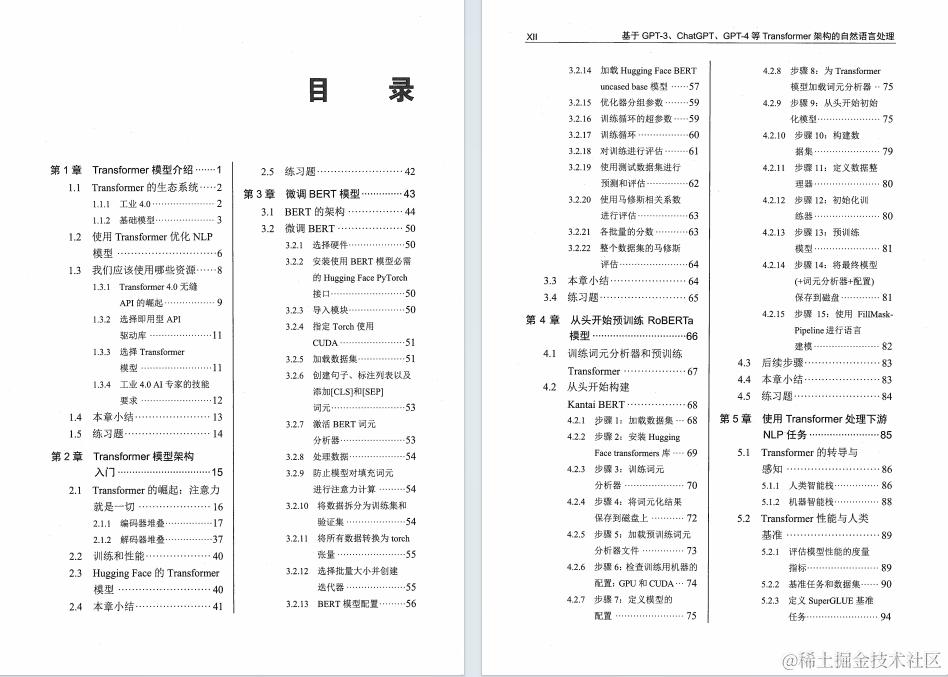

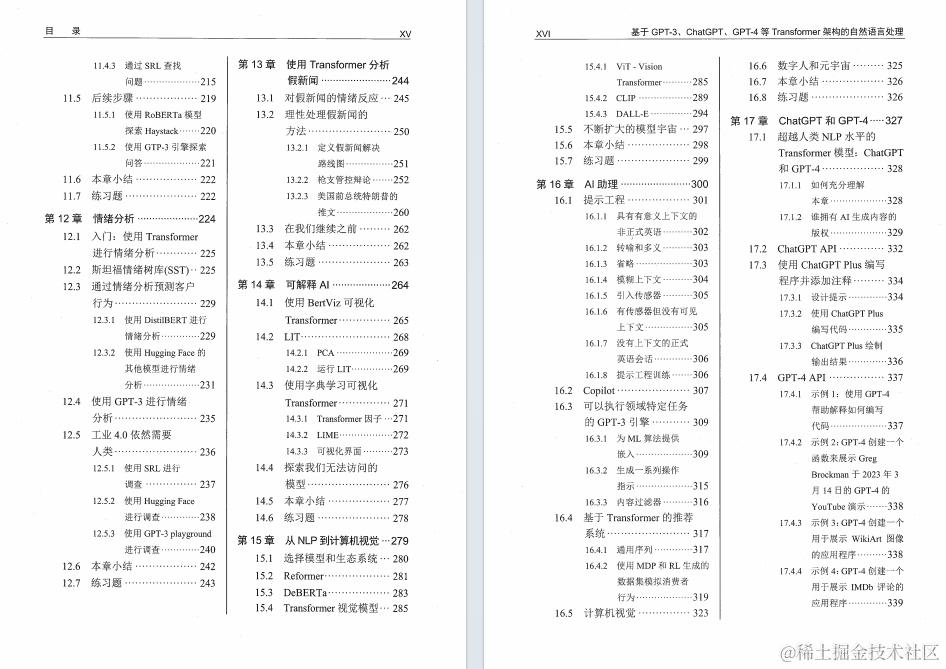

书籍目录如下:

第1 章 Transformer 模型介绍

-

1.1 Transformer 的生态系统

-

1.2 使用Transformer 优化NLP模型

-

1.3 我们应该使用哪些资源

-

1.4 本章小结

-

1.5 练习题

第2 章 Transformer 模型架构入门

-

2.1 Transformer 的崛起:注意力就是一切

-

2.2 训练和性能

-

2.3 Hugging Face 的Transformer模型

-

2.4 本章小结

-

2.5 练习题

第3 章 微调BERT 模型

-

3.1 BERT 的架构

-

3.2 微调BERT

-

3.3 本章小结

-

3.4 练习题

第4 章 从头开始预训练RoBERTa模型

-

4.1 训练词元分析器和预训练Transformer

-

4.2 从头开始构建Kantai BERT

-

4.3 后续步骤

-

4.4 本章小结

-

4.5 练习题

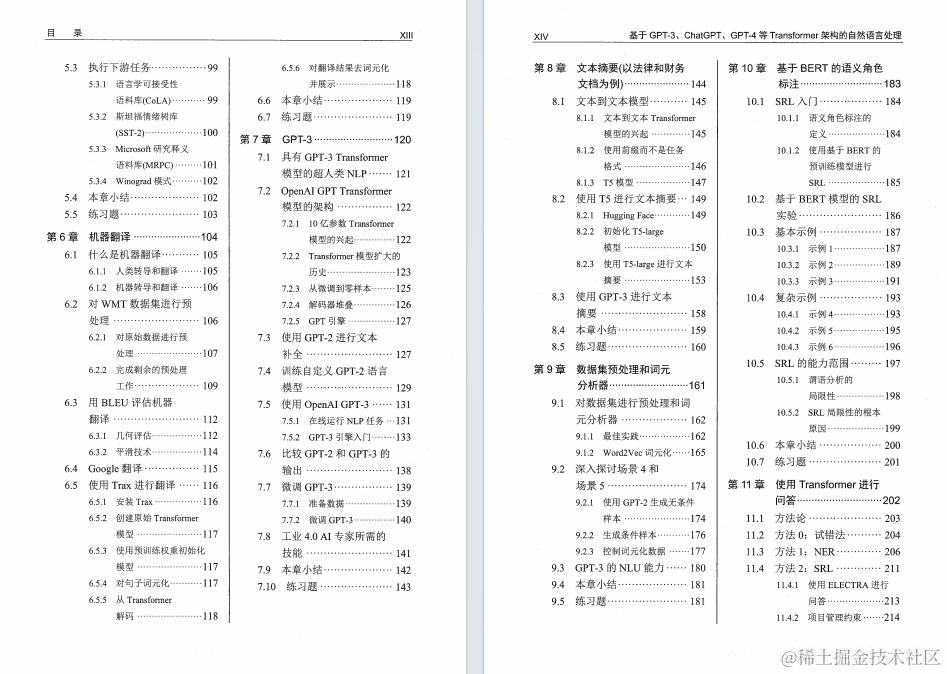

第5 章 使用Transformer 处理下游NLP 任务

-

5.1 Transformer 的转导与感知

-

5.2 Transformer 性能与人类基准

-

5.3 执行下游任务

-

5.4 本章小结

-

5.5 练习题

第6 章 机器翻译

-

6.1 什么是机器翻译

-

6.2 对WMT 数据集进行预处理

-

6.3 用BLEU 评估机器翻译

-

6.4 Google 翻译

-

6.5 使用Trax 进行翻译

-

6.6 本章小结

-

6.7 练习题

第7 章 GPT-3

-

7.1 具有GPT-3 Transformer模型的超人类NLP

-

7.2 OpenAI GPT Transformer模型的架构

-

7.3 使用GPT-2 进行文本补全

-

7.4 训练自定义GPT-2 语言模型

-

7.5 使用OpenAI GPT-3

-

7.6 比较GPT-2 和GPT-3 的输出

-

7.7 微调GPT-3

-

7.8 工业4.0 AI 专家所需的技能

-

7.9 本章小结

-

7.10 练习题

第8 章 文本摘要(以法律和财务文档为例)

-

8.1 文本到文本模型

-

8.2 使用T5 进行文本摘要

-

8.3 使用GPT-3 进行文本摘要

-

8.4 本章小结

-

8.5 练习题

第9 章 数据集预处理和词元分析器

-

9.1 对数据集进行预处理和词元分析器

-

9.2 深入探讨场景4 和场景5

-

9.3 GPT-3 的NLU 能力

-

9.4 本章小结

-

9.5 练习题

第10 章 基于BERT 的语义角色标注

-

10.1 SRL 入门

-

10.2 基于BERT 模型的SRL

-

实验

-

10.3 基本示例

-

10.4 复杂示例

-

10.5 SRL 的能力范围

-

10.6 本章小结

-

10.7 练习题

第11 章 使用Transformer 进行问答

-

11.1 方法论

-

11.2 方法0:试错法

-

11.3 方法1:NER

-

11.4 方法2:SRL

-

11.5 后续步骤

-

11.6 本章小结

-

11.7 练习题

第12 章 情绪分析

-

12.1 入门:使用Transformer进行情绪分析

-

12.2 斯坦福情绪树库(SST)

-

12.3 通过情绪分析预测客户行为

-

12.4 使用GPT-3 进行情绪分析

-

12.5 工业4.0 依然需要人类

-

12.6 本章小结

-

12.7 练习题

第13 章 使用Transformer 分析假新闻

-

13.1 对假新闻的情绪反应

-

13.2 理性处理假新闻的方法

-

13.3 在我们继续之前

-

13.4 本章小结

-

13.5 练习题

第14 章 可解释AI

-

14.1 使用BertViz 可视化Transformer

-

14.2 LIT

-

14.3 使用字典学习可视化Transformer

-

14.4 探索我们无法访问的模型

-

14.5 本章小结

-

14.6 练习题

第15 章 从NLP 到计算机视觉

-

15.1 选择模型和生态系统

-

15.2 Reformer

-

15.3 DeBERTa

-

15.4 Transformer 视觉模型

-

15.5 不断扩大的模型宇宙

-

15.6 本章小结

-

15.7 练习题

第16 章 AI 助理

- 16.1 提示工程

本书将带领你开发代码和设计提示(这是一项控制Transformer 模型行为的新的“编程”技能)。每一章都会使用Python、PyTorch 和TensorFlow 从头开始讲授语言理解的关键方面。

你将学习原始Transformer、Google BERT、OpenAI GPT-3、T5 和其他几个模型的架构。最后一章将在前面16 章所学知识的基础上,展示ChatGPT 和GPT-4 的增强能力。你将学会如何微调Transformer,如何从头开始训练模型,如何使用强大的API。

PDF书籍: 完整版本链接获取

😝有需要的小伙伴,可以V扫描下方二维码领取==🆓

PDF一览:

PDF书籍: 完整版本链接获取

😝有需要的小伙伴,可以V扫描下方二维码领取==🆓