📝个人主页🌹:Eternity._

🌹🌹期待您的关注 🌹🌹

❀ 蓝耘智算平台

前言:在科技日新月异的今天,人工智能(AI)技术正以前所未有的速度改变着我们的生活和工作方式。作为这一领域的先行者,蓝耘科技始终致力于探索AI的无限可能,为全球用户带来更加智能、高效、便捷的技术体验。

今天,我们怀着无比激动的心情,向广大用户隆重介绍蓝耘科技的最新力作——DeepSeek满血版。这不仅是我们在AI推理领域的一次重大突破,更是对用户体验的一次全面升级。DeepSeek满血版的发布,标志着蓝耘科技在AI技术的道路上迈出了更加坚实的步伐。

为了让更多用户能够享受到这一革命性的技术成果,蓝耘科技特别推出了尊享500万Tokens的特权活动。这一举措旨在让更多用户有机会深入体验DeepSeek满血版的强大功能,感受AI推理带来的全新飞跃。

在接下来的篇章中,我们将详细介绍DeepSeek满血版的各项功能和优势,以及如何通过500万Tokens特权,开启您的AI推理新篇章。让我们携手并进,共同见证蓝耘科技引领的AI技术新纪元!

蓝耘智算平台

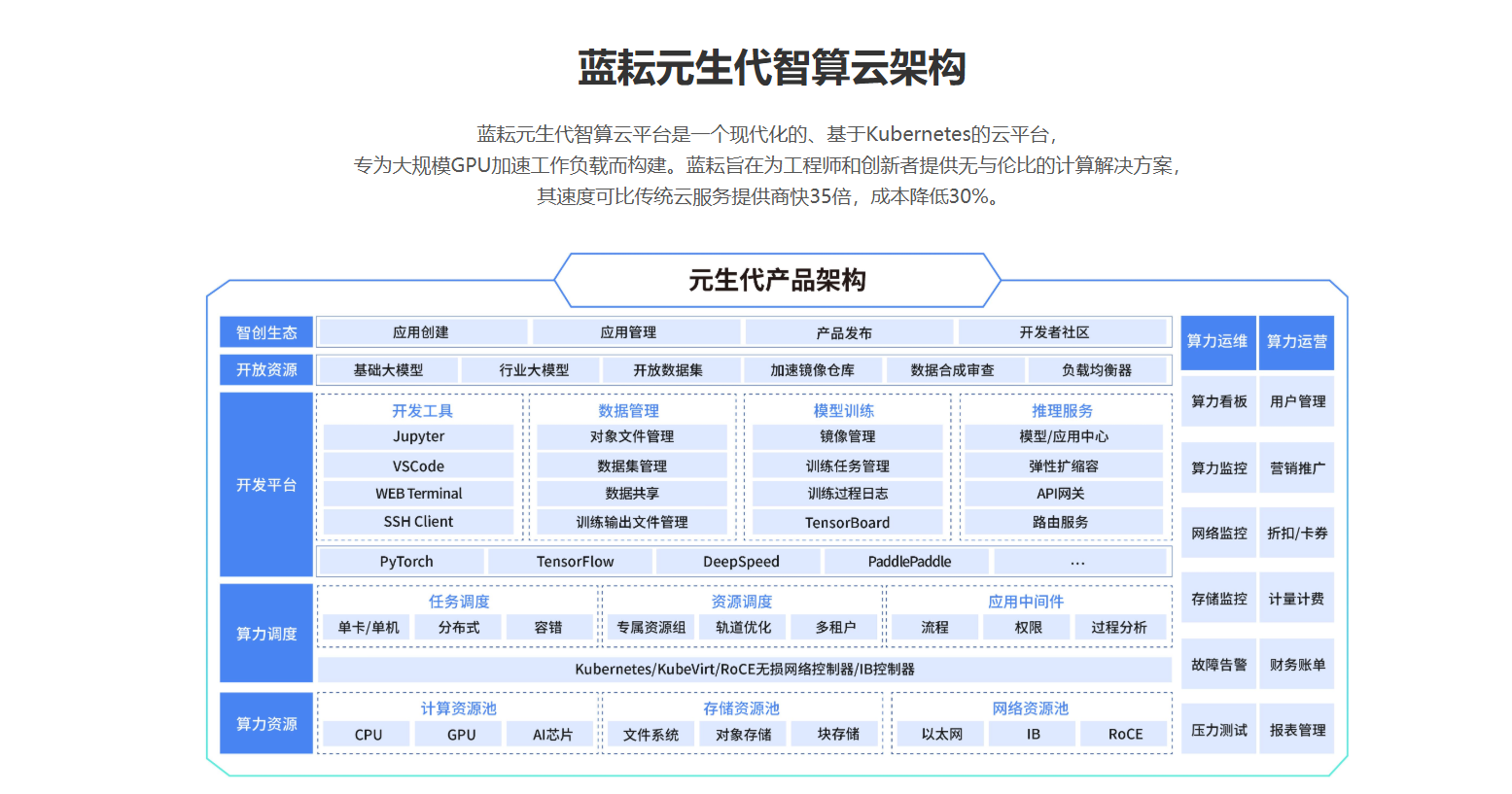

蓝耘智算平台是一个专为有高性能计算需求的用户设计的云计算平台,提供强大的计算能力和灵活的服务。该平台基于行业领先的灵活基础设施及大规模的GPU算力资源,构建了一个现代化的、基于Kubernetes的云平台,专为大规模GPU加速工作负载而设计。

DeepSeek-R1满血版:核心技术与突破

核心技术亮点

纯强化学习训练:

- DeepSeek满血版是首个完全通过强化学习训练的大型语言模型,无需传统的监督微调或大量的人工标注数据,仅依靠奖励信号就能发展出强大的推理能力。

- 这一突破验证了强化学习在大型语言模型训练中的巨大潜力,为未来的模型训练提供了新的思路和方向。

冷启动与强化学习结合:

- DeepSeek引入了冷启动数据结合强化学习的训练方法,有效解决了可读性和语言混合方面的局限。

- 这种方法在保持强化学习优势的同时,显著提升了模型的推理能力,使其能够更好地处理各种复杂的语言任务。

GRPO算法框架:

- DeepSeek开发了独特的GRPO(Group Relative Policy Optimization)算法框架,通过群组相对优势估计来优化策略网络。

- 与传统方法相比,GRPO避免了高计算开销问题,使模型在训练过程中能够更高效地学习和优化,提高了训练效率和模型性能。

多层次奖励机制:

- DeepSeek设计了包括准确性奖励、格式奖励和语言一致性奖励等多层次的奖励机制。

- 这些奖励机制相互配合,确保模型在推理过程中不仅能得出准确的结果,还能保证输出的格式规范和语言表达的一致性。

技术突破

超长上下文理解能力:

- DeepSeek满血版支持超长上下文理解,能够处理和理解高达200k tokens的上下文信息,这在大型语言模型中是非常罕见的。

- 这一突破使得DeepSeek在处理长篇文档、复杂对话以及需要大量背景知识的任务时表现更为出色,能够更好地把握语义和逻辑关系。

高性能计算能力:

- 蓝耘科技为DeepSeek满血版配备了高性能的计算资源,包括先进的GPU和CPU,以及优化的软件系统和分布式计算技术。

- 这些硬件和软件的结合使得DeepSeek能够快速完成复杂的推理任务,大大缩短了推理时间,提高了推理效率。

广泛的应用场景:

- DeepSeek满血版凭借其强大的推理能力和灵活性,在多个应用场景中展现出卓越的性能。

- 无论是在数学教育、科研领域、编程辅助、软件开发、智能写作、智能客服还是知识问答系统中,DeepSeek都能提供高效、准确的推理和辅助服务。

蓝耘科技发布的DeepSeek满血版在核心技术与突破方面取得了显著成就,这些成就不仅提升了AI推理的体验和效率,也为AI技术的未来发展指明了方向。

元生代推理引擎:解锁AI潜能的强力引擎

多模态数据处理能力: 元生代推理引擎支持多模态数据的输入与处理,这意味着它能够同时处理文本、图像、音频等多种类型的数据。这种能力使得引擎能够应用于更广泛的场景,通过整合不同模态的数据,引擎能够提供更全面、准确的推理结果,从而满足复杂任务的需求

动态推理与高精度计算: 该引擎具备动态推理的能力,能够根据输入数据的特性和任务需求,灵活调整推理策略。这种灵活性使得引擎能够在不同场景下保持高效、准确的推理性能。

高效资源调度与成本优化: 元生代推理引擎结合了先进的容器化技术,实现了高效的资源调度。它能够根据任务的需求,自动优化算力的分配,确保每一份资源都能得到充分利用。

安全合规与输出保障: 安全性是AI技术中不可忽视的一环。元生代推理引擎内置了策略引擎,能够确保模型输出的内容符合安全规范。

快速入门:三步调用大模型接口,OpenAI SDK无缝兼容

蓝耘API接口与OpenAI官方规范完美契合,助力开发者无缝迁移现有应用。只需轻松几步配置,即可畅享全新体验:

替换API参数: 简单将base_url调整为蓝耘接口地址(例如https://api.lkeap.cloud.tencent.com/v1),并填入平台专属api_key,即可迅速接入。选择心仪模型: 在调用时,只需指定model参数为deepseek-r1或deepseek-v3,即可灵活选用蓝耘的强大模型,满足多样化需求。发送请求,尽享流畅对话: 借助标准的OpenAI SDK,开发者能够轻松发起对话,享受与ChatGPT同等出色的开发体验,无需繁琐适应,即刻上手。

蓝耘API接口,让迁移无忧,开发更便捷,为您的AI之旅加速助力!

python:

若各位选择使用python进行终端回答调用,蓝耘也给了我们对应的方法。我们只需要创建一个python文件命名为ark_example.py,将以下示例代码拷贝进文件。并替换密钥为 我们自己的API KEY。将content中的<你是谁>修改为自定义提问内容。点击运行,终端将显示模型返回结果。我们只要这样做好之后首次模型服务调用已完成。

from openai import OpenAI

# 构造 client

client = OpenAI(

api_key="sk-xxxxxxxxxxx", # APIKey

base_url="https://maas-api.lanyun.net/v1",

)

# 流式

stream = True

# 请求

chat_completion = client.chat.completions.create(

model="/maas/deepseek-ai/DeepSeek-R1",

messages=[

{

"role": "user",

"content": "你是谁",

}

],

stream=stream,

)

if stream:

for chunk in chat_completion:

# 打印思维链内容

if hasattr(chunk.choices[0].delta, 'reasoning_content'):

print(f"{chunk.choices[0].delta.reasoning_content}", end="")

# 打印模型最终返回的content

if hasattr(chunk.choices[0].delta, 'content'):

if chunk.choices[0].delta.content != None and len(chunk.choices[0].delta.content) != 0:

print(chunk.choices[0].delta.content, end="")

else:

result = chat_completion.choices[0].message.content

CURL:

用户还可以通过 HTTP 方式直接调用方舟模型服务。在终端窗口中,拷贝下面命令,并替换密钥为 我们自己的API KEY。将content中的<你好>修改为自定义提问内容。终端将显示模型返回结果。我们只要这样做好之后首次模型服务调用已完成。

curl https://maas-api.lanyun.net/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer sk-xxxxxxxxxxxxxx" \

-d '{

"model": "/maas/deepseek-ai/DeepSeek-R1",

"messages": [

{

"role": "user",

"content": "你好"

}

],

"stream": true

}'

实战用例:OpenAI SDK进阶使用

随着人工智能技术的飞速发展,OpenAI SDK已成为开发者们构建智能应用的重要工具。它不仅简化了与OpenAI API的交互流程,还提供了丰富的功能支持,使得开发者能够更专注于创新而非繁琐的集成细节。本文将通过一个实战用例,展示OpenAI SDK的进阶使用方法,帮助开发者更好地利用这一强大工具。

今天我们用几个经典的例子来见证一下他的强大!

实战用例:构建一个智能客服系统

import openai

# 配置OpenAI客户端

openai.api_key = 'YOUR_API_KEY'

def multi_turn_chat(user_input):

context = user_input # 初始对话上下文

prompt = f"用户: {context}\nAI助手: " # 构建初始提示

while True:

try:

# 发送请求到OpenAI API

response = openai.Completion.create(

prompt=prompt,

model='gpt-4', # 使用GPT-4模型

max_tokens=150,

temperature=0.7,

n=1,

stop=None

)

# 获取AI的回答

ai_response = response.choices[0].text.strip()

# 打印AI的回答

print(f"AI助手: {ai_response}")

# 等待用户输入新的内容,或输入'退出'结束对话

user_continue = input("用户: ")

if user_continue.lower() == '退出':

break

context += f"\n用户: {user_continue}"

prompt = f"用户: {context}\nAI助手: "

except openai.ApiError as e:

print(f"API请求失败: {e}")

break

# 示例对话开始

initial_input = "请问如何更改我的账户密码?"

multi_turn_chat(initial_input)

实战用例:内容创作辅助工具的风格转换功能

import openai

# 配置OpenAI客户端

openai.api_key = 'YOUR_API_KEY'

def generate_text_with_style(prompt, style):

try:

# 设置风格参数(这里以“风格”作为示例,实际可能需要根据模型支持的风格进行调整)

# 注意:GPT模型本身可能不支持直接的风格参数,这里仅为示例

# 在实际应用中,可能需要通过调整temperature、top_p等参数或结合其他技术实现风格转换

style_prompt = f"请以一种{style}的风格回答以下问题:\n{prompt}"

# 发送请求到OpenAI API

response = openai.Completion.create(

prompt=style_prompt,

model='gpt-4',

max_tokens=200,

temperature=0.9 if style.lower() == '创意' else 0.5, # 假设“创意”风格使用较高temperature

n=1,

stop=None

)

# 获取生成的文本

generated_text = response.choices[0].text.strip()

return generated_text

except openai.ApiError as e:

print(f"API请求失败: {e}")

return None

# 示例使用

prompt = "请描述一个未来城市的景象。"

style = "正式" # 或 "创意" 等其他风格

generated_text = generate_text_with_style(prompt, style)

print(generated_text)

部署与搭配Chatbox实现本地AI助手

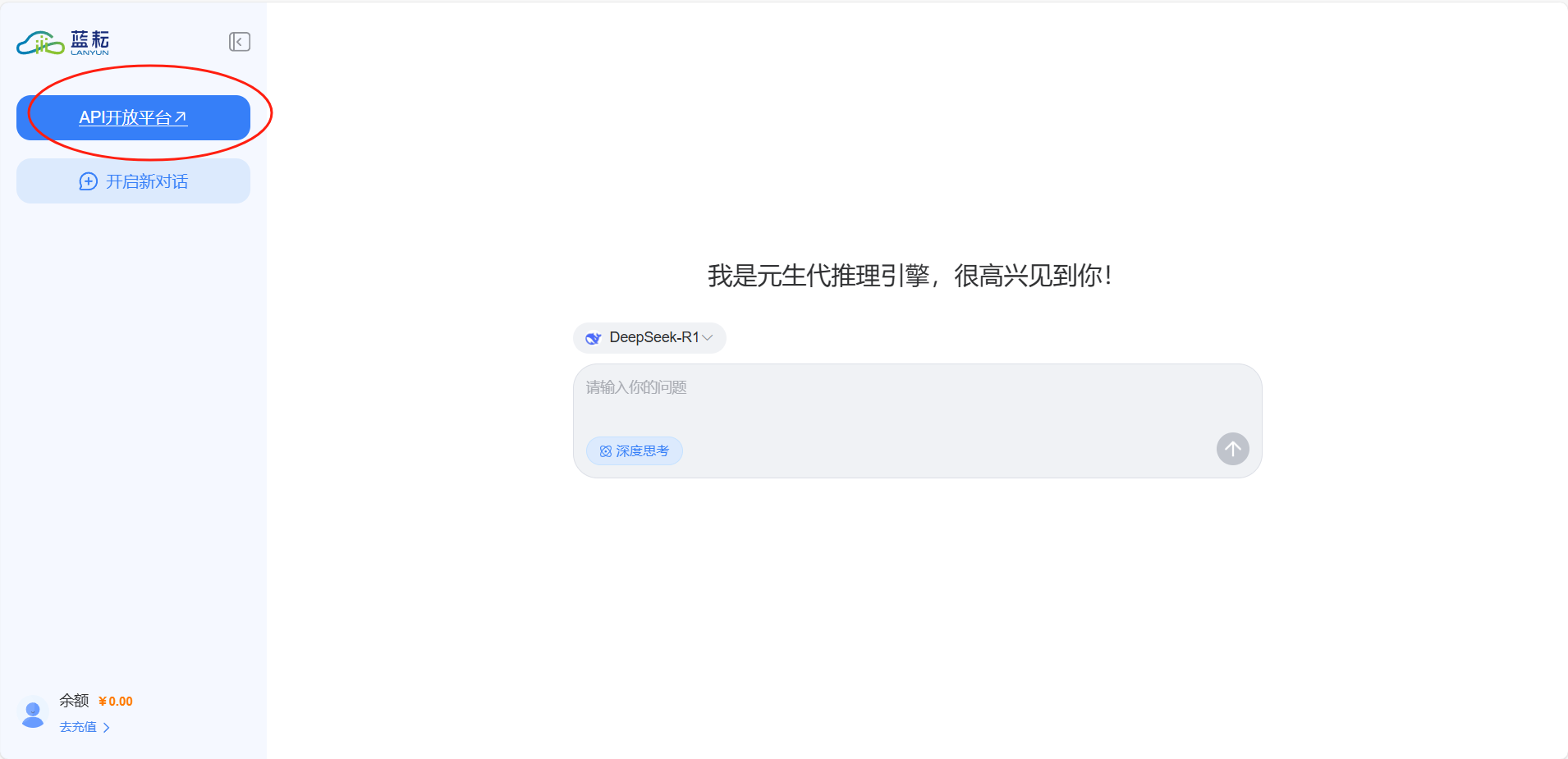

获取API KEY

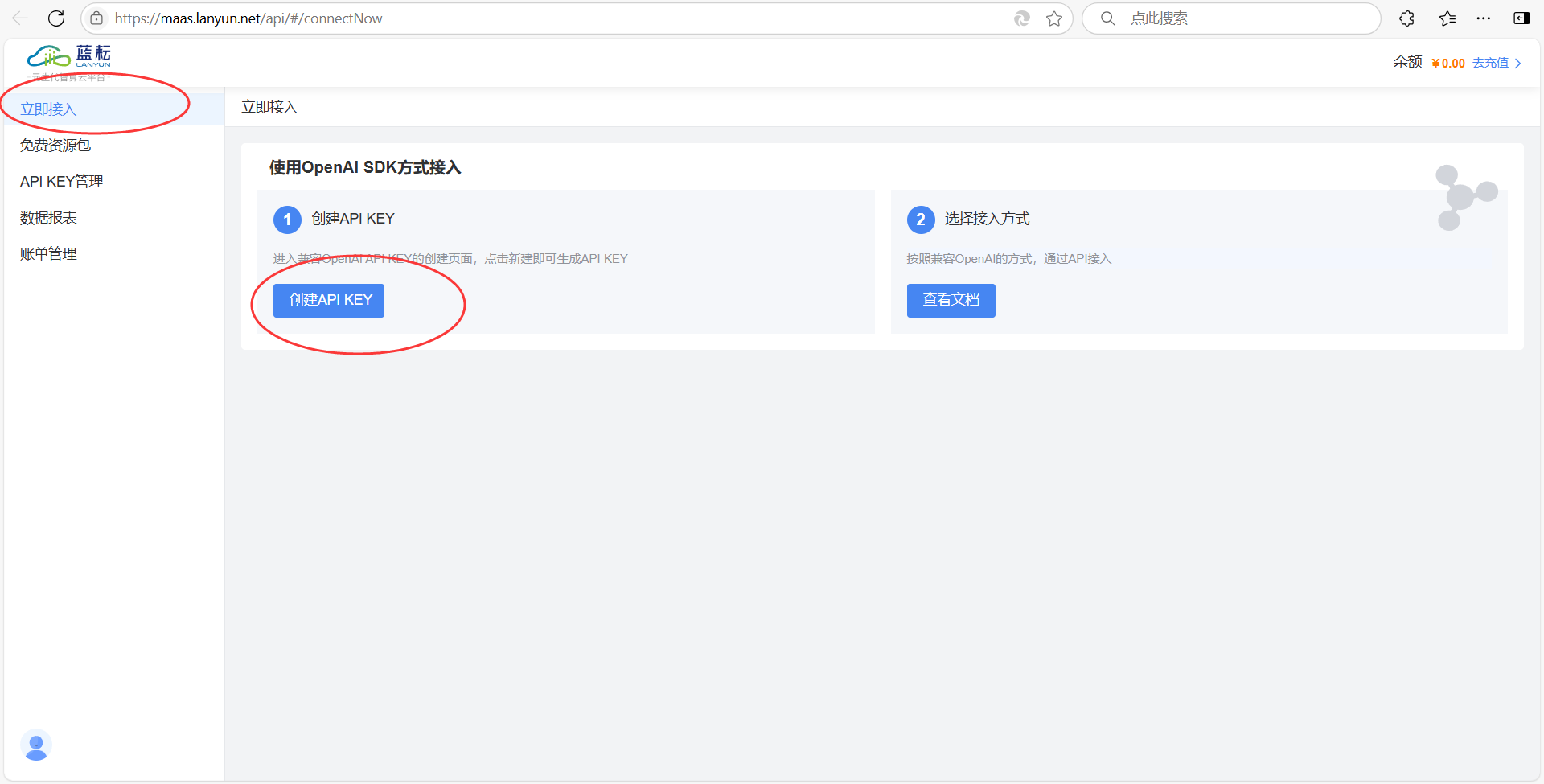

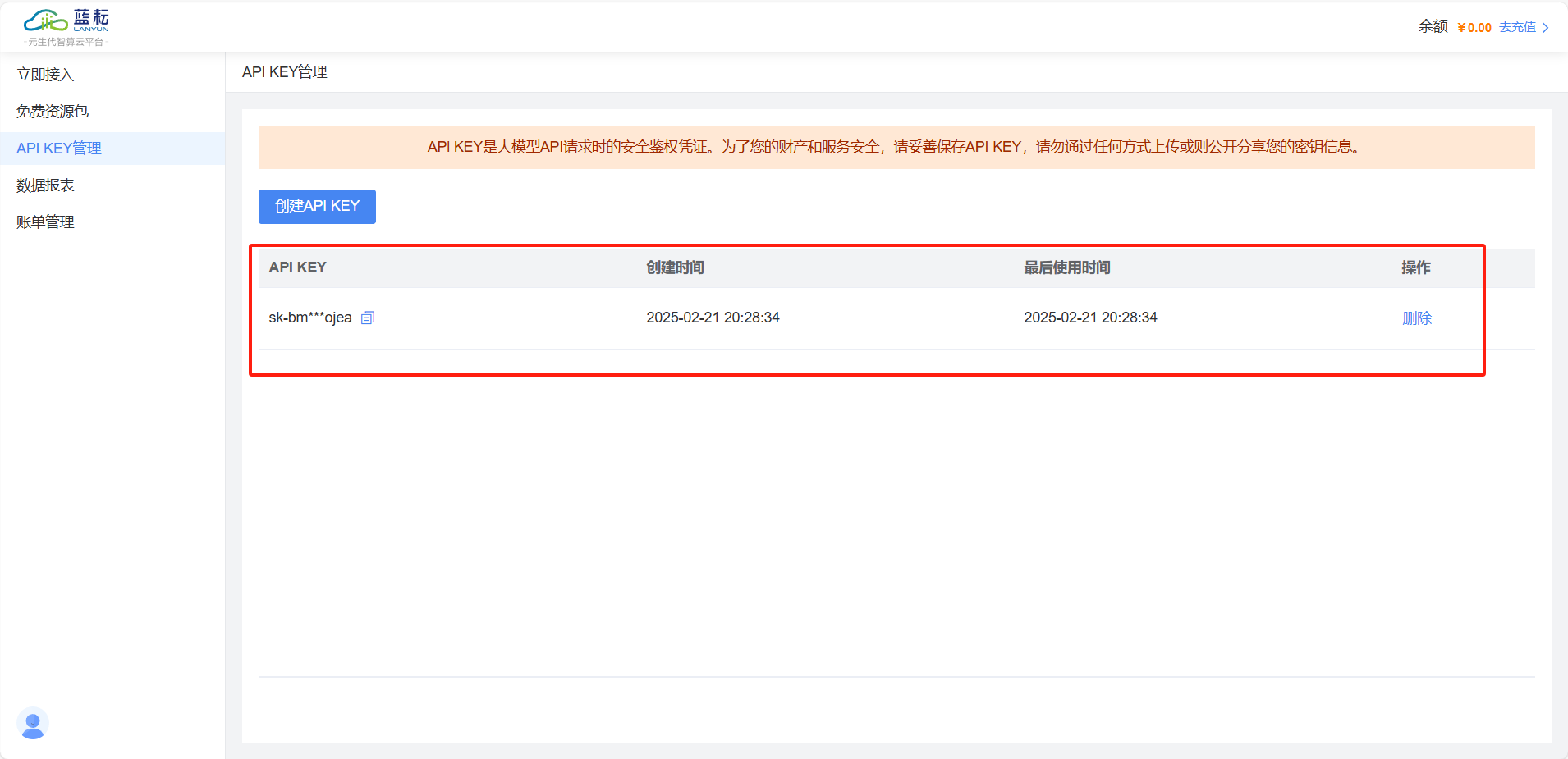

- 进入 API平台 > 立即接入管理,单击创建API KEY。

- 单击创建 API KEY 按钮。

- 在名称文本框中确认或修改API KEY名称后,点击创建。

注意:

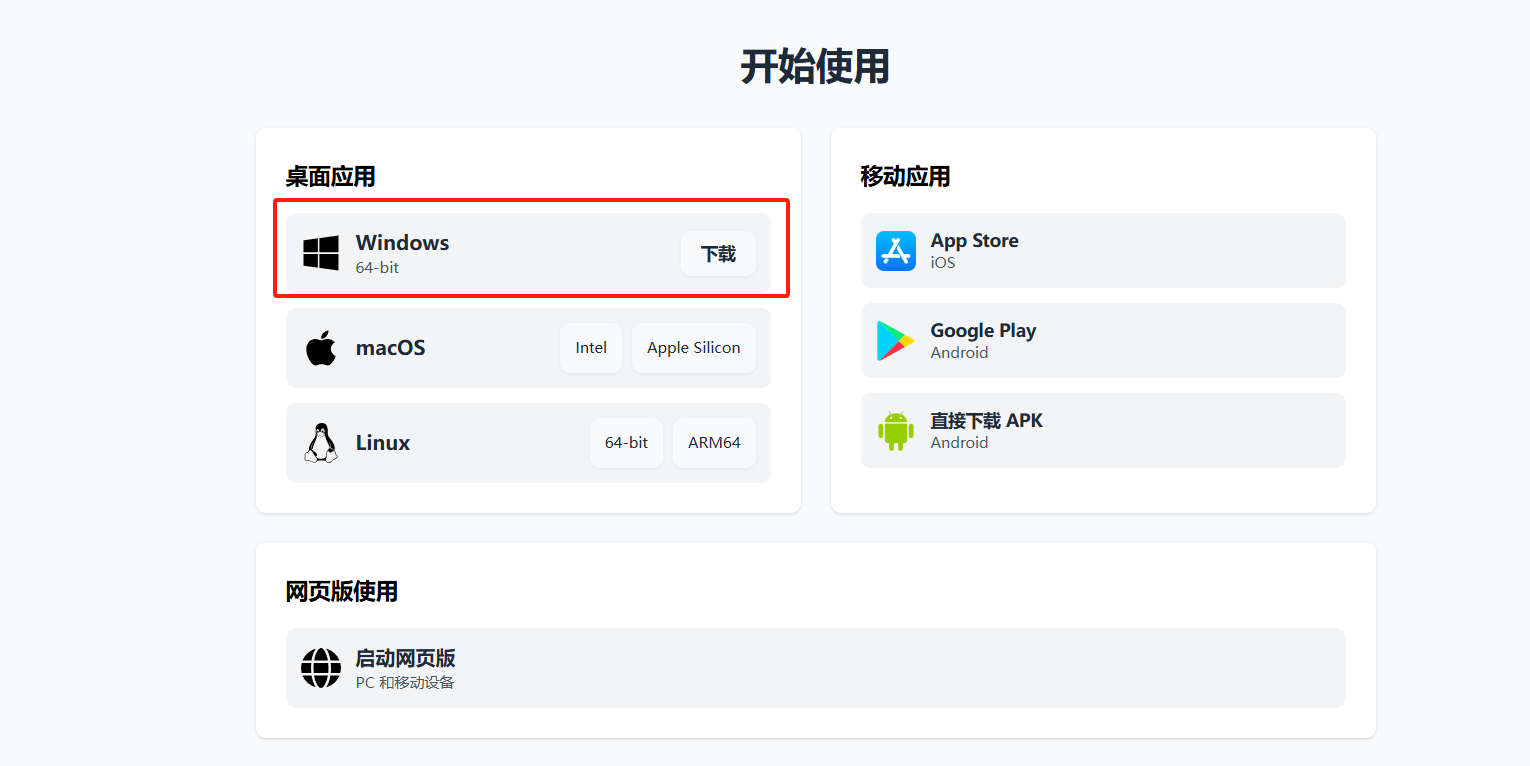

Chatbox:连接蓝耘API的高效跨平台客户端

Chatbox,作为一款开源且功能强大的跨平台客户端,为连接蓝耘API提供了无与伦比的便捷体验。无论是Windows、Mac、Linux用户,还是移动端设备持有者,都能轻松下载安装Chatbox,从官网或第三方平台获取最新版本,享受无缝连接蓝耘API的高效服务。

-

访问 Chatbox 下载地址下载并安装客户端,本方案以 Windows 为例。

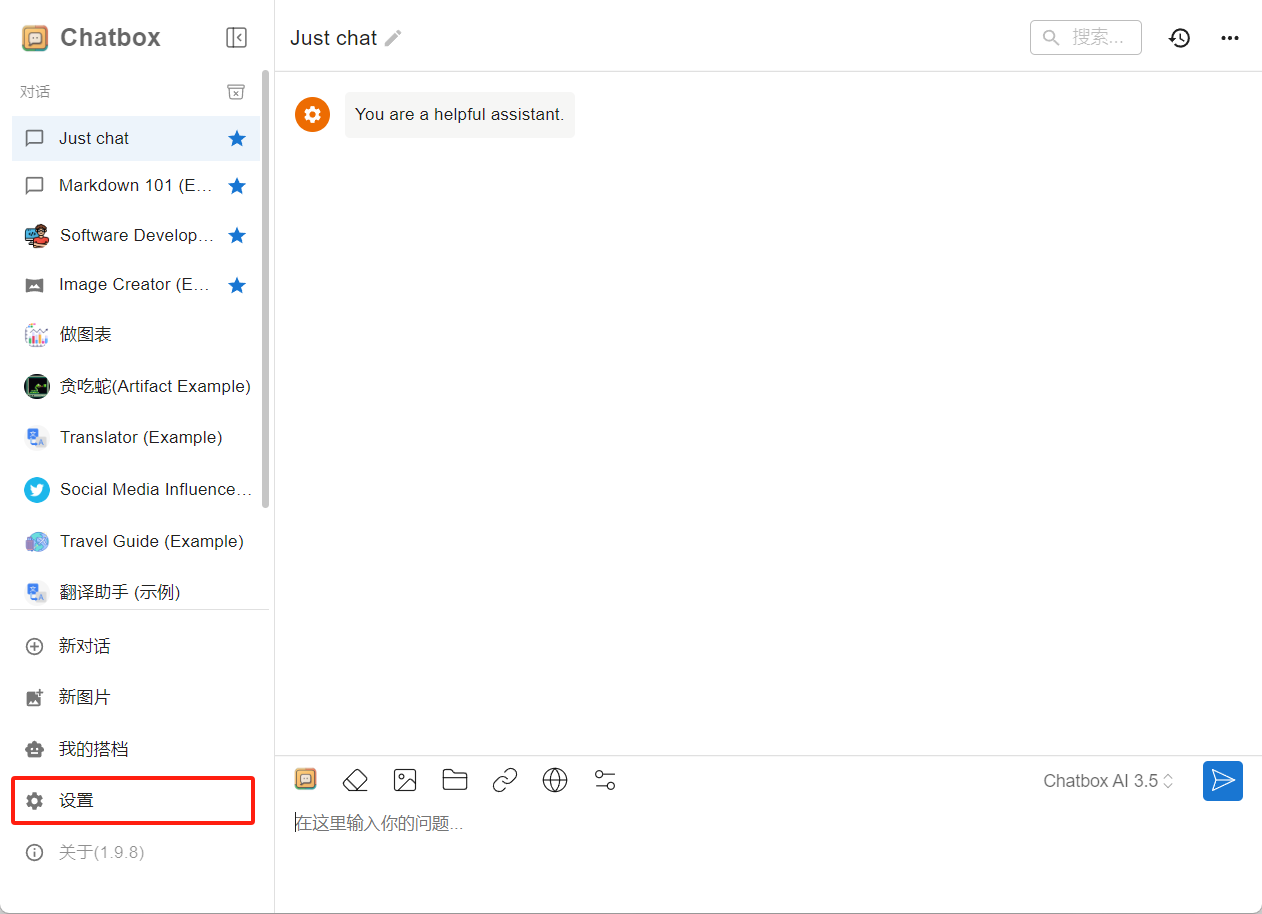

-

运行并配置蓝耘 API ,单击设置。

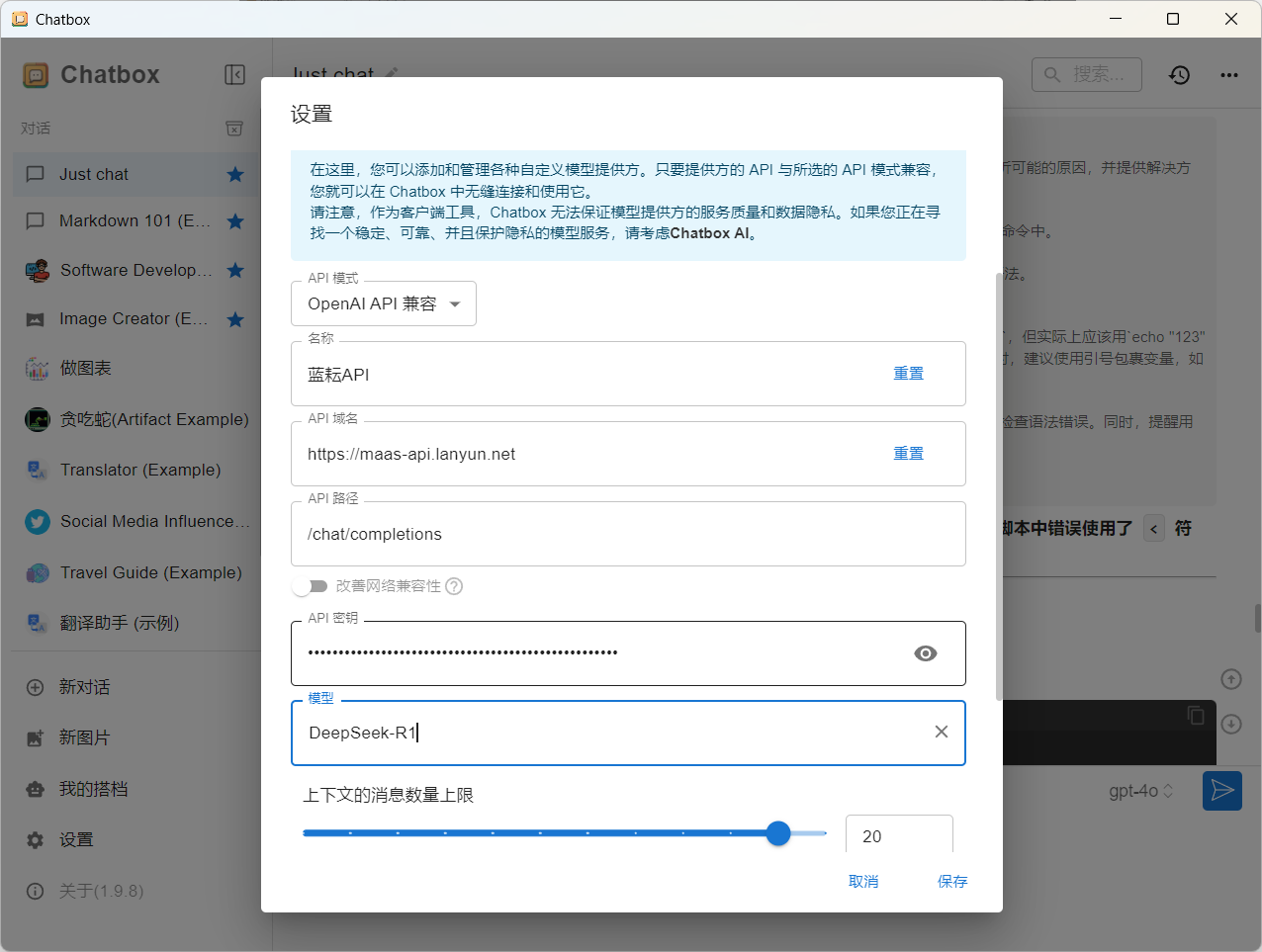

-

在弹出的看板中按照如下表格进行配置。

| 项目 | 说明 | 示例值 |

|---|---|---|

| 模型提供方 | 下拉选择模型提供方。 | 添加自定义提供方 |

| 名称 | 填写定义模型提供方名称。 | 蓝耘 API |

| API 域名 | 填写模型服务调用地址。 | https://maas-api.lanyun.net/v1 |

| API 路径 | 填写模型服务调用路径。 | /chat/completions |

| API 密钥 | 填写模型服务调用 API 密钥。 | 填写 上一步骤获取的蓝耘 API-KEY |

| 模型 | 填写调用的模型(本方案以 deepseek-r1 模型为例,可自行配置其它模型进行体验)。 | maas/deepseek-ai/DeepSeek-R1 |

点击保存创建对话:确认目标模型,即可开启聊天

总结

蓝耘科技近期震撼发布了DeepSeek满血版,这款全新的人工智能推理工具不仅带来了前所未有的性能提升,更以尊享500万Tokens特权引领了AI推理体验的新飞跃。

DeepSeek满血版作为蓝耘科技的最新力作,展现出了强大的技术实力和创新精神。此次发布的版本在算法、数据处理能力、以及模型规模上均实现了显著提升。通过深度学习和自然语言处理技术的融合,DeepSeek满血版能够深入挖掘数据,快速准确地响应用户需求,无论是文本、图像、音频还是视频数据,都能得到精准的处理和反馈。

尤为值得一提的是,蓝耘科技为DeepSeek满血版用户尊享了500万Tokens特权。这一举措不仅彰显了蓝耘科技对用户需求的深刻洞察,也体现了其在AI推理领域的领先地位。500万Tokens的配额,足以满足大规模用户应用的需求,确保了在突发流量和业务高峰时,系统依然能够保持稳定、低延迟的服务。

让我们加入蓝耘智算平台,开启新的篇章!推荐指数:★★★★★(5/5)

蓝耘智算平台注册链接:https://cloud.lanyun.net//#/registerPage?promoterCode=0131