RCNN,SSD, YOLO的优缺点比较及反思

1. RCNN

rcnn对于原有的目标检测算法提升50% 在VGG-16网络模型下,voc2007数据集上准确率为66%,但是速度很慢,内存占用量大,主要原因为候选框由速度较慢的selective search算法完成以及重复卷积网络计算。

Fast-RCNN

- 加入ROI池化 :提出ROI pooling池化层结构,解决了候选框子图将图像裁剪缩放到相同尺寸大小时产生坐标偏移的问题;fast R-CNN在全连接层之前插入了ROI pooling层,从而不需要对图像进行裁剪,很好的解决了这个问题。

- 多任务损失函数:将分类损失和边框定位回归损失结合在一起统一训练,最终输出对应分类和边框坐标。

- Fast-RCNN = RCNN + SPPNET - Crop

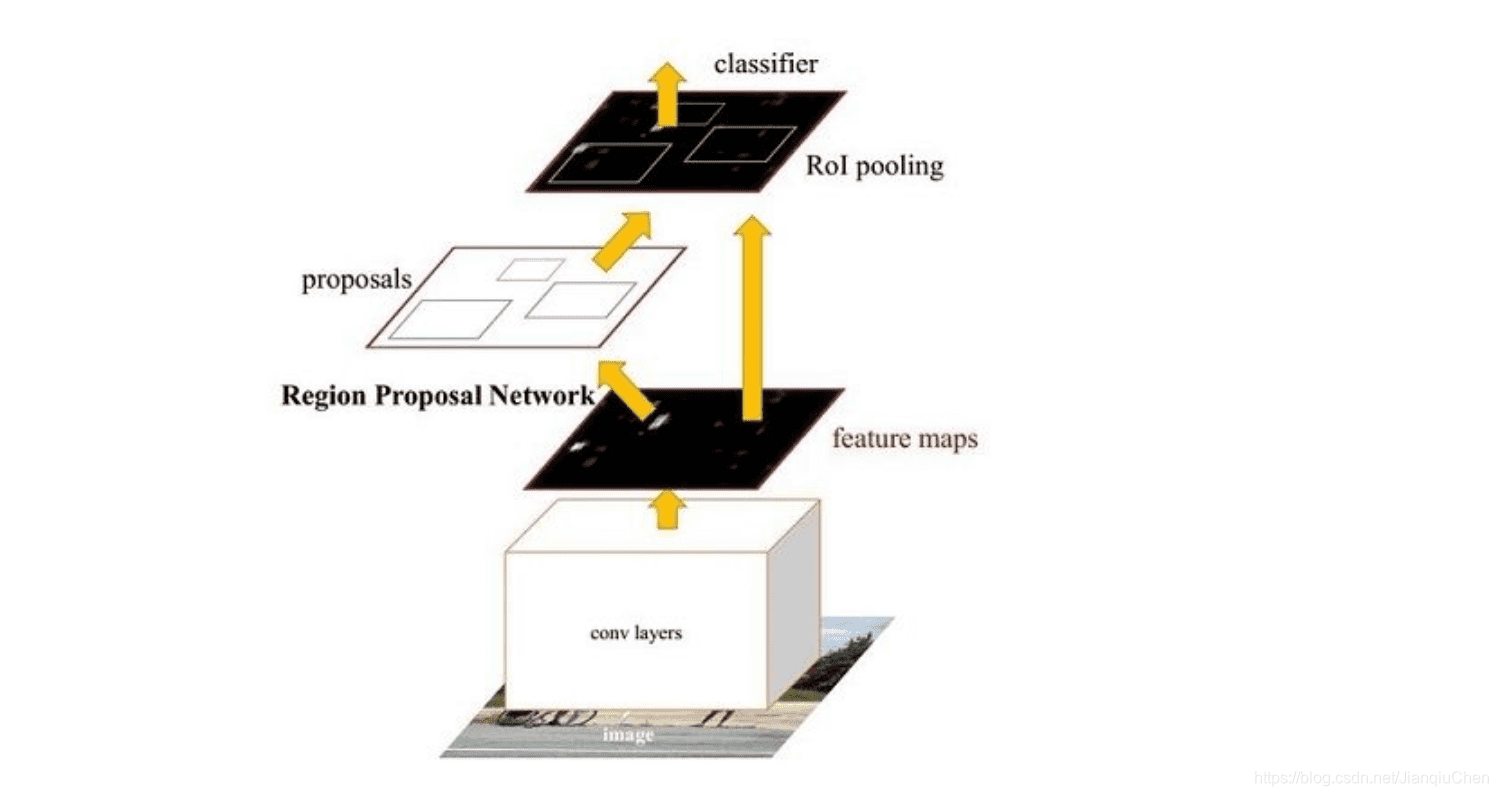

Faster-RCNN

- 加入RPN网络 :region proposal networks RPN层用于生成候选框,并利用softmax判断候选框是前景还是背景,从中选取前景候选框(因为物体一般在前景中),并利用bounding box regression调整候选框的位置,从而得到特征子图,称为proposals。

- 分类层:利用ROI层输出的特征图proposal,判断proposal的类别,同时再次对bounding box进行regression从而得到精确的形状和位置。

- 交替训练: 交替训练SPPNET和RPN网络(一次通过RPN网络一次通过SPPNET计算损失),测试集上先通过RPN进行分类再使用SPPNET进行最后的分类和回归

- Anchor框: 在高级特征上取k个Anchor框。anchor有[x,y,w,h]四个坐标偏移量,x,y表示中心点坐标,w和h表示宽度和高度。这样,对于feature map上的每个点,就得到了k个大小形状各不相同的选区region。

- Anchor框的计算: 先使用softmax确定是前景还是背景进行筛选,再进行bounding box回归。

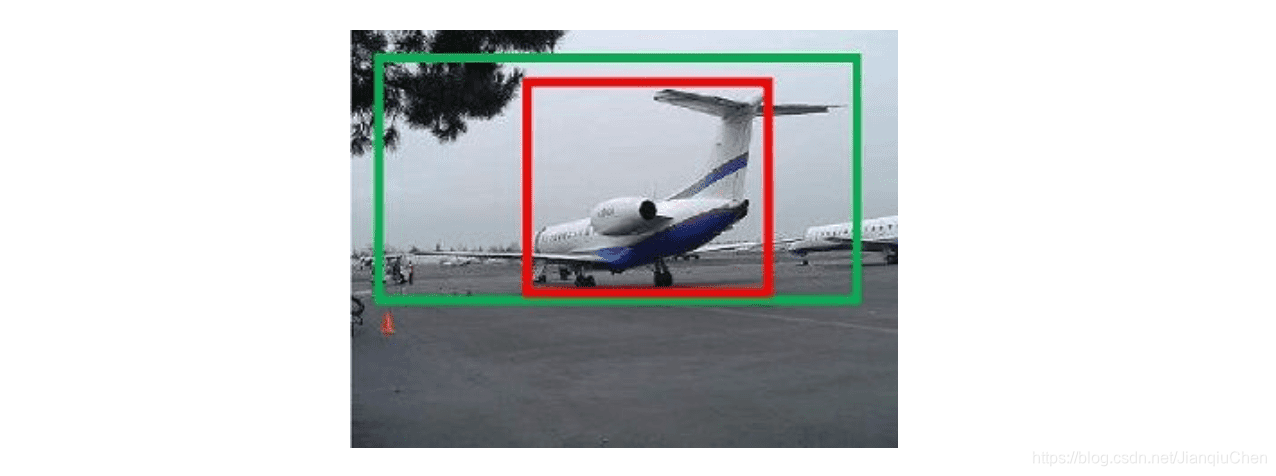

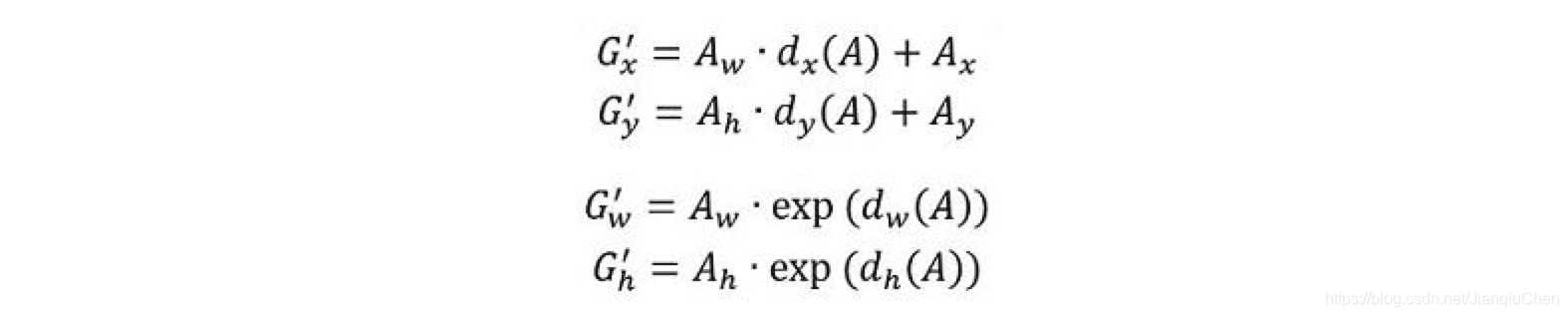

假设红色框的坐标为[x,y,w,h], 绿色框,也就是目标框的坐标为[Gx, Gy,Gw,Gh], 我们要建立一个变换,使得[x,y,w,h]能够变为[Gx, Gy,Gw,Gh]。最简单的思路是,先做平移,使得中心点接近,然后进行缩放,使得w和h接近。如下

学习dx dy dw dh这四个线性变换,可以用线性回归来建模。对于空间位置loss,我们一般采用均方差算法并可以使用自适应梯度下降算法Adam优化方法。 - Faster-RCNN = Fast-RCNN + RPN - SS

Faster-RCNN 系列的反思

使用金字塔模型可以解决RCNN裁剪尺度变化的问题,对感兴趣区域进行分类提高了候选框采集的速度。对小物体有更好对检测效果。

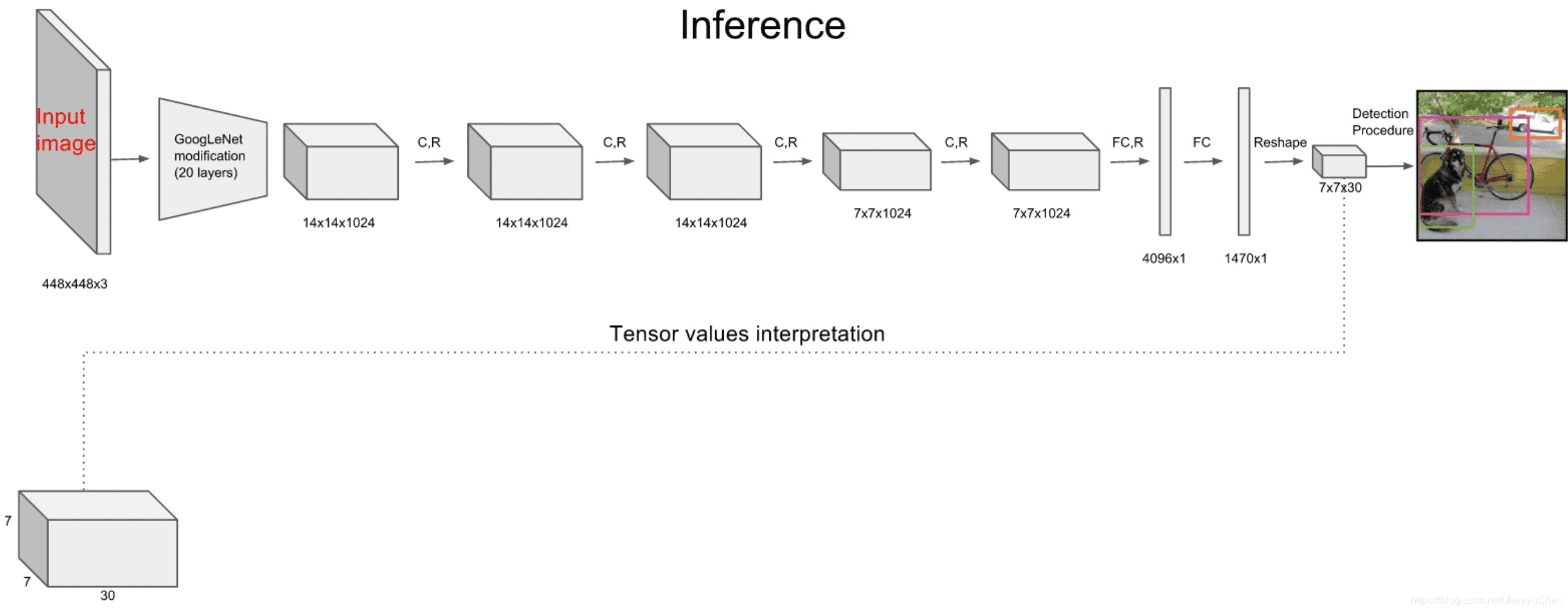

2. YOLO

you only look once:one-stage的目标检测算法,将物体的定位和分类在一起完成,在一个输出层回归bounding box的位置和bounding box所属类别。在一块泰坦显卡上,FPS达到了45,实现了实时(Realtime)检测。

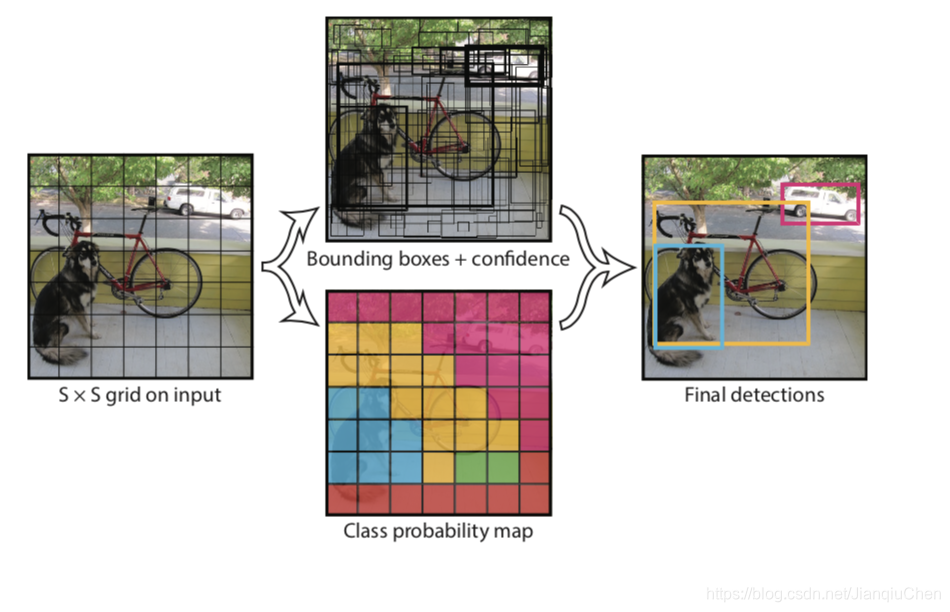

YOLO V1

- 图像分割 :将图像隐式的分割为S X S个网格,当物体中心落在哪个网格里哪个网格就负责预测

- 计算量小:张量大小只有 S x S x (B*5 + C)。

- 训练集和测试集图片大小不一致 训练图片大小为224x224,测试图片为448x448

YOLO V2

- 批标准化 :加入BN层

- 加入448 x 448图片:在训练过程中加入和测试图像一样大的448 x 448 size的图像

- 引用Anchor Boxes 提升了recall值但是小幅降低了mAP(更稳定)。

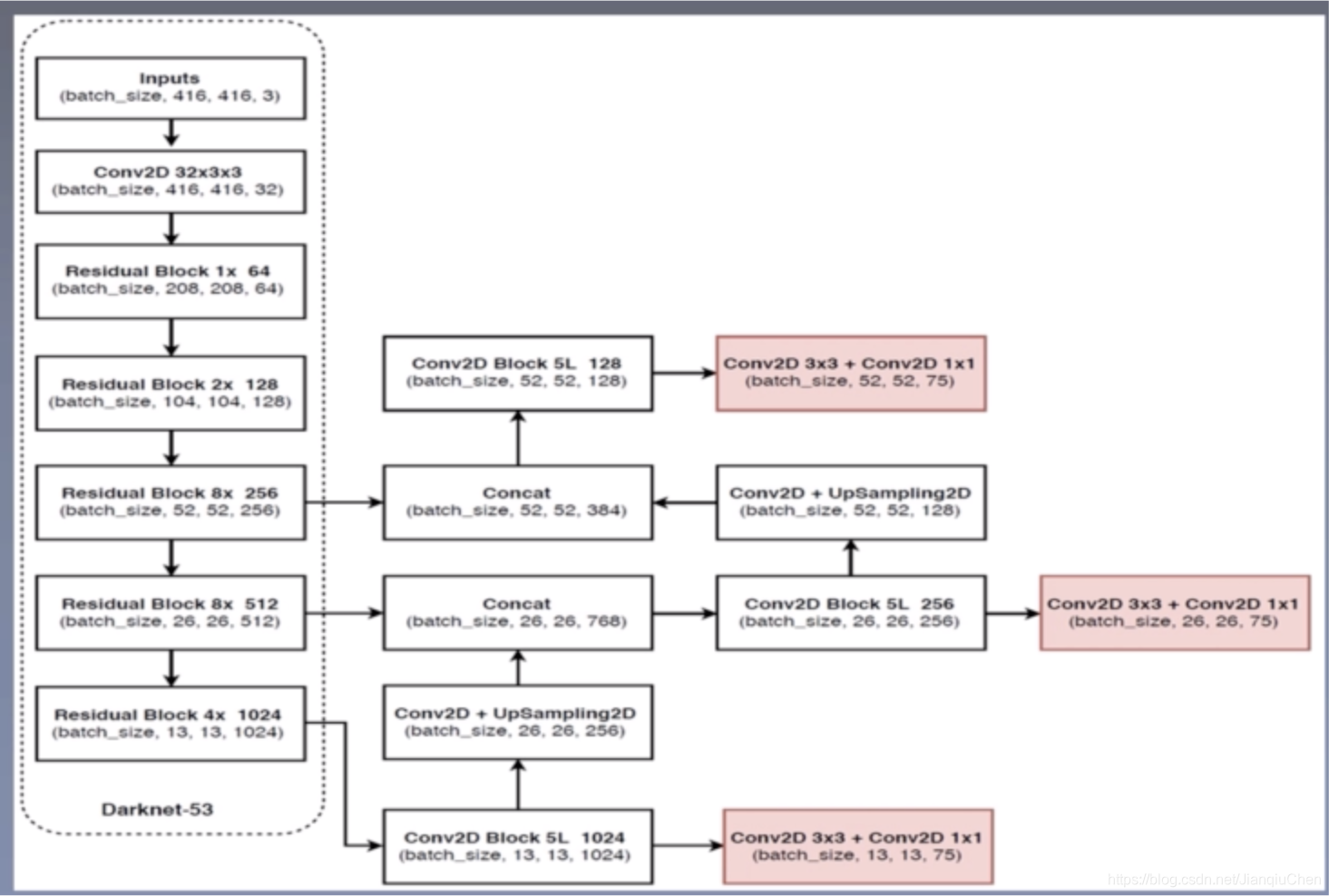

YOLO V3

-

YOLO V3 网络结构

- 3个Anchor框 :52x52 小 26 x26 中 13 x 13 大

- 加入448 x 448图片:在训练过程中加入和测试图像一样大的448 x 448 size的图像

- 引用Anchor Boxes :提升了recall值但是小幅降低了mAP(更稳定)。

- 加入NMS筛选

YOLO系列的反思

丧失部分精度,将图片端到端的进行目标检测,也引入了rcnn的Anchor框体系大幅提升mAP。因为没有进行区域采样,所以对全局信息有较好的表现,但是在小范围的信息上表现较差。

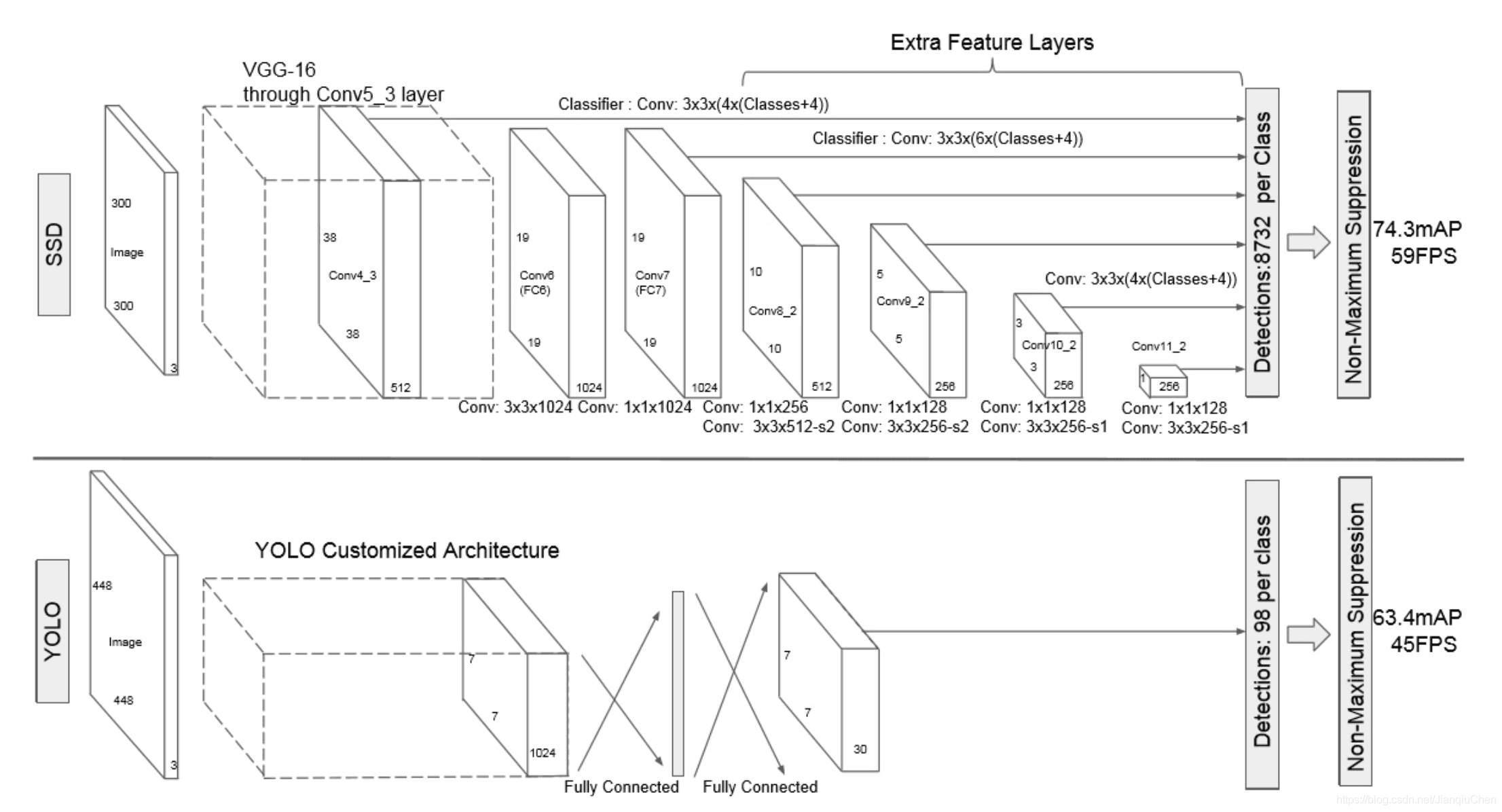

3. SSD

Single Shot MultiBox Detector,平衡了YOLO和Faster RCNN的优缺点的模型。Faster R-CNN准确率mAP较高,漏检率recall较低,但速度较慢。而yolo则相反,速度快,但准确率和漏检率较低。

- 密集采样 :在6个特征图上进行4-6个bounding box框采样(论文上写的是default boxes 但是是和其他论文里对bounding box一样)

- 多尺寸feature map:每一个卷积层,都会输出不同大小感受野的feature map。在这些不同尺度的feature map上,进行目标位置和类别的训练和预测,从而达到多尺度检测的目的,可以克服yolo对于宽高比不常见的物体,识别准确率较低的问题。而yolo中,只在最后一个卷积层上做目标位置和类别的训练和预测。这是SSD相对于yolo能提高准确率的一个关键所在。

- 多anchor框 :每个anchor对应4-6个位置参数和C个类别参数.

- 加入NMS筛选

SSD反思

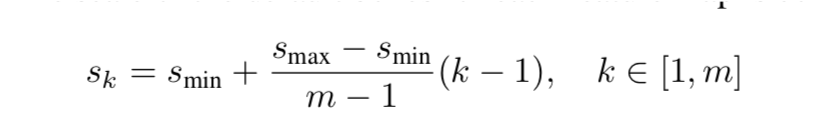

SSD相比SPPNET可以实现参数共享即在多个feature map上使用单一网络。SSD的Anchor框大小是计算出来的,相比Faster RCNN的固定anchor框更加科学。下图为不同feature map上Anchor框的比率。 低级feature map使用小anchor框获取细节信息,高级feature map上使用大anchor框获取全局信息。

参考资料:

[1]: https://www.cnblogs.com/carsonzhu/p/9547973.html