引言

人工神经网络(Artificial Neural Networks, ANNs)是人工智能领域的核心技术之一,近年来在图像识别、自然语言处理、医疗诊断等多个领域取得了显著成果。本文旨在为初学者提供一个全面的人工神经网络入门指南,涵盖其基本原理、常见结构、优化策略以及代码实现。通过本文,读者将能够理解神经网络的基本概念,并掌握如何在实际项目中应用这些技术。

一. 人工神经网络基础理论

1.1 神经网络的基本原理

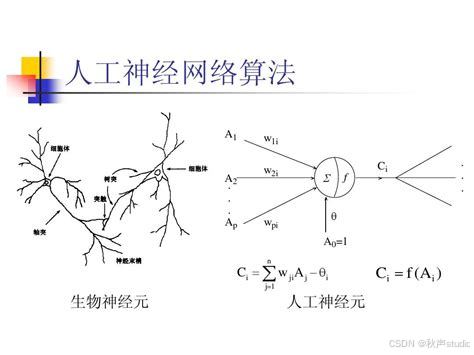

人工神经网络的基本原理是模拟人脑神经元的工作方式。人脑由数十亿个神经元组成,这些神经元通过突触连接,形成一个复杂的网络。人工神经网络通过数学模型模拟这一过程,构建虚拟的“神经元网络”,从而实现对数据的处理和学习。

如上图所示,人工神经元(Artificial Neuron)是对生物神经元(Biological Neuron)的抽象和模拟。每个神经元接收多个输入信号,这些信号经过加权求和后,通过激活函数进行非线性变换,最终产生输出信号。

在神经网络中,每个神经元接收来自其他神经元的输入信号,这些信号经过加权求和后,通过激活函数进行非线性变换,最终产生输出信号。多个神经元按照特定的结构连接起来,形成一个网络。通过反复调整网络中的权重和偏置,神经网络能够从数据中学习到规律,并用于预测或分类任务。

1.2 神经网络的核心组件

1.2.1 神经元(节点)

神经元是神经网络的基本单元,其结构模拟生物神经元。每个神经元接收多个输入信号,这些信号经过加权求和后,通过激活函数进行非线性变换,最终产生输出信号。常见的激活函数包括 Sigmoid、ReLU 和 Tanh 等。

- Sigmoid 函数:将输入值映射到 0 到 1 之间,常用于二分类问题。

- ReLU 函数:当输入大于 0 时输出等于输入,输入小于等于 0 时输出为 0,计算简单且能有效缓解梯度消失问题。

- Tanh 函数:将输入值映射到 -1 到 1 之间,输出以 0 为中心,适用于需要正负对称输出的场景。

1.2.2 连接权重与偏置

连接权重决定了神经元之间信号传递的强度,权重值越大,信号传递的影响越强。偏置则是神经元的固有输入,类似于线性函数中的截距,能够增加模型的灵活性。在训练过程中,权重和偏置会通过学习算法不断调整,以优化网络的性能。

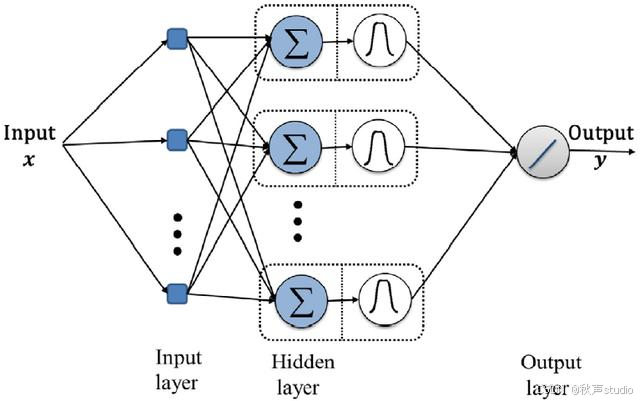

如上图所示,神经网络通常包括输入层(Input Layer)、隐藏层(Hidden Layer)和输出层(Output Layer)。输入层负责接收外部数据,隐藏层对数据进行特征提取和变换,输出层给出最终的预测结果。

1.3 主流学习算法

1.3.1 反向传播算法

反向传播算法是神经网络训练的核心算法,尤其在多层前馈神经网络中广泛应用。其基本思想是通过计算预测值与真实值之间的误差,然后反向传播误差,逐层调整权重和偏置,使得网络的预测结果逐渐接近真实值。

误差 = 1 2 ∑ i = 1 n ( y i − y ^ i ) 2 \text{误差} = \frac{1}{2} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2 误差=21i=1∑n(yi−y^i)2

其中, y i y_i yi 是真实值, y ^ i \hat{y}_i y^i 是预测值。

1.3.2 其他学习算法

除了反向传播算法,还有一些其他的学习算法,如遗传算法和粒子群优化算法。这些算法通过模拟自然界的进化或群体行为,优化神经网络的权重和结构。

二. 人工神经网络的常见结构

2.1 前馈神经网络

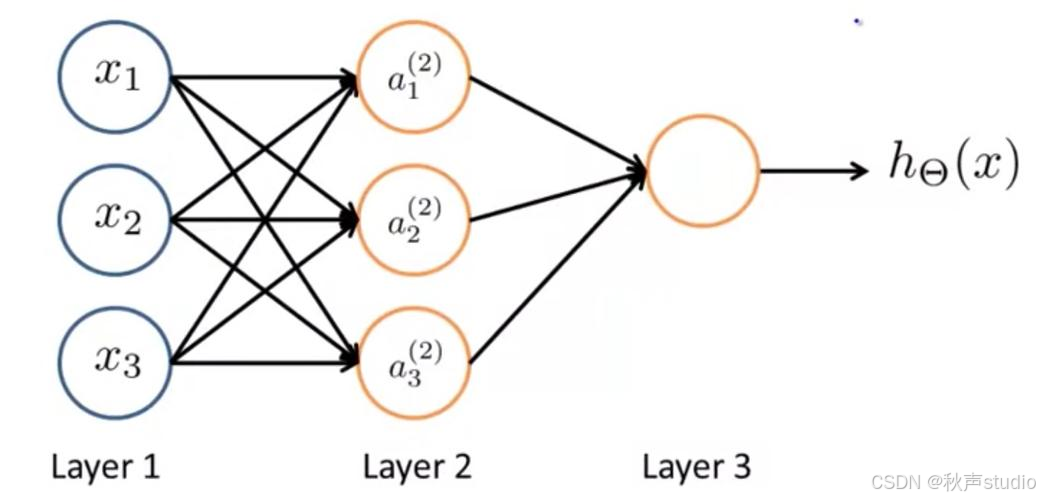

前馈神经网络是最简单的神经网络结构,信息从输入层单向传递到输出层,中间经过一个或多个隐藏层。前馈神经网络适用于简单的模式分类任务,如手写数字识别。

如上图所示,前馈神经网络通常包括多个层级(Layer 1、Layer 2、Layer 3),每一层由多个神经元组成,层与层之间通过权重连接。前馈神经网络适用于简单的模式分类任务,如手写数字识别。

2.1.1 前馈神经网络的结构

前馈神经网络通常包括输入层、隐藏层和输出层。输入层负责接收外部数据,隐藏层对数据进行特征提取和变换,输出层给出最终的预测结果。

2.2 卷积神经网络(CNN)

卷积神经网络(CNN)是专门用于处理图像数据的神经网络结构。其核心组件包括卷积层、池化层和全连接层。

2.2.1 卷积层

卷积层通过卷积核在图像上滑动,提取图像的局部特征。卷积核的权重在训练过程中不断调整,以提取出最有效的特征。

卷积操作 = ∑ i = 1 k ∑ j = 1 k w i , j ⋅ x i , j \text{卷积操作} = \sum_{i=1}^{k} \sum_{j=1}^{k} w_{i,j} \cdot x_{i,j} 卷积操作=i=1∑kj=1∑kwi,j⋅xi,j

其中, w i , j w_{i,j} wi,j 是卷积核的权重, x i , j x_{i,j} xi,j 是图像的局部像素值。

2.2.2 池化层

池化层对卷积层输出的特征图进行降维处理,常见的池化操作包括最大池化和平均池化。池化层能够减少计算量,防止过拟合。

2.3 递归神经网络(RNN)

递归神经网络(RNN)是专门用于处理序列数据的神经网络结构。其核心特点是具有循环连接,能够捕捉序列数据中的时间依赖关系。

2.3.1 RNN 的结构

RNN 的每个时间步接收当前时刻的输入和上一时刻的隐藏状态,通过隐藏层的计算生成当前时刻的输出和隐藏状态。RNN 适用于自然语言处理、语音识别等任务。

三. 人工神经网络的优化与改进策略

3.1 算法层面优化

3.1.1 新型学习算法

自适应学习率算法能够根据每个参数的历史梯度自动调整学习率,提升训练效率。基于注意力机制的学习算法则能够动态分配注意力权重,提升模型的表达能力。

3.1.2 模型压缩与加速

剪枝技术通过去除冗余连接或神经元,减少模型的参数量。量化技术则将模型参数从高精度表示转换为低精度表示,降低存储和计算需求。

3.2 架构层面改进

3.2.1 混合架构设计

混合架构结合了多种神经网络结构的优势,如 CNN 和 RNN 的结合能够同时处理图像和序列数据。

3.2.2 动态架构调整

动态架构调整技术能够根据任务复杂度自动调整网络的深度或宽度,提升模型的适应性。

3.3 结合其他技术协同创新

3.3.1 与知识图谱融合

知识图谱能够为神经网络提供丰富的结构化知识,提升模型的推理能力。例如,在智能问答系统中,知识图谱能够帮助模型理解用户的问题并生成准确的答案。

3.3.2 与强化学习结合

强化学习能够通过奖励信号优化神经网络的决策策略。例如,在机器人控制中,强化学习能够帮助机器人学习最优的行动策略。

四. 代码实现

4.1 使用 Python 和 TensorFlow/Keras 实现前馈神经网络

import tensorflow as tf

from tensorflow.keras import layers, models

# 构建一个简单的前馈神经网络

model = models.Sequential([

layers.Dense(128, activation='relu', input_shape=(784,)), # 输入层

layers.Dense(64, activation='relu'), # 隐藏层

layers.Dense(10, activation='softmax') # 输出层

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 打印模型结构

model.summary()

4.2 使用 PyTorch 实现卷积神经网络

import torch

import torch.nn as nn

import torch.optim as optim

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(1, 32, kernel_size=3, stride=1, padding=1)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2, padding=0)

self.fc1 = nn.Linear(32 * 14 * 14, 10)

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = x.view(-1, 32 * 14 * 14)

x = self.fc1(x)

return x

# 实例化模型

model = SimpleCNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

4.3 使用 TensorFlow/Keras 实现递归神经网络

import tensorflow as tf

from tensorflow.keras import layers, models

# 构建一个简单的递归神经网络

model = models.Sequential([

layers.SimpleRNN(64, activation='relu', input_shape=(None, 100)), # 输入层

layers.Dense(10, activation='softmax') # 输出层

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 打印模型结构

model.summary()

结语

人工神经网络作为人工智能的核心技术之一,已经在多个领域取得了显著成果。通过本文的介绍,读者应该对神经网络的基本原理、常见结构、优化策略以及代码实现有了初步的了解。未来,随着技术的不断进步,神经网络将在更多领域发挥重要作用,推动社会的智能化发展。

参考文献

学习是通往智慧高峰的阶梯,努力是成功的基石。

我在求知路上不懈探索,将点滴感悟与收获都记在博客里。

要是我的博客能触动您,盼您 点个赞、留个言,再关注一下。

您的支持是我前进的动力,愿您的点赞为您带来好运,愿您生活常暖、快乐常伴!

希望您常来看看,我是 秋声,与您一同成长。

秋声敬上,期待再会!