Multi-class Road User Detection with 3+1D Radar in the View-of-Delft Dataset

本文介绍一个新的自动驾驶数据集:VOD,论文收录于 ICRA2022。下一代毫米波雷达除了提供距离、方位和多普勒速度外,还会提供高度信息。

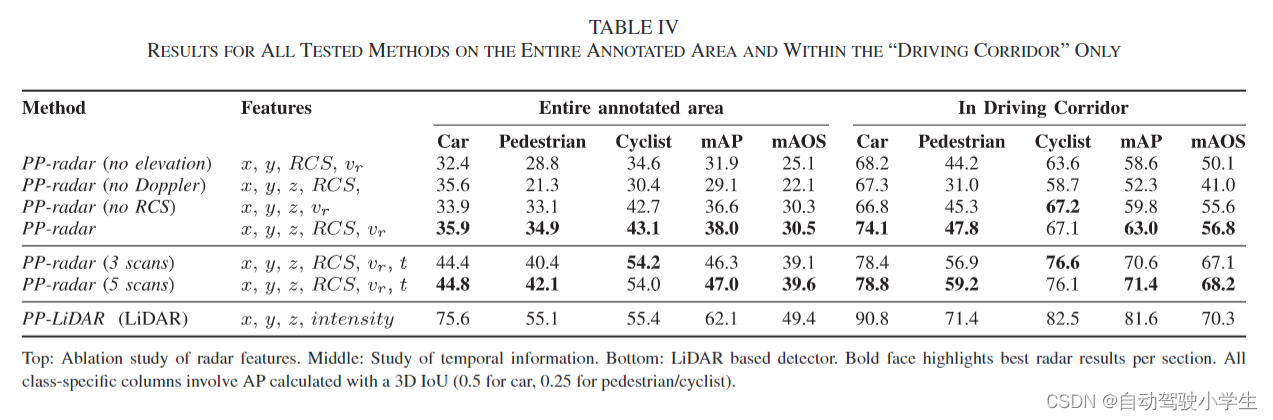

- 在本文中,作者将 PointPillars 3D 检测器应用于了 3+1D 雷达数据 (1D指的是多普勒)。在消融实验中,作者比较了雷达高度信息、多普勒速度、雷达反射截面 RCS 和雷达点云时域融合对最终检测性能的影响。

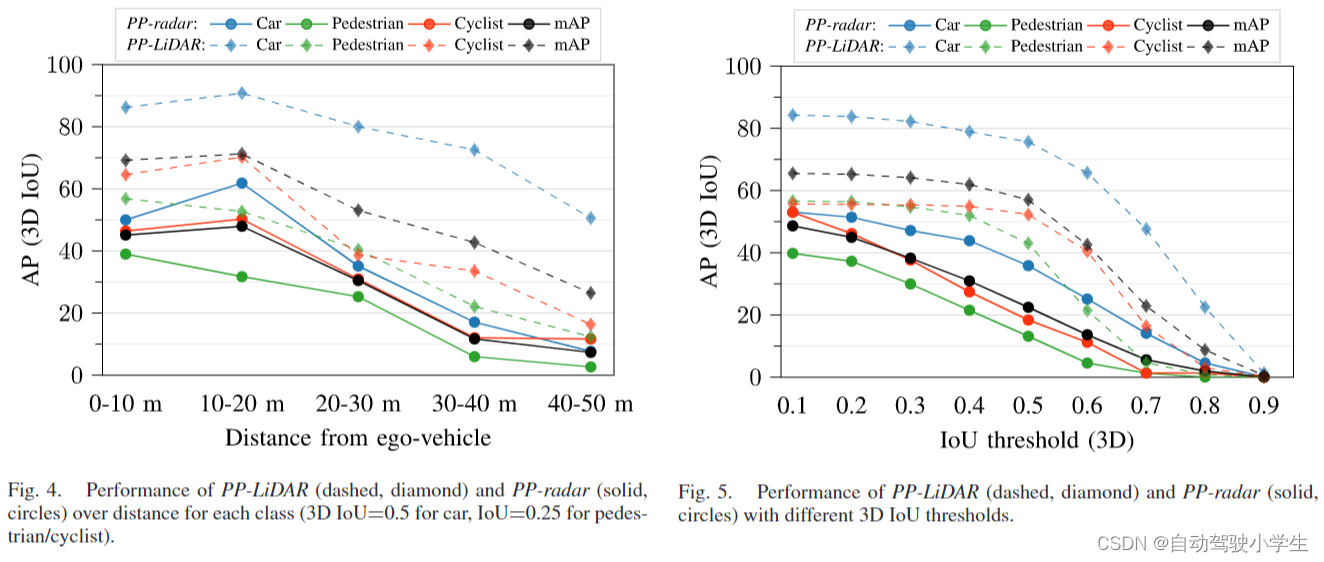

- 随后,作者比较了毫米波雷达和激光雷达在不同目标类别和距离上的检测性能。

- 本文提出的 VOD 数据集,包含 8693 帧时间同步和标定好的 64线激光雷达、双目相机和 3+1D 雷达,数据是在复杂的城市交通中采集的。包括 123106 个运动和静态对象的 3D 边界框,其中包括 26587 个行人、10800 个骑自行车的人和 26949 辆汽车。

- 实验表明,64线激光雷达的检测性能仍然优于 3+1D 雷达的检测性能,但添加高度信息和连续雷达扫描的融合有助于缩小二者之间的检测差距。

项目链接为:https://github.com/tudelft-iv/view-of-delft-dataset

1. Dataset

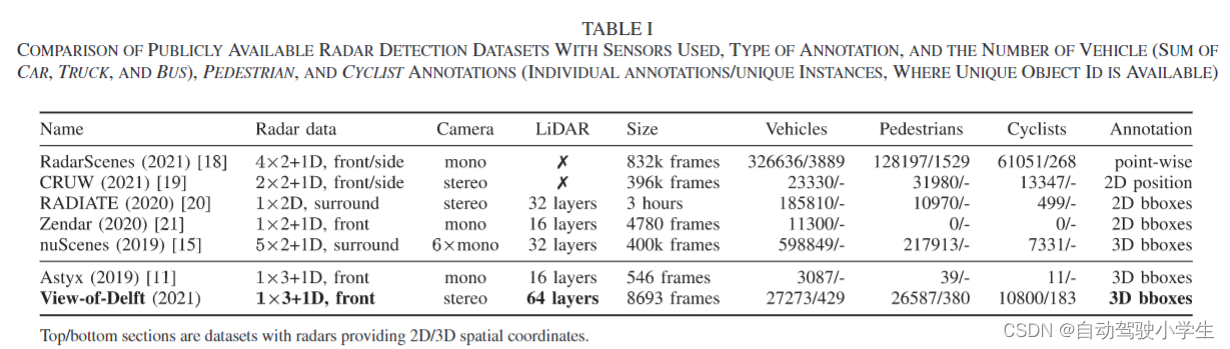

下表是开源的毫米波雷达数据集比较,目前学术界使用很广泛的有nuScenes,不过其使用的是2+1D毫米波雷达,3+1D毫米波雷达数据集还有Astyx,不过只有546frames,规模很小,不适合做研究。VOD除了使用3+1D毫米波雷达以外,还使用到了双目摄像头和64线激光雷达,共标注了8693frames,是目前最大的含有3+1D毫米波雷达的数据集。

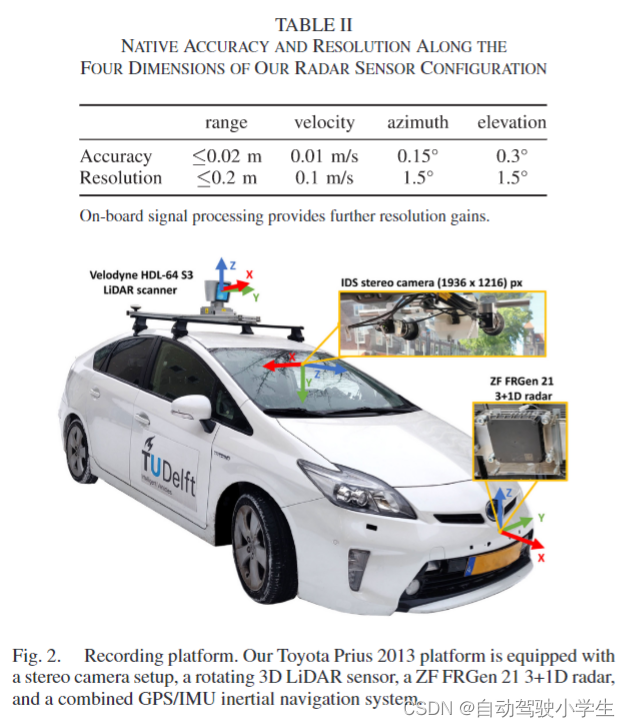

下表是4D毫米波雷达传感器的规范,可以看到其在测量距离,速度,升角和方位角的准确度和分辨率。传感器坐标方向以及最终的数据结构形式和KITTI数据集一模一样(只是编号稍有不同),详细内容可以看github中作者提供的jupyter notebook。

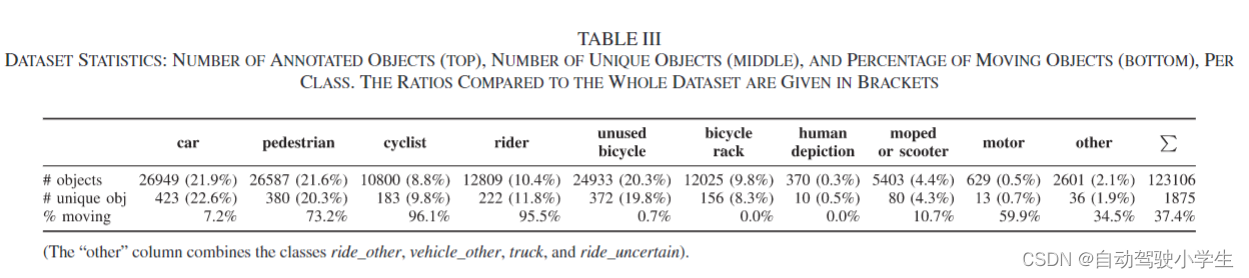

下表是数据统计情况:可以看到不同类别的标注数量及其在整个数据集的比例以及动态物体所占比例。

2. Methodology

本文中使用PointPillars作为多类别物体检测器。毫米波雷达返回点云共包含5个特征:距离 r r r、方位角 α \alpha α、升程角 θ \theta θ、相对速度 v r e l v_{rel} vrel 以及反射截面 R C S RCS RCS。转换为直角坐标系,则可以得到点云 p = [ x , y , z , v r e l , R C S ] p=[x,y,z,v_{rel},RCS] p=[x,y,z,vrel,RCS]。根据自车速度,可以得到补偿后的速度 v r v_r vr,可以看作是一个附加特征。

LiDAR领域中的数据增强技术不能直接用于毫米波雷达点云,这是因为雷达测量的相对速度与物体所处的角度相关。同样地,也不能旋转真值bounding box和其中的点云,这会导致物体的速度发生改变。

3. Experiments

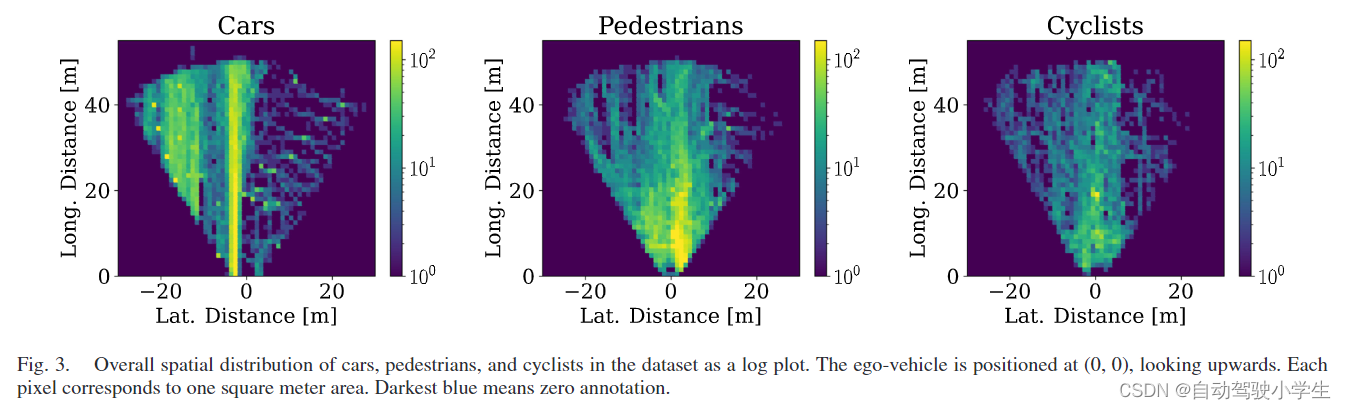

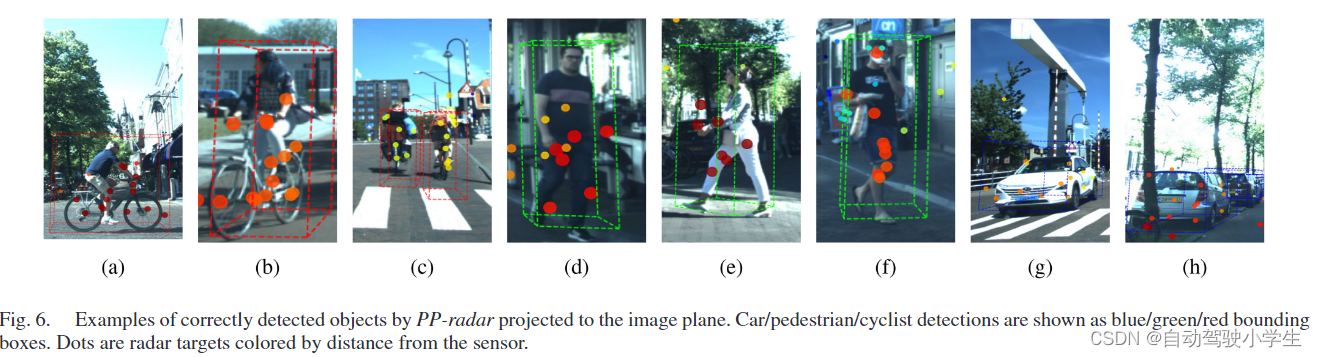

本文测试了三种类别的检测性能:汽车,行人,骑自行车人员。三种类别的空间分布如下图所示,训练集、验证集、测试集比例为59%/15%/26%。

本文给出了两个区域的评价指标,一是整个区域(相机FOV至50米),二是矩形区域(相机坐标:

−

4

m

<

x

<

4

m

,

z

<

25

m

-4m<x<4m,z<25m

−4m<x<4m,z<25m)。下表是不同区域、不同类别的检测结果(这是测试集结果)。可以看出:

- 速度特征对行人和骑自行车人员的检测影响很大,其次是高度信息,然后是RCS。

- 聚合多帧雷达扫描有助于提高检测结果,特别是在Cyclist提升最多。