一、摘要

联邦学习 在解决 数据孤岛 问题方面有着非常重要的作用,它支持 多方在不共享数据 的情况下进行协作。然而,现有的 联邦学习算法 存在三个缺点:

- 忽视了 multi-model data distribution (多模态数据分布) 带来的挑战。

multi-model data distribution 指的是在 不同的客户端 上使用 不同的模型 来处理各自的数据分布。每个客户端可能会根据其本地数据的特性和需求,训练一个特定的模型,而 不是 所有客户端都使用 相同的模型架构。 - 在对具有 多个自变量 的 目标函数 的 指数运算 和 对数运算 进行 加密 方面存在局限性,并且 依赖第三方合作者 进行加密。

为了解决这个问题,该论文提出了一种 通用的多模态垂直联邦学习框架。

3. 为了解决 数据分布问题,提出了一个 两步多模型转换器模型,该模型可以有效地 捕获跨域语义特征。

4. 在 加密 方面,为了解决 传统的加法同态加密算法仅支持加法和乘法 的不足,改论文采用 二元泰勒级数展开 对目标函数进行变换。

5. 整合这些组件,提出了一个 全面的训练和传输协议,在加密过程 中 消除了对第三方合作者的需要。

二、介绍

随着 物联网 (IoT) 和 机器学习 (ML) 的快速发展,人工智能大大增强了信息处理能力。传统上,ML 模型 是使用从多个提供商收集的大规模集中数据生成和训练的。然而,在很多地方,完全的数据交换是被禁止的。除此之外,还有很多其他的挑战,例如:有限的数据可用性、较差的数据质量、缺少标签 … … 这些都导致了 很难在公共领域聚合数据。

为了解决这些问题,Google 首先提出了 联邦学习框架,该框架允许 训练过程 能够在 分散的数据所有者的设备 上进行。通过对 本地模型参数 进行交互和更新,FL 可以在 不需要共享数据 的情况下进行分布式设备的 协同训练。

之后,针对在工业领域中,数据是 垂直分布 的这一特点,又提出了一种 垂直联邦学习 (VFL) 框架 来训练隐私保护逻辑回归模型。

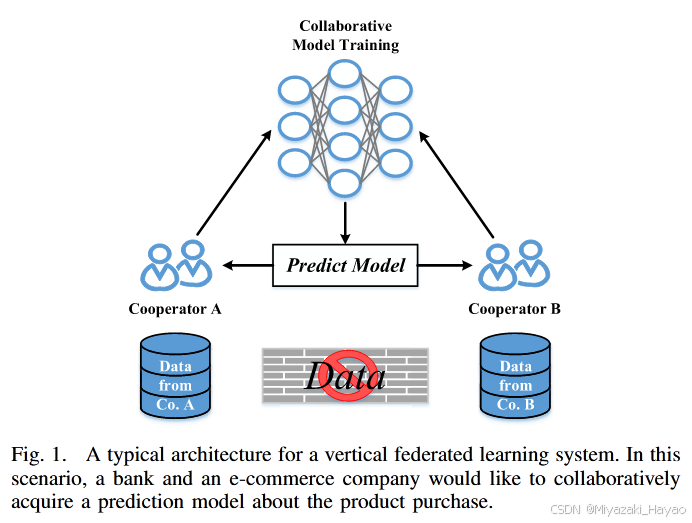

在 VFL 场景中,考虑这样一种情况:两家不同的公司,共同开发产品购买的预测模型。在这种情况下,用户数据 是从 相邻社区 收集的,这可能导致 样本 ID 的重叠,同时 特征空间 也可能不同。一个 典型的 VFL 框架 如下图所示。

大多数 VFL 方法 都采用相同的设置。然而,由于 更复杂的数据分布 和 更深的数据维度,不断发展的 IoT 带来了新的挑战。

1. 问题一

例如,在现实场景中,来自 不同组织 的敏感数据在 年龄和性别 等特征方面可能只有 有限的重叠,而 特征空间 的很大一部分可能 没有明显的关系。将这种 数据形式 成为 multi-modal data 多模态数据。

在这种情况下,现有的 VFL 方法不再适用,需要修改以解决这些现实的 多模态数场景。

2. 第一个贡献

文章的第一个贡献是,通过设计一个 多模态 VFL 框架 来解决 multi-modal data 挑战。为了克服现有方法的局限性,利用了强大的 转换框架 1。

在 VFL 的背景下,只有 模型和梯度 可以共享,改论文提出了一个 跨域模块 来利用固有的关系。

此外,作者随后使用 多模态模块 对 来自不同合作者的样本 进行 配对。

3. 问题二

VFL 中的传统协议 依赖于第三方协作者来 确保数据机密性 并 生成密钥 2。然而,第三方的加入,带来了数据泄露的风险。

确实也有一些 改进方案 采用新的 传输协议 来消除对第三方的依赖。但这些方法中,由于 加密后 计算损失 和 梯度 的复杂性,某些参数 仍然 没有加密。这暴露了原始数据,在其它组织访问和传输数据时带来了很多风险。

3. 问题三

另一个问题是,baseline VFL 采用 mean square error (MSE) 作为 目标函数3。该函数只涉及 加法 和 乘法 运算,但不包括常用的 交叉熵函数 包括 指数和对数 等运算,这对加密计算带来了较大的挑战。该问题在此之前是没有解决的。

4. 第二个贡献

文章第二个贡献用于解决上面的两个问题,提出了一种 新的传输协议。

首先,设计了一个 完全加密的传输过程,不依赖于第三方。这增强了整个联邦学习过程中数据的隐私性和安全性。

其次,使用了 二元泰勒级数展开 来解决 加密计算 的问题。这确保了所有操作的安全执行。

三、文章结构

- Inrtoduction

- Preliminaries

- Vertical Federated Learning

- Transformer & BERT Model

- Multi-Modal Machine Learning

- Homomorphic Encryption

- Methodology

- Problem Statement

- Overall of the Framework

- Cross-Domain Interaction Module

- Multi-Modal Encoder Interaction Module

- Protocol of Model Training and Parameter Transmission

- Experiments

- Comparison With the State-of-the-Art of Image-Text Task

- Comparison With the State-of-the-Art of Video-Text Task

- Ablation Study

- Conclusion

四、总结

改论文中,作者讨论了 垂直联邦学习 中的两个实际问题。

首先,通过提出一个能够处理 多模态 和 单模态 数据格式 的 通用 VFL 框架,来解决 不同合作者 之间的 数据类型不同 的问题。具体来说,引入了一个 两步多模态模型 来学习 跨域 和 多模态 特征。

其次,解决了 加密问题,该问题和广泛使用的 同态加密 相关,即支支持 加法 和 乘法 运算。改论文采用 二元泰勒级数展开 来变换 交叉熵函数。

A. Vaswani et al., “Attention is all you need,” in Proc. Adv. Neural Inf. Process. Syst., vol. 30, 2017, pp. 1–11. ↩︎

D. Romanini et al., “PyVertical: A vertical federated learning framework for multi-headed SplitNN,” 2021, arXiv:2104.00489. ↩︎

Q. Yang, Y. Liu, T. Chen, and Y. Tong, “Federated machine learning: Concept and applications,” ACM Trans. Intell. Syst. Technol. (TIST), vol. 10, no. 2, pp. 1–19, 2019. ↩︎