笼统的说,Hive中的Join可分为Common Join(Reduce阶段完成join)和Map Join(Map阶段完成join)。本文简单介绍一下两种join的原理和机制。

一 .Hive Common Join

如果不指定MapJoin或者不符合MapJoin的条件,那么Hive解析器会将Join操作转换成Common Join,即:在Reduce阶段完成join.

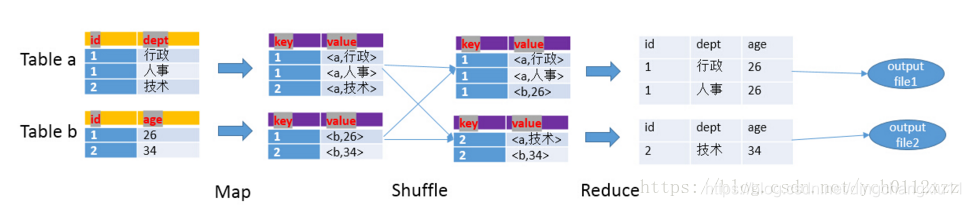

整个过程包含Map、Shuffle、Reduce阶段。

Map阶段

读取源表的数据,Map输出时候以Join on条件中的列为key,如果Join有多个关联键,则以这些关联键的组合作为key;

Map输出的value为join之后所关心的(select或者where中需要用到的)列;同时在value中还会包含表的Tag信息,用于标明此value对应哪个表;

按照key进行排序

Shuffle阶段

根据key的值进行hash,并将key/value按照hash值推送至不同的reduce中,这样确保两个表中相同的key位于同一个reduce中

Reduce阶段

根据key的值完成join操作,期间通过Tag来识别不同表中的数据。

以下面的HQL为例,图解其过程:

SELECT

a.id,a.dept,b.age

FROM a join b

ON (a.id = b.id);

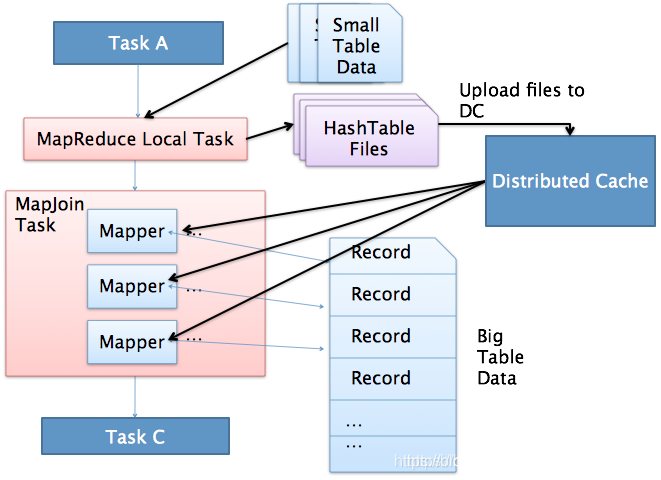

二. Hive Map Join

MapJoin通常用于一个很小的表和一个大表进行join的场景,具体小表有多小,由参数 hive.mapjoin.smalltable.filesize来决定,该参数表示小表的总大小,默认值为25000000字节,即25M.

Hive0.7之前,需要使用hint提示* /+ mapjoin(table) */才会执行MapJoin,否则执行Common Join,但在0.7版本之后,默认自动会转换Map Join,由数 hive.auto.convert.join来控制,默认为true.

假设a表为一张大表,b为小表,并且hive.auto.convert.join=true,那么Hive在执行时候会自动转化为MapJoin。

执行流程如下:

1.通过MapReduce Local Task,将小表读入内存,生成HashTableFiles上传至Distributed Cache中,这里会对HashTableFiles进行压缩。

2.MapReduce Job在Map阶段,每个Mapper从Distributed Cache读取HashTableFiles到内存中,顺序扫描大表,在Map阶段直接进行Join,将数据传递给下一个MapReduce任务。

三.测试

准备数据

hive (test)> select * from stu_190802;

stu_190802.id stu_190802.name stu_190802.sex stu_190802.department stu_190802.age

16 xm m 2 25

16 xm m 2 25

16 xm m 2 25

1 zs m 1 18

2 ls m 1 19

3 ww m 1 20

4 zq f 1 18

5 ll f 1 21

6 hl f 1 19

7 xh f 1 20

8 cl f 1 22

9 fj m 1 19

10 wb m 2 23

11 wf f 2 24

12 jj m 2 21

13 yy m 2 20

14 ld f 2 18

15 ch f 2 22

1 zs m 1 17

1 zs m 1 19

hive (test)> select * from department;

department.id department.leader

1 zs

2 wl

默认是ture 会开启小表mapjoin

hive (test)> set hive.auto.convert.join;

hive.auto.convert.join=true

hive (test)> set hive.mapjoin.smalltable.filesize;

hive.mapjoin.smalltable.filesize=25000000

两个表进行关联默认会执行mapjoin

select

t1.*

,t2.leader

from stu_190802 t1

left join department t2

on t1.department =t2.id;

Query ID = finup_20191225144340_00ff1ec6-8d8a-44ca-b92f-08e7b2a1074e

Total jobs = 1

SLF4J: Found binding in [jar:file:/Users/finup/opt/hive3.1.1/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

============将小表读入内存,生成HashTableFiles====================================

2019-