【大语言模型】ACL2024论文-18 MINPROMPT:基于图的最小提示数据增强用于少样本问答

MINPROMPT:基于图的最小提示数据增强用于少样本问答

摘要

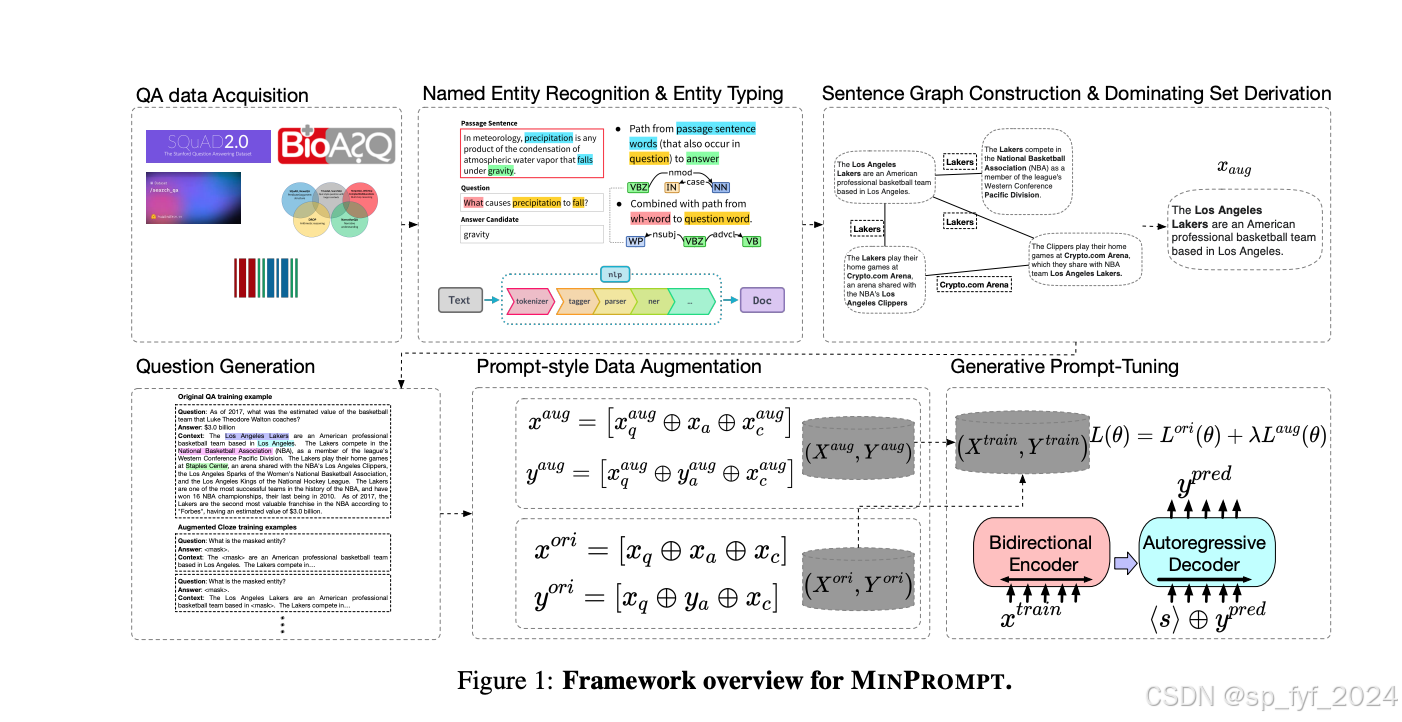

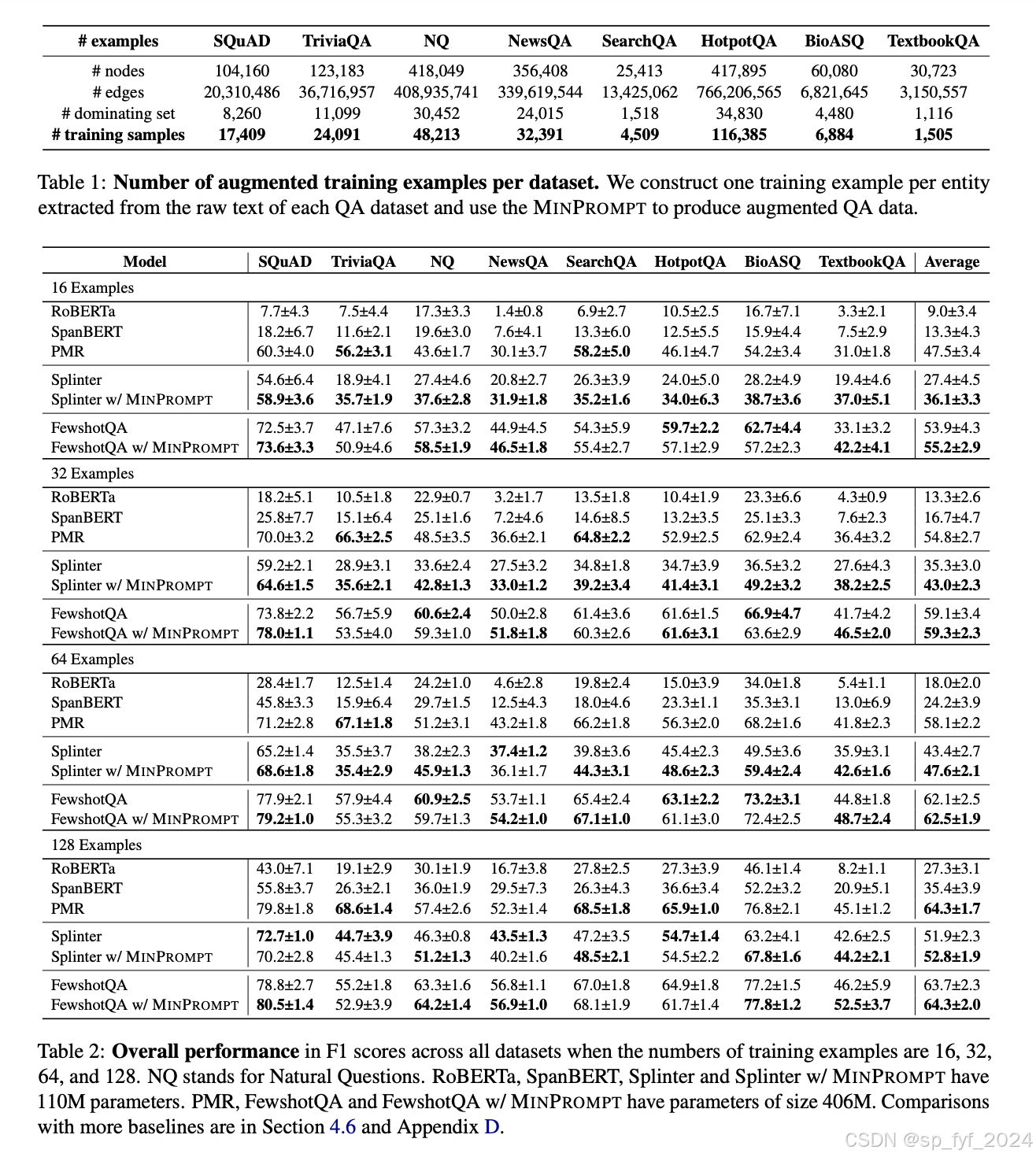

本文提出了MINPROMPT,一个用于开放域问答(QA)任务的最小数据增强框架,旨在通过近似图算法和无监督问题生成来提高少样本QA的效率和准确性。MINPROMPT通过将原始文本转换为图结构,建立不同事实句子之间的联系,然后应用图算法识别覆盖原始文本中最大部分信息的最小句子集合。基于这些句子生成问答对,并在选定的句子上训练模型以获得最终模型。实验结果表明,MINPROMPT在效率上与基线相比具有可比性或更好的结果,F1分数提高了最多27.5%。

研究背景

问答系统(QA)是自然语言处理(NLP)领域的关键追求之一,它能够基于给定的叙述背景提供准确响应。传统的监督学习方法依赖于大量的标注QA训练样本,但获取这些样本成本高昂。因此,研究者们开始关注少样本QA任务,即在只有有限数量训练样本的情况下实现QA挑战。

问题与挑战

少样本QA面临的主要挑战是如何有效地利用有限的训练样本来调整预训练的大型语言模型(LLMs),以适应特定领域并取得最佳结果。随着用于微调的数据量的增加,训练时长也会相应增加,这在模型规模较大时尤其不理想。因此,最小数据增强的重要性不言而喻。

如何解决

MINPROMPT通过选择最具信息量的数据进行微调来提高微调过程的效率。具体来说,MINPROMPT包括三个模块:句子图构建模块、数据选择模块和问题生成模块。首先,将原始文本转换为图结构,建立句子之间的联系;然后,应用图算法识别最小句子集合以覆盖所有共享实体;最后,基于选定的句子子集生成问答对,并在选定的句子上训练模型。

核心创新点

- 最小数据增强:MINPROMPT提出了一种新的数据增强方法,通过图算法和无监督问题生成来合成最信息丰富的QA训练样本。

- 图结构的应用:通过将文本转换为图结构,MINPROMPT能够捕捉文本元素之间的复杂联系,并识别出最信息丰富的句子。

- 无监督问题生成:MINPROMPT能够在不需要额外显式监督的情况下,从选定的句子中生成高质量的问答对。

算法模型

MINPROMPT的算法模型基于图算法和无监督问题生成。具体来说,它包括以下几个关键步骤:

- 命名实体识别与实体类型识别:使用NER技术提取实体及其类型,作为构建句子图的桥梁。

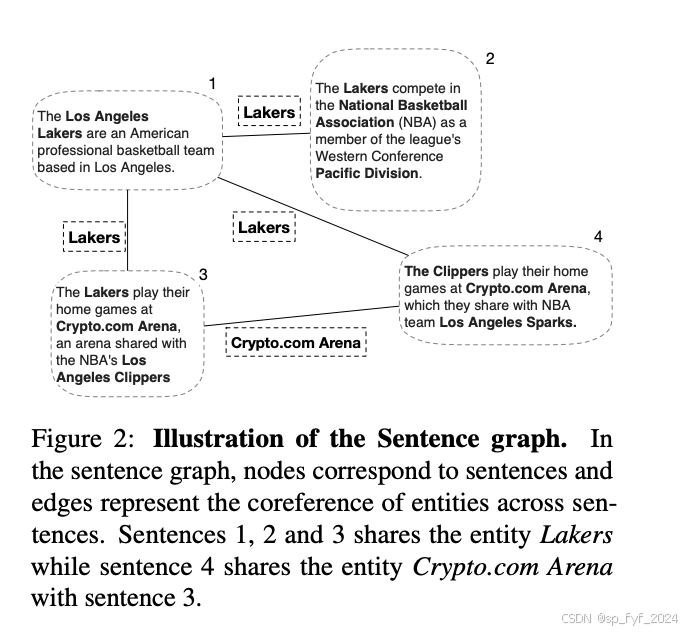

- 句子图构建:构建句子图以捕捉事实句子之间的语义重叠。

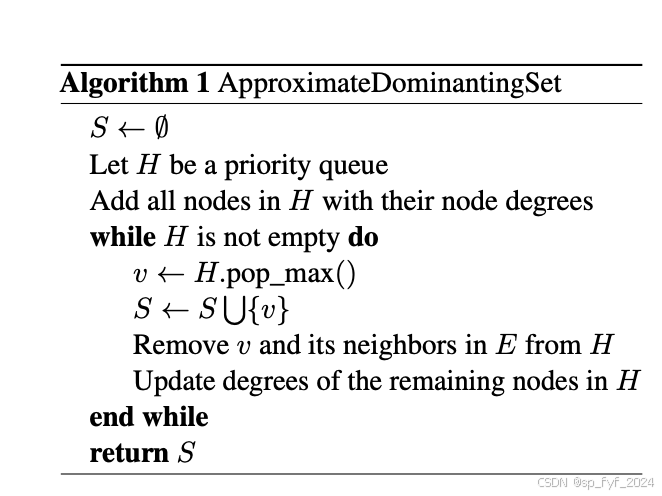

- 最小支配集近似:使用贪心算法找到覆盖整个句子图的最小句子集合。

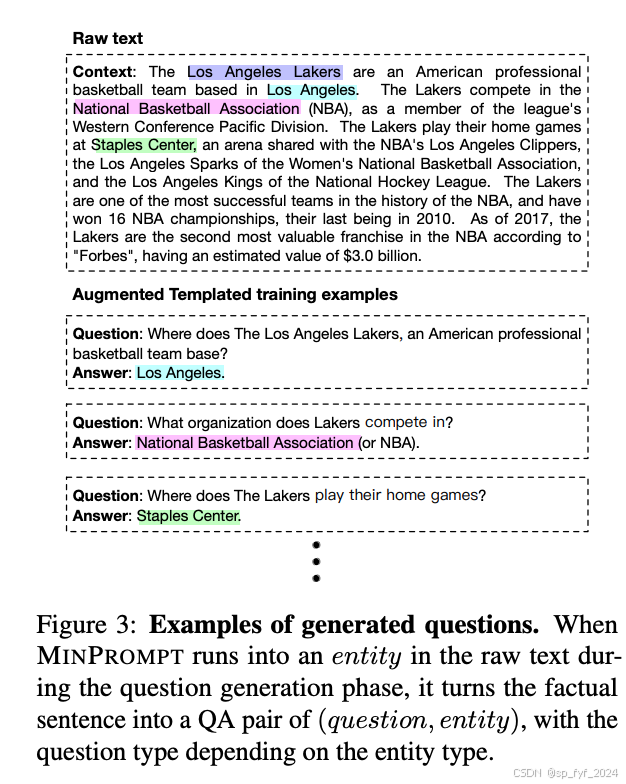

- 问题生成:将选定的事实句子转换为问答对。

- 提示式数据增强:通过提示调整扩展最近在提示调整中取得的进展,为MINPROMPT创建增强数据。

实验效果

实验在多个公共基准数据集上进行,包括SQuAD、NewsQA、TriviaQA等。结果表明,MINPROMPT在效率上与基线相比具有可比性或更好的结果,F1分数提高了最多27.5%。在16、32、64和128个训练样本的情况下,MINPROMPT在大多数情况下都优于或与基线方法相当。特别是在训练样本较少时,MINPROMPT的性能提升更为显著。

相关工作

相关工作主要集中在以下几个方面:

- 问题生成:先前的研究提出了多种问题生成模型,如基于强化学习的问答模型和基于语义匹配的问题生成模型。

- 少样本QA:以往的研究主要集中在重用预训练语言模型或使用合成QA数据从头开始训练模型。

- 预训练模型的应用:一些研究工作探索了如何利用预训练模型来提高QA任务的性能。

后续优化方向

尽管MINPROMPT在性能上取得了一定的成果,但仍存在一些局限性和未来的优化方向:

- NER模型性能的影响:MINPROMPT的性能受到所集成的NER模型的影响,因此提高NER模型的准确性是未来的一个研究方向。

- 实体的重要性:MINPROMPT使用所有共享实体来构建句子图,但不同实体对下游QA任务的重要性可能不同,因此区分对待实体可能会带来不同的结果。

- 提示调整模板的自动化:当前的提示调整模板依赖于手动设计,探索自动化构建更优提示调整模板的方法也是一个有趣的研究方向。

综上所述,MINPROMPT通过其创新的数据增强方法和图算法应用,在少样本QA任务中取得了显著的性能提升。未来的工作可以进一步探索如何提高NER模型的准确性、区分实体的重要性以及自动化构建提示调整模板,以进一步提升MINPROMPT的性能和适用性。