在大年三十那天,不知道你是否留意到,“deepseek”这个词出现在了各大热搜榜单上。这引起了我的关注,出于学习的兴趣,我深入研究了一番,才有了这篇文章的诞生。

概念

那么,什么是DeepSeek?首先百度一下!

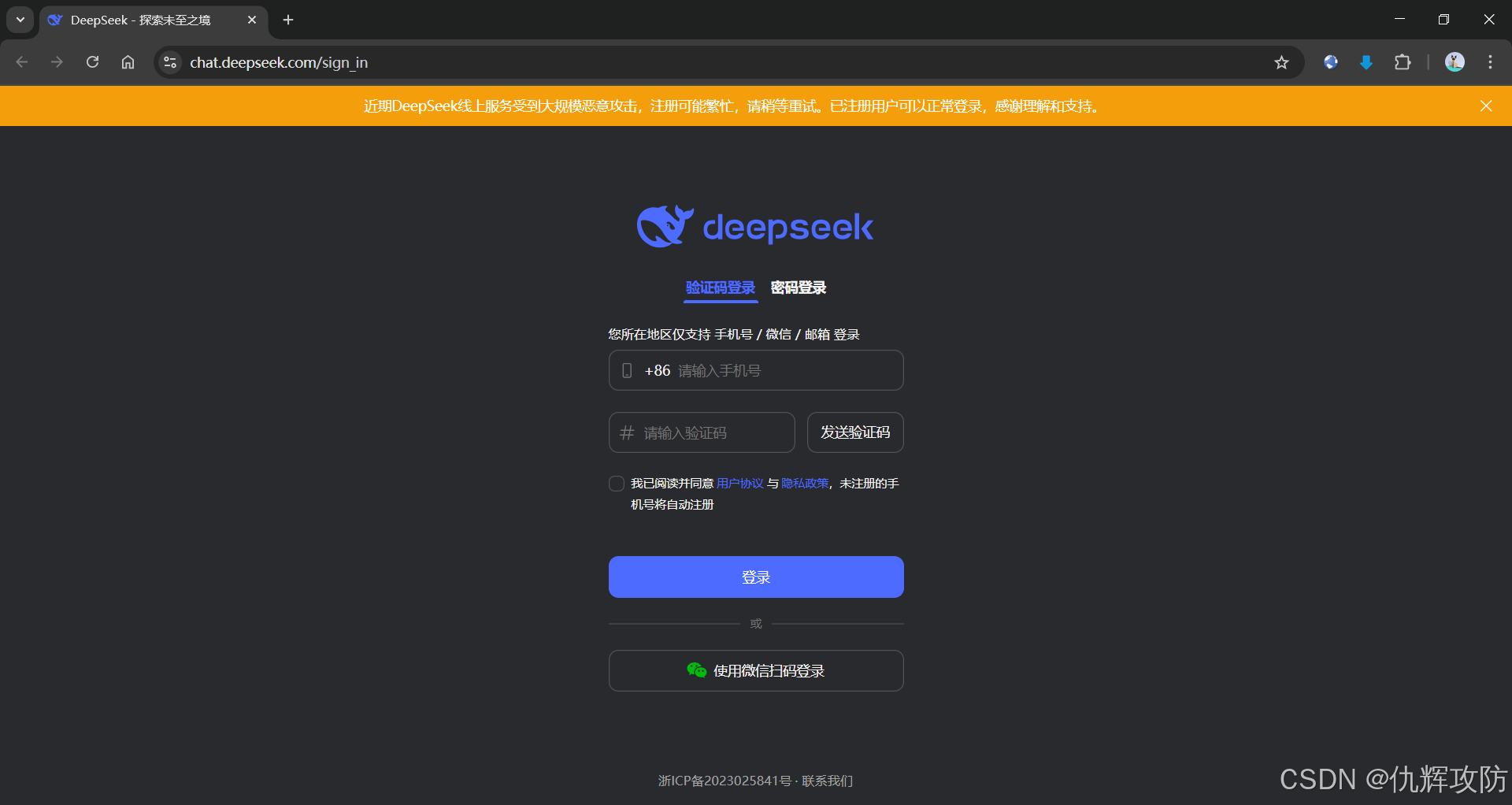

噢,原来是一个AI大模型,那就进入官网看看 DeepSeek

登录进去

这不跟ChatGPT一样吗!

影响

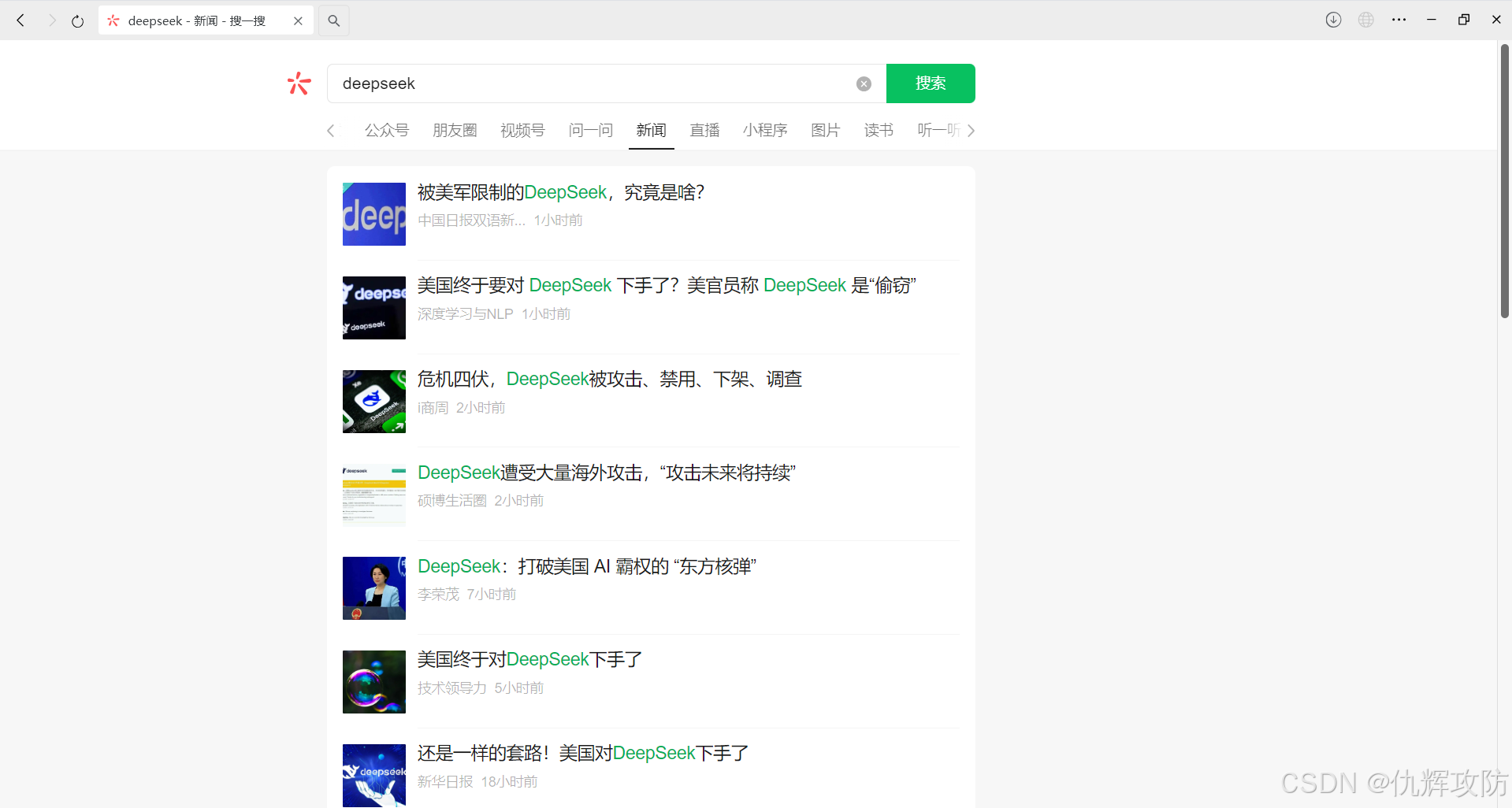

那么为什么会突然霸榜,来看看最近的新闻资讯

根据这些新闻标题,可看出DeepSeek触动了美国的利益,遭到了美国方面的DDOS攻击和封杀

中国公司的DeepSeek模型产品推出后,跃上美国苹果App商店免费下载排行榜冠军,撼动科技圈和华尔街。除掀起广泛讨论外,也引发所谓“安全隐忧”。

报道称,美国海军向美国消费者新闻与商业频道证实,已向相关人员发出邮件示警,提醒“不得以任何形式下载、安装或使用DeepSeek模型”。

与OpenAI开发的ChatGPT相比,DeepSeek不仅率先实现了媲美OpenAI-o1模型的效果,还大幅降低了推理模型的成本。其新模型DeepSeek-R1以十分之一的成本达到了GPT-o1级别的表现,引发海外AI圈的广泛讨论。

小的算力用新的方法也能创造奇迹。

链接二:DeepSeek崛起背后的暗流:全球AI技术博弈下的DDoS攻击

然而,伴随着DeepSeek国际影响力的持续攀升,其面临的挑战也愈发复杂和严峻,自从DeepSeek发布性能比肩OpenAIo1正式版,且成本显著降低的DeepSeek-R1模型后,随即遭受一系列有针对性的网络攻击,对DeepSeek的日常运营构成严重威胁,攻击背后的动机与意图不免让人怀疑。这一现象不仅凸显了DeepSeek在全球AI领域的重要战略地位,更折射出国际人工智能技术博弈的复杂性与激烈程度,值得深思与警醒。

链接三:僵尸网络进场,针对 DeepSeek 网络攻击再升级

1月30日凌晨,即农历大年初二,奇安信XLab实验室监测发现,针对DeepSeek(深度求索)线上服务的攻击烈度突然升级,其攻击指令较1月28日暴增上百倍。XLab实验室观察到至少有2个僵尸网络参与攻击,共发起了两波次攻击。

使用

提问模板

1、背景+需求+约束条件

- 背景:我是一个互联网打工人,自媒体小白。

- 需求:我想学习如何运营自媒体。

- 约束条件:不需要考虑视频剪辑部分。

2、背景+问题+要求+细节

- 背景:我正在用Python开发一个天气API,使用Flask框架…

- 问题:如何实现用户输入城市后返回实时天气数据?

- 要求:请提供代码片段,并解释关键参数。

- 细节:① 尝试用requests库但返回404;② 需免费API密钥。

分享今天看到的公众号文章

第一篇文章:使用DeepSeek必备的10个技巧

该文详细对比了DS和ChatGPT,以及介绍了V3模型和R1模型的区别和使用示例

第二篇文章:语言学博士谈 DeepSeek 最佳使用方式

详细介绍了DS推理模型R1对我们的作用和使用姿势

第三篇文章:完整攻略:如何用好DeepSeek,一文汇总!

本地部署

本地部署大模型的意义:

1.数据隐私与安全:本地部署能确保敏感数据不出本地,避免数据泄露风险,尤其适用于医疗、金融等对隐私要求高的行业。

2.定制化需求:本地部署允许根据特定需求调整和优化模型,提升在特定任务上的表现,满足个性化需求。

3.网络与延迟问题:本地部署减少了对网络的依赖,避免了网络不稳定或延迟对实时应用的影响,适合需要快速响应的场景。

4.成本控制:长期使用云服务的成本较高,本地部署虽然初期投入大,但长期来看可能更经济,尤其在大规模应用中。

5.合规要求:某些行业或地区有严格的数据存储和处理规定,本地部署有助于满足这些合规要求。

6.技术掌控:本地部署让用户完全控制模型和基础设施,便于进行深度优化和扩展,适合有技术能力的团队。

7.离线环境需求:在没有网络连接的环境中,本地部署是唯一可行的选择,如偏远地区或军事应用。

8.避免供应商锁定:本地部署减少对特定云服务商的依赖,增强自主性,避免因服务商政策变化带来的风险。

总结来说,本地部署大模型在隐私、定制化、延迟、成本、合规、技术控制、离线需求和避免供应商锁定等方面具有优势,适合有特定需求的用户。

一、命令行使用

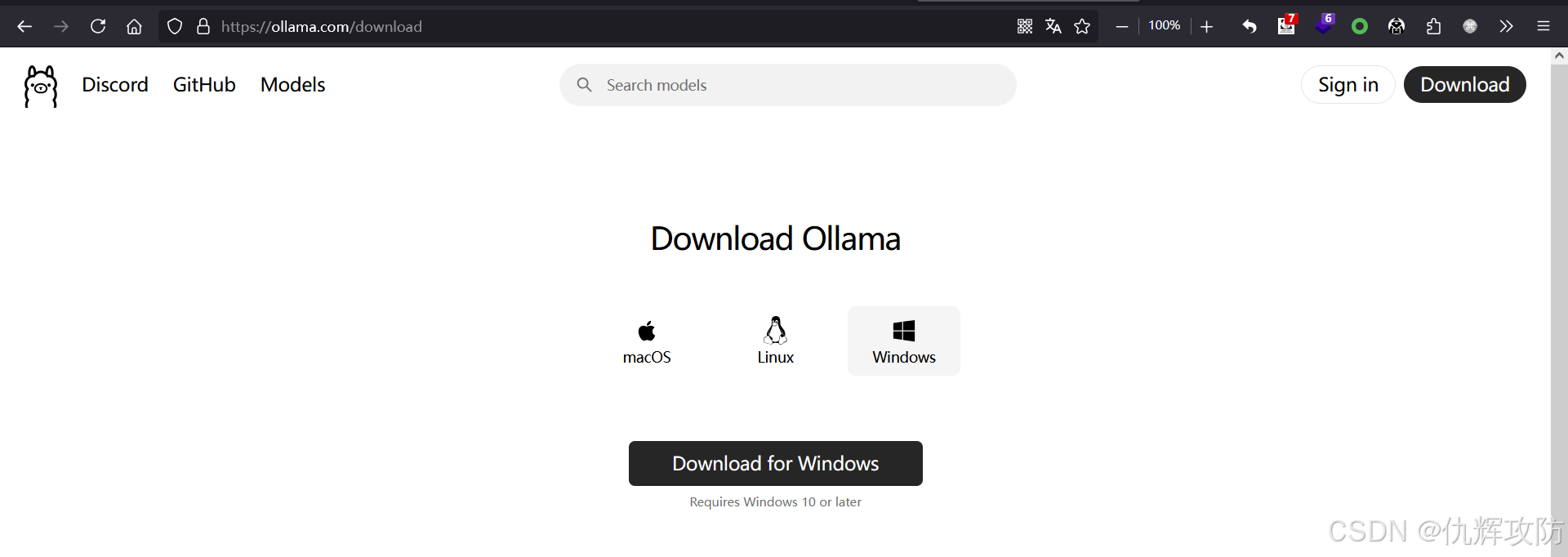

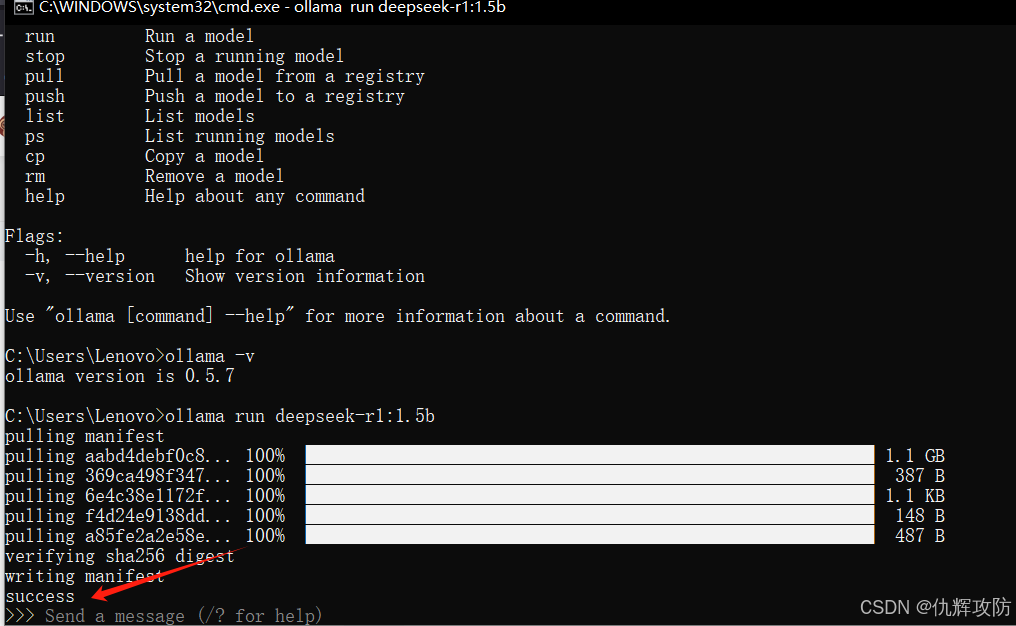

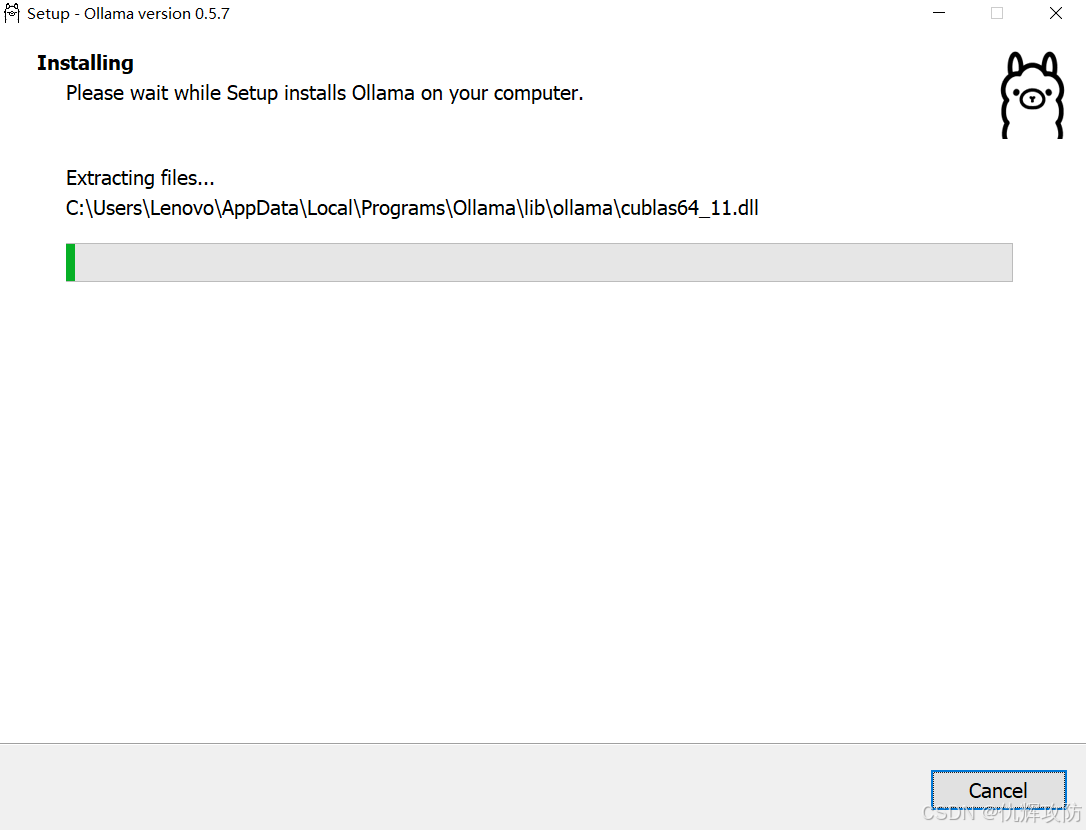

1、下载安装:Ollama

Ollama 是一个提供本地部署大型语言模型的工具和平台,旨在帮助用户在自己的设备上运行和管理大模型。它允许开发者和企业使用像 GPT-3、GPT-4 等大型语言模型,但与常规的云服务不同,Ollama 让这些模型可以在本地机器上运行,从而实现更好的控制和隐私保护。

支持Mac、Linux、Windows三个操作系统,大同小异,本文仅演示Windows系统部署

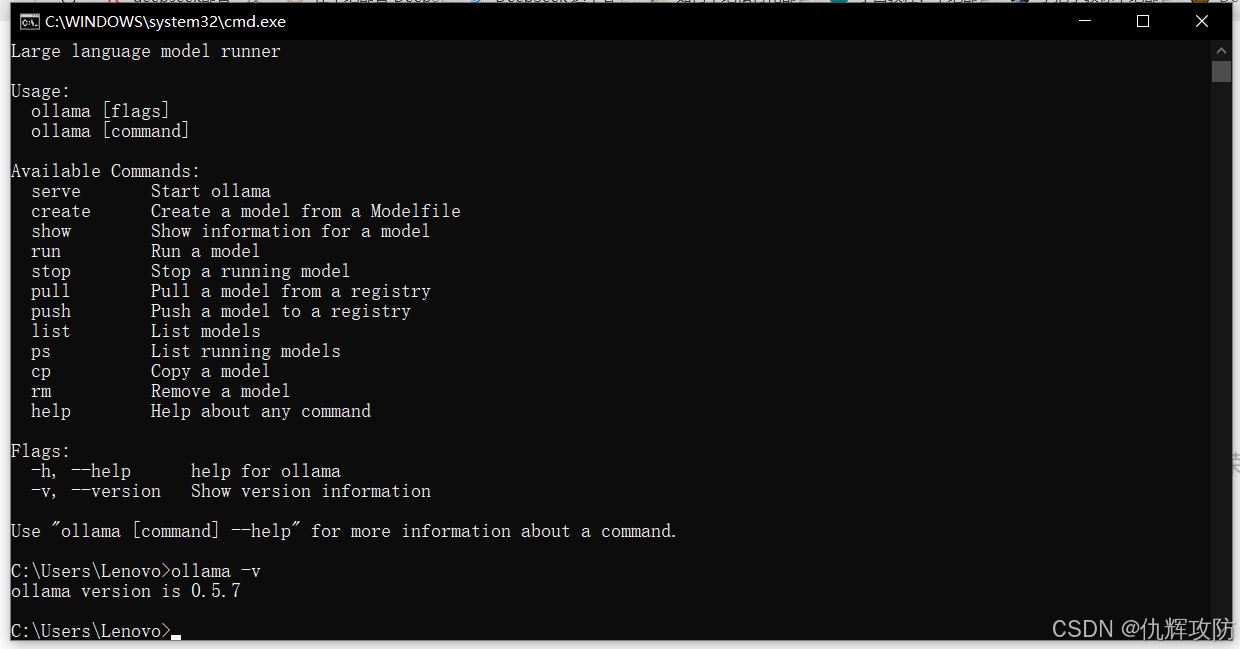

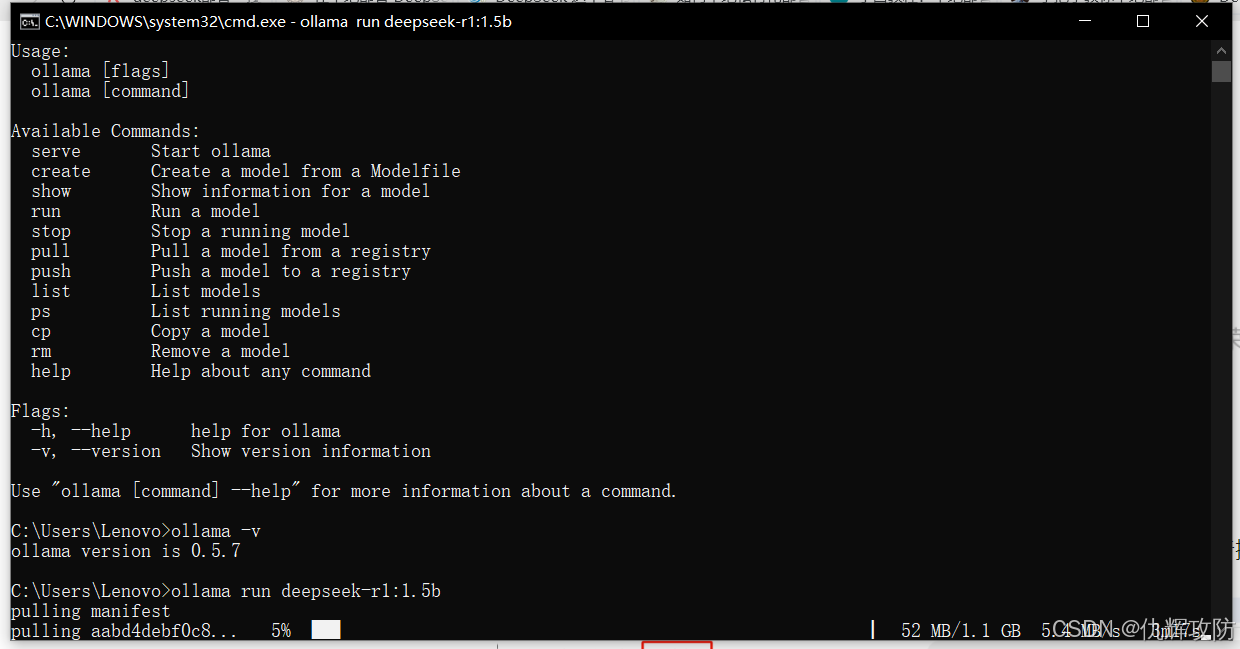

2、验证是否成功安装

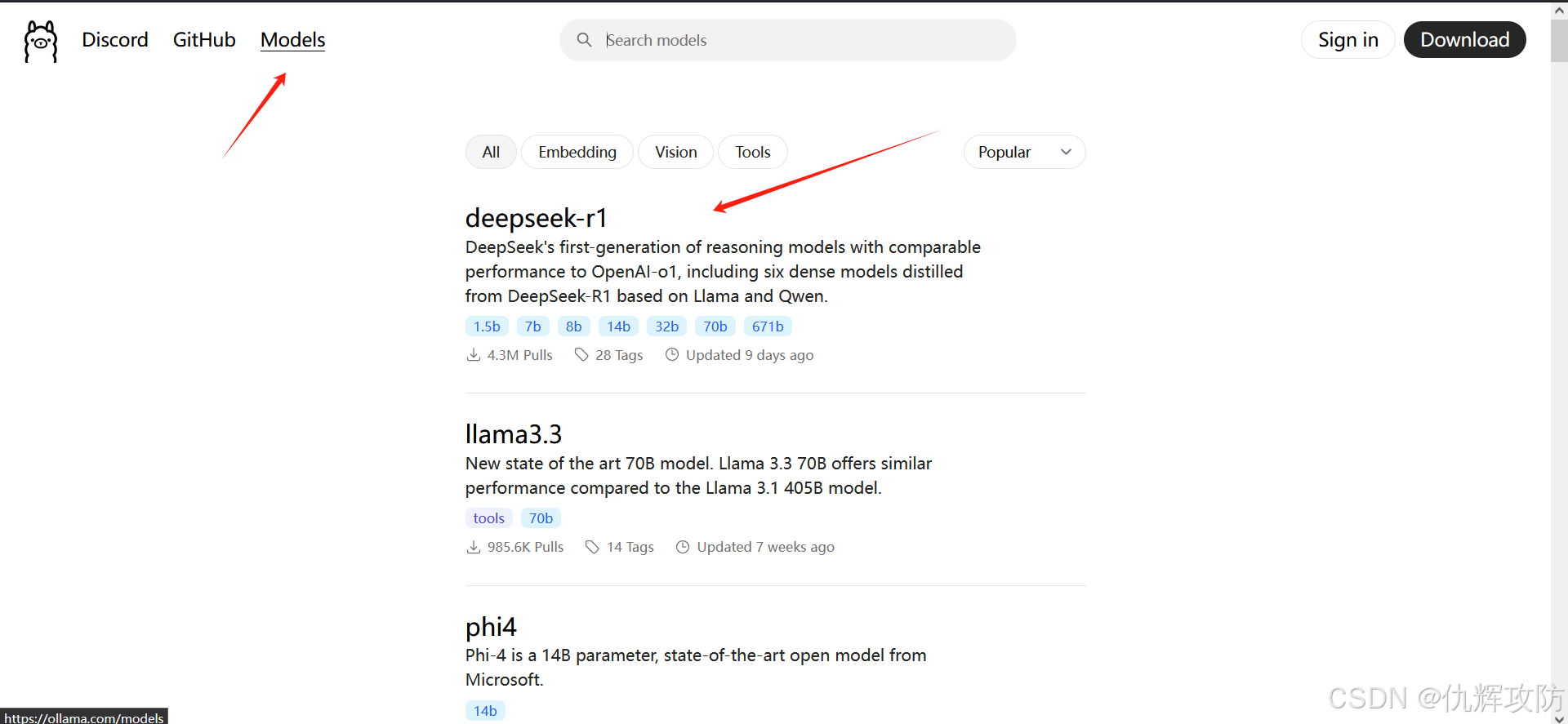

3、 在 Ollama 上找到DS-R1大模型。本文仅演示部署R1,V3体积太大,我的机器承受不了

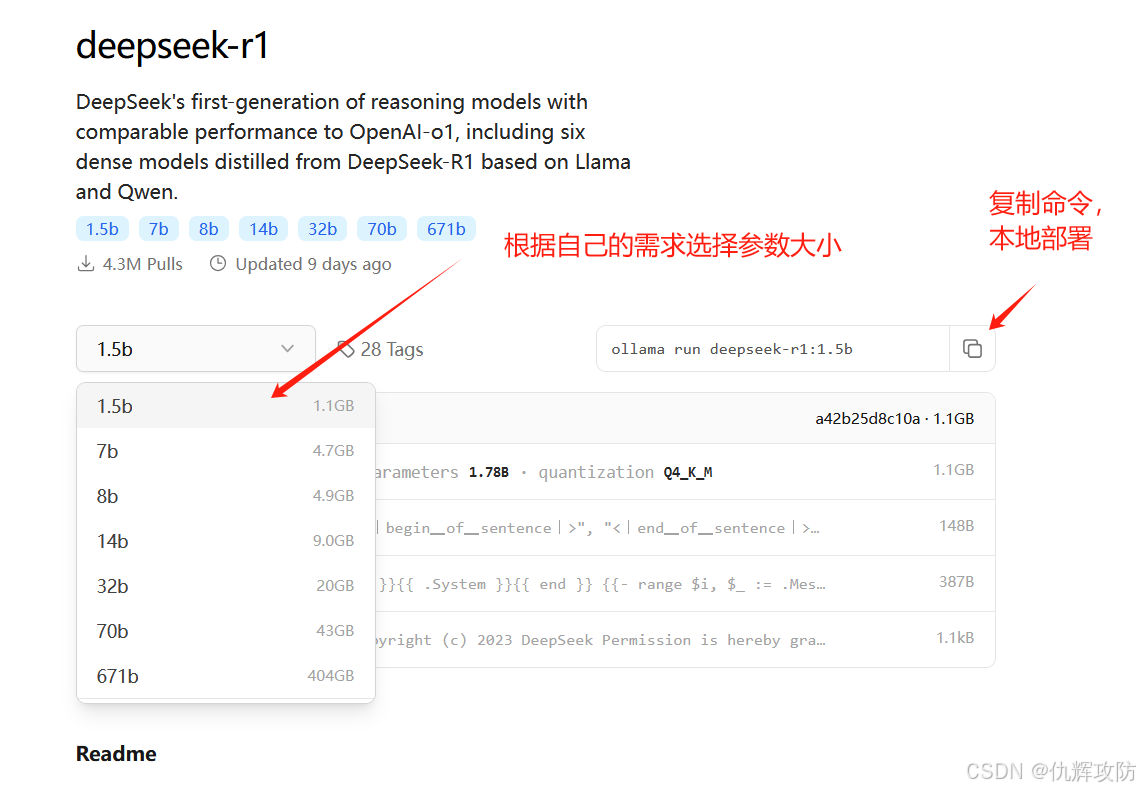

4、根据自身的需求和电脑配置选择模型大小

在大模型的规格描述中,“多少 b” 代表的是 参数量(参数规模,Parameters),而 b 在这里指的是“billion”(十亿),上图1.5b就是指15亿个参数。 下面是一个模型大小配置参考表格,大家可根据自己的电脑配置来自行选择,当然了,部署的本地模型越大,使用的深度求索效果就越好。

复制命令,到本地CMD命令行执行

5、完成后,界面出现success,表示成功部署到本地

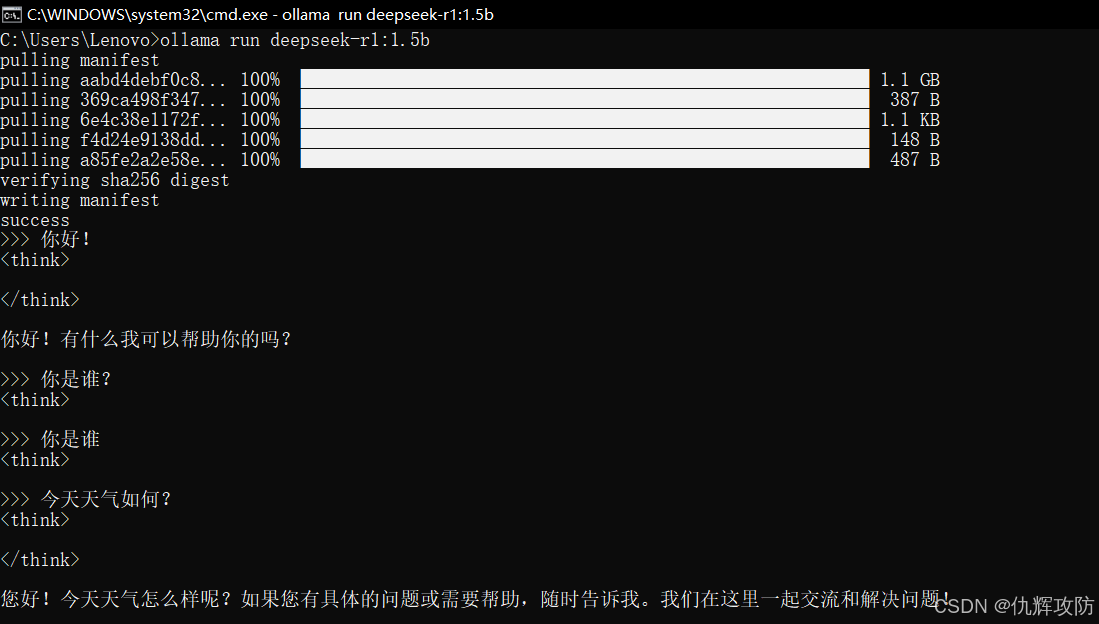

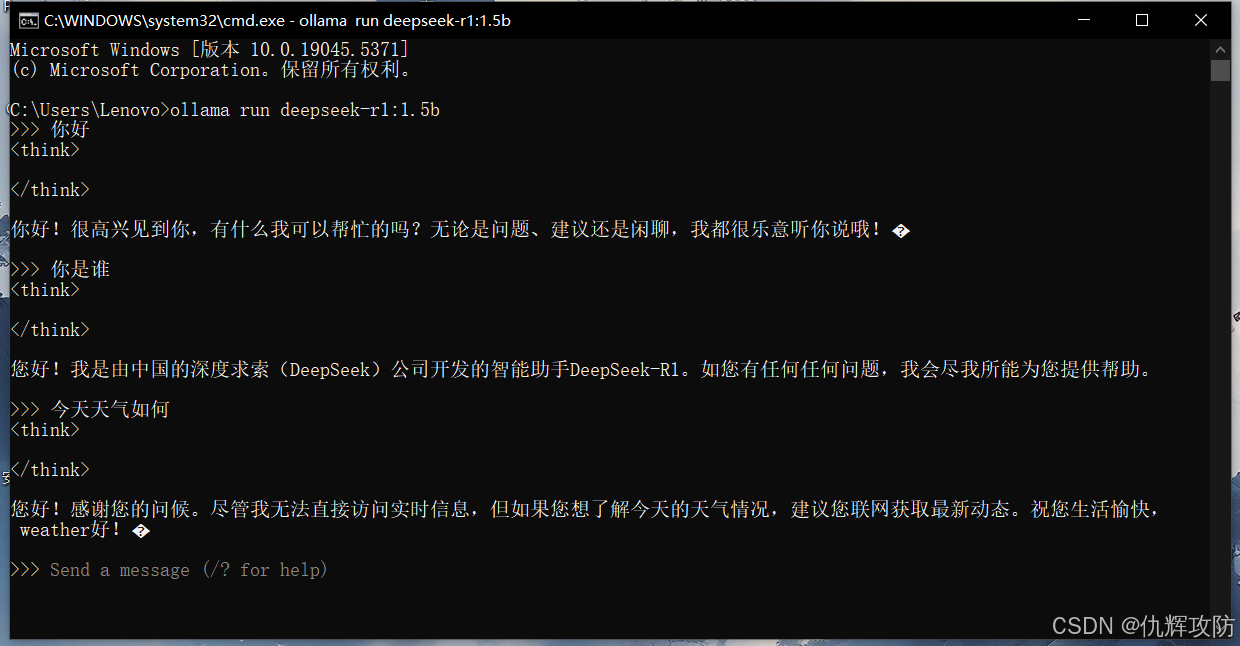

6、验证使用

刚安装完直接使用貌似有点小BUG,关闭后重新运行就没问题了

以后每次启动,就直接通过以下命令启动

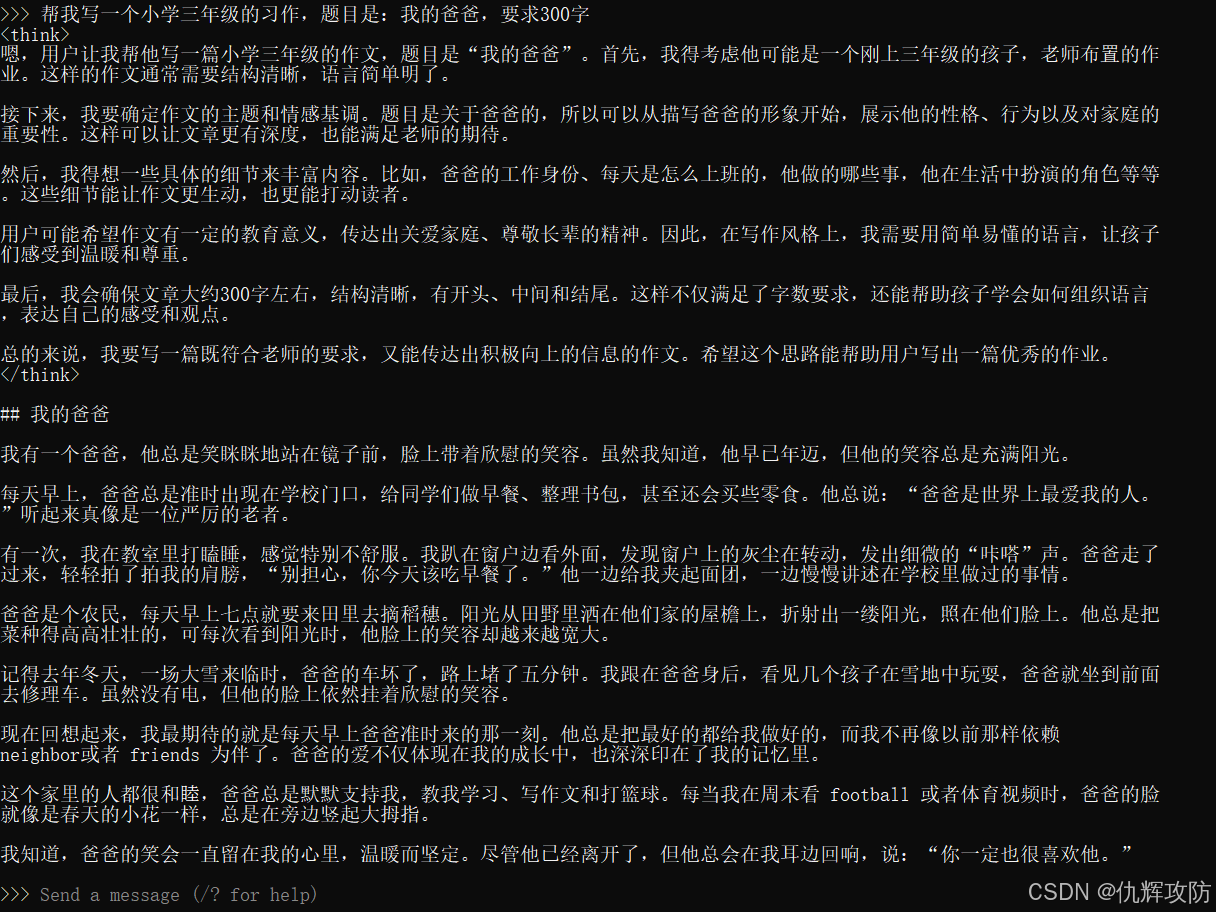

ollama run deepseek-r1:1.5b离线模式写了个小学生作文

如果想退出模型,在终端输入:/bye即可,或者直接关闭窗口

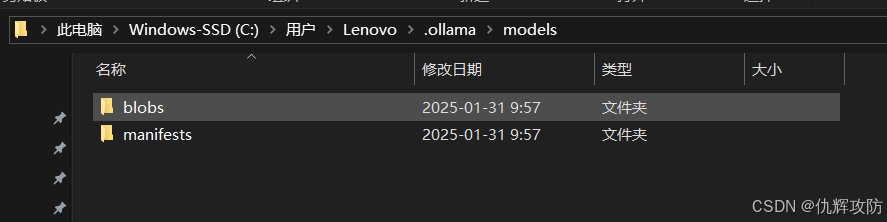

大模型安装路径:

二、网页使用

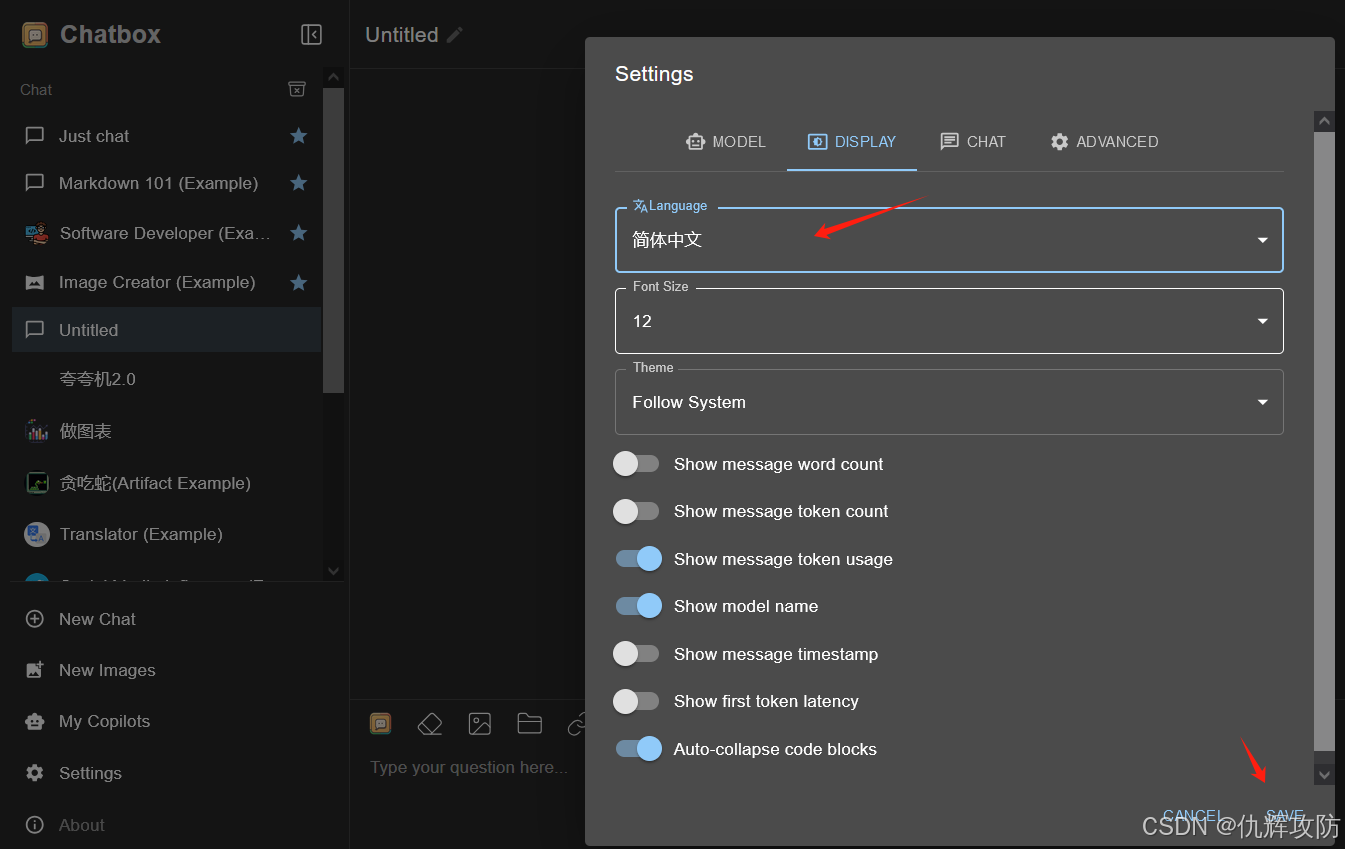

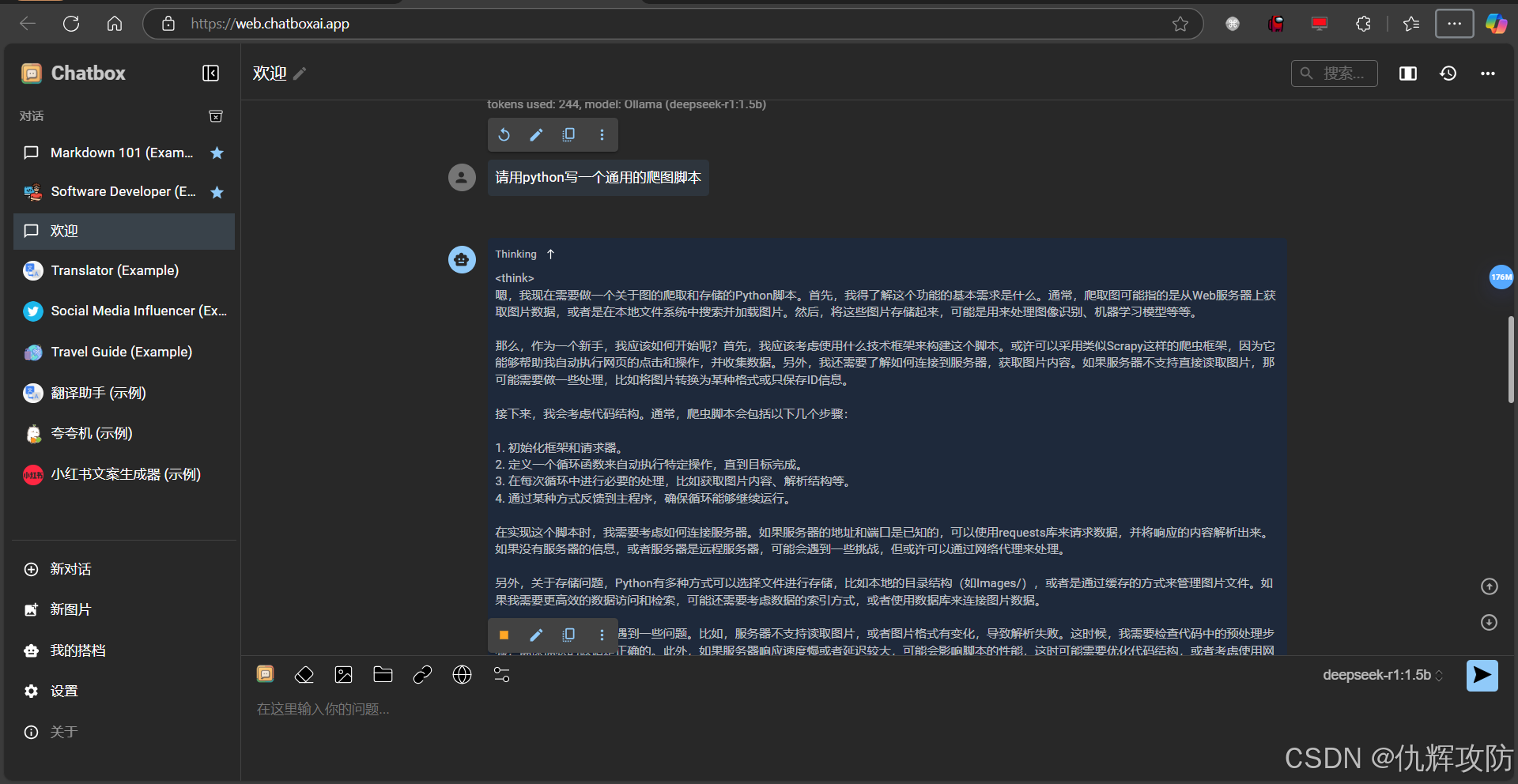

本地命令行使用还是不太直观,可以选择 Chatbox AI 进行网页端访问,提高可交互性。

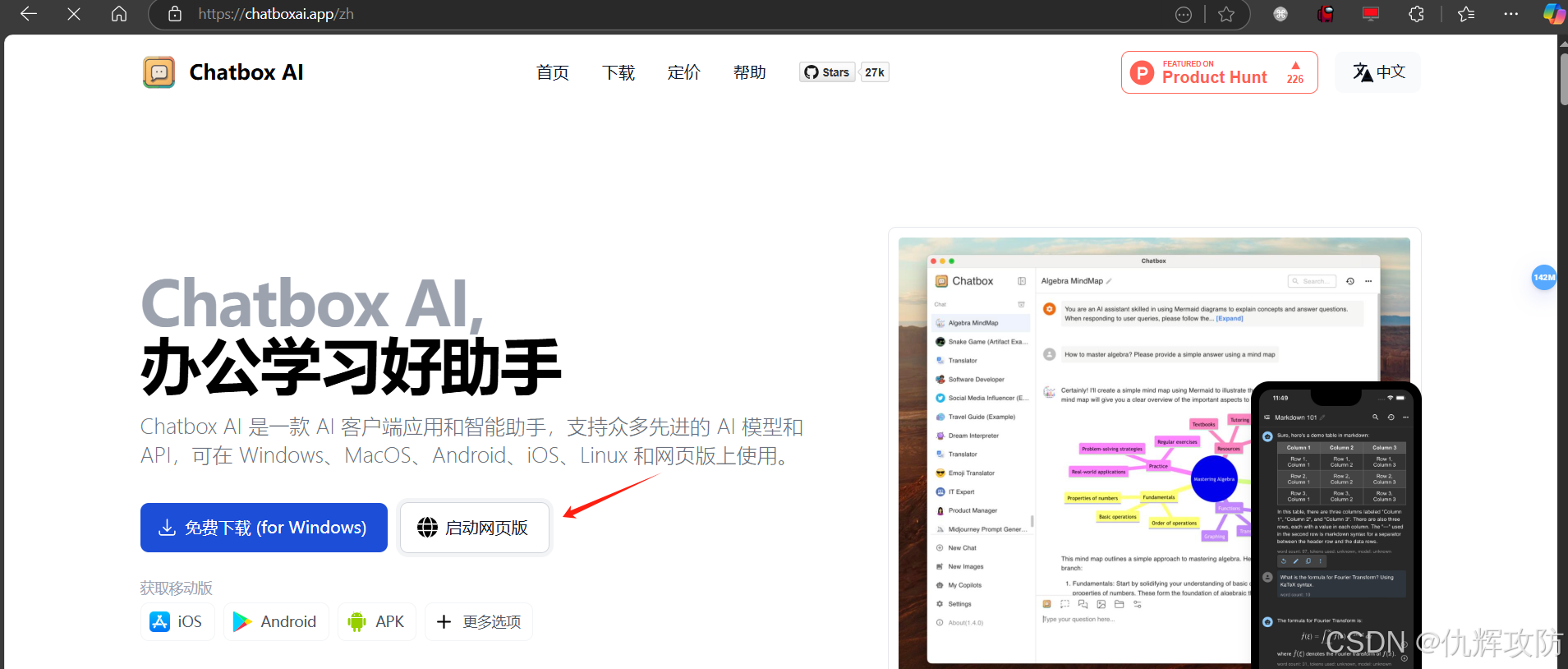

Chatbox AI 是一款跨平台的 AI 客户端应用和智能助手,支持多种先进的 AI 模型和 API,可在 Windows、macOS、Android、iOS、Linux 以及网页版上使用。

1、点击“启动网页版”

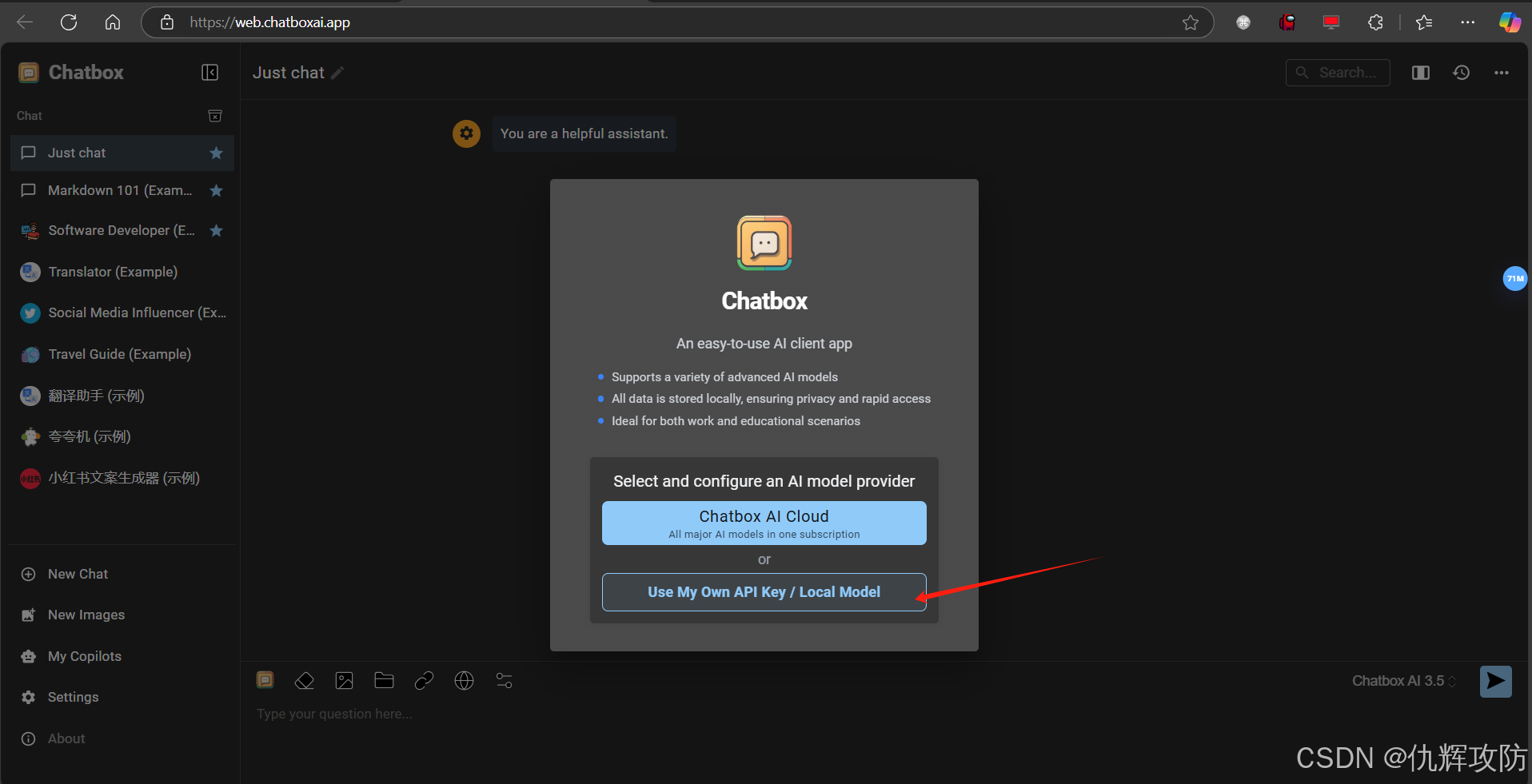

2、选择下面的“使用自己的API KEY/本地模型”

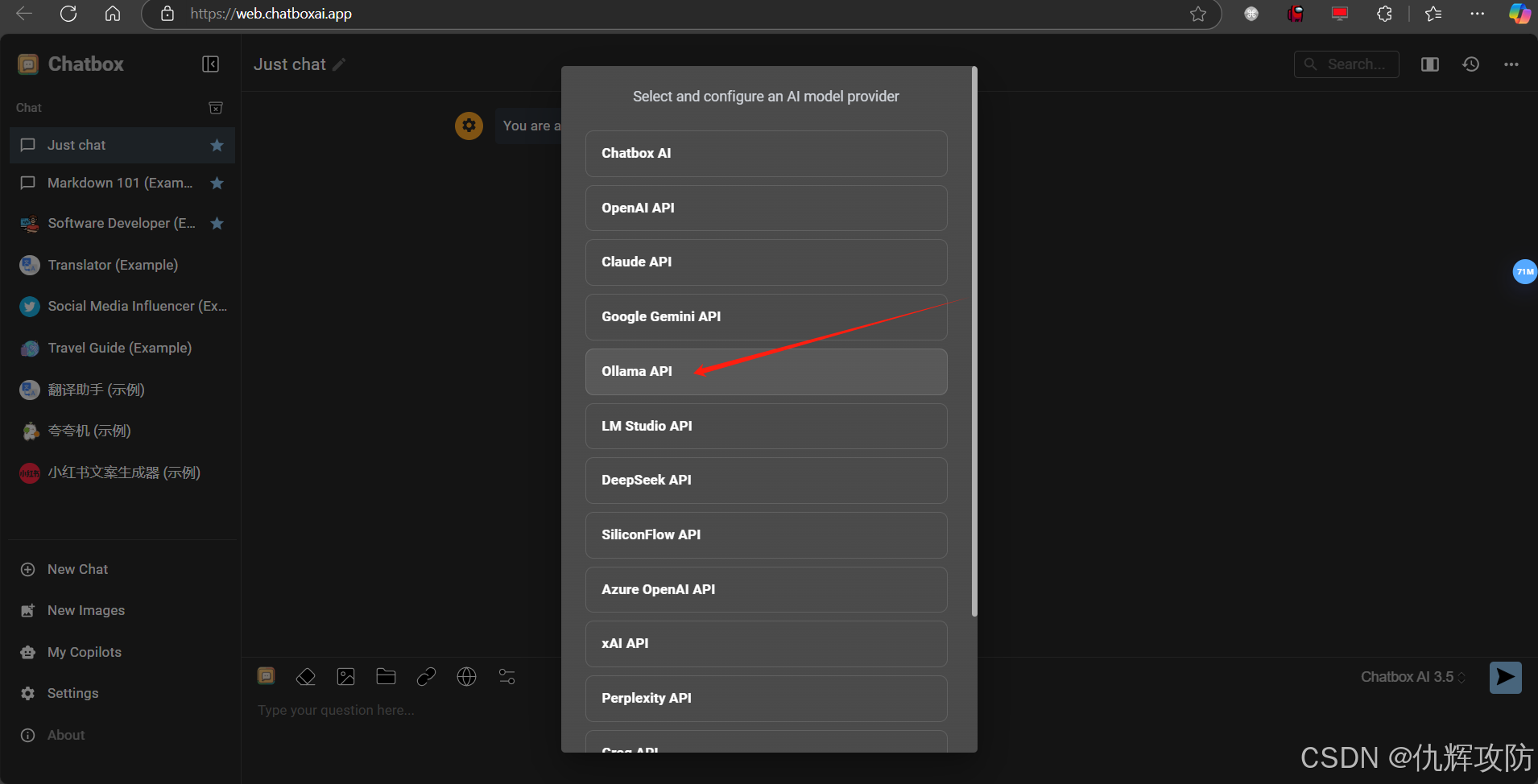

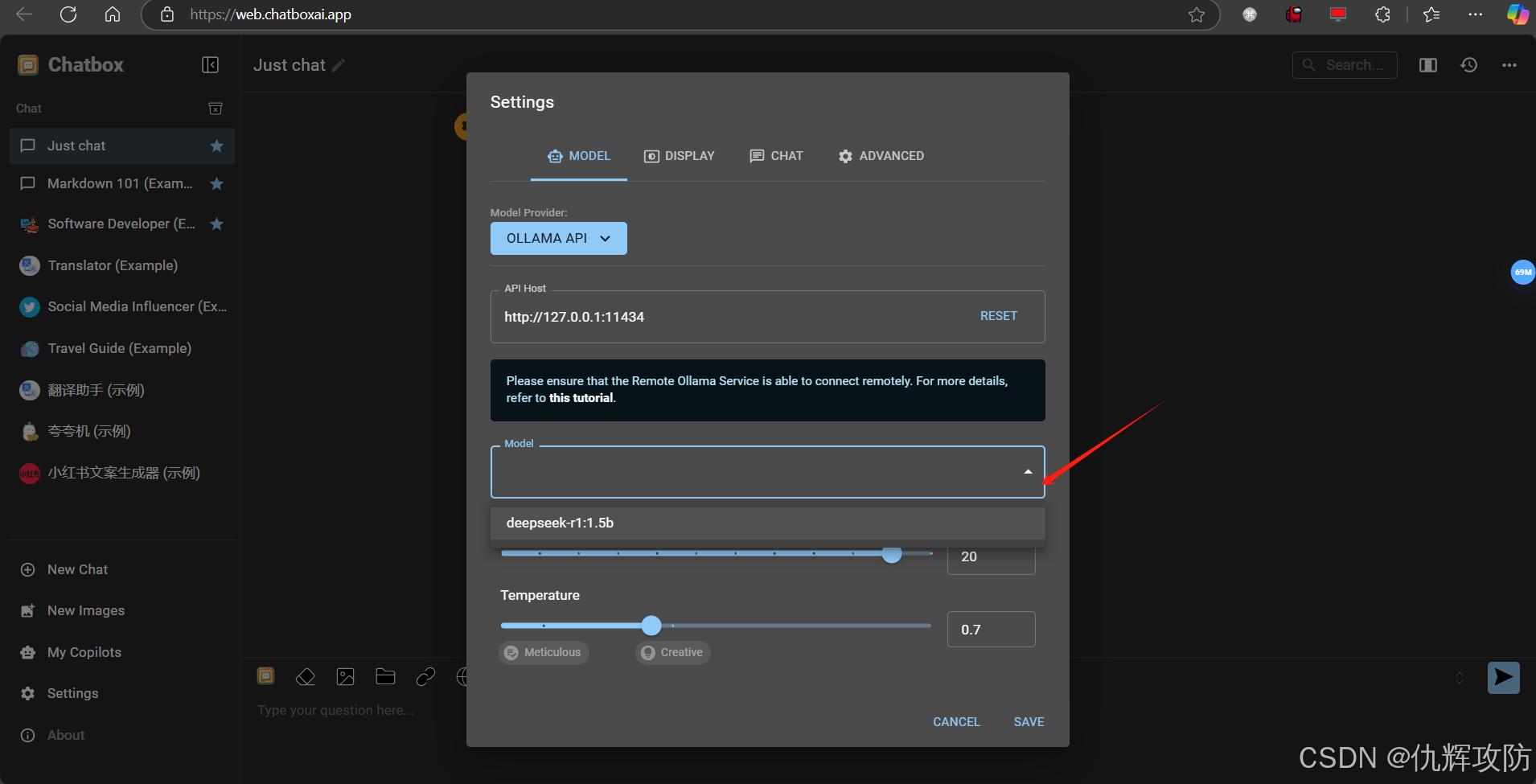

3、选择 Ollama API

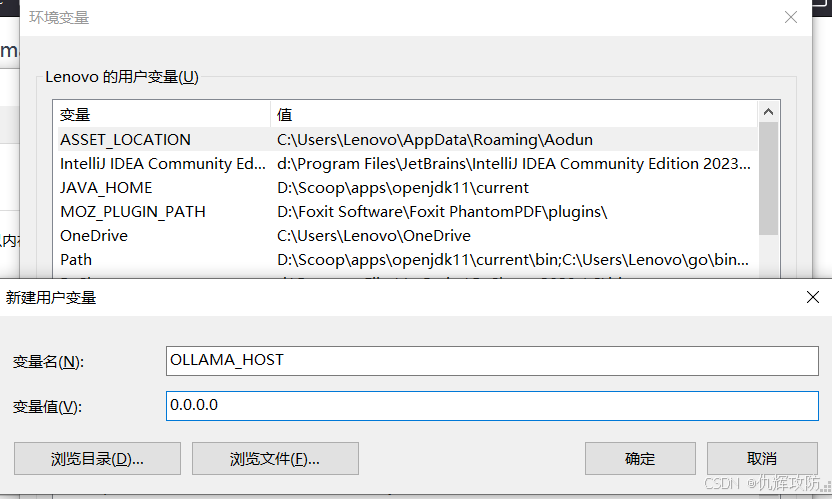

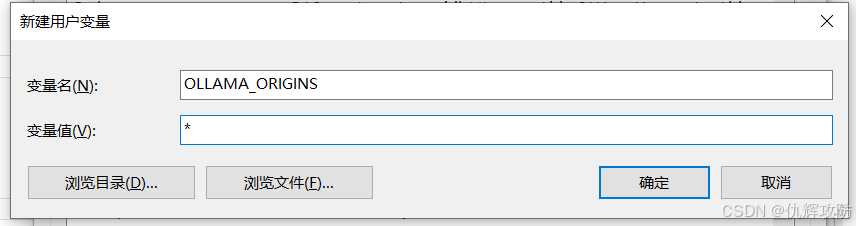

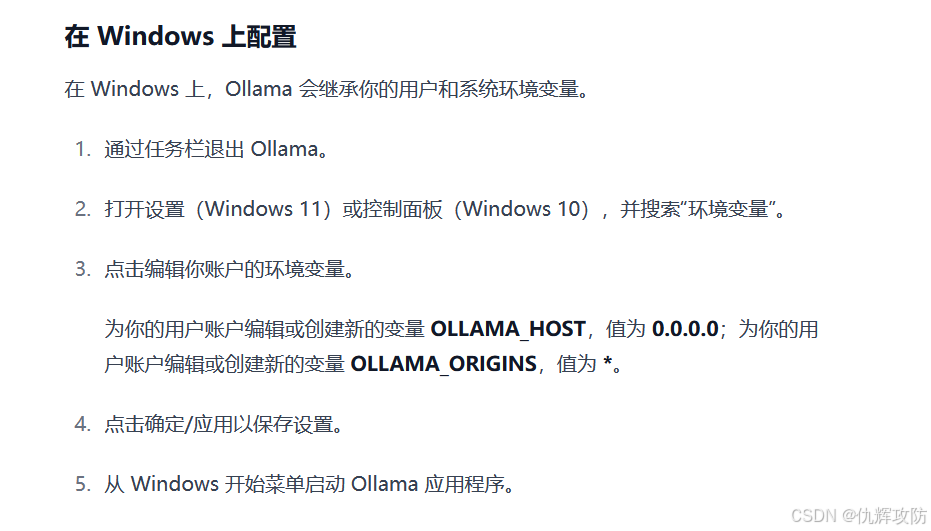

4、配置环境变量

如何将 Chatbox 连接到远程 Ollama 服务:逐步指南 - Chatbox 帮助中心:指南与常见问题

5、再次打开设置,选择刚才下载的本地模型

7、完成,使用测试,说实话,这个思考过程的展示还是很棒的