https://docs.python-requests.org/en/master/user/quickstart/

Requests库的七个主要方法

| 方法 | 说明 |

| requests.request() | 构造一个请求,支撑以下各方法的基础方法 |

| requests.get() | 获取HTML网页的主要方法,对应于HTTP的GET |

| requests.head() | 获取HTML网页的头信息的方法,对应于HTTP的HEAD |

| requests.post() | 向HTML网页提交POST请求的方法,对应于HTTP的POST |

| requests.put() | 向HTML网页提交PUT请求的方法,对应于HTTP的PUT |

| requests.patch() | 向HTML网页提交局部修改请求,对应于HTTP的PATCH |

| requests.delete() | 向HTML网页提交删除请求的方法,对应于HTTP的DELETE |

requests库的异常

| 属性 | 说明 |

| r.status_code | HTTP请求的返回状态,200表求连接成功,404表示失败 |

| r.text | HTTP响应内容的字符串形式,即,url对应的页面内容 |

| r.encoding | 从HTTP header中猜测的响应内容编码方式 |

| r.apparent_encoding | 从内容中分析出的响应内容编码方式(备选编码方式) |

| r.content | HTTP响应内容的二进制形式 |

| r.url | 返回URL实际参数 |

| r.json | |

| r.raw | 数据流方式下载 |

| r.iter_content | 边下载边存储 |

| r.headers | |

| r.cookies | |

| r.history | 重定向 |

r = requests.get(url, params = None, **kwargs)

构造一个向服务器请求资源的Request对象(Request),并且get方法返回一个包含服务器资源的Response对象;

requests.get函数的完整参数如下:

requests.get(url, params = None, **kwargs)

url: 拟获取页面的url链接

params: url中额外参数,字典或字节流格式,可选

**kwargs: 12个控 访问的参数

>>> payload = {'key1': 'value1', 'key2': 'value2'} >>> rl = requests.get('https://httpbin.org/get', params=payload)

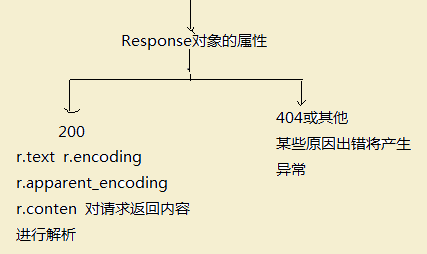

Requests库的2个重要的对象 Request 和 Response对象(Response对象包含爬虫返回的所有内容)

| 属性 | 说明 |

| r.status_code | HTTP请求的返回状态,200表求连接成功,404表示失败 |

| r.text | HTTP响应内容的字符串形式,即,url对应的页面内容 |

| r.encoding | 从HTTP header中猜测的响应内容编码方式 |

| r.apparent_encoding | 从内容中分析出的响应内容编码方式(备选编码方式) |

| r.content | HTTP响应内容的二进制形式 |

>>> import requests

>>> r = requests.get("http://www.baidu.com")

>>> r.status_code

200

>>> r.text #发现是乱码>>> r.encoding #查看它的编码

'ISO-8859-1'

>>> r.apparent_encoding #再查看它的apparent_encoding编码'utf-8'

>>> r.encoding ='utf-8' #用'utf-8'编码来替换'ISO-8859-1'这个编码。

>>> r.text #结果可以正常显示网页内容

r.url

>>> payload = {'key1': 'value1', 'key2': ['value2', 'value3']} >>> r = requests.get('https://httpbin.org/get', params=payload) >>> print(r.url) https://httpbin.org/get?key1=value1&key2=value2&key2=value3

Response Content

r.text

>>> import requests >>> r = requests.get('https://api.github.com/events') >>> r.text '[{"repository":{"open_issues":0,"url":"https://github.com/...

r.encoding

>>> r.encoding 'utf-8' >>> r.encoding = 'ISO-8859-1'r.encoding:如果header中不存在charset,则认为编码为'ISO-8859-1'

r.apparent_encoding: 根据网页内容分析出的编码方式

Binary Response Content

r.content

>>> r.content b'[{"repository":{"open_issues":0,"url":"https://github.com/...

gzipanddeflate自动解码>>> from PIL import Image >>> from io import BytesIO >>> i = Image.open(BytesIO(r.content))

JSON Response Content

r.json

>>> import requests >>> r = requests.get('https://api.github.com/events') >>> r.json() [{'repository': {'open_issues': 0, 'url': 'https://github.com/...异常

simplejson.JSONDecodeError /json.JSONDecodeError 内容包含无效json或者204 (No Content)

Raw Response Content

r.raw

>>> r = requests.get('https://api.github.com/events', stream=True) >>> r.raw <urllib3.response.HTTPResponse object at 0x101194810> >>> r.raw.read(10) '\x1f\x8b\x08\x00\x00\x00\x00\x00\x00\x03' with open(filename, 'wb') as fd: for chunk in r.iter_content(chunk_size=128): fd.write(chunk)stream=True 初始request中必须设置该参数可获得raw数据

r = requests.get('http://httpbin.org/stream/20', stream=True)

r.iter_content

r._iter_linesurl = "http://wx4.sinaimg.cn/large/d030806aly1fq1vn8j0ajj21ho28bduy.jpg" rsp = requests.get(url, stream=True) with open('1.jpg', 'wb') as f: for i in rsp.iter_content(chunk_size=1024): # 边下载边存硬盘, chunk_size 可以自由调整为可以更好地适合您的用例的数字 f.write(i)当流下载时,用

Response.iter_content更方便些。requests.get(url)默认是下载在内存中的,下载完成才存到硬盘上,可以用Response.iter_content来边下载边存硬盘

Response.iter_content将自动解码gzip和deflate传输编码。Response.raw是一个原始字节流——它不会转换响应内容。如果您确实需要访问返回的字节,请使用Response.raw.

响应状态码和异常

r.status_code

>>> r = requests.get('https://httpbin.org/get') >>> r.status_code 200 # Requests 还带有一个内置的状态代码查找对象,以便于参考: >>> r.status_code == requests.codes.ok Truer

.raise_for_status()>>> bad_r = requests.get('https://httpbin.org/status/404') >>> bad_r.status_code 404 >>> bad_r.raise_for_status() Traceback (most recent call last): File "requests/models.py", line 832, in raise_for_status raise http_error requests.exceptions.HTTPError: 404 Client Error如果我们发出了错误的请求(4XX 客户端错误或 5XX 服务器错误响应),我们可以使用以下命令引发它

Response.raise_for_status()但是,因为我们

status_code的r是200,当我们调用raise_for_status()我们得到:>>> r.raise_for_status() NoneConnectionError 网络问题(例如 DNS 故障、拒绝连接等)

HTTPError HTTP 请求返回不成功的状态代码

requests.exceptions.Timeout

TooManyRedirects 请求超过配置的最大重定向数

Requests 显式引发的所有异常都继承自

requests.exceptions.RequestException

响应头

r.headers

>>> r.headers { 'content-encoding': 'gzip', 'transfer-encoding': 'chunked', 'connection': 'close', 'server': 'nginx/1.0.4', 'x-runtime': '148ms', 'etag': '"e1ca502697e5c9317743dc078f67693f"', 'content-type': 'application/json' }字典很特别:它只是为 HTTP 标头而制作的。根据 RFC 7230

>>> r.headers['Content-Type'] 'application/json' >>> r.headers.get('content-type') 'application/json'

cookies

快速访问cookies

>>> url = 'http://example.com/some/cookie/setting/url' >>> r = requests.get(url) >>> r.cookies['example_cookie_name'] 'example_cookie_value'发送cookies

>>> url = 'https://httpbin.org/cookies' >>> cookies = dict(cookies_are='working') >>> r = requests.get(url, cookies=cookies) >>> r.text '{"cookies": {"cookies_are": "working"}}'Cookies 在 a 中返回

RequestsCookieJar,它的作用类似于 adict但也提供了更完整的接口,适合在多个域或路径上使用。Cookie jar 也可以传递给请求>>> jar = requests.cookies.RequestsCookieJar() >>> jar.set('tasty_cookie', 'yum', domain='httpbin.org', path='/cookies') >>> jar.set('gross_cookie', 'blech', domain='httpbin.org', path='/elsewhere') >>> url = 'https://httpbin.org/cookies' >>> r = requests.get(url, cookies=jar) >>> r.text '{"cookies": {"tasty_cookie": "yum"}}'

重定向和历史记录

r.history

例如,GitHub 将所有 HTTP 请求重定向到 HTTPS:

>>> r = requests.get('http://github.com/') >>> r.url 'https://github.com/' >>> r.status_code 200 >>> r.history [<Response [301]>]

allow_redirects参数禁用重定向处理:>>> r = requests.get('http://github.com/', allow_redirects=False) >>> r.status_code 301 >>> r.history []

超时 timeout

告诉请求在给定的秒数后停止等待响应

timeout>>> requests.get('https://github.com/', timeout=0.001) Traceback (most recent call last): File "<stdin>", line 1, in <module> requests.exceptions.Timeout: HTTPConnectionPool(host='github.com', port=80): Request timed out. (timeout=0.001)

timeout对整个响应下载没有时间限制;相反,如果服务器在timeout几秒钟内没有发出响应(更准确地说,如果在几秒钟内没有在底层套接字上接收到字节),则会引发异常timeout。如果未明确指定超时,则请求不会超时。