点击蓝字关注我们

扫码关注我们

公众号 : 计算机视觉战队

扫码回复:YoloV4,获取下载链接

期待已久的检测经典又来来了一波强袭——yolov4。

背景&简述

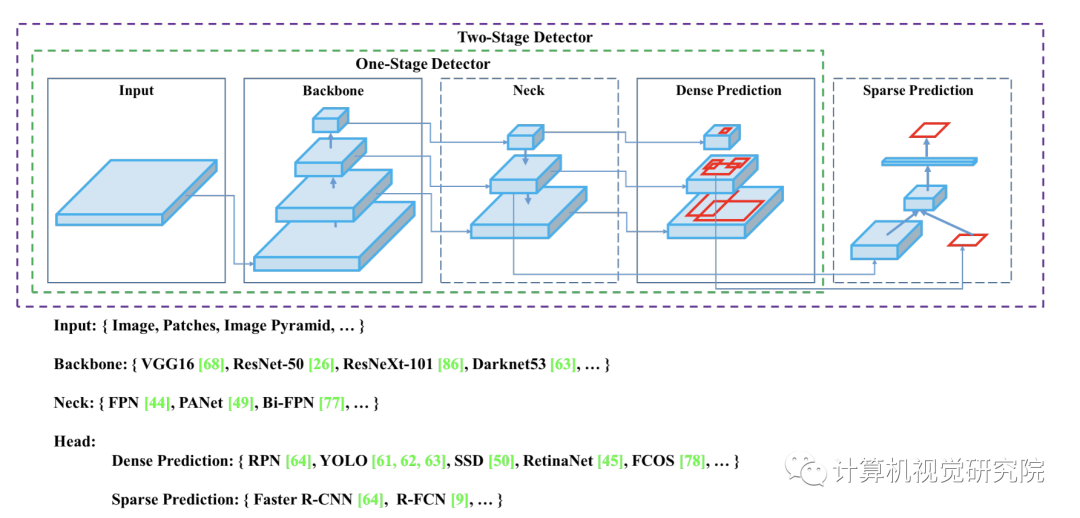

有大量的特征被认为可以提高卷积神经网络(CNN)的精度。需要在大型数据集上对这些特征的组合进行实际测试,并对结果进行理论验证。某些功能只对某些模型进行操作,某些问题只对某些模型进行操作,或只对小规模数据集进行操作;而某些功能(如批处理规范化和剩余连接)则适用于大多数模型、任务和数据集。本文假设这些通用特征包括加权剩余连接(WRC)、跨阶段部分连接(CSP)、跨小批量规范化(CmBN)、自对抗训练(SAT)和Mish激活。本文使用了新功能:WRC、CSP、CmBN、SAT、误激活、马赛克数据增强、CmBN、DropBlock正则化和CIoU丢失,并将其中一些功能结合起来,以达到以下效果:43.5%的AP(65.7%的AP50)用于MS COCO数据集,在Tesla V100上以65 FPS的实时速度。

创新点分析

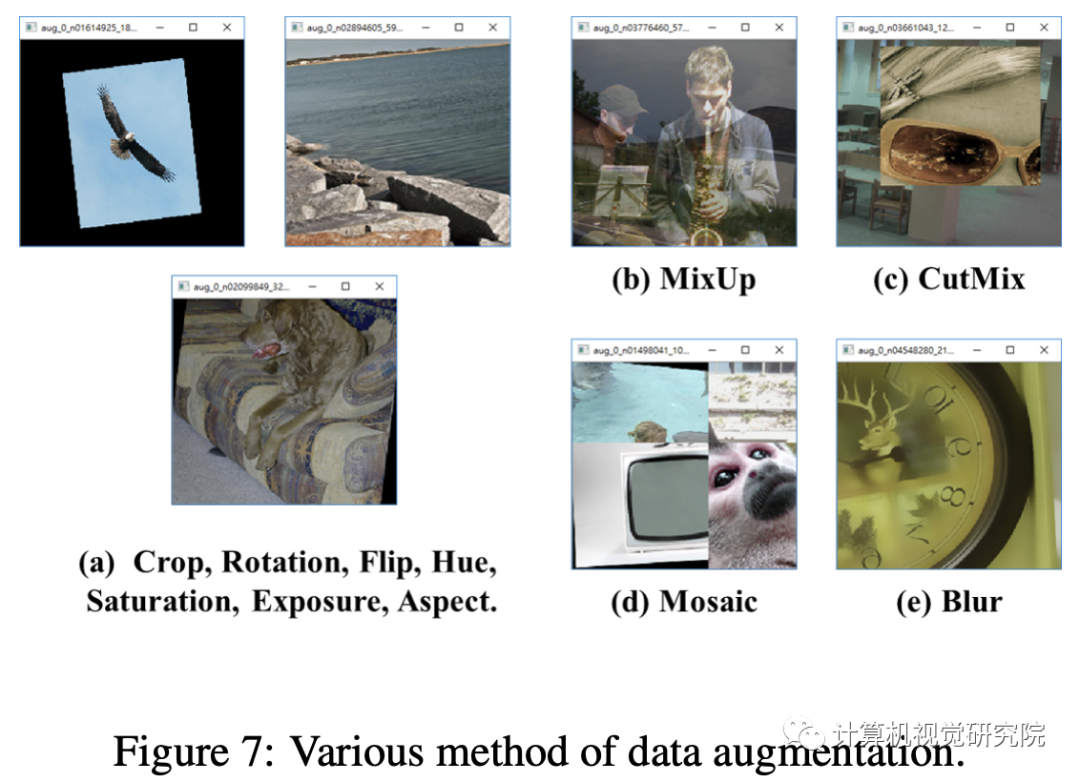

Mosaic数据增强

把四张图拼成一张图来训练,变相的等价于增大了mini-batch。这是从CutMix混合两张图的基础上改进;

Self-Adversarial Training

在一张图上,让神经网络反向更新图像,对图像做改变扰动,然后在这个图像上训练。这个方法,是图像风格化的主要方法,让网络反向更新图像来风格化图像。

Self-Adversarial Training (SAT) also represents a new data augmentation technique that operates in 2 forward backward stages. In the 1st stage the neural network alters the original image instead of the network weights. In this way the neural network executes an adversarial attack on itself, altering the original image to create the deception that there is no desired object on the image. In the 2nd stage, the neural network is trained to detect an object on this modified image in the normal way.

Cross mini-batch Normal

CmBN表示CBN修改的版本,如下图所示,定义为 Cross mini-Batch Normalization(CMBN)。这只收集单个批次内最小批次之间的统计数据。

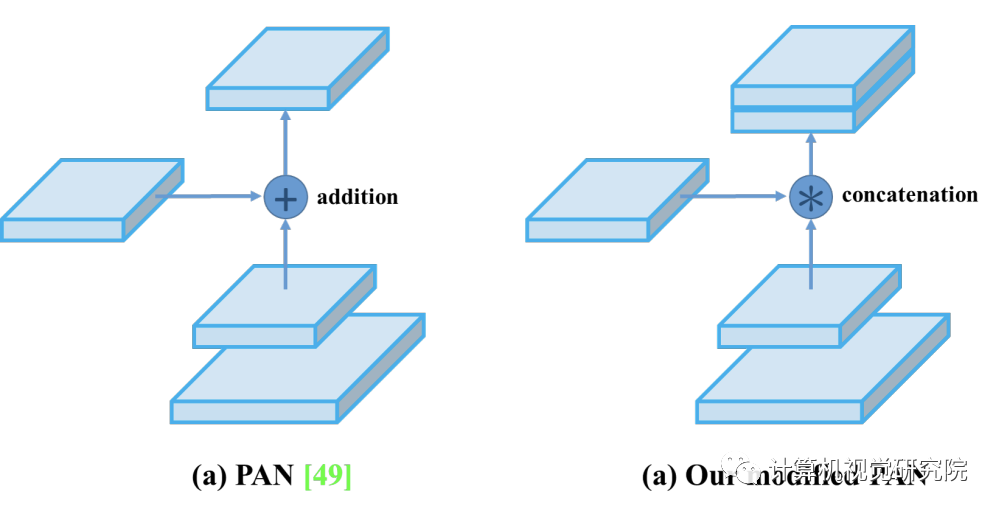

modify SAM

从SAM的逐空间的attention,到逐点的attention;修改的PAN,把通道从相加(add)改变为concat。

实验

以数据增强方法为例,虽然增加了训练时间,但可以让模型泛化性能和鲁棒性更好。例如下面的常见增强方法:

图像扰动,

改变亮度、对比对、饱和度、色调

加噪声

随机缩放

随机裁剪(random crop)

翻转

旋转

随机擦除(random erase)

Cutout

MixUp

CutMix

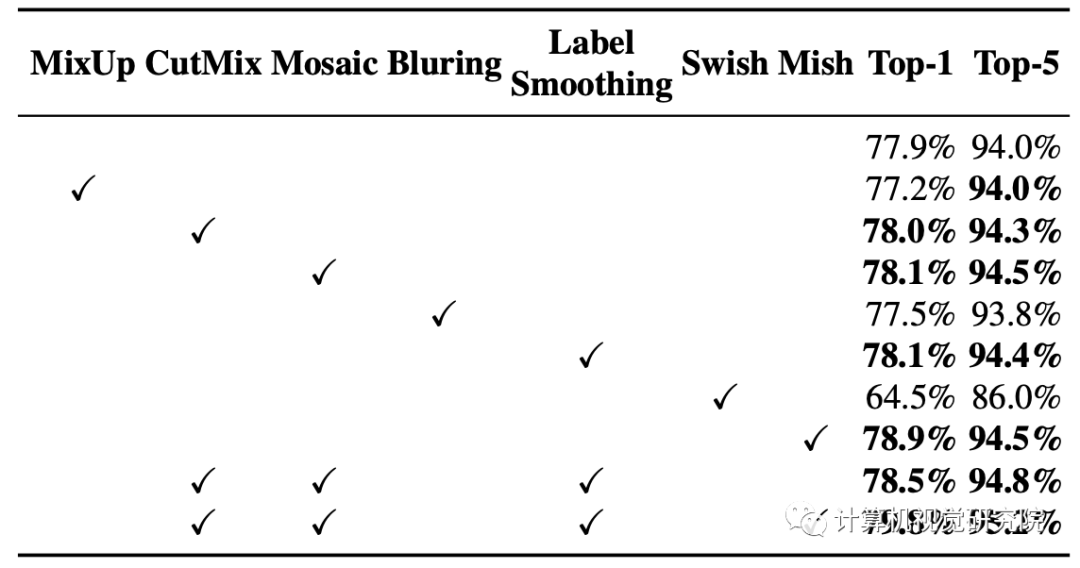

通过实验看得出,用了很多tricks,简直就是目标检测最强万花筒,下表是对分类网络的实验:

CSPResNeXt-50 classifier accuracy

CSPDarknet-53 classifier accuracy

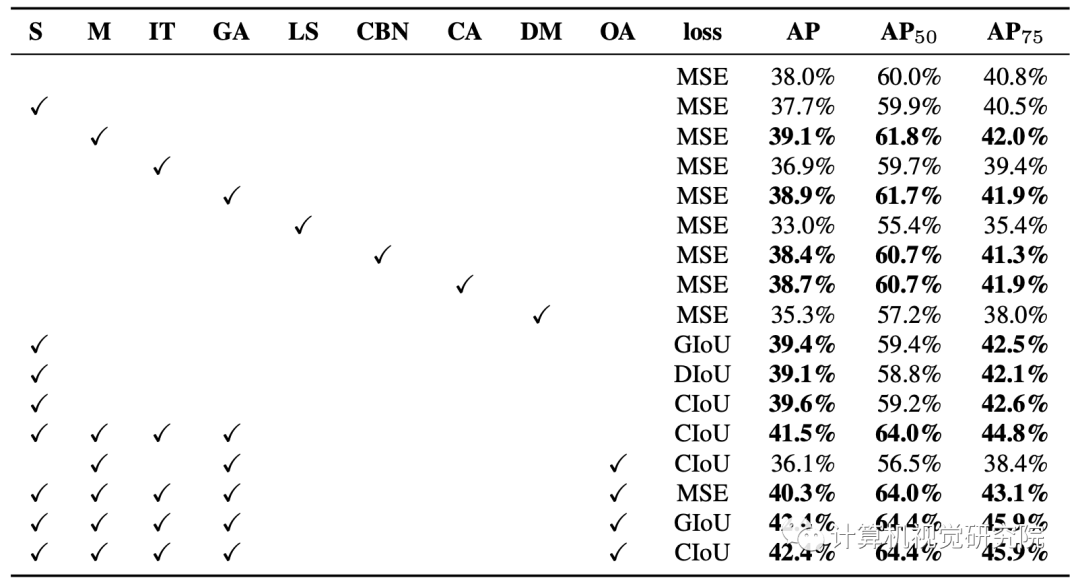

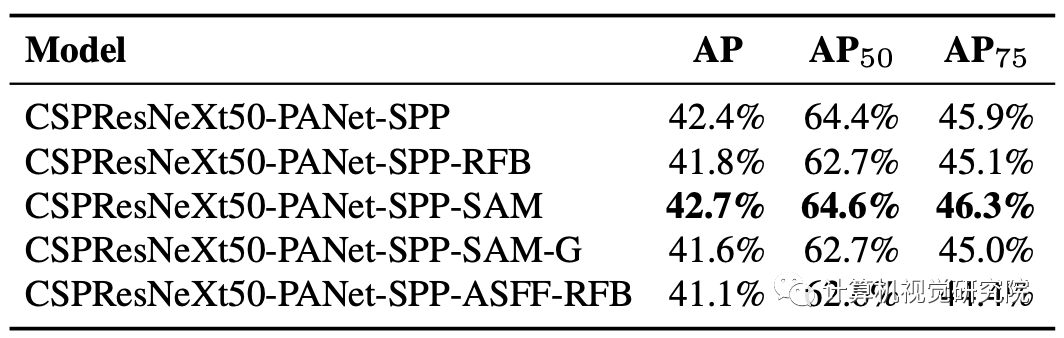

在YOLOv4检测网络上,对比了四个loss(GIoU、CIoU、DIoU、MSE),标签平滑,Cosine学习率,遗传算法选超参数,Mosaic数据增强等各种方法。下表是YOLOv4检测网络上的消融实验结果:

CSPResNeXt50-PANet-SPP, 512x512

使用不同与训练权重模型用于训练:

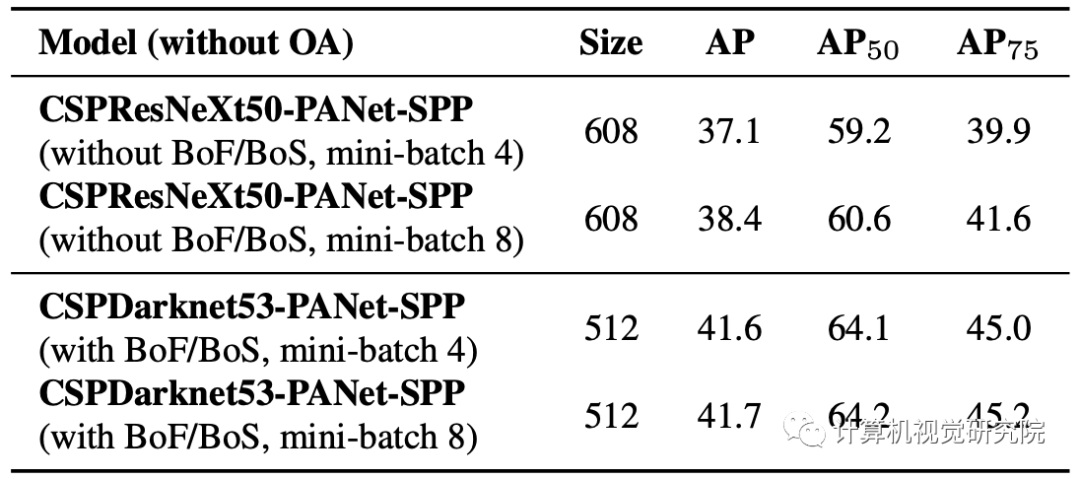

不同的mini-batch size结果:

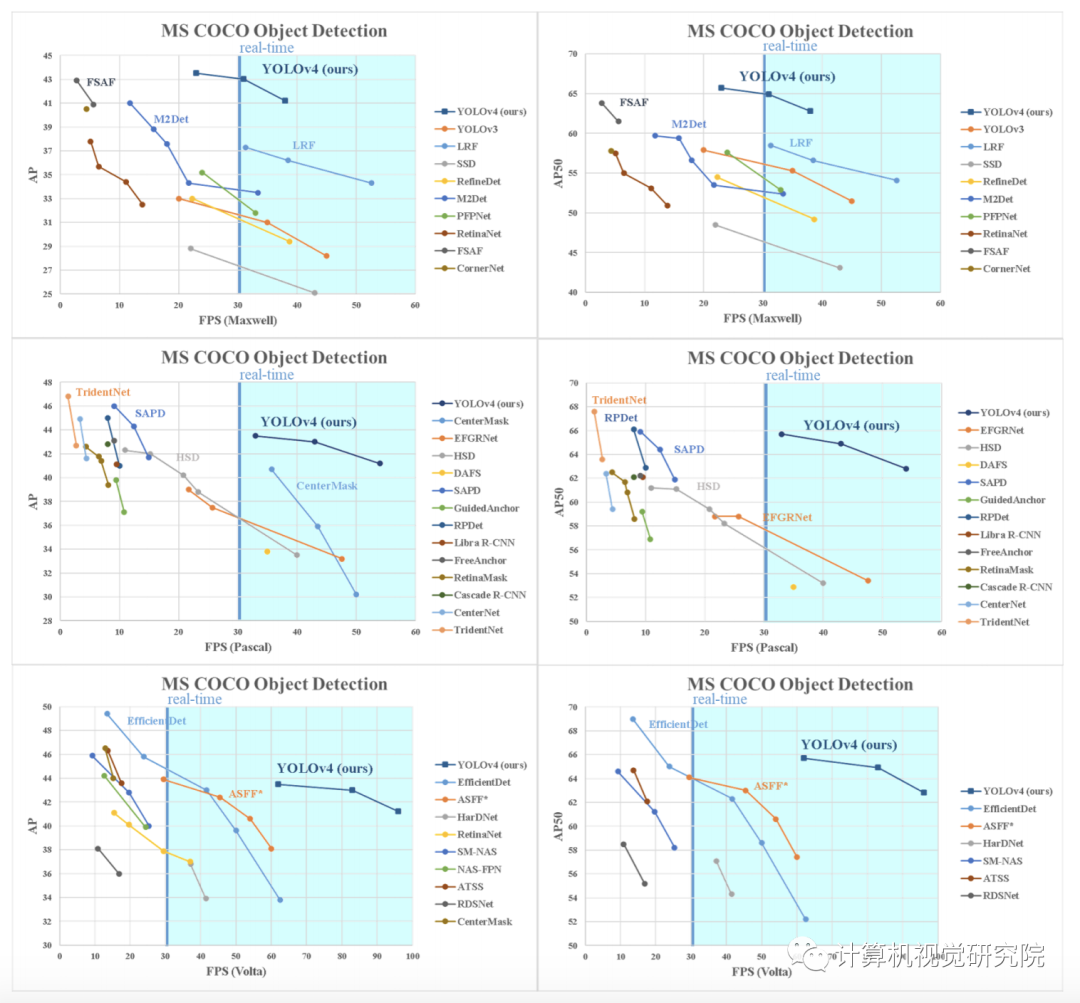

最后,是在Maxwell、Pascal、Volta三个不同系列的GPU,在COCO 数据集上的结果对比:

最劲爆的是,在COCO数据集,与其他框架比较(速度和精度):

如果想加入我们“计算机视觉研究院”,请扫二维码加入我们。我们会按照你的需求将你拉入对应的学习群!

计算机视觉研究院主要涉及深度学习领域,主要致力于人脸检测、人脸识别,多目标检测、目标跟踪、图像分割等研究方向。研究院接下来会不断分享最新的论文算法新框架,我们这次改革不同点就是,我们要着重”研究“。之后我们会针对相应领域分享实践过程,让大家真正体会摆脱理论的真实场景,培养爱动手编程爱动脑思考的习惯!

扫码关注我们

公众号 : 计算机视觉战队

扫码回复:YoloV4,获取下载链接