简介

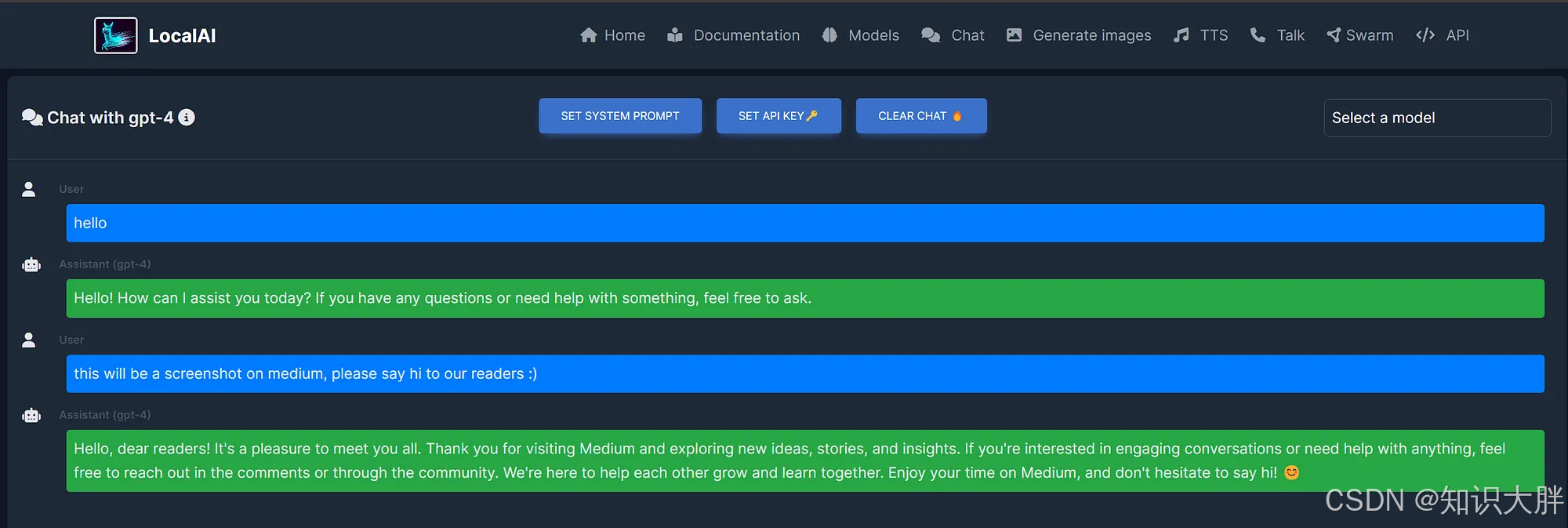

我最近遇到了LocalAI,这是一个开源平台,用于在本地尝试和运行不同的大型语言模型 (LLM) 和其他 AI 模型,例如文本转语音或图像生成。LocalAI 旨在替代 OpenAI 产品,让您可以在自己的硬件上部署和使用 AI 模型,从而确保隐私并潜在地节省云成本。但是,运行 CPU 版本——即使在我相当新的 i7 处理器上——也非常慢。幸运的是,我现在的笔记本电脑配备了功能强大的 NVIDIA RTX 4070,所以我寻找一种方法来充分利用 LocalAI 的强大功能。由于设置花了我一段时间,即使我之前有使用 Docker、WSL 和 Ubuntu 的经验,所以我想分享一个分步指南。

为什么选择 Docker 和 WSL2?

虽然我确实喜欢 Linux,但我仍然喜欢在我的“日常使用” PC 上运行 Windows,因为我还用它玩游戏或运行其他仅限 Windows 的应用程序。自从 WSL 诞生以来,这几乎变得毫不费力,因为 WSL 让我可以直接在 Windows 中同时拥有两全其美的优势。将 Docker 与 WSL2 结合使用为在 Windows 上运行基于 Linux 的容器提供了一个非常强大的环境。将其与 NVIDIA GPU 支持相结合,您可以显著加快 LocalAI 任务的速度。