1、Fine-tuning Approaches

从语言模型转移学习的一个趋势是,在监督的下游任务中相同模型的微调之前,一个语言模型目标上预训练一些模型体系结构。这些方法的优点是几乎没有什么参数需要从头学习。至少部分由于这一优势,OpenAI GPT在GLUE benchmark的许多句子级别任务上取得了以前最先进的结果。

微调是必须非常精确地调整模型参数以适应某些观察的过程。在没有已知机制来解释为什么参数恰好具有它们返回的观察值的情况下,需要微调的理论被认为是有问题的。

2、OpenAI GPT

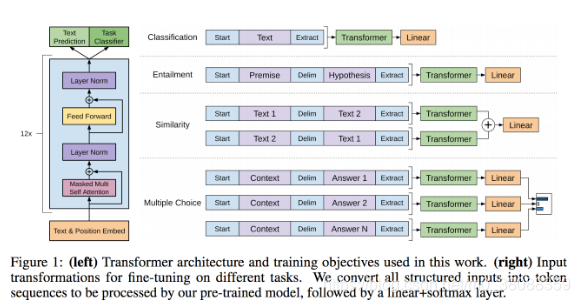

该方法主要结合了Transfromer和无监督预训练。

主要分为两个阶段:

(1)首先以无监督的方式在大型数据集上训练一个 Transformer,即使用语言建模作为训练信号。

(2)然后在小得多的有监督数据集上精调模型以解决具体任务。

这一项研究任务建立在Semi-supervised Sequence Learning论文中所提出的方法,该方法展示了如何通过无监督预训练的 LSTM 与有监督的精调提升文本分类性能。这一项研究还扩展了论文Universal Language Model Fine-tuning for Text Classification所提出的 ULMFiT 方法,它