因此我们尝试修改一下输入的类型,双击input type=“text”的text字段,将其修改为“password”,双击完成后,可以看出左侧直接变为了密码型的字段。

再将其恢复为文本类型,我们再修改一下ov和value的值

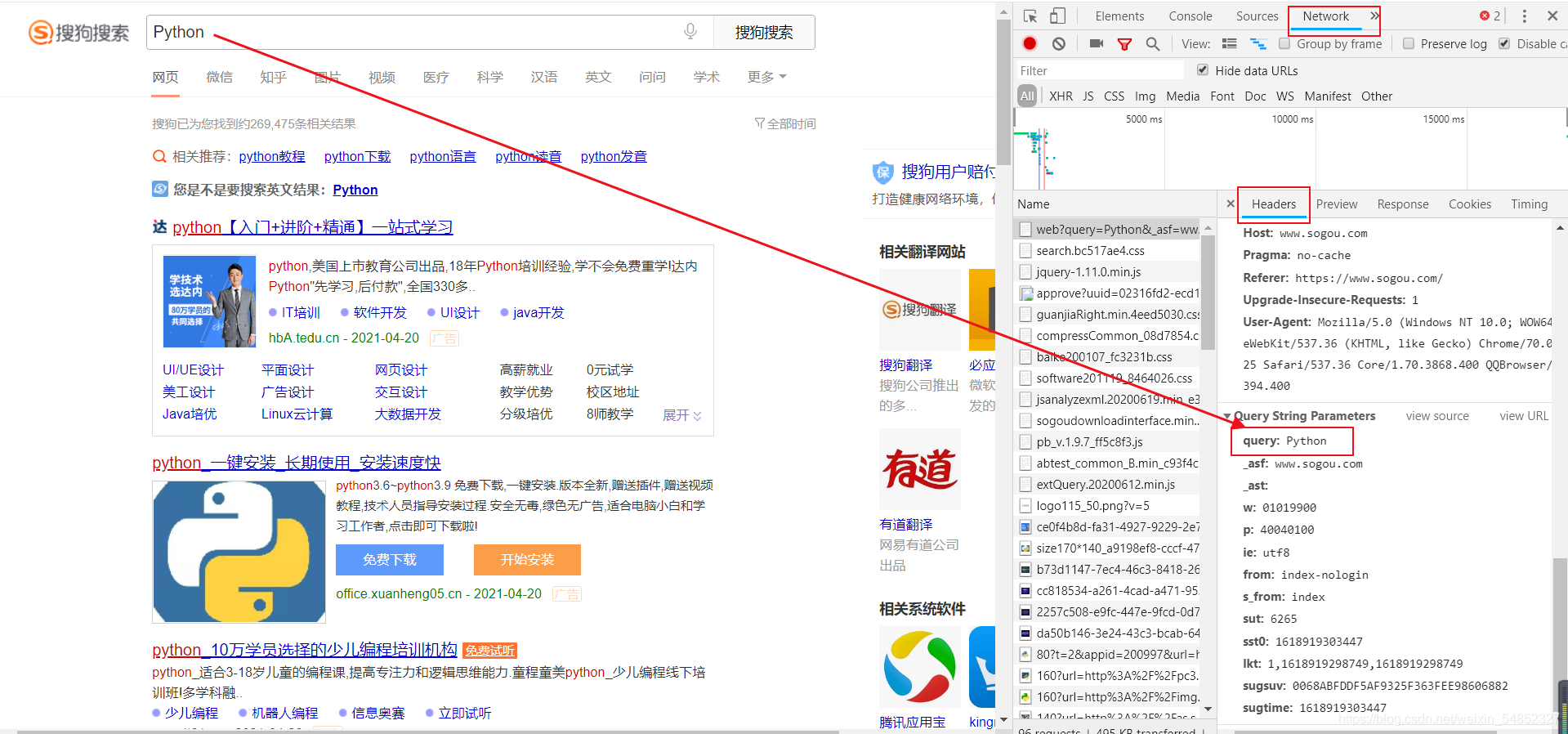

可以看出修改后搜索界面也发生了相应的改变,因此可以看出界面与代码之间是相对应的。在Network中同样也可以看到对应的搜索文本内容。

二、入门爬虫库的基本介绍与使用

**

库的下载

**

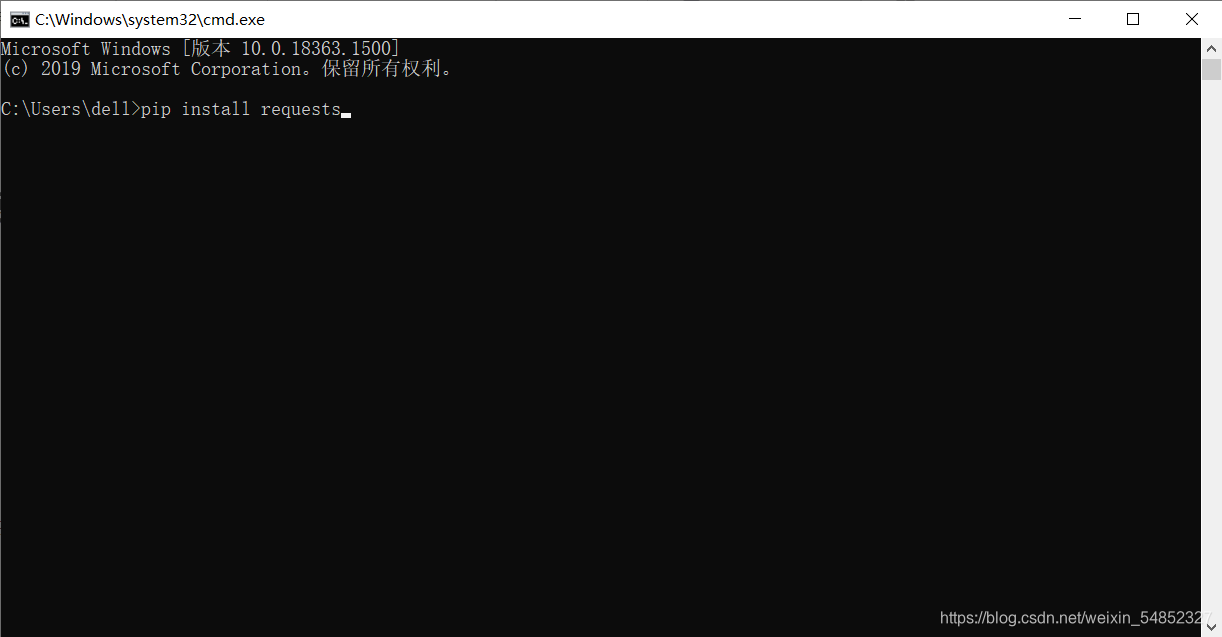

可以通过在windows的cmd命令(开始键+r键–>输入cmd打开)中输入

pip install <库名>

即可直接下载

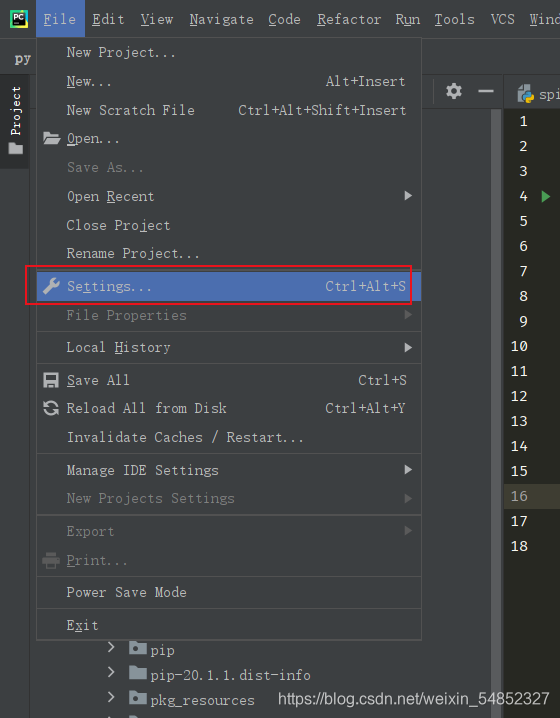

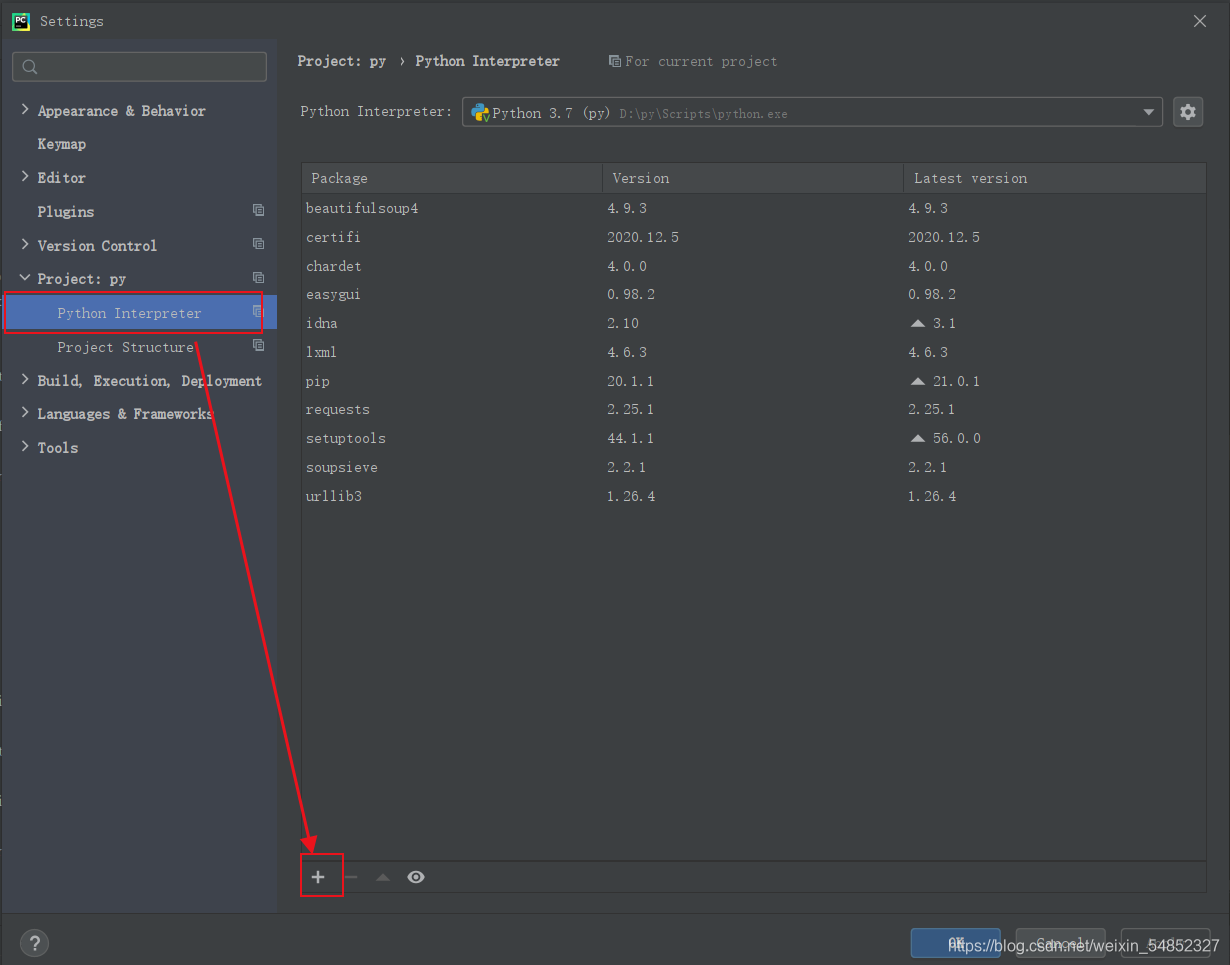

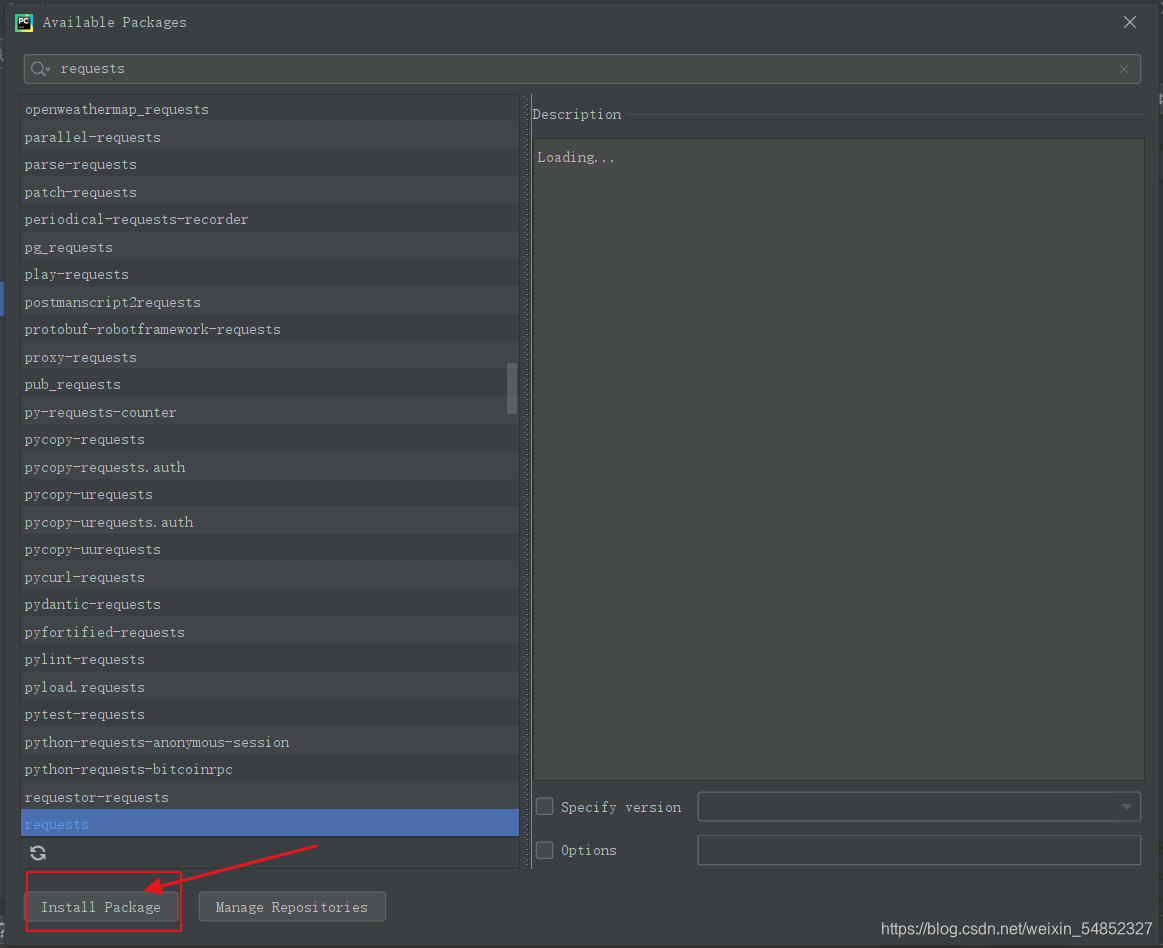

如果是采用PyCharm,则可以在File–>setting内搜索库名直接进行下载

介绍完库的下载方法后接下来就是库的介绍引用过程啦!!

依此将函数的功能列出实在是比较枯燥,因此选择举例方法介绍基本库函数的使用!

1.引入requests库并对库函数进行使用爬取全文本信息

首先爬虫需要使用的库是requests库,其功能主要是由网站的url获取网页全部信息。

import requests

req = requests.get(url = <目标网站>, headers = <网站爬虫的头信息>)

#通常使用headers来隐藏自己爬虫的身份,通过headers信息将自己伪装成->

#浏览器搜索引擎等,是防止一些网站识破代码爬虫的有效手段。

requests.get()函数主要是返回网页的基本信息,通常要对获得的信息进行解码,此时就需要了解到原始网页的头文名里的编码信息。

一般是在里边找到"charset"的信息,一般为utf-8。

req.enconding = "utf-8" #解码过程

html = req.text #导出文本内容

其实到这里就可以对小说网站进行最基本的爬虫了,

以下就是最基础的入门代码。

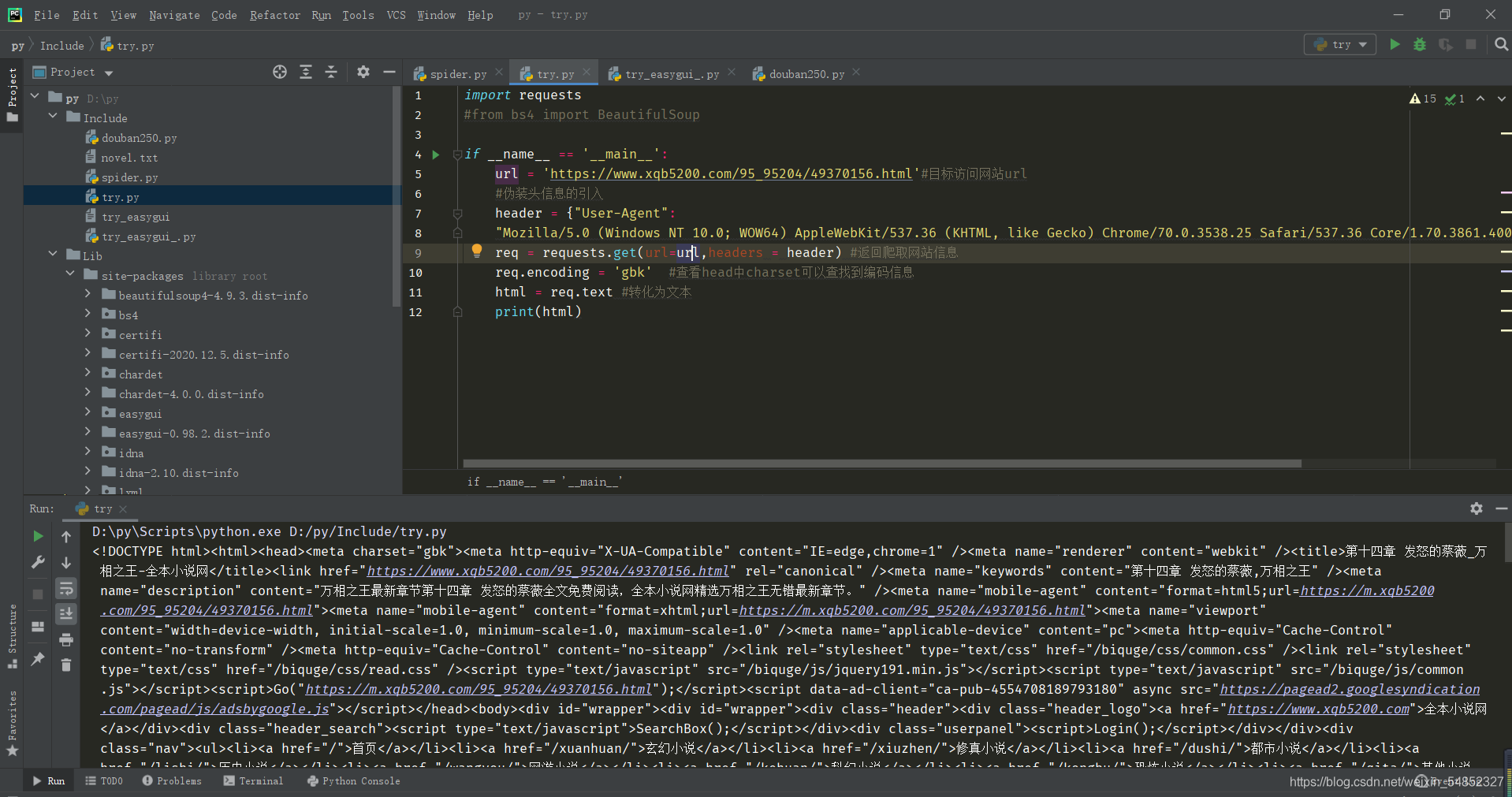

import requests

#from bs4 import BeautifulSoup

if __name__ == '__main__':

url = 'https://www.xqb5200.com/95_95204/49370156.html'#目标访问网站url

#伪装头信息的引入

header = {"User-Agent":

"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3861.400 QQBrowser/10.7.4313.400"}

req = requests.get(url=url,headers = header) #返回爬取网站信息

req.encoding = 'gbk' #查看head中charset可以查找到编码信息

html = req.text #转化为文本

print(html)

看到这里,初学者肯定会疑惑headers是从哪儿获取得到的,下面是简单举例:

在网页的Netwrok中找到headers,往下翻,寻找到User-Agent,将其复制粘贴即可。

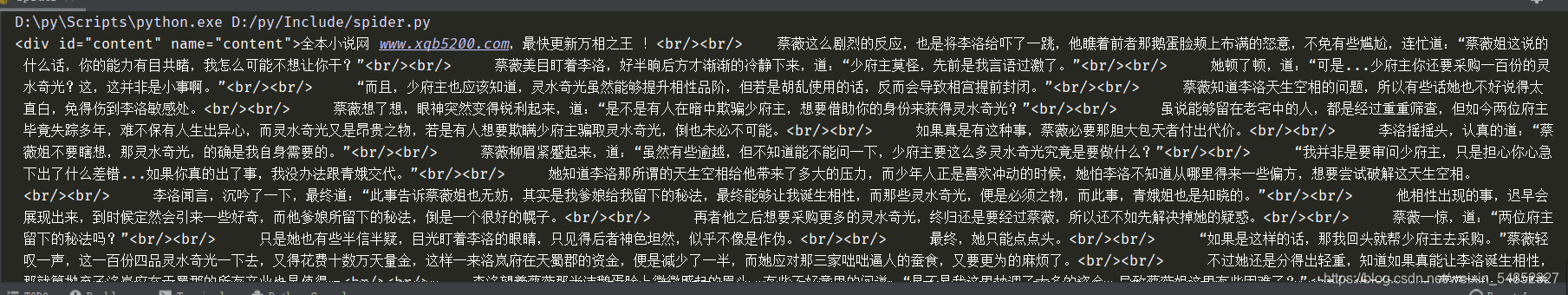

爬取结果如下:

显然,它把全部信息都显示了,并不是我们需要的内容。

接下来就要引入另一个库进行。

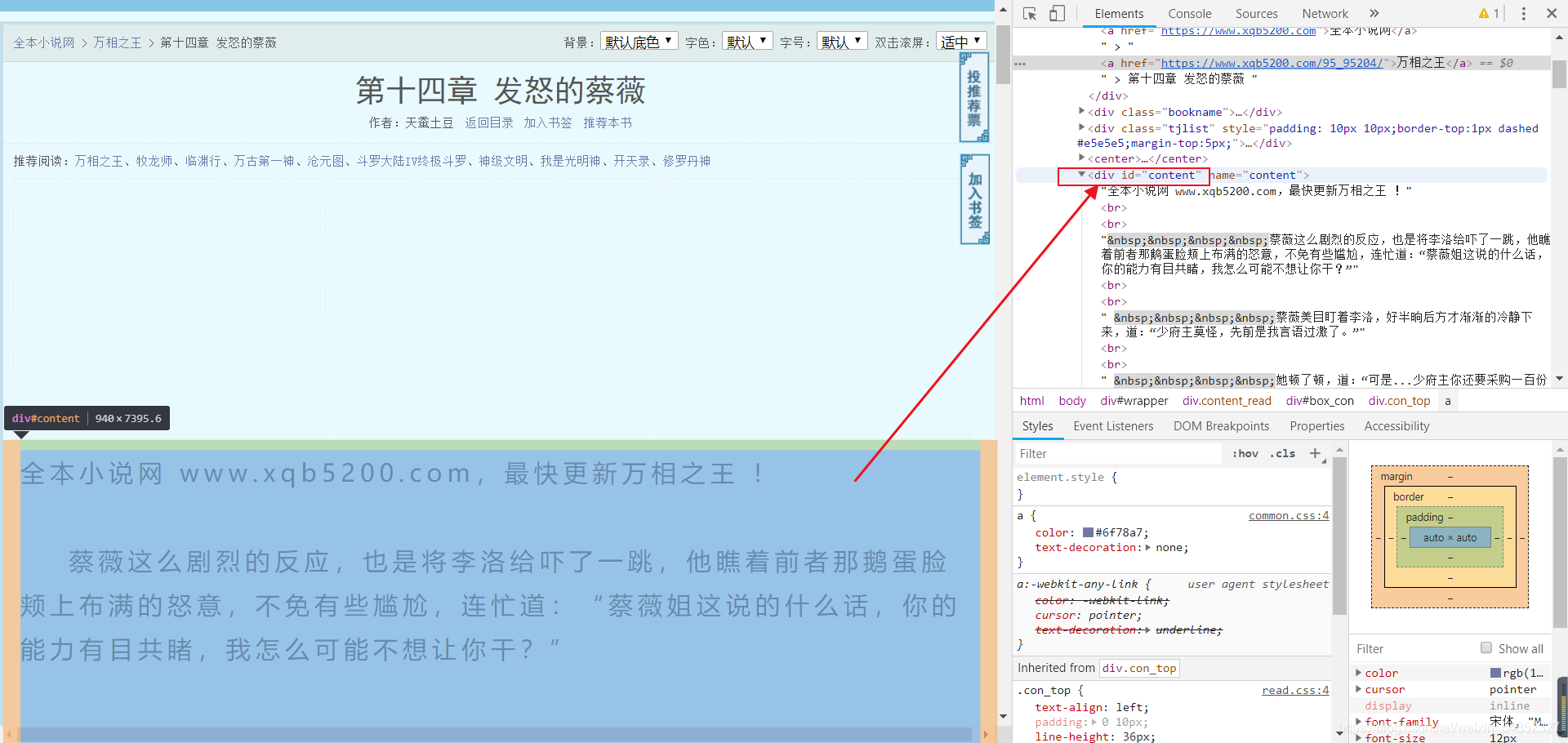

2.BeautifulSoup库的介绍、引用过程及解析获取爬虫数据

除了requests库的爬取内容,其次就是BeautifulSoup库的解析数据功能。

BeautifulSoup库是BeautifulSoup4库(一般书写为bs4)中的子库。

import bs4 from BeautifulSoup

#html接上文中的已爬取得到的全部信息

bes= BeautifulSoup(html,"lxml")#通过lxml方式解析获取网页中文本信息

text = bes.find("div", id = "content"[,class_ = "<class的名称>"]) #解析text中,提取标签为"div"内id = "content"全部信息,也可解析提取class = <某名称>的内容信息

代码如下:

import requests

from bs4 import BeautifulSoup

if __name__ == '__main__':

url = 'https://www.xqb5200.com/95_95204/49370156.html'

header = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3861.400 QQBrowser/10.7.4313.400"}

req = requests.get(url=url,headers = header)

req.encoding = 'gbk'

html = req.text

bes = BeautifulSoup(html,"lxml")

texts = bes.find("div", id = "content")

print(texts)

运行结果如下:

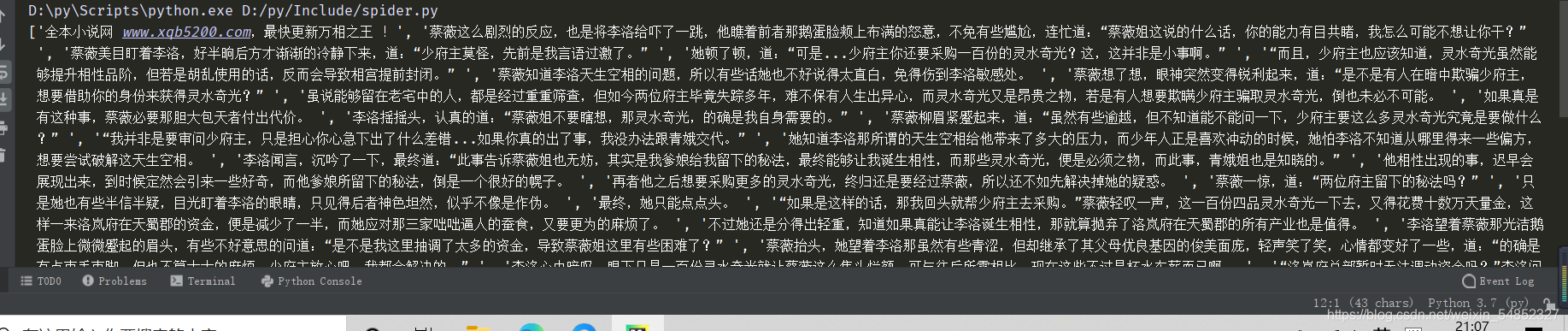

结果中可以看出在每段的开头处存在四个空格键,因此需要将其消除

代码如下:

texts_list = texts.text.split("\xa0"*4)

print(texts_list)

得到列表结果:

**

全代码如下:

**

import requests

from bs4 import BeautifulSoup

if __name__ == '__main__':

url = 'https://www.xqb5200.com/95_95204/49370156.html'

header = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3861.400 QQBrowser/10.7.4313.400"}

req = requests.get(url=url,headers = header)

req.encoding = 'gbk'

html = req.text

bes = BeautifulSoup(html,"lxml")

texts = bes.find("div", id = "content")

texts_list = texts.text.split("\xa0"*4)

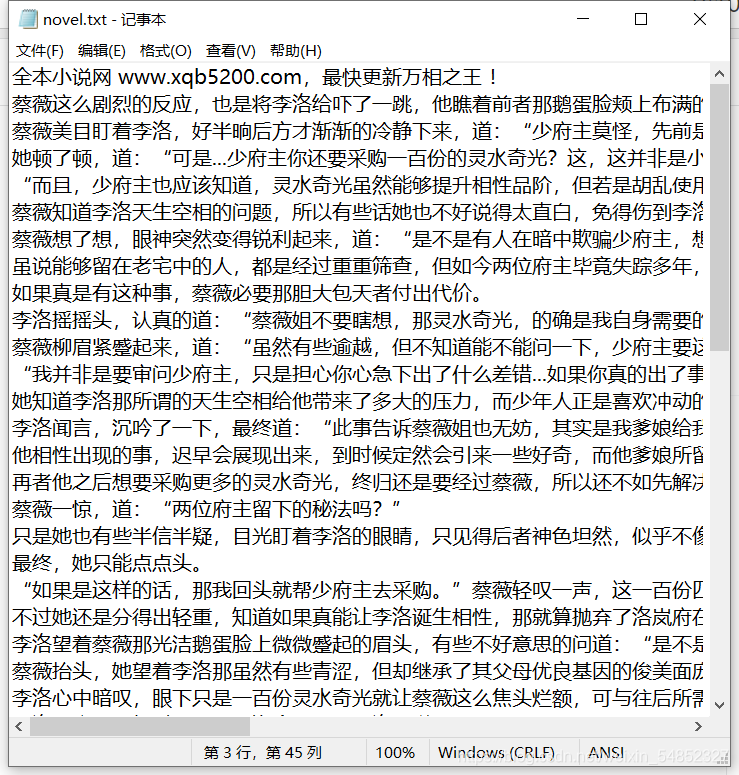

with open("D:/novel.txt","w") as file: ##打开读写文件,逐行将列表读入文件内

for line in texts_list:

file.write(line+"\n")

得到结果如下:

别急,还有亿点点!

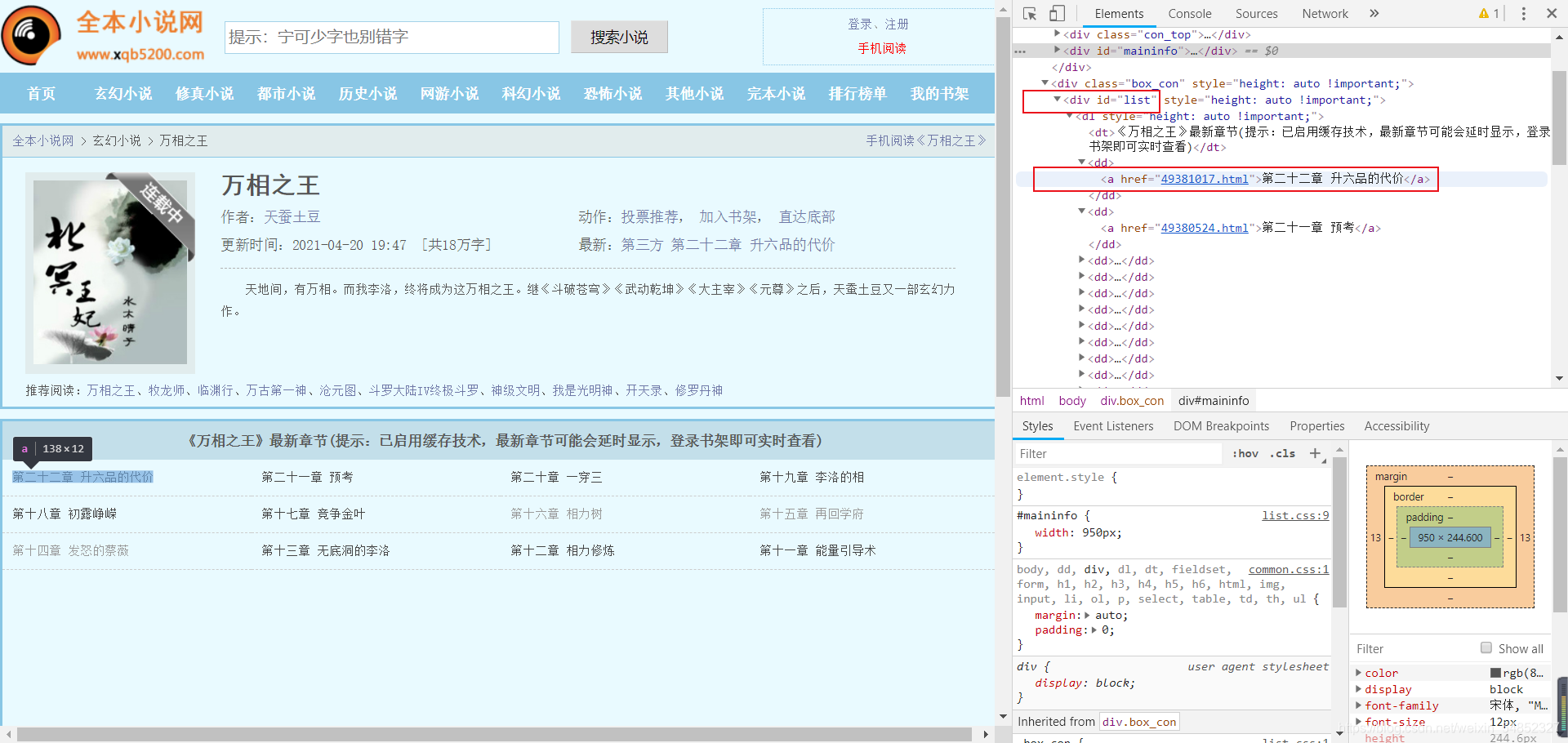

三、初步进阶——批量爬取下载小说

批量读入小说文本文件

可将代码进一步深化,采用同样的操作方法,从全体章节处读取url网站名导入列表中,再对以上代码进行批量的读取即可进行批量下载小说等文本文件了。

**

批量爬取下载小说至txt文本全代码如下:

**

import requests

from bs4 import BeautifulSoup

def geturl():

url = "https://www.xqb5200.com/95_95204/"

header = {"User-Agent":

"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3861.400 QQBrowser/10.7.4313.400"}

req = requests.get(url = url, headers = header)

req.encoding = "gbk"

html = req.text

bes = BeautifulSoup(html,"lxml")

texts = bes.find("div", id="list")

chapters = texts.find_all("a") #该函数可以返回list下的标签为a的所有信息

words = [] #创建空的列表,存入每章节的url与章节名称

##对标签a内的内容进行提取

for chapter in chapters:

name = chapter.string #取出字符串,可以看出字符串只有章节号与章节名称,刚好符合我们所需

url1 = url + chapter.get("href") #获得每一章节小说的url,可从html代码中看到每一个"href"前边均缺少初始的url,因此需要加上

word = [url1, name] #以列表格式存储

words.append(word) #最终加入总的大列表中并返回

return words

if __name__ == '__main__':

target = geturl()

header = {"User-Agent":

"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3861.400 QQBrowser/10.7.4313.400"}

for tar in target:

req = requests.get(url=tar[0],headers = header)

req.encoding = 'gbk'

html = req.text

bes = BeautifulSoup(html,"lxml")

texts = bes.find("div", id = "content")

texts_list = texts.text.split("\xa0"*4)

with open("D:/novels/"+ tar[1] + ".txt","w") as file: #写入文件路径 + 章节名称 + 后缀

for line in texts_list:

file.write(line+"\n")

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

### 一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

### 二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

### 三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

### 四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

### 五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

### 六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化学习资料的朋友,可以戳这里无偿获取](https://bbs.csdn.net/topics/618317507)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**