先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前在阿里

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

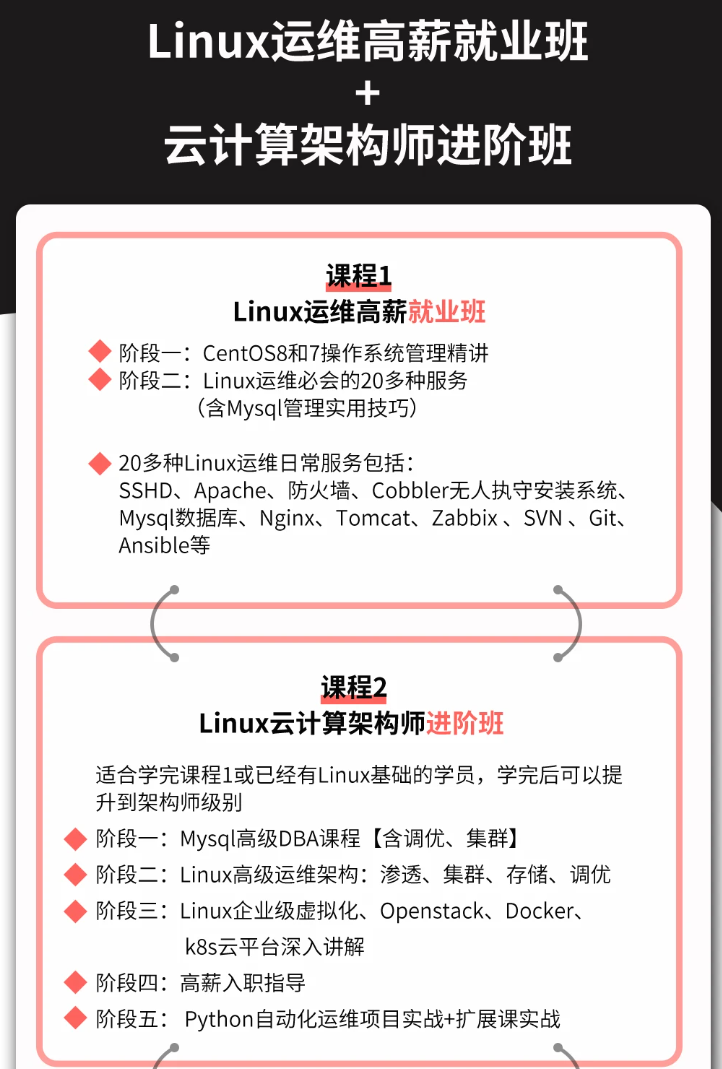

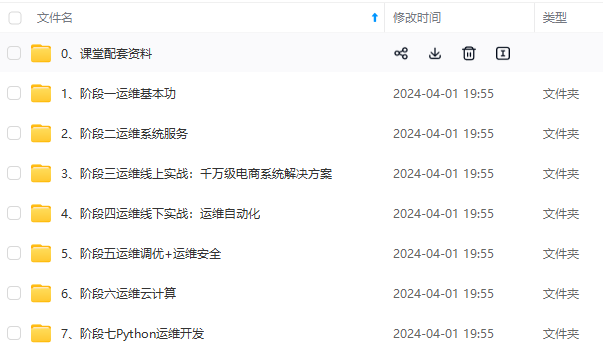

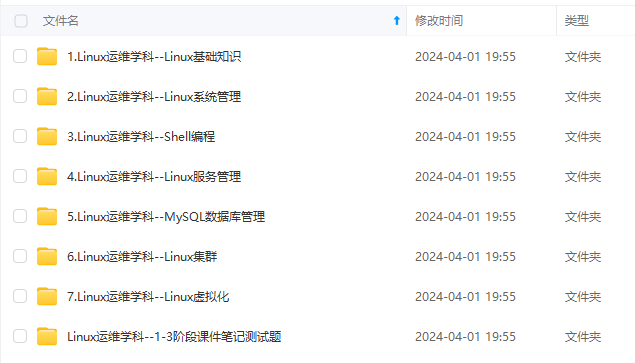

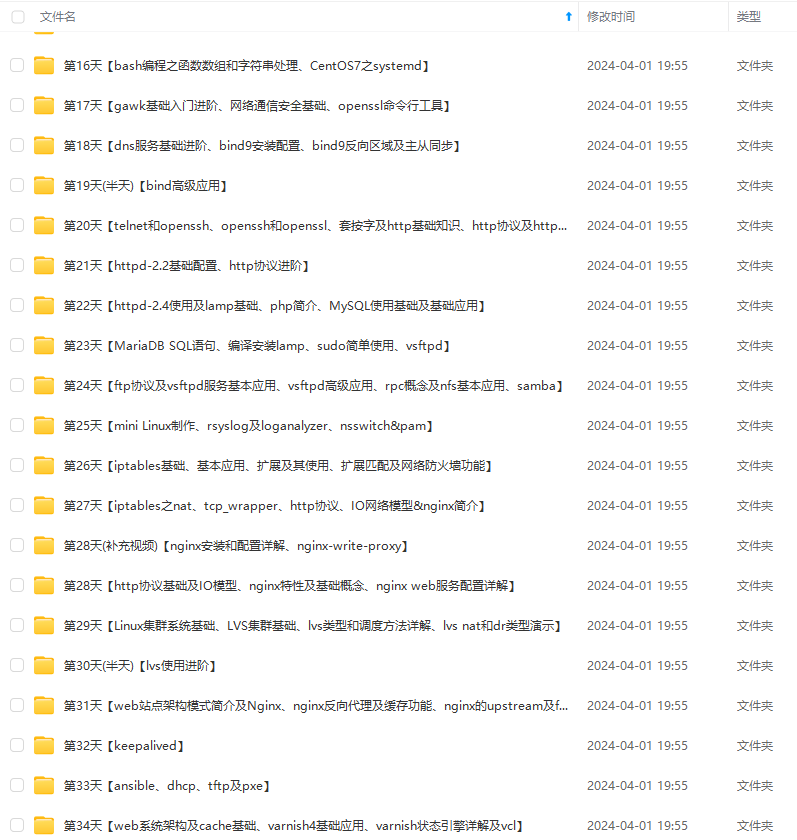

因此收集整理了一份《2024年最新Linux运维全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上运维知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

Aug 17 15:56:50 hbs crond[23739]: (CRON) INFO (@…

Hint: Some lines were ellipsized, use -l to show in full.

[root@hbs/tmp]#

- 相关启动命令

Centos 6

service crond start //启动服务

service crond stop //关闭服务

service crond restart //重启服务

service crond reload //重新载入配置

service crond status //查看服务状态

Centos 7

systemctl stop crond //关闭

systemctl start crond //开启

systemctl reload crond //重新加载

systemctl restart crond //重启

02.定时任务 配置方法

2.1定时任务相关文件

-

定时任务 服务配置文件目录:

/var/spool/cron -

定时任务 运行记录日志文件:

/var/log/cron -

定时任务 禁止用户运行名单:

/etc/cron.deny

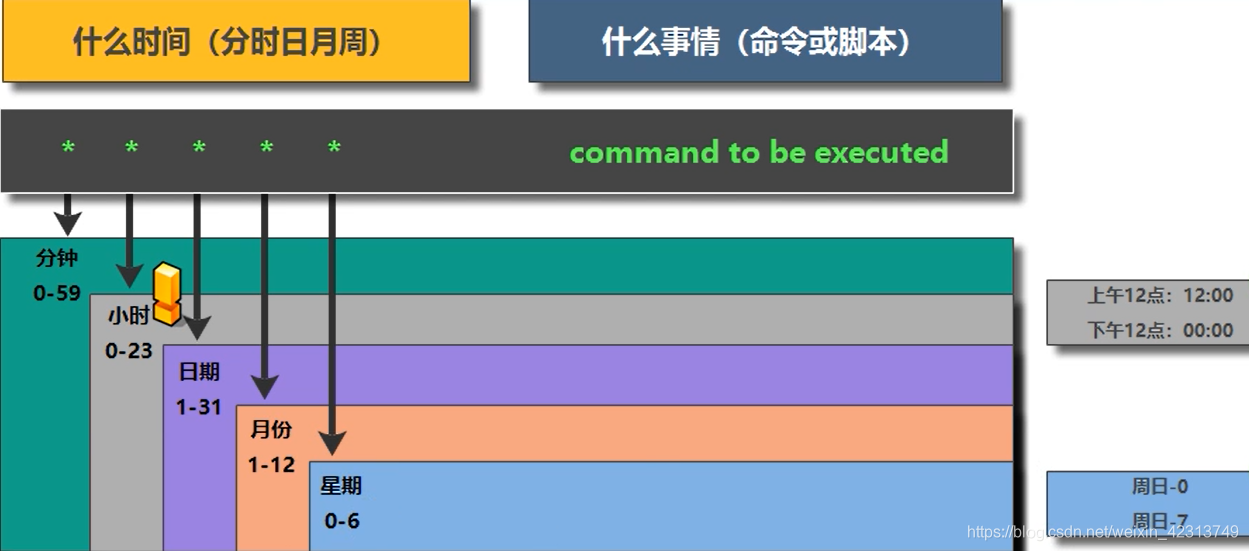

2.2定时任务编写格式

- 查看编写格式

[root@hbs/tmp]# cat /etc/crontab

SHELL=/bin/bash

PATH=/sbin:/bin:/usr/sbin:/usr/bin

MAILTO=root

For details see man 4 crontabs

Example of job definition:

.---------------- minute (0 - 59)

| .------------- hour (0 - 23)

| | .---------- day of month (1 - 31)

| | | .------- month (1 - 12) OR jan,feb,mar,apr …

| | | | .---- day of week (0 - 6) (Sunday=0 or 7) OR sun,mon,tue,wed,thu,fri,sat

| | | | |

* * * * * user-name command to be executed

分 时 日 月 周

[root@hbs/tmp]#

-

-

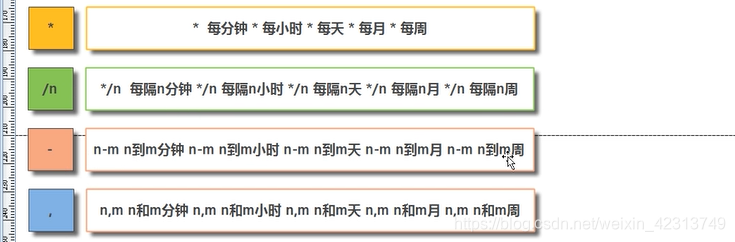

写法:

1.用数值表示 时间信息

00 02 * * * 备份文件

2.利用特殊符号表示时间信息

-

* * * * 备份文件

/分钟 /小时 /天 /月 /周

=========================================

PS:定时任务最短执行的周期为 每分钟

*/5 */ 6 */3 */1 */2

每隔5分钟 每隔6小时 每隔3日 每隔1月 每隔2周

=========================================

其它 写法:

01-05 02 * * * 每2日的01、02、03、04、05 执行一遍

指定不连续的时间范围:

00 14,20 * * * * 每天14点,20点执行一次

-

-

补充说明

00/10 01,03 * * * 每天1点和3点的时候 每隔 10分钟,执行一次

30/10 01,03 * * * 每天1点和3点的时候 , 从30分钟开始,每隔 10分钟,执行一次

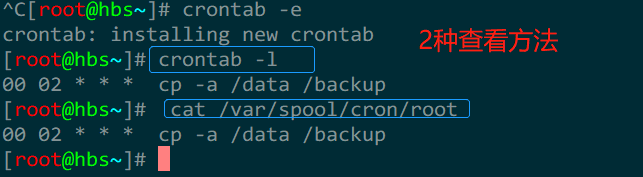

2.3 编写步骤

- 编写步骤

每天凌晨两点备份 /data目录到 /backup

第一个历程: 写上时间信息

00 02 * * *

第二个历程: 写上完成任务的具体命令

cp -a /data /backup

第三个历程: 编写定时任务

crontab -e

00 02 * * * cp -a /data /backup

======================================

[root@hbs~]#crontab -e

00 02 * * * cp -a /data /backup

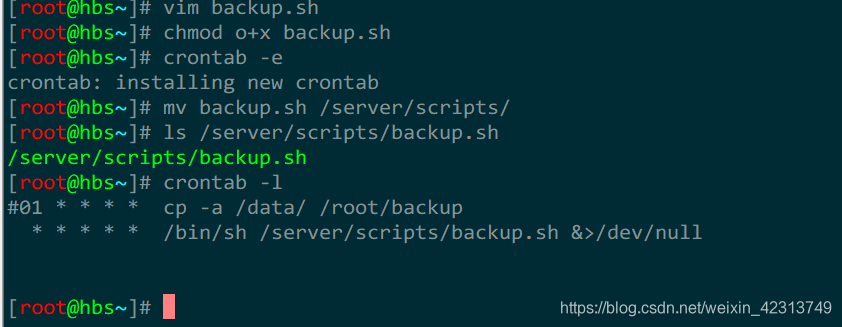

2.4定时任务编写注意事项:(规范)

-

编写定时任务要有注释说明

-

编写定时任务路径信息尽量使用绝对路径

-

编写定时任务命令需要采用绝对路径执行 /usr/sbin/useradd

命令执行成功条件:

useradd —> $PATH —> /sbin/useradd —> 命令执行成功

定时任务执行时,识别的PATH信息只有: /usr/bin:/bin

useradd命令—>usr/sbin/useradd

所以,编写要写绝对路径

useradd命令—>usr/sbin/useradd

- 编写定时任务时,可以将输出到屏幕上的信息保存到黑洞中,避免占用磁盘空间

sh test.sh &>/dev/null

- 编写定时任务, 尽量不要产生屏幕输出信息

tar zcvf /backup/data.tar.gz /data 有信息输出

tar zcf /backup/data.tar.gz ./data 没有信息输出

- 当需要多个命令完成一个定时任务需求时,可以利用脚本编写定时

vim backup.sh

cp -a /data /backup

tar zcvf /backup/data.tar.gz /data

crontab -e

xxxxx

-

-

-

-

- /bin/sh /server/scripts/backup.sh &>/dev/null

-

-

-

-

============================================================

- 对定时任务排查的方法

1.检查是否有定时任务配置文件

2.检查定时任务日志文件

[root@hbs~]# tail -f /var/log/cron

Aug 17 21:27:49 hbs crontab[26501]: PAM pam_end: NULL pam handle passed

Aug 17 21:39:27 hbs crontab[26577]: (root) END EDIT (root)

Aug 17 21:39:27 hbs crontab[26577]: PAM pam_end: NULL pam handle passed

Aug 17 21:40:58 hbs crontab[26595]: (hbs) END EDIT (hbs)

Aug 17 21:41:01 hbs CROND[26598]: (hbs) CMD (systemctl status crond)

执行时间 主机名 编辑定时任务 以什么用户编辑或执行定时任务/干了什么事情 执行定时任务

- 定时任务还有atd 定时任务

at命令是一次性定时计划任务,执行完一个任务后不再执行此任务了。

at -f /tmp/date now +1 minutes #设置1分钟后执行/tmp/date文件中的内容

明天17点钟,输出时间到指定文件内

[root@hbs~]# echo ‘love you’ >/dev/null

[root@hbs~]# at 17:00 tomorrow

at> echo ‘love you’ >/dev/null

at>

job 8 at Thu Aug 19 17:00:00 2021

Can’t open /var/run/atd.pid to signal atd. No atd running?

[root@hbs~]#

删除已经设置的任务

atq : 查看定时任务

atrm 8 :删除定时任务

最后的话

最近很多小伙伴找我要Linux学习资料,于是我翻箱倒柜,整理了一些优质资源,涵盖视频、电子书、PPT等共享给大家!

资料预览

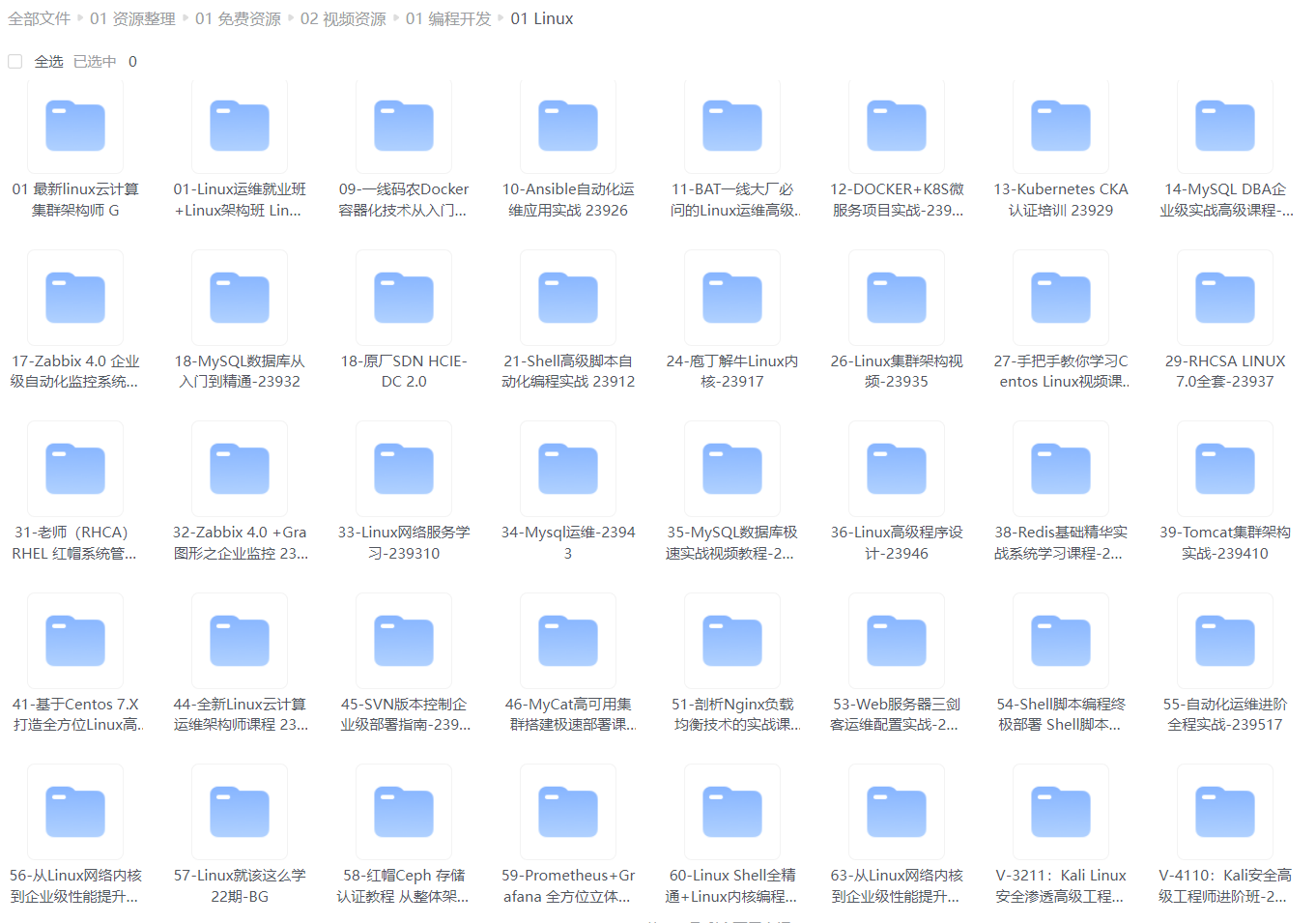

给大家整理的视频资料:

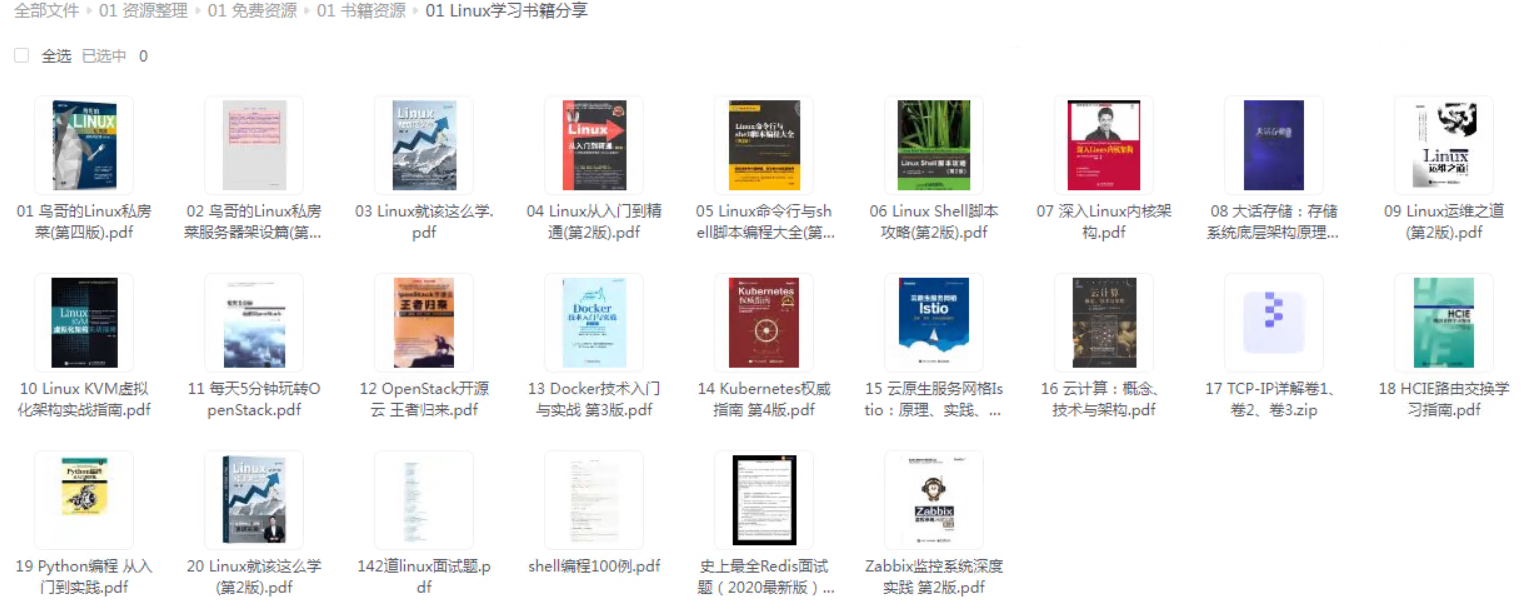

给大家整理的电子书资料:

如果本文对你有帮助,欢迎点赞、收藏、转发给朋友,让我有持续创作的动力!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

我要Linux学习资料,于是我翻箱倒柜,整理了一些优质资源,涵盖视频、电子书、PPT等共享给大家!

资料预览

给大家整理的视频资料:

[外链图片转存中…(img-c2XeBk5J-1715770593589)]

给大家整理的电子书资料:

[外链图片转存中…(img-nnioX8TQ-1715770593589)]

如果本文对你有帮助,欢迎点赞、收藏、转发给朋友,让我有持续创作的动力!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!