文章目录

- 零、学习目标

- 一、导入新课

- 二、新课讲解

- 三、归纳总结

- 四、上机操作

零、学习目标

- 了解HDFS Java API

- 掌握使用Java API操作HDFS

一、导入新课

- 上一节对HDFS的Shell操作进行了详细的讲解,而HDFS Shell本质上就是对Java API的应用。本节课将针对HDFS Java API操作进行详细讲解。

二、新课讲解

- 由于Hadoop是使用Java语言编写的,因此可以使用Java API操作Hadoop文件系统。HDFS Shell本质上就是对Java API的应用,通过编程的形式操作HDFS,其核心是使用HDFS提供的Java API构造一个访问客户端对象,然后通过客户端对象对HDFS上的文件进行操作(增、删、改、查)。

(一)了解HDFS Java API

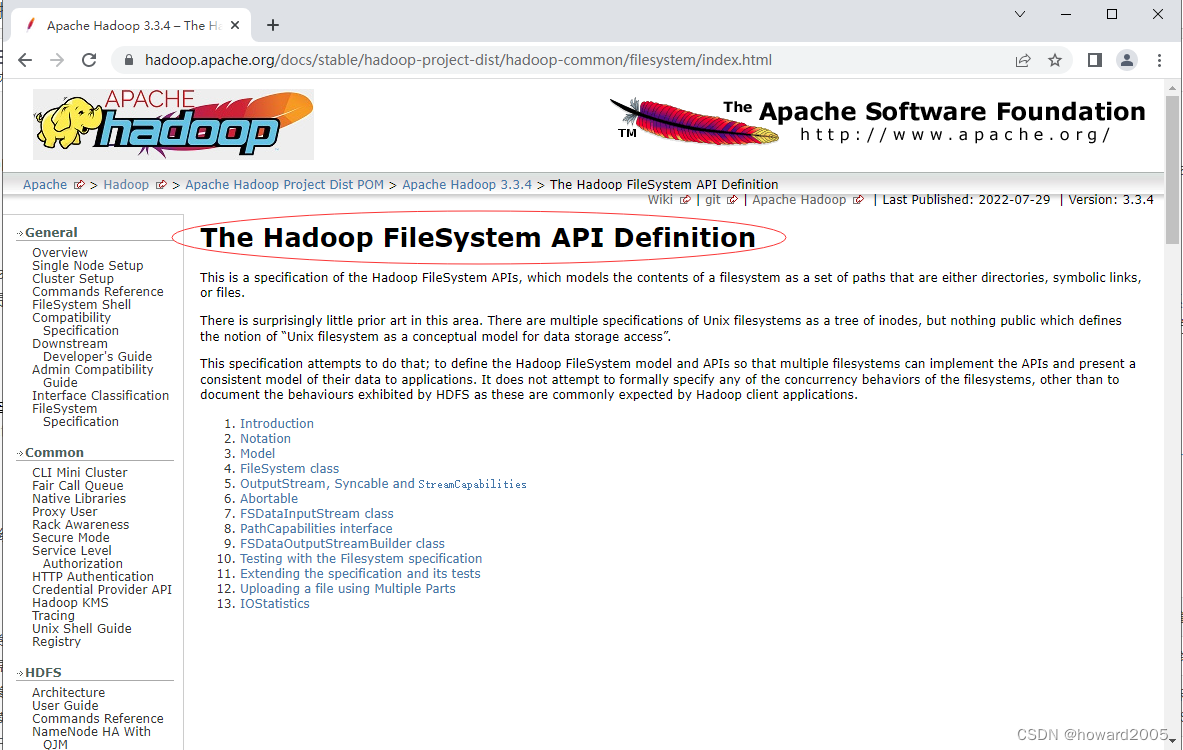

- Hadoop文件系统API文档:Apache Hadoop 3.3.4 – The Hadoop FileSystem API Definition

1、HDFS常见类与接口

- Hadoop整合了众多文件系统,HDFS只是这个文件系统的一个实例。

| 类或接口 | 功能描述 |

|---|---|

| org.apache.hadoop.fs.FileSystem | 一个通用文件系统的抽象基类,可被分布式文件系统继承。 |

| org.apache.hadoop.fs.FileStatus | 文件状态接口,用于向客户端展示系统中文件和目录的元数据。具体包括文件大小、块大小、副本信息、所有者、修改时间等,可通过FileSystem.listStatus()方法获得具体的实例对象。 |

| org.apache.hadoop.fs.FileDataInputStream | 文件输入流,用于读取Hadoop文件。 |

| org.apache.hadoop.fs.FileDataOutputStream | 文件输出流,用于写Hadoop文件。 |

| org.apache.hadoop.fs.Configuration | 访问配置项,所有配置项的值,如果在core-site.xml中有对应的配置,则以core-site.xml为准。 |

| org.apache.hadoop.fs.Path | 路径,用于表示Hadoop文件系统中的一个文件或一个目录的路径。 |

| org.apache.hadoop.fs.PathFilter | 路径过滤器接口,通过实现方法PathFilter.accept(Path path)来判断是否接收路径path表示的文件或目录。 |

2、FileSystem的常用方法

-

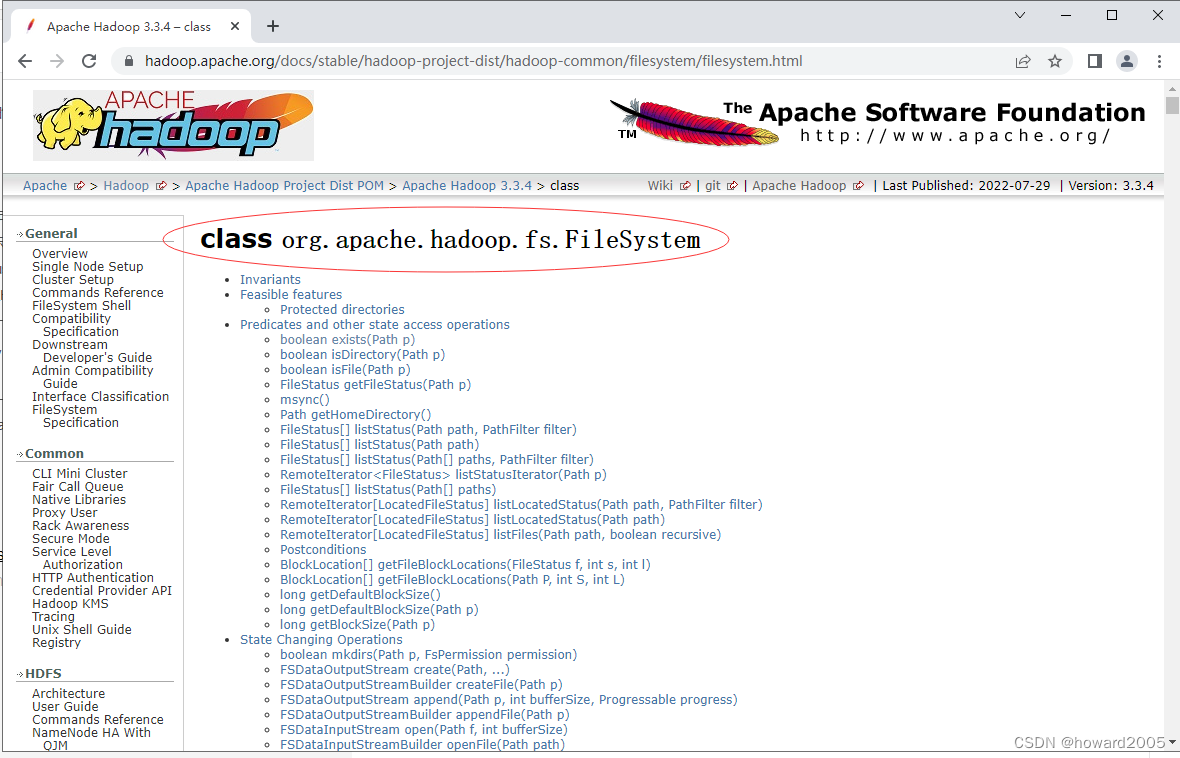

FileSystem类API文档:Apache Hadoop 3.3.4 – class

-

FileSystem对象的一些方法可以对文件进行操作

| 方法名 | 功能描述 |

|---|---|

| copyFromLocalFile(Path src, Path dst) | 从本地磁盘复制文件到HDFS |

| copyToLocalFile(Path src, Path dst) | 从HDFS复制文件到本地磁盘 |

| mkdirs(Path f) | 建立子目录 |

| rename(Path src, Path dst) | 重命名文件或文件夹 |

| delete(Path f) | 删除指定文件 |

(二)编写Java程序访问HDFS

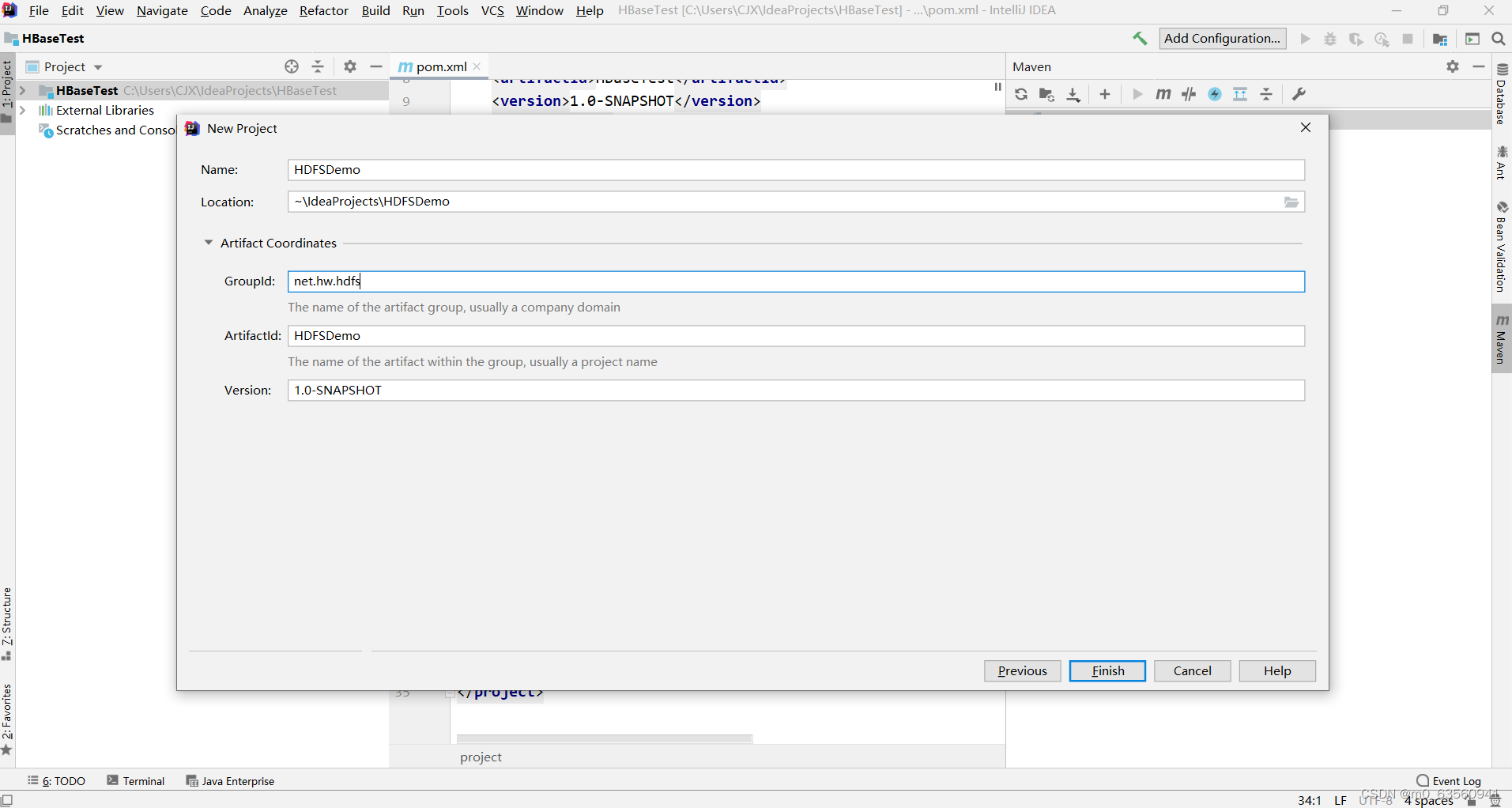

1、创建Maven项目

-

创建Maven项目 - HDFSDemo

-

单击【Finish】按钮

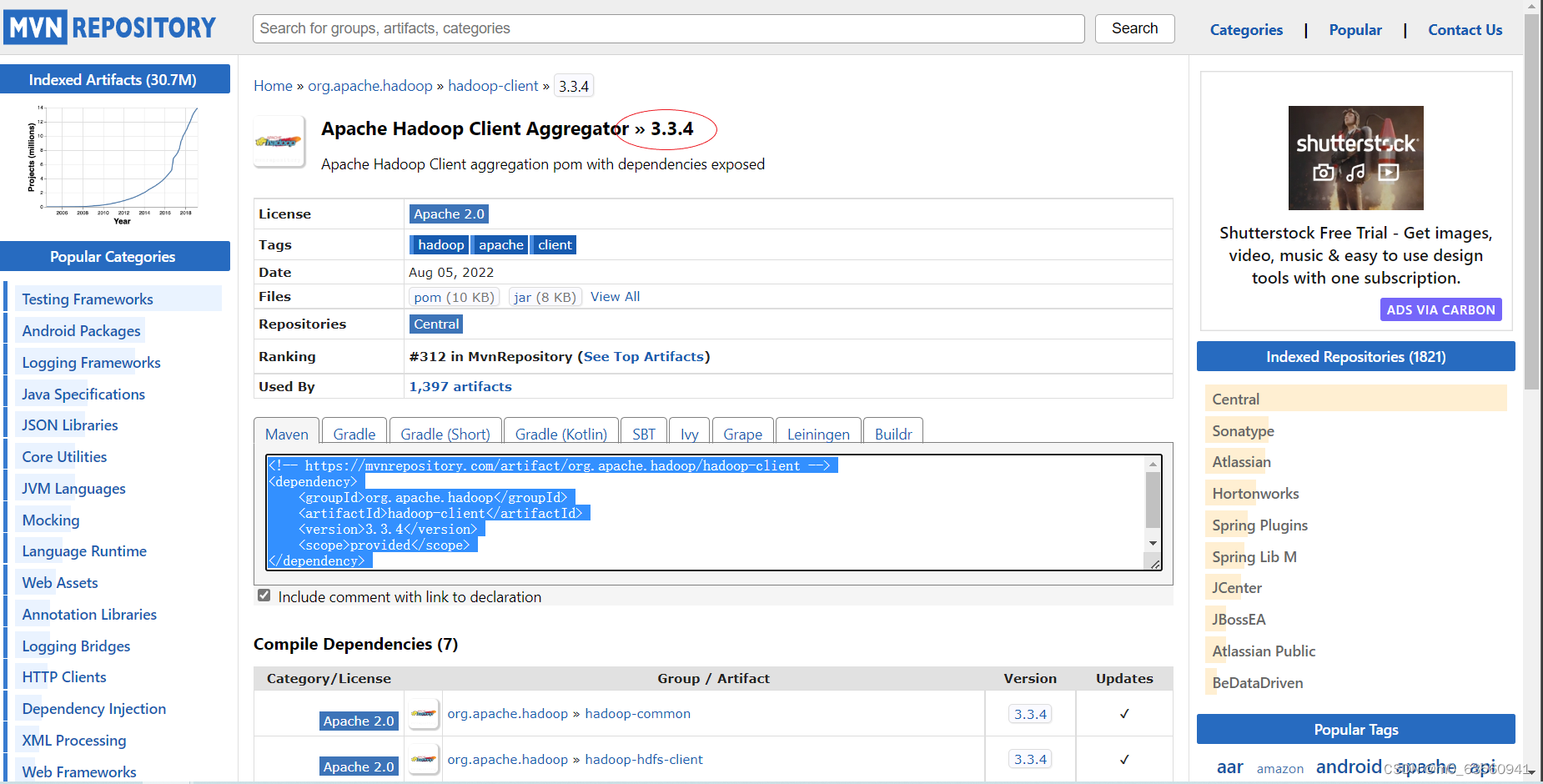

2、添加相关依赖

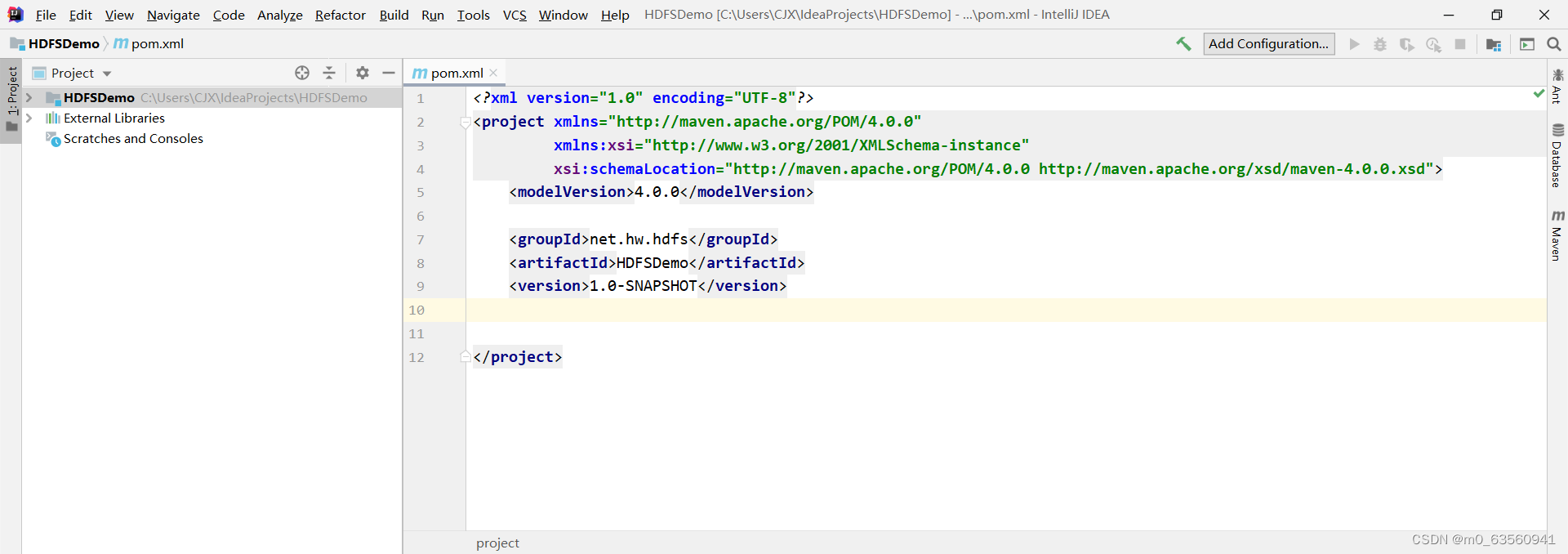

- 在

pom.xml文件里添加hadoop和junit依赖

<dependencies>

<!--hadoop客户端-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

<!--单元测试框架-->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

</dependency>

</dependencies>

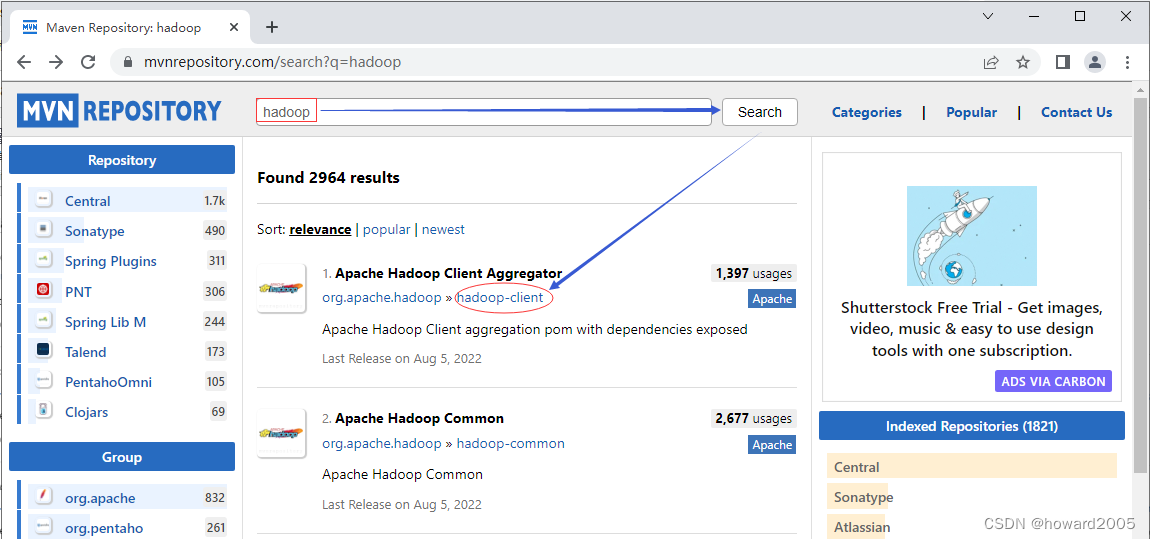

- Maven Repository(Maven仓库)- https://mvnrepository.com/

- 搜索

hadoop - 单击

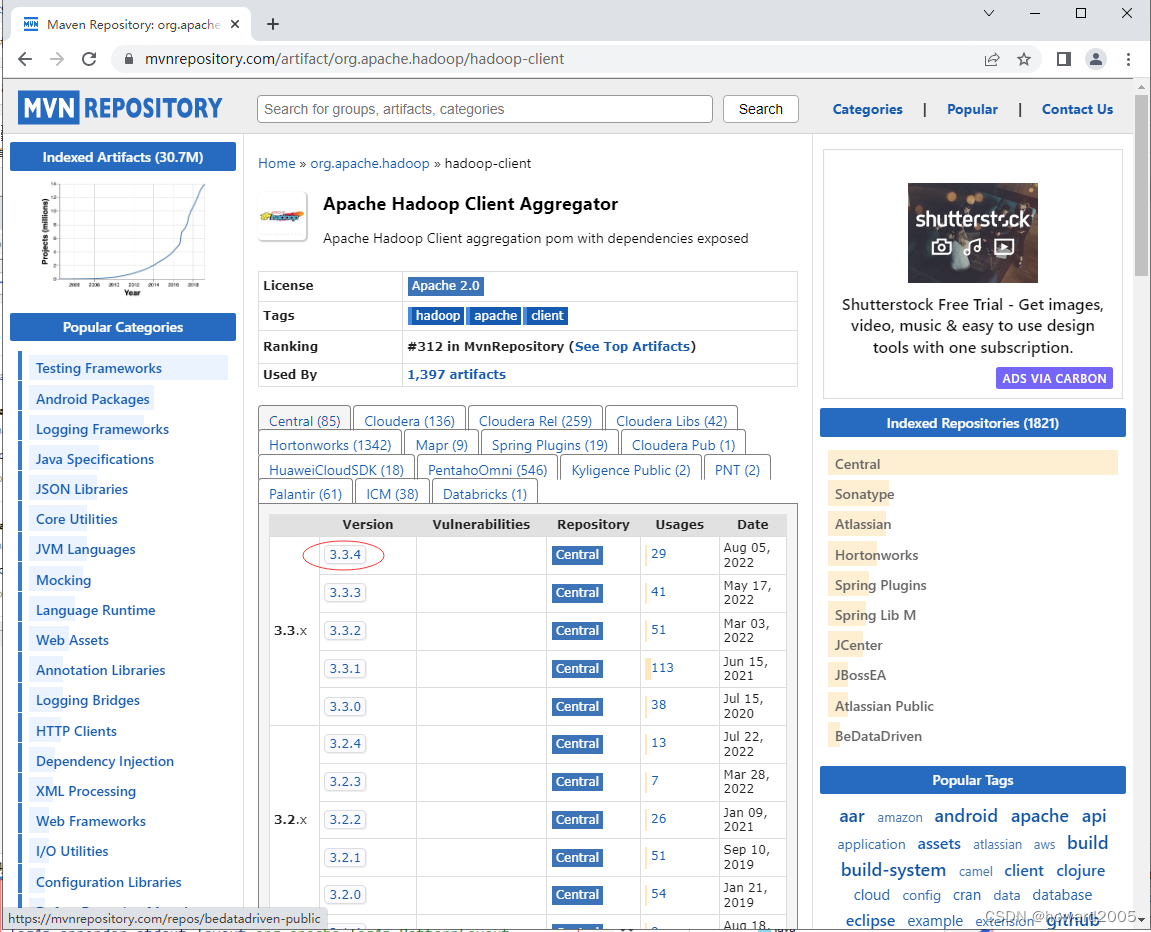

hadoop-client超链接 - 单击

3.3.4超链接

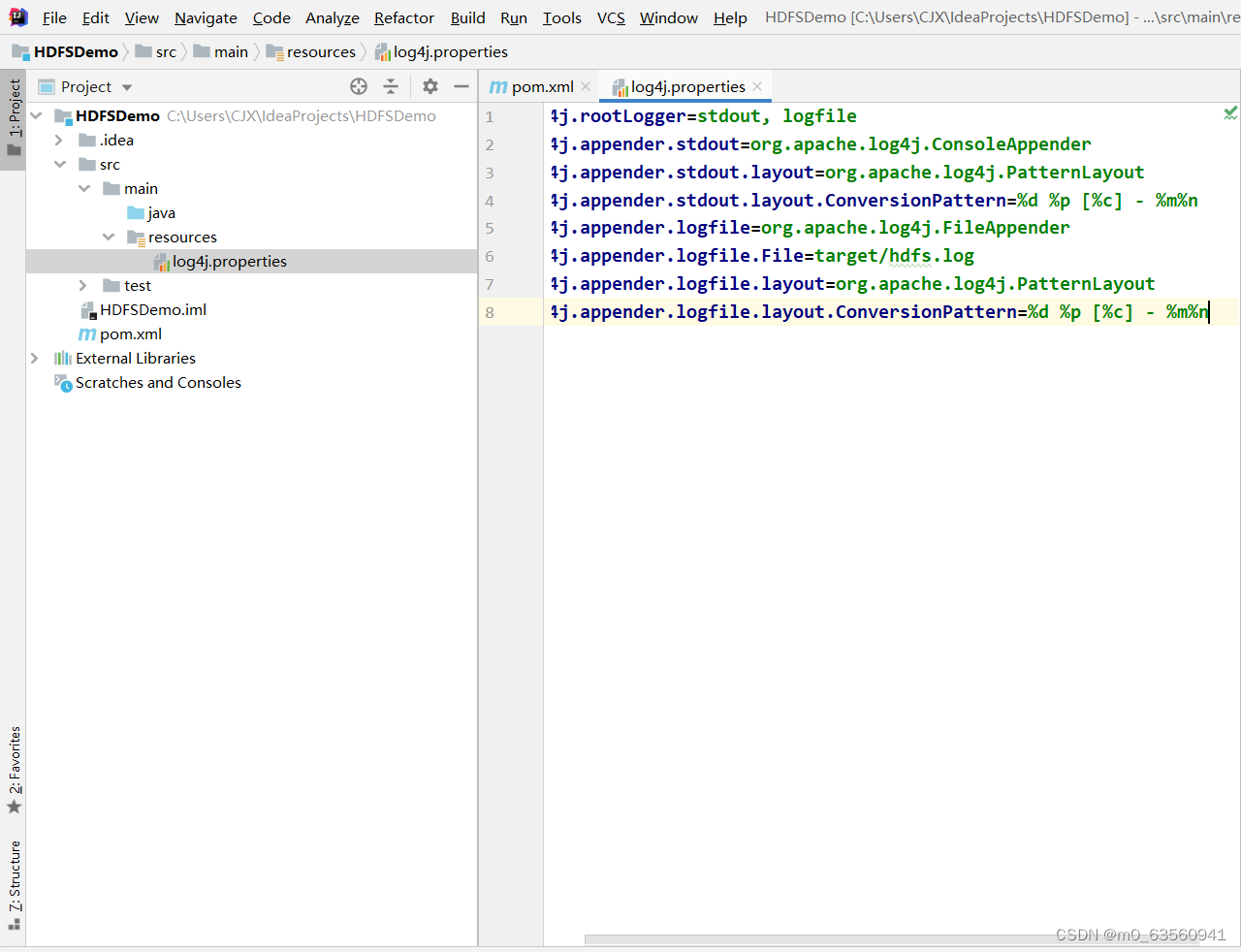

3、创建日志属性文件

- 在

resources目录里创建log4j.properties文件

log4j.rootLogger=stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/hdfs.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

4、启动集群HDFS服务

-

在主节点上执行命令:

start-dfs.sh -

在Hadoop WebUI界面查看