- Arxiv日期:2023.10.24

- 机构:Apple / Mila, Université de Montréal / Tel Aviv University

关键词

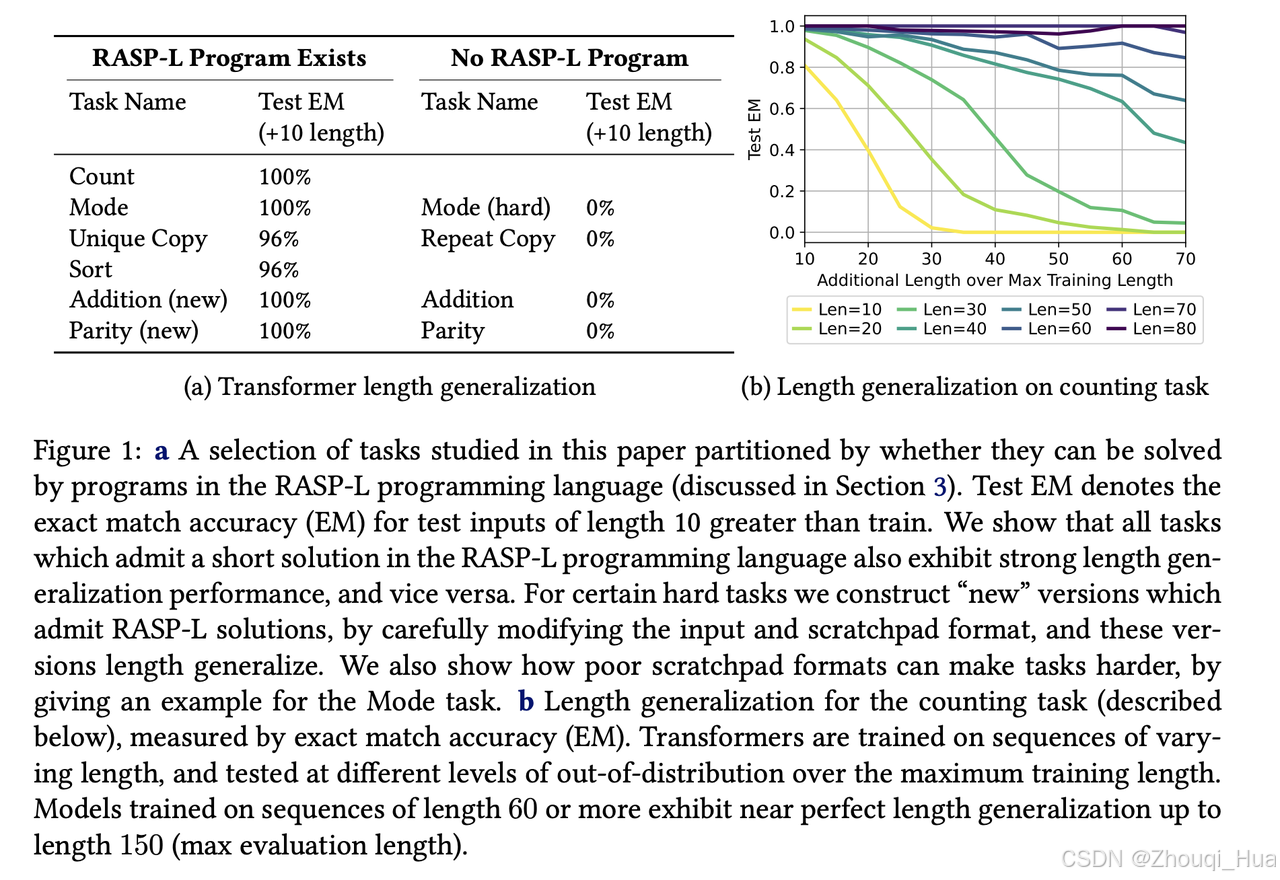

- 长度泛化

- 任务区分

核心结论

1. Transformer可以在简单的、易于学习的算法表示上呈现长度泛化

2. 提出假说 RASP-Generalization Conjecture,认为 Transformer 能够在以下条件下泛化:

-

Simplicity:该表示在 RASP-L 中是简单的

-

diversity:训练数据多样化 -> 避免学习到只适用于训练分布的更短程序

3. (实验结论验证假说)符合假说的任务(例如计数和排序)展示了强大的长度泛化能力,而不符合的任务(例如奇偶性检查和加法)泛化性能较差

4. 通过调整任务的输入和输出格式(例如为加法任务添加索引提示和反向顺序),可以显著降低任务的复杂性并提高泛化能力

5. 增加训练数据的多样性有助于提高 Transformer 对复杂任务的泛化性能

6. (隐式偏差)Transformer 倾向于学习简单的、易于表示的算法。RASP-L 提供了一种衡量这种简单性的框架

主要方法

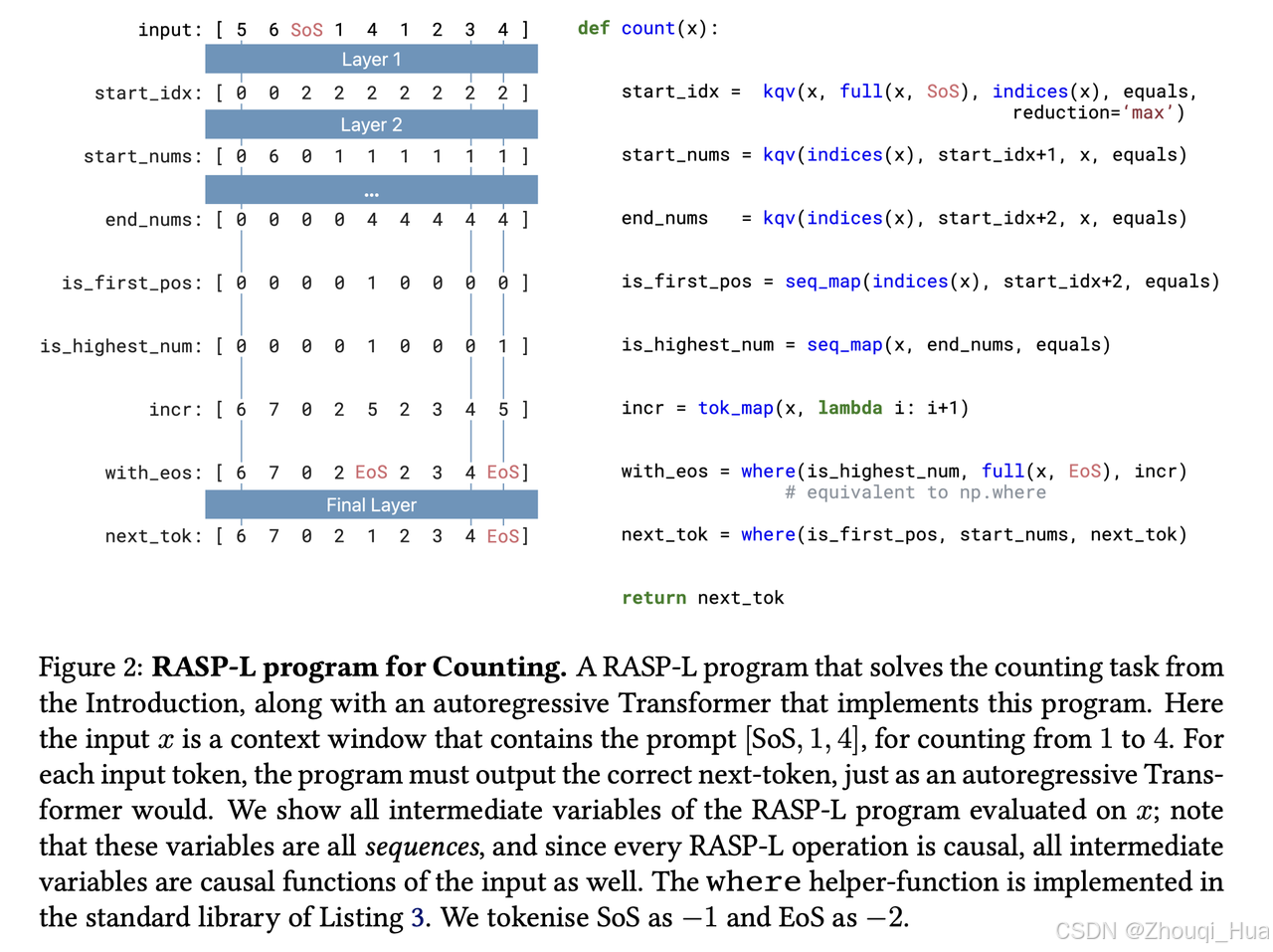

研究内容:探讨 Transformer 模型在算法任务上的长度泛化能力,即模型在训练集长度范围之外的任务表现

引入了一种面向 Transformer 的编程语言(RASP),用于描述 Transformer 能轻松表达的算法。将 RASP 进一步限制为 RASP-L,用以定义简单的、易于学习的算法表示。

可以参考讲解视频:https://www.youtube.com/watch?v=koo5Bo0k9Wc

注:本系列不包括基础的知识点讲解,为笔记/大纲性质而非教程,用于论文知识点和思想和快速记忆和回顾,更多细节建议阅读论文原文