- Arxiv日期:2023.12.15

- 机构:McGill University / IBM / Facebook / ServiceNow

关键词

- 长度泛化

- 位置编码

- CoT

核心结论

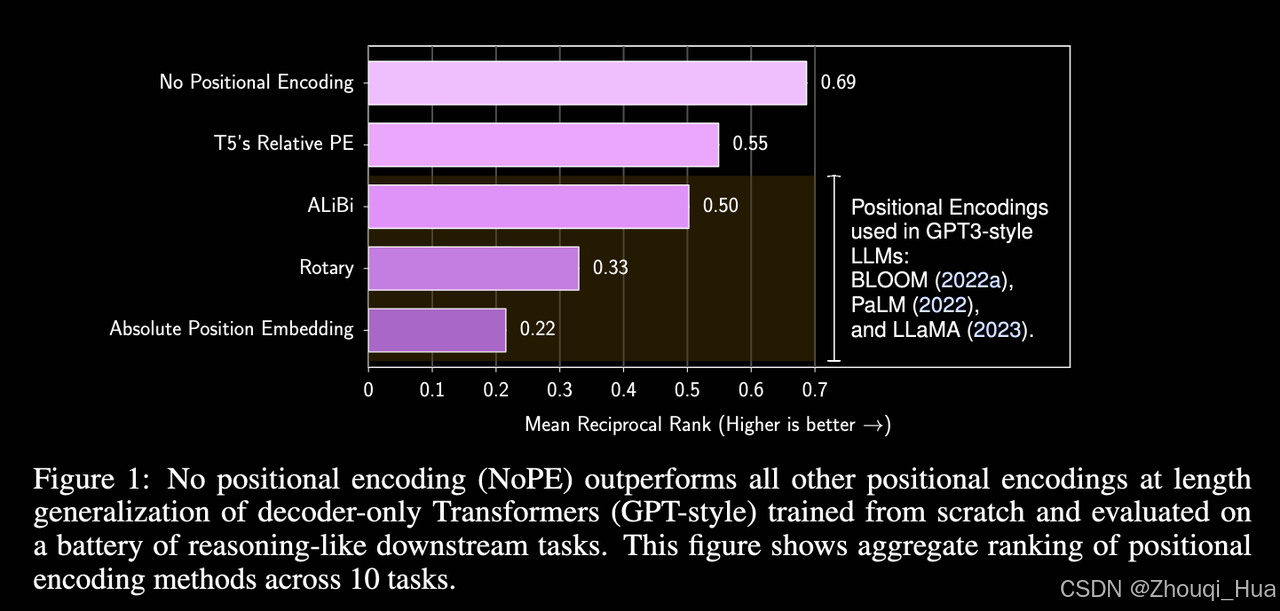

1. decoder-only 中不显式使用位置编码(NoPE)可以提高长度泛化性能

2. (证明了)decoder-only transformer 如果NoPE同时具备绝对APE和RPE的能力

3. 暂存器(cot)对于长度泛化和任务相关,同时关注短期和长期信息效益更显著

主要方法

主要关注decoder-only transformer中的长度泛化能力

NoPE效果最佳

-

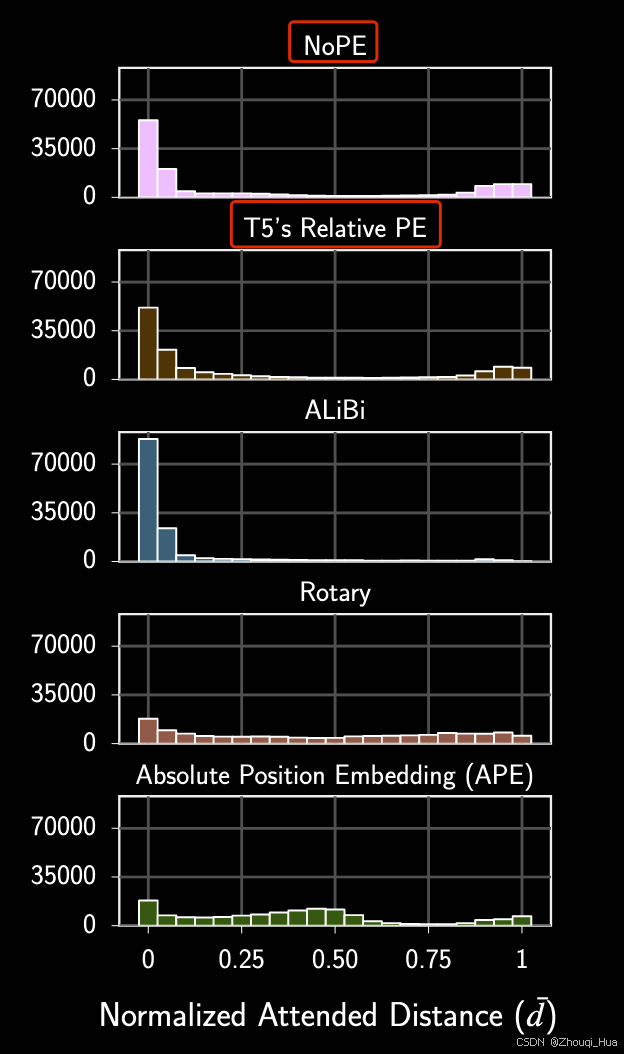

第一个注意力子层可以实现绝对位置编码的能力

-

后面的注意力子层可以实现相对位置编码的能力(f_con+f_ref)

-

提出推测NoPE模型可以自行选择相对/绝对

观察到在所有 PE 中,无论格式如何,暂存器仅对加法任务有益。且关注位置双峰分布的PE(同时关注短期和长期信息)可以显著提高增益

注:本系列不包括基础的知识点讲解,为笔记/大纲性质而非教程,用于论文知识点和思想和快速记忆和回顾,更多细节建议阅读论文原文