- Arxiv日期:2024.6.2

- 机构:SJTU / Alibaba

关键词

- 推理方法

- 元认知推理

核心结论

1. 神经符号方法拓展

-

神经符号方法展示了在增强LLM推理能力方面的潜力

-

传统的符号方法通常依赖于将自然语言转换为程序化的正式语言(如 Python 或 SQL),但这类方法限制了推理任务的多样性和适用性

-

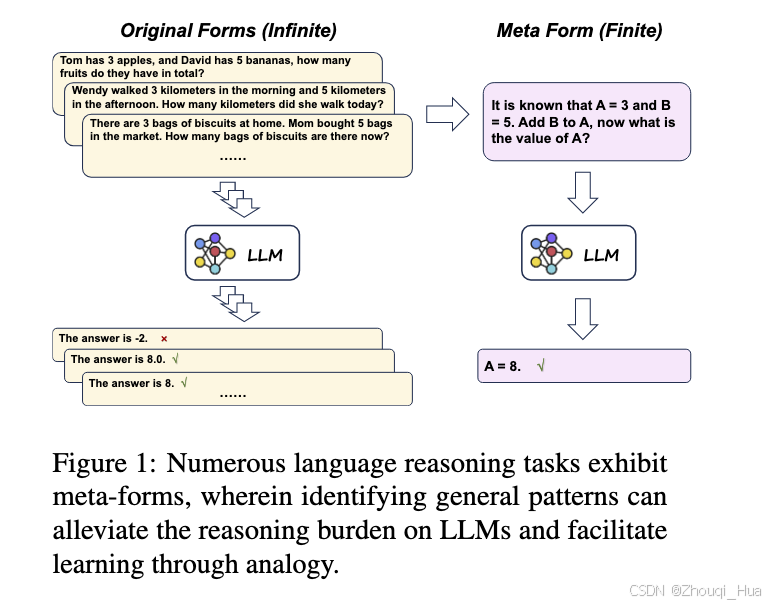

本文提出的 Meta-Reasoning 在此基础上扩展了神经符号方法的适用范围,旨在通过符号化处理,使 LLMs 能够更灵活地处理各种类型的推理任务

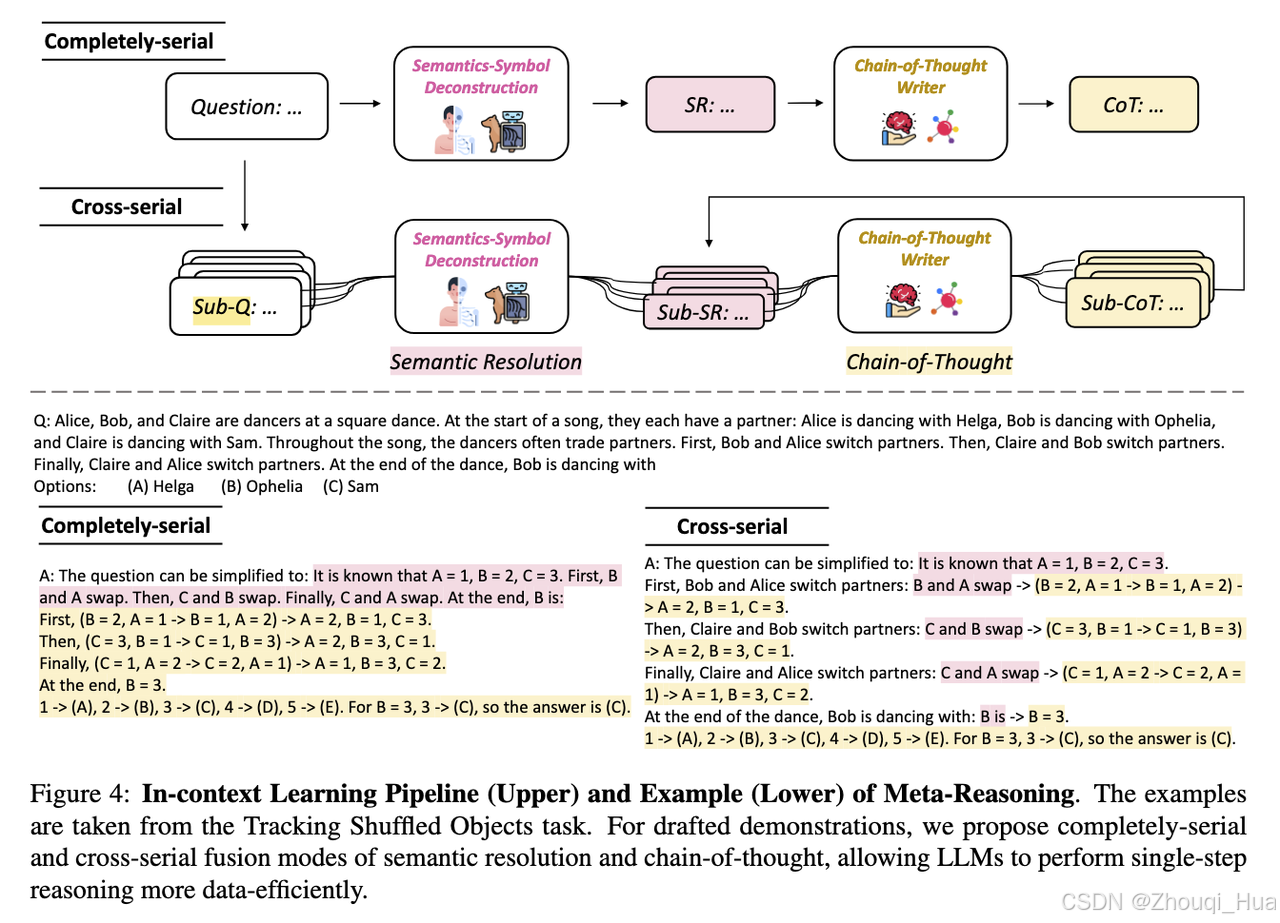

2. 通过语义符号解构,可以减少语言之间的差异,帮助 LLMs 在多语种、复杂语义及不确定任务中提升推理准确性和稳定性(模型能够抽象化不同任务的共同推理结构,从而提高了跨领域和跨语义任务的推理能力)

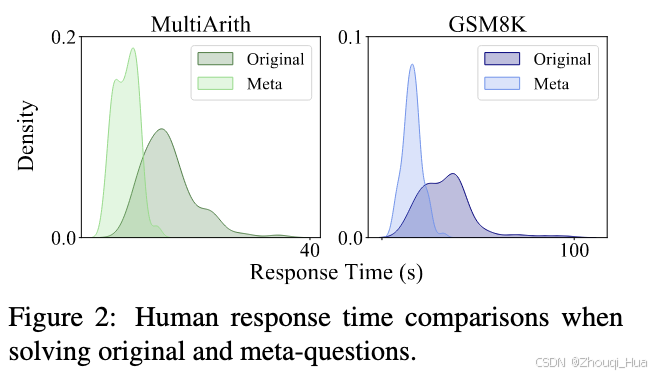

3. 通过对复杂推理任务进行语义解析和符号化,推理的过程得到了简化(简化后的问题模型能够帮助 LLMs 更快地识别推理模式和结构,提高推理速度)

4. 通过符号化简化任务,LLMs 能够通过更少的学习示例来掌握推理任务,提高了模型的学习效率和普适性

5. Meta-Reasoning 方法能够显著提高 LLMs 在复杂任务中的稳定性(减少异常和无意义输出的概率)

6. 算术任务中的错误通常是由于语义解析不准确导致,而符号推理和逻辑推理任务中的错误则更多来源于推理过程中的误差

主要方法

提出将自然语言问题形式化的方法 Meta-Reasoning:

分析了人类在解决传统推理问题和符号推理问题时的处理速度:

提出将传统自然语言描述的推理问题使用符号表示,分为 Entity 和 Operation 两种表示。

分为两种穿插的元推理方法:

注:本系列不包括基础的知识点讲解,为笔记/大纲性质而非教程,用于论文知识点和思想和快速记忆和回顾,更多细节建议阅读论文原文