大模型应用中什么是IFT(指令微调)?

背景

随着人工智能技术的发展,特别是自然语言处理(NLP)领域的进步,预训练语言模型(如GPT-3、BERT)已经展现出了强大的语言理解和生成能力。这些模型通常通过在大规模文本数据上进行预训练来学习语言的基本结构和语义。然而,这些预训练模型在具体任务中的表现往往需要进一步的微调(Fine-Tuning)来提升其在特定任务上的效果。

Instruction Fine-Tuning 是一种特别的微调技术,它通过为模型提供明确的指令来引导模型在特定任务上的表现。这种方法不仅可以提升模型的准确性,还能使模型更加容易理解和执行复杂的任务。

原理

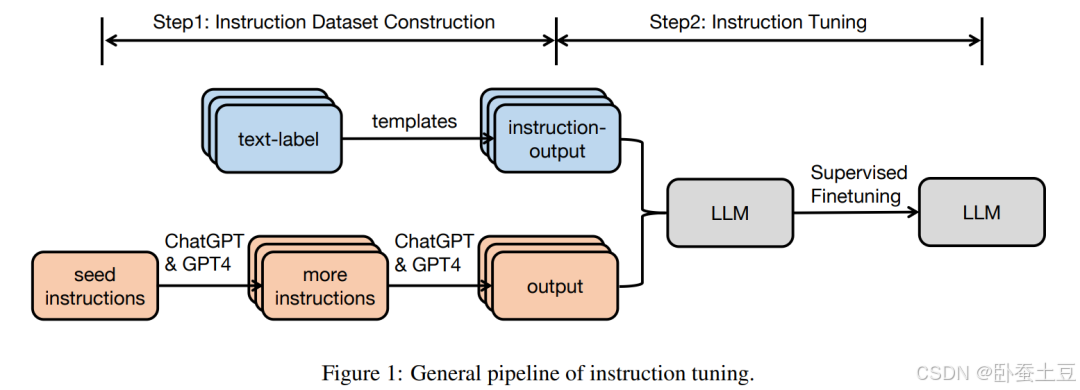

Instruction Fine-Tuning 的核心思想是通过提供明确的指令(Instructions)来微调预训练模型,使其能够更好地执行特定任务。这些指令通常以自然语言的形式给出,描述了任务的具体要求和期望的输出格式。模型通过学习这些指令,能够更准确地理解任务并生成符合要求的结果。

步骤

- 预训练(Pre-training): 在大规模文本数据上训练语言模型,使其学习语言的基本结构和语义。

- 指令微调(Instruction Fine-Tuning): 为模型提供特定任务的指令,并在相关数据集上进行微调,使模型能够更好地理解和执行这些指令。

- 任务执行(Task Execution): 在给定任务上应用微调后的模型,生成符合指令要求的结果。

公式

设预训练语言模型为 M θ M_{\theta} Mθ,指令为 I I I,任务输入为 x x x,期望的输出为 y y y。指令微调的目标是通过最小化以下损失函数来调整模型参数 θ \theta θ:

L ( θ ) = E ( x , y ) ∼ D [ ℓ ( M θ ( I , x ) , y ) ] \mathcal{L}(\theta) = \mathbb{E}_{(x, y) \sim D} [\ell(M_{\theta}(I, x), y)] L(θ)=E(x,y)∼D[ℓ(Mθ(I,x),y)]

其中, ℓ \ell ℓ 是损失函数(例如交叉熵损失), D D D 是训练数据集。

优势

Instruction Fine-Tuning 的主要优势在于:

- 提高准确性: 通过明确的指令,模型可以更准确地理解任务要求,生成更符合预期的结果。

- 增强灵活性: 模型能够根据不同的指令适应多种任务,具备更强的泛化能力。

- 简化训练过程: 使用自然语言指令可以减少任务描述的复杂度,使模型更容易训练和使用。

应用实例

示例1:文本分类

假设我们有一个文本分类任务,要将输入文本分类为“正面”或“负面”。传统的微调方法可能需要手动设计特征或标签,而 Instruction Fine-Tuning 只需提供指令:

指令: “请将以下文本分类为正面或负面。”

输入文本: “这个产品真的很好,我非常满意。”

通过 Instruction Fine-Tuning 微调后的模型能够直接生成分类结果:

输出: “正面”

示例2:文本摘要

在文本摘要任务中,我们希望模型能生成给定文章的简短摘要。使用指令可以简化这一过程:

指令: “请为以下文章生成一个简短的摘要。”

输入文章: “人工智能技术正在迅速发展,特别是在自然语言处理领域…”

通过微调后的模型可以生成符合要求的摘要:

输出摘要: “人工智能技术在自然语言处理领域迅速发展。”

代码示例

以下是一个简单的 Instruction Fine-Tuning 代码示例,使用 Hugging Face 的 Transformers 库:

from transformers import GPT2LMHeadModel, GPT2Tokenizer, Trainer, TrainingArguments

import torch

# 加载预训练模型和分词器

model = GPT2LMHeadModel.from_pretrained('gpt2')

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

# 定义指令和训练数据

instruction = "请将以下文本分类为正面或负面。"

texts = ["这个产品真的很好,我非常满意。", "这个产品很糟糕,我非常失望。"]

labels = ["正面", "负面"]

# 准备训练数据

train_data = [{"input_text": instruction + text, "label": label} for text, label in zip(texts, labels)]

# 训练参数设置

training_args = TrainingArguments(

output_dir='./results',

num_train_epochs=3,

per_device_train_batch_size=2,

save_steps=10,

save_total_limit=2,

)

# 自定义数据集

class CustomDataset(torch.utils.data.Dataset):

def __init__(self, tokenizer, data):

self.tokenizer = tokenizer

self.data = data

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

item = self.data[idx]

inputs = self.tokenizer(item['input_text'], return_tensors="pt")

labels = self.tokenizer(item['label'], return_tensors="pt")["input_ids"]

return {"input_ids": inputs["input_ids"].squeeze(), "labels": labels.squeeze()}

# 创建数据集

train_dataset = CustomDataset(tokenizer, train_data)

# 创建Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset

)

# 开始训练

trainer.train()

通过上述代码,我们可以看到 Instruction Fine-Tuning 如何通过简单的指令来微调预训练模型,并提升其在具体任务上的表现。

高级技巧

为了进一步提升 Instruction Fine-Tuning 的效果,可以采用一些高级技巧和策略:

1. 多样化指令

为模型提供多样化的指令可以增强模型的泛化能力。例如,对于同一个任务,可以提供不同表述方式的指令:

instructions = [

"请将以下文本分类为正面或负面。",

"请判断以下文本是正面的还是负面的。",

"请告诉我以下文本的情感倾向,是正面还是负面?"

]

2. 数据增强

通过数据增强技术可以生成更多的训练数据,从而提高模型的鲁棒性。例如,可以对原始数据进行同义词替换、随机插入噪声等操作。

def synonym_replacement(text):

# 这里可以使用同义词库进行替换

return text.replace("好", "不错").replace("糟糕", "差劲")

augmented_texts = [synonym_replacement(text) for text in texts]

augmented_train_data = [{"input_text": instruction + text, "label": label} for text, label in zip(augmented_texts, labels)]

3. 模型集成

可以使用多个模型进行集成,通过组合多个模型的输出结果来提升最终性能。这种方法特别适用于任务难度较高的场景。

from transformers import AutoModelForSequenceClassification, AutoTokenizer

import torch

# 加载多个模型

model1 = AutoModelForSequenceClassification.from_pretrained('model1')

model2 = AutoModelForSequenceClassification.from_pretrained('model2')

tokenizer1 = AutoTokenizer.from_pretrained('model1')

tokenizer2 = AutoTokenizer.from_pretrained('model2')

def predict(text):

inputs1 = tokenizer1(text, return_tensors="pt")

inputs2 = tokenizer2(text, return_tensors="pt")

outputs1 = model1(**inputs1)

outputs2 = model2(**inputs2)

# 简单平均集成

final_output = (outputs1.logits + outputs2.logits) / 2

return torch.argmax(final_output, dim=1).item()

# 预测示例

text = "这个产品真的很好,我非常满意。"

label = predict(text)

print("预测结果:", "正面" if label == 1 else "负面")

4. 任务调度与分级

对于复杂任务,可以将其拆分为多个子任务,分别进行微调,然后将各子任务的结果进行整合。例如,对于文本生成任务,可以首先进行主题识别,然后生成大纲,最后生成详细内容。

# 子任务1:主题识别

instruction1 = "请识别以下文本的主要主题。"

# 子任务2:生成大纲

instruction2 = "根据以下主题生成大纲。"

# 子任务3:生成详细内容

instruction3 = "根据以下大纲生成详细内容。"

# 微调模型和执行子任务的代码略

总结

Instruction Fine-Tuning 作为一种新兴的微调方法,通过自然语言指令来引导模型在特定任务上的表现。其主要优势在于提高准确性、增强灵活性和简化训练过程。在实际应用中,通过明确的指令,我们可以更容易地让模型执行复杂任务,从而大大提升人工智能系统的实用性和可靠性。通过结合多样化指令、数据增强、模型集成和任务调度等高级技巧,Instruction Fine 的效果可以得到进一步提升。