博主介绍:✌全网粉丝10W+,前互联网大厂软件研发、集结硕博英豪成立工作室。专注于计算机相关专业项目实战6年之久,选择我们就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅🍅感兴趣的可以先收藏起来,点赞、关注不迷路,大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助同学们顺利毕业 。🍅

1、毕业设计:2025年计算机专业毕业设计选题汇总(建议收藏)✅

2、大数据毕业设计:2025年选题大全 深度学习 python语言 JAVA语言 hadoop和spark(建议收藏)✅

1、项目介绍

技术栈:

python语言、flask框架、Pyecharts、MySQL数据库、requests爬虫技术

2、项目界面

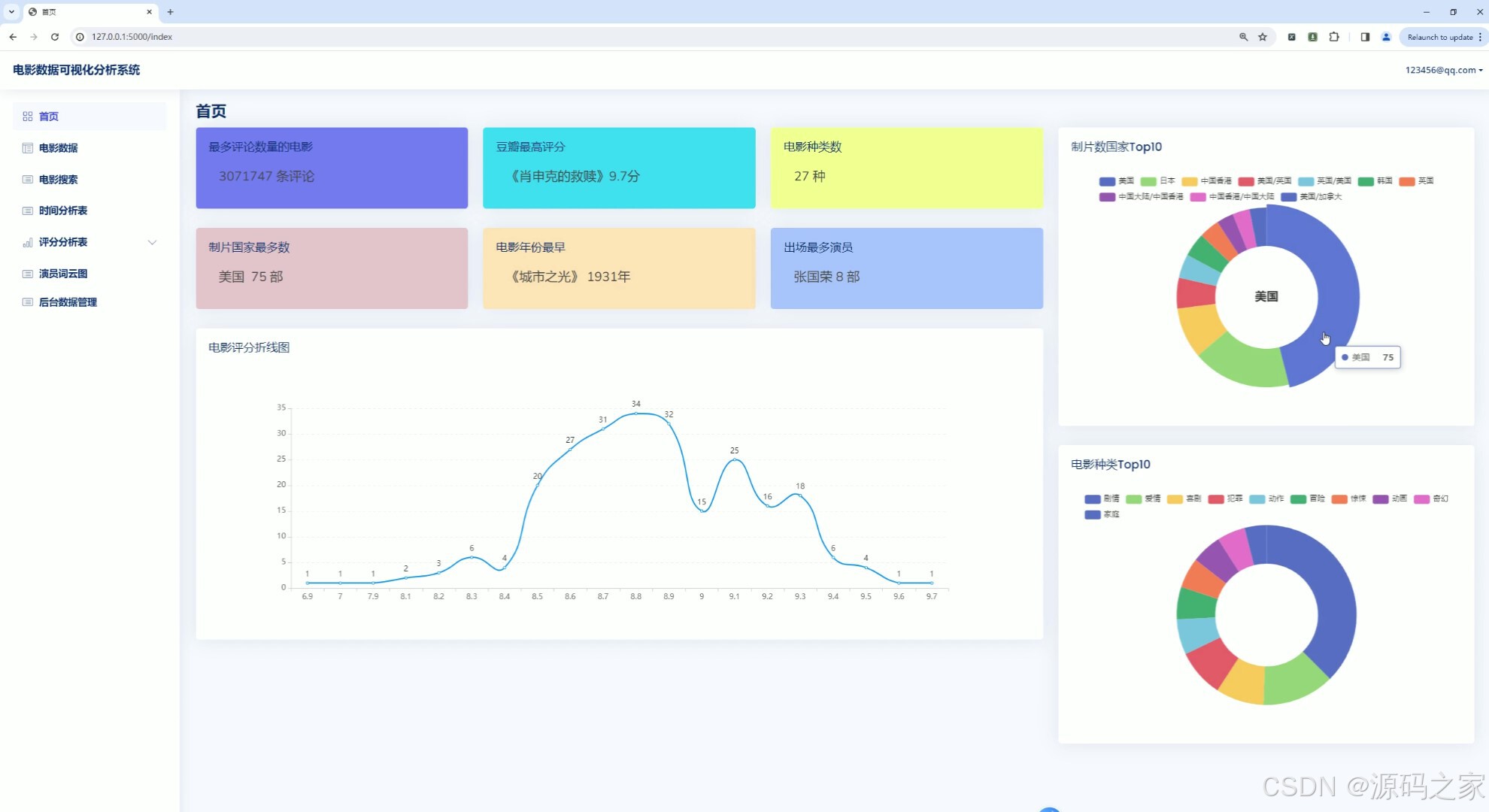

(1)首页—电影数据分析概况

(2)电影数据中心

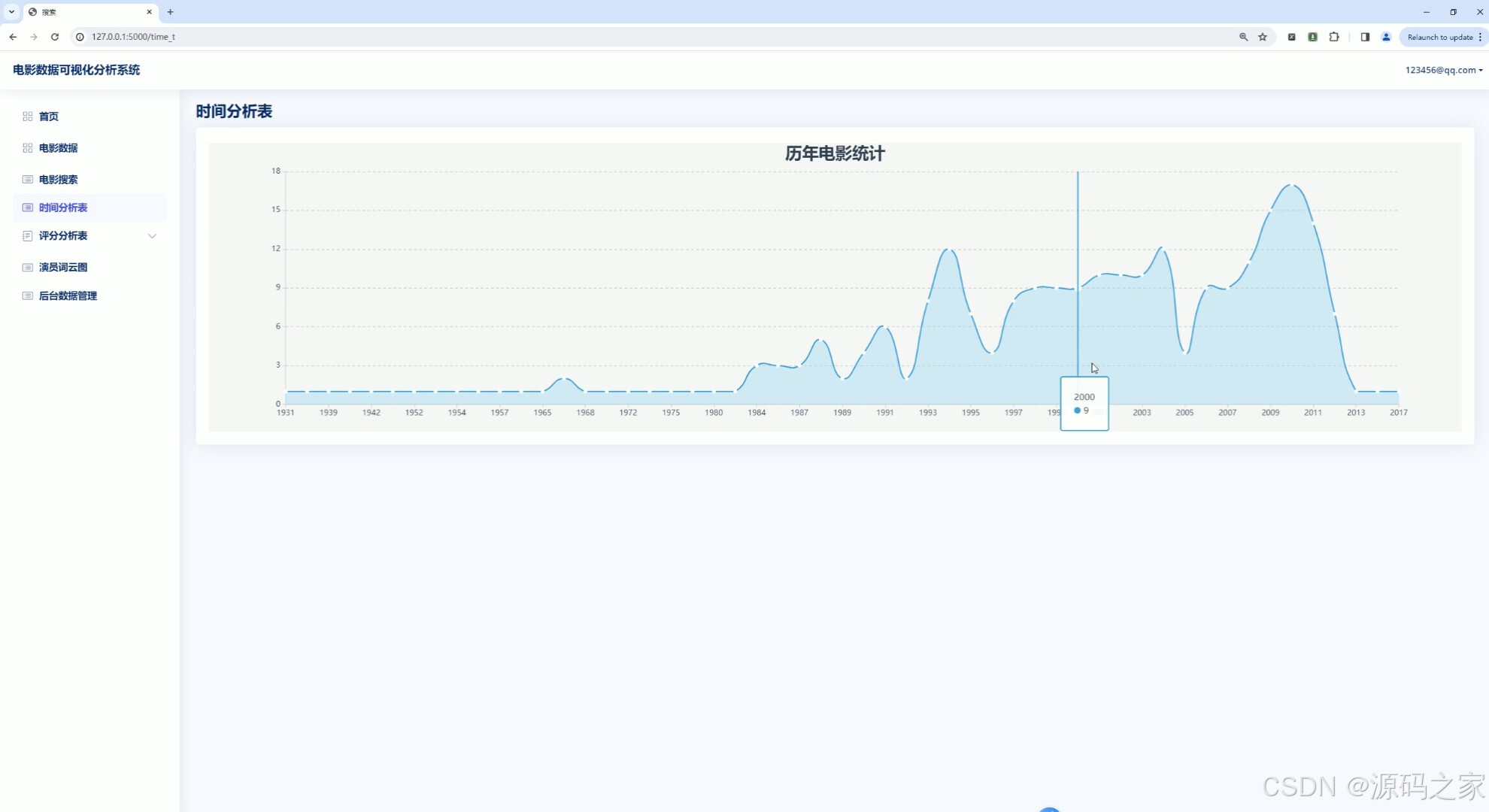

(3)电影时间分析

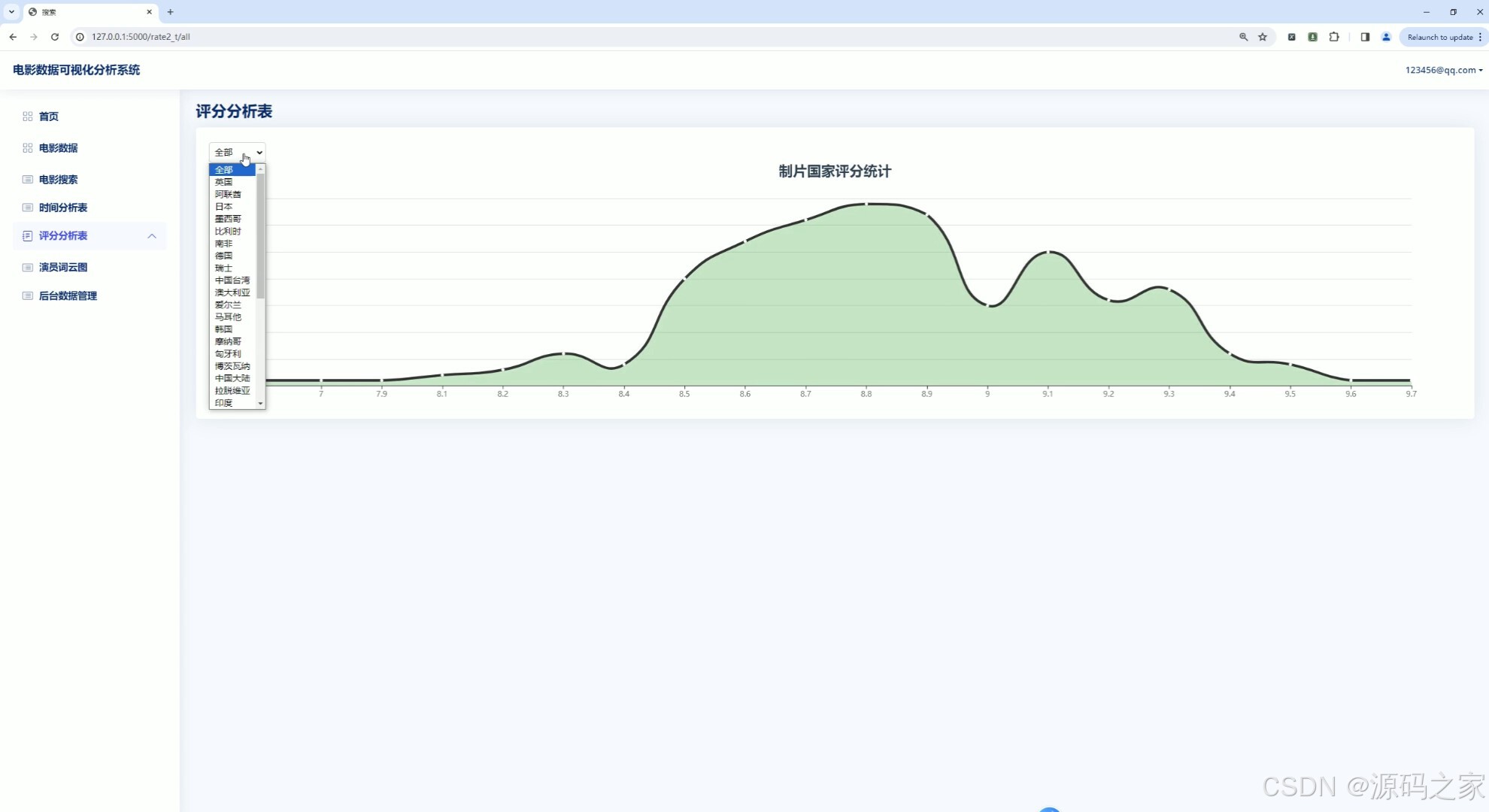

(4)电影制片国家维度—评分数据分析

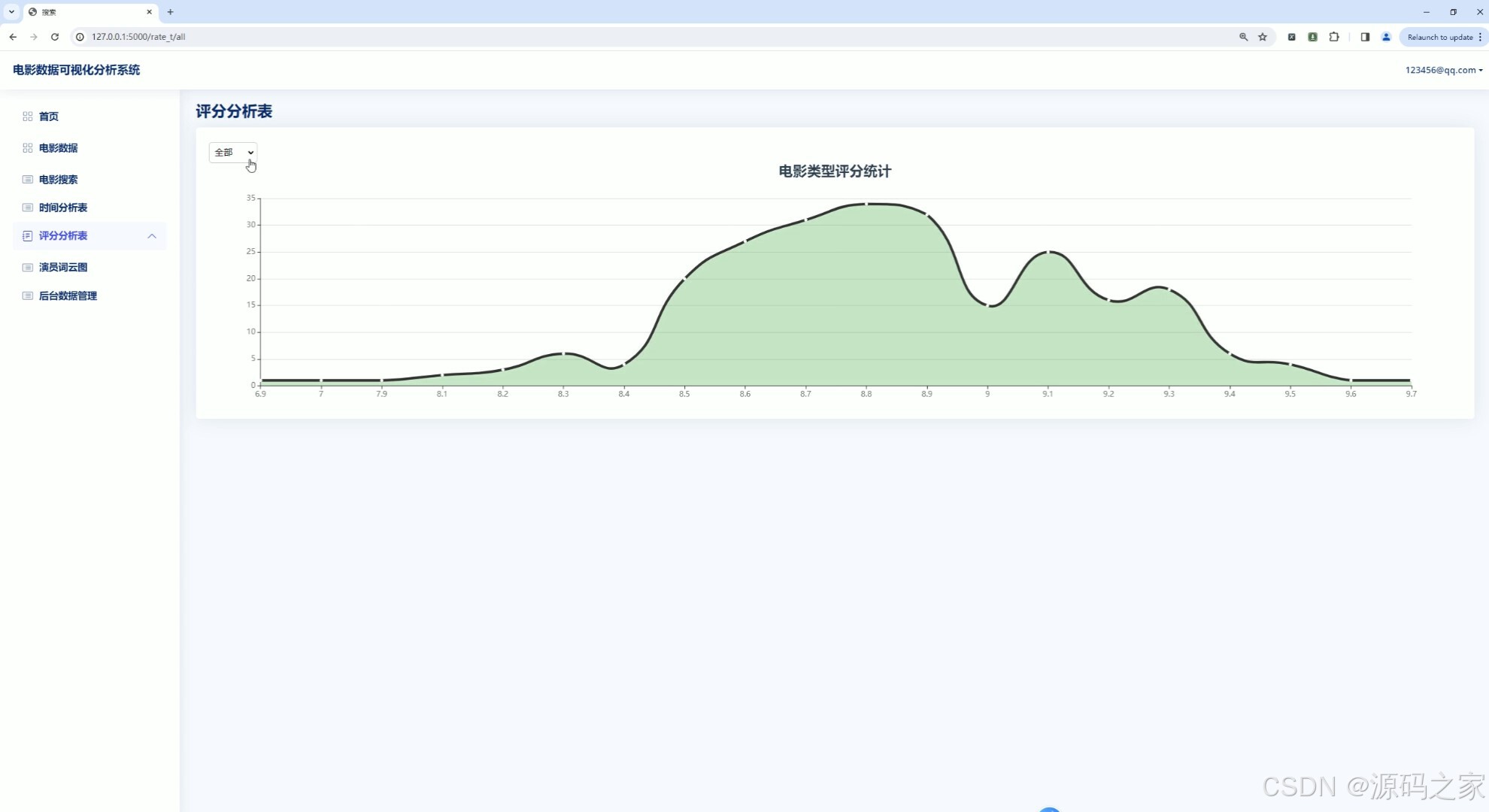

(5)电影类型维度—评分数据分析

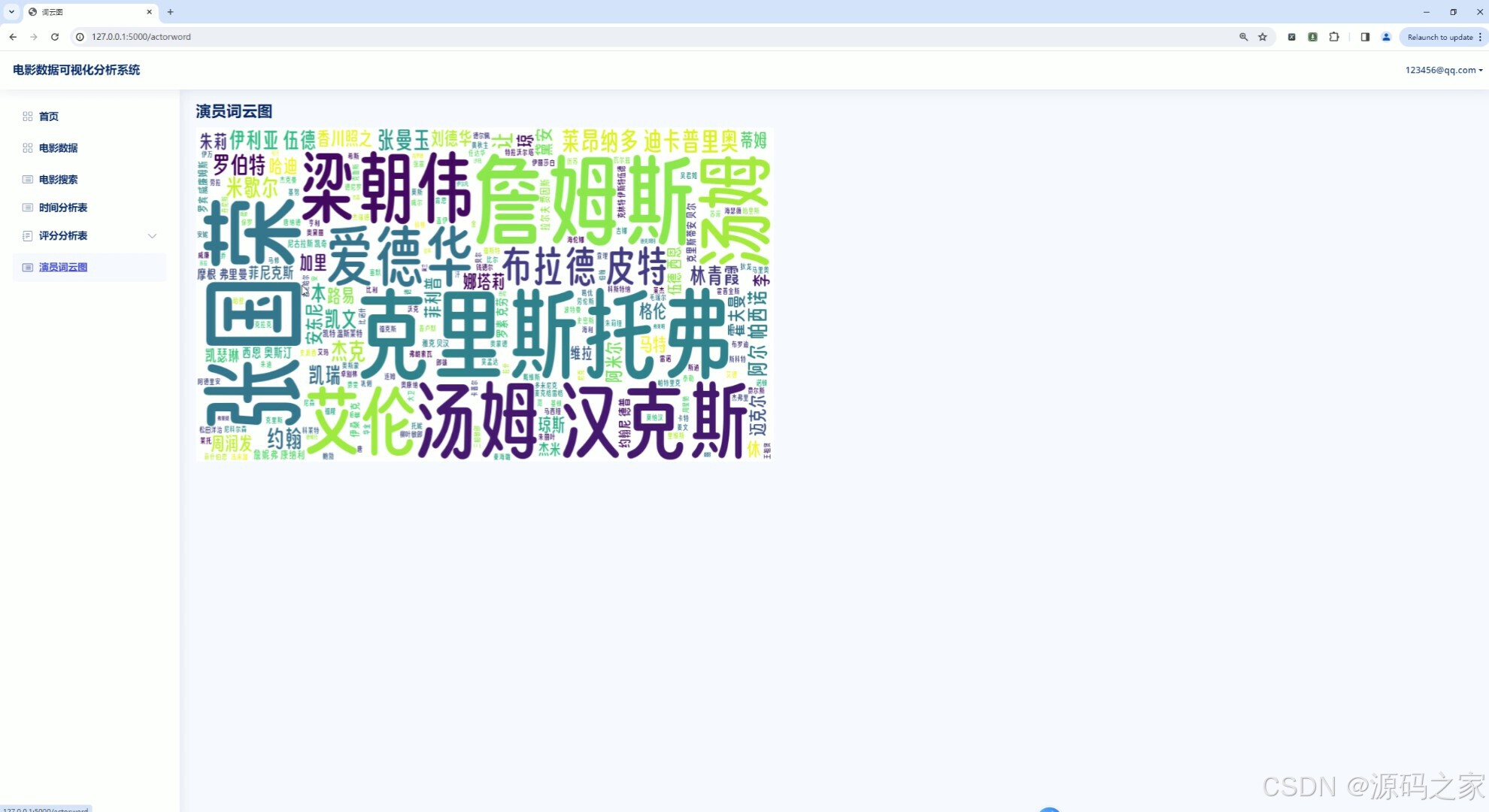

(6)电影演员词云图分析

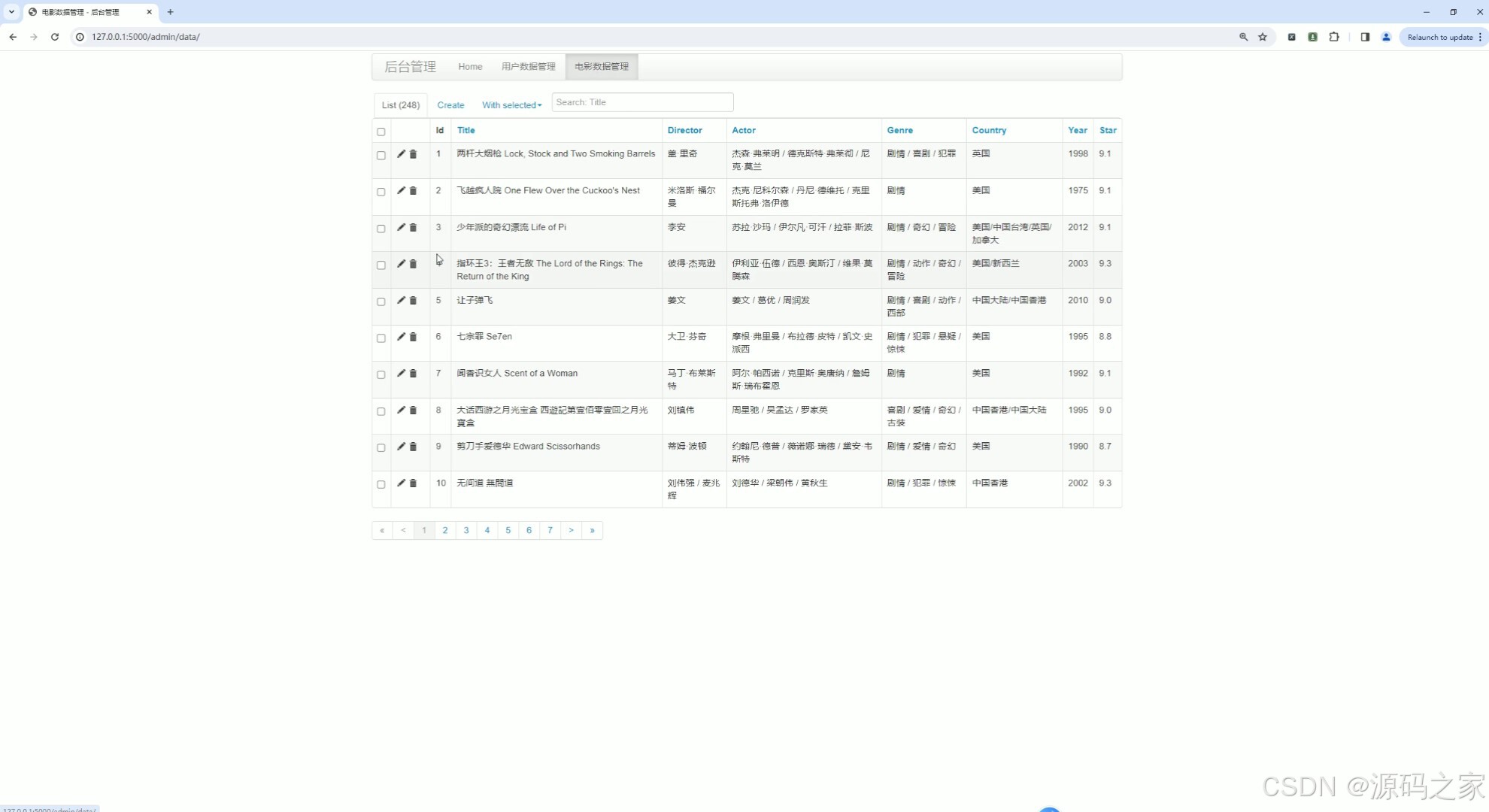

(7)后台数据管理

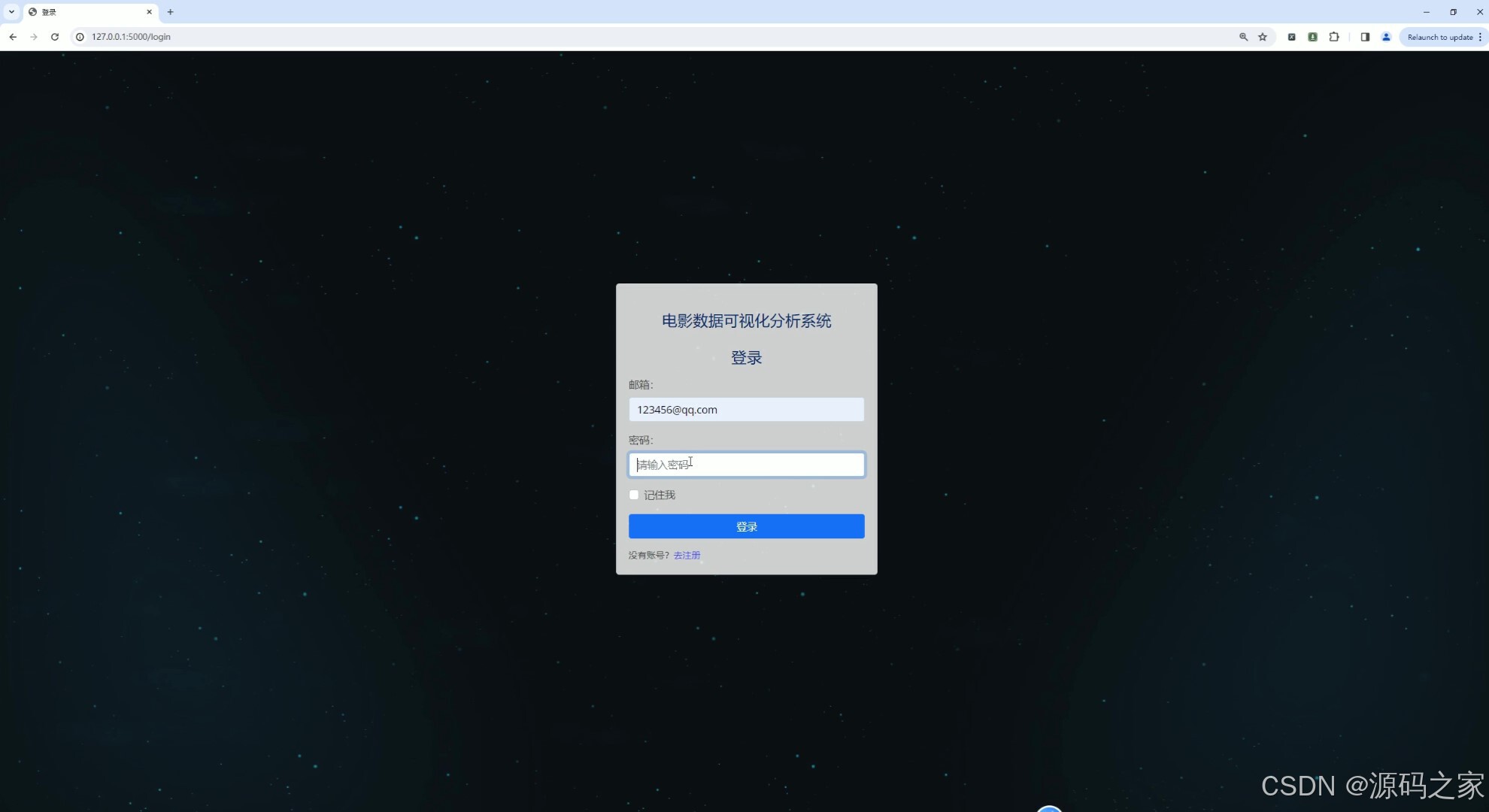

(8)注册登录界面

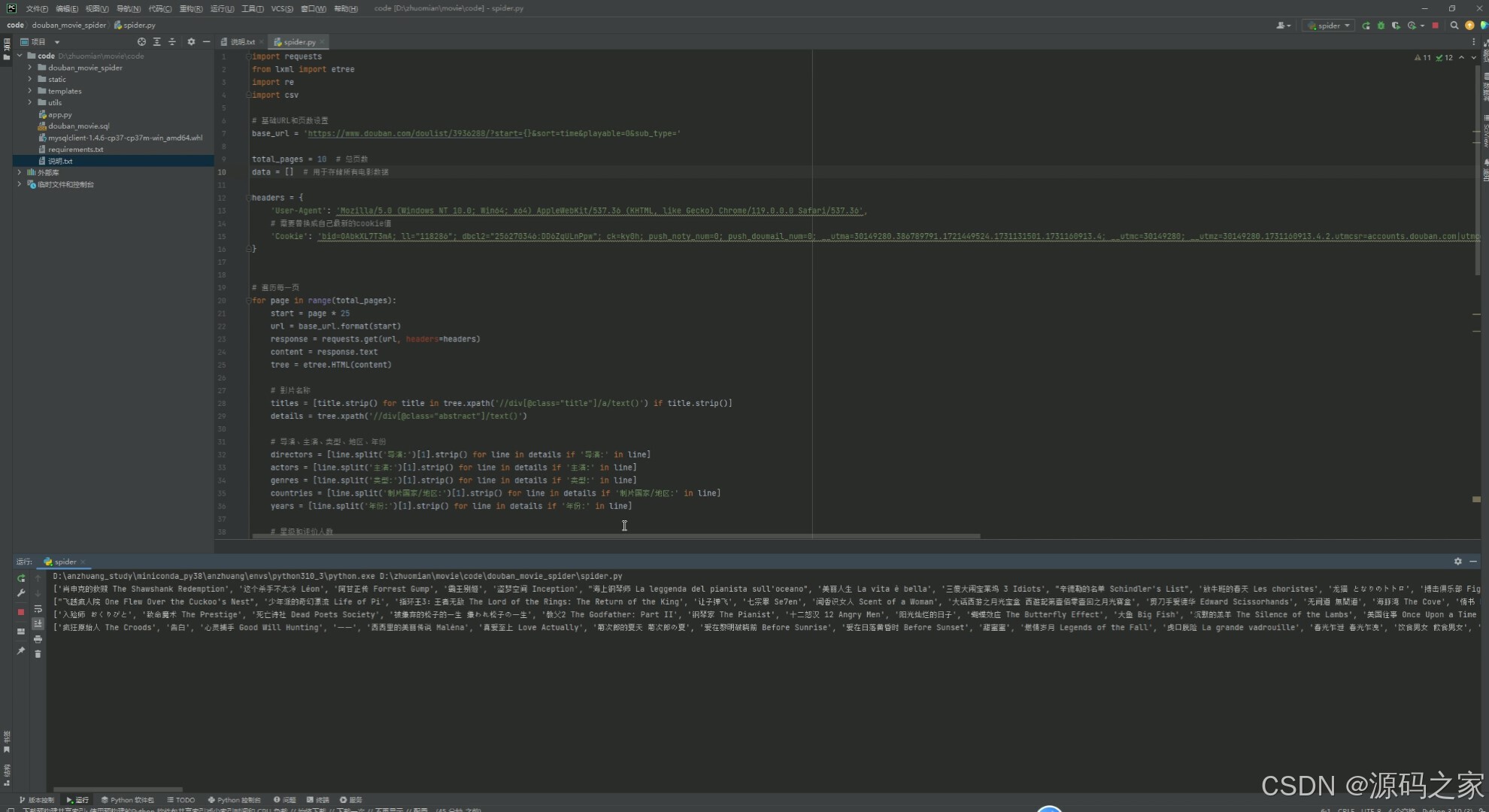

(9)电影数据爬取

3、项目说明

在当今信息化社会,数据已成为各行各业决策的重要依据。特别是在电影行业,通过对电影数据的深入分析,可以揭示出观众喜好、市场趋势以及电影本身的特性,为电影制作、发行和营销提供有力支持。基于此,我们设计并开发了一个基于Python语言及其相关技术栈的豆瓣电影数据分析系统。该系统集成了多个功能模块,旨在为用户提供全面、直观的电影数据分析服务。

技术栈概述

本系统主要采用了以下技术栈:

Python语言:作为数据处理和爬虫开发的强大工具,Python以其简洁的语法和丰富的库支持,成为本项目的核心语言。

Flask框架:一个轻量级的Web应用框架,用于构建用户友好的Web界面,提供数据查询和可视化展示功能。

Pyecharts可视化库:基于Python的开源可视化库,提供多种图表类型,如柱状图、饼图、词云图等,用于直观展示电影数据。

MySQL数据库:作为关系型数据库管理系统,MySQL提供高效的数据存储和查询功能,满足项目对大量电影数据的存储需求。

requests爬虫技术:用于发送HTTP请求,获取豆瓣电影页面的HTML内容,是数据爬取的关键工具。

豆瓣电影:作为数据来源,豆瓣电影提供了丰富的电影信息和用户评价,为系统提供了可靠的数据基础。

功能模块介绍

首页—电影数据分析概况

首页是系统的入口,展示了电影数据分析的概况。通过柱状图、饼图等图表,直观展示了电影的数量、评分分布、类型分布等关键信息,为用户提供了快速了解电影市场的窗口。

电影数据中心

电影数据中心提供了详细的电影信息,包括电影名称、导演、演员、上映时间、评分等。用户可以通过关键词搜索或筛选功能,快速找到感兴趣的电影,并查看其详细信息。

电影时间分析

电影时间分析模块提供了电影上映时间的统计和可视化展示。通过柱状图或折线图,用户可以直观地看到电影在不同时间段的上映情况,以及市场趋势的变化。

电影制片国家维度—评分数据分析

该模块分析了不同制片国家的电影评分情况。通过饼图或柱状图,用户可以清晰地看到各国电影的评分分布,以及不同国家电影之间的评分差异。

电影类型维度—评分数据分析

电影类型维度分析模块提供了不同类型电影的评分数据。用户可以查看各种类型电影的评分分布,了解不同类型电影的市场表现和观众喜好。

电影演员词云图分析

电影演员词云图分析模块通过词云图展示了演员在电影中的出现频率和重要性。用户可以通过词云图直观地看到哪些演员在电影市场中具有较高的影响力和关注度。

后台数据管理

后台数据管理模块为管理员提供了便捷的数据管理功能。管理员可以通过该模块对电影数据进行增删改查操作,确保数据的准确性和完整性。同时,该模块还提供了数据备份和恢复功能,保障数据安全。

注册登录界面

注册登录界面为用户提供了注册和登录功能。用户可以通过注册功能创建账户,并通过登录功能进入系统。注册登录功能确保了用户数据的安全性和隐私性。

电影数据爬取

电影数据爬取模块是系统的核心功能之一。该模块利用requests爬虫技术和HTML解析技术,自动获取豆瓣电影页面的数据,并将其存储到MySQL数据库中。通过定期爬取数据,系统可以保持数据的实时性和准确性。

系统总结

综上所述,基于Python语言及其相关技术栈的豆瓣电影数据分析系统是一个功能全面、直观易用的数据分析工具。该系统通过集成多个功能模块,为用户提供了全面的电影数据分析服务。无论是电影制作方、发行方还是观众,都可以通过该系统深入了解电影市场的发展趋势和观众喜好,为电影产业提供有力支持。同时,该系统还具备强大的数据管理和安全性功能,确保用户数据的安全性和隐私性。未来,我们将继续优化系统功能,提升用户体验,为电影行业提供更加精准、高效的数据分析服务。

4、核心代码

import requests

from lxml import etree

import re

import csv

# 基础URL和页数设置

base_url = 'https://www.douban.com/doulist/3936288/?start={}&sort=time&playable=0&sub_type='

total_pages = 10 # 总页数

data = [] # 用于存储所有电影数据

headers = {}

# 遍历每一页

for page in range(total_pages):

start = page * 25

url = base_url.format(start)

response = requests.get(url, headers=headers)

content = response.text

tree = etree.HTML(content)

# 影片名称

titles = [title.strip() for title in tree.xpath('//div[@class="title"]/a/text()') if title.strip()]

details = tree.xpath('//div[@class="abstract"]/text()')

# 导演、主演、类型、地区、年份

directors = [line.split('导演:')[1].strip() for line in details if '导演:' in line]

actors = [line.split('主演:')[1].strip() for line in details if '主演:' in line]

genres = [line.split('类型:')[1].strip() for line in details if '类型:' in line]

countries = [line.split('制片国家/地区:')[1].strip() for line in details if '制片国家/地区:' in line]

years = [line.split('年份:')[1].strip() for line in details if '年份:' in line]

# 星级和评价人数

stars = tree.xpath('//div[@class="rating"]/span[2]/text()')

numbers = [int(re.search(r'\d+', person).group()) for person in tree.xpath('//div[@class="rating"]/span[3]/text()')]

# 图片src和详情链接

img_srcs = tree.xpath('//div[@class="post"]//img/@src')

detail_links = tree.xpath('//div[@class="title"]//a/@href')

print(titles,directors,actors,genres,countries,years,stars,numbers)

# 合并当前页的数据

for i in range(len(titles)):

data.append([

titles[i] if i < len(titles) else '',

directors[i] if i < len(directors) else '',

actors[i] if i < len(actors) else '',

genres[i] if i < len(genres) else '',

countries[i] if i < len(countries) else '',

years[i] if i < len(years) else '',

stars[i] if i < len(stars) else '',

numbers[i] if i < len(numbers) else '',

img_srcs[i] if i < len(img_srcs) else '',

detail_links[i] if i < len(detail_links) else ''

])

# 保存数据到CSV文件

with open('movies.csv', mode='w', newline='', encoding='utf-8') as file:

writer = csv.writer(file)

# 写入表头

writer.writerow(

['Title', 'Director', 'Actor', 'Genre', 'Country', 'Year', 'Star', 'Number of Reviews', 'Image Source',

'Detail Link']

)

# 写入所有数据

writer.writerows(data)

print("数据已成功保存到 movies.csv")

5、源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,查看我的【用户名】、【专栏名称】、【顶部选题链接】就可以找到我啦🍅

感兴趣的可以先收藏起来,点赞、关注不迷路,下方查看👇🏻获取联系方式👇🏻