目录

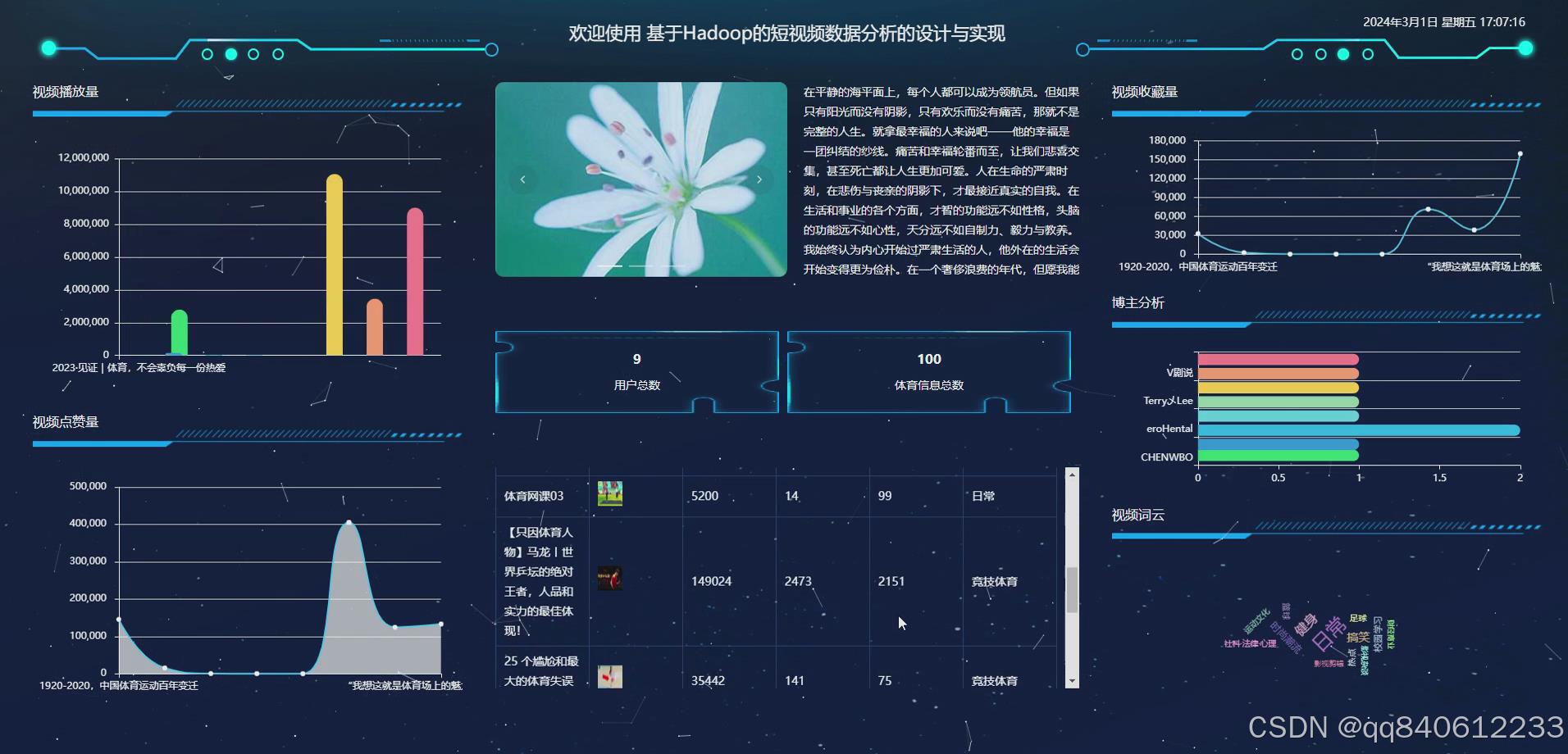

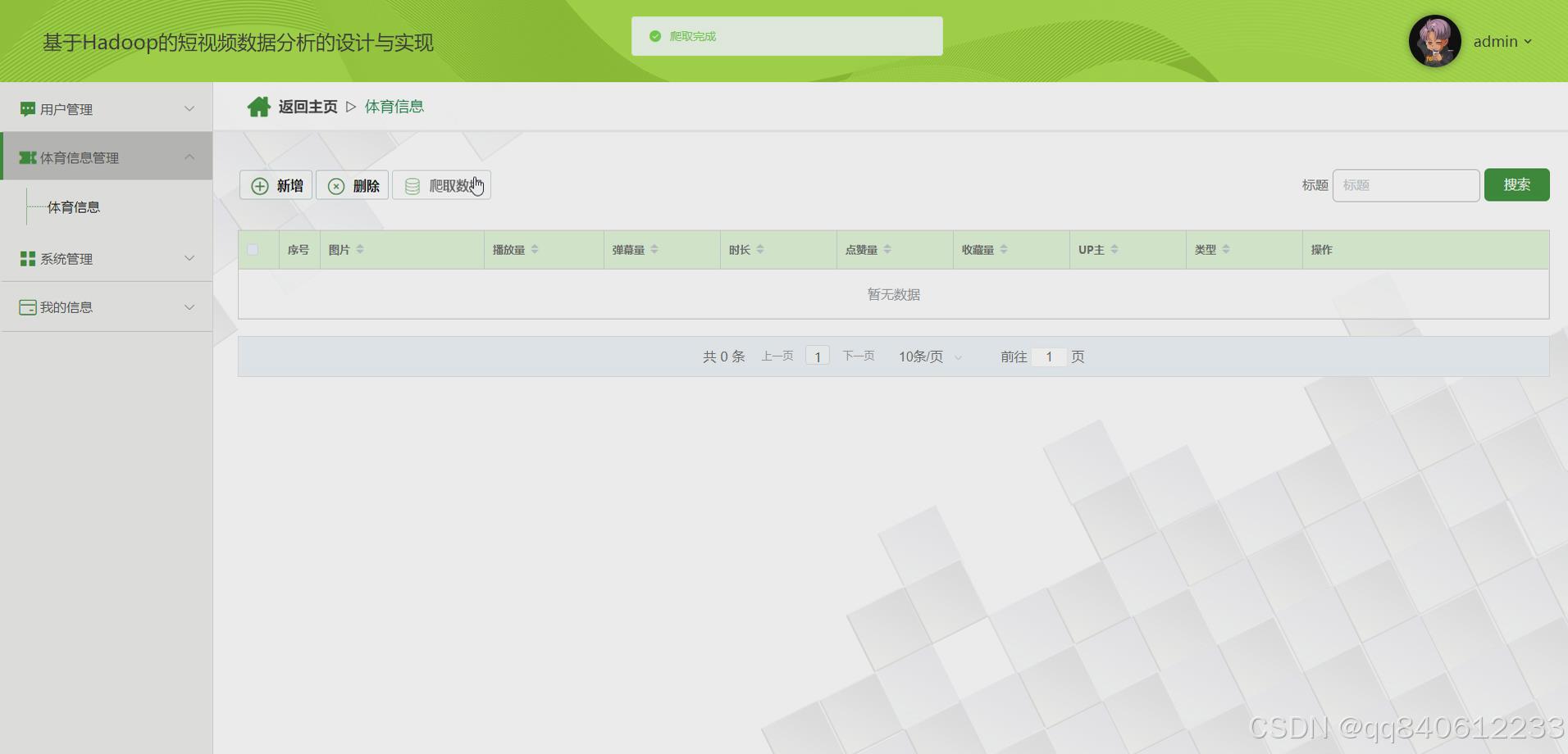

具体实现->已完成成品截图

课题项目源码功能介绍

基于Python大数据技术进行网络爬虫的设计,框架使用Scrapy.

系统设计支持以下技术栈

前端开发框架:vue.js

数据库 mysql 版本不限

后端语言框架支持:

1 java(SSM/springboot)-idea/eclipse

2.python(flask/django)–pycharm/vscode

3.Nodejs+Vue.js -vscode

4.php(thinkphp/laravel)-hbuilderx/vscode

数据库工具:Navicat/SQLyog等都可以

可行性分析

经济可行性:本网站基于Django/Flask 和MySql开发,使用开源技术平台经济成本较低,用户可以直接点击观看无需更多经济付出。

技术可行性:本系统基于python和js易于维护,同时基于浏览器操作有着跨平台的优势,Django/Flask框架较为成熟构建速度较快便于快速开发更新,MySql数据库容易上手应用广泛。

操作可行性:本系统基于HTML直观简易用户点击即可进行操作,操作十分方便简洁。

社会因素的分析:本系统为了解决用户观影的“痛点”而设计,操作大大简化,同时线上观影市场广泛符合广大用户的实际需求。

可定制设计功能创新点->最短路线推荐算法

:使用场景:最短路线推荐使用场景包括但不限于以下方面

交通出行:在城市中,人们需要从一个地方快速到达另一个地方。通过最短路线算法,可以规划出最快捷的行驶路径,减少旅行时间和油耗。

物流配送:物流公司需要高效地分配货物,确保货物能够以最低的成本和最快的速度送达目的地。最短路线算法可以帮助确定最佳的配送路径。

电力网络:在电力网络中,电线杆和变电站可以视为节点,电线可以视为边。最短路线算法有助于优化电线布局,减少电力损耗和成本。

社交网络:在社交网络中,用户之间的关注关系可以视为边,用户本身可以视为节点。最短路线算法可以用于推荐好友或关注对象,增强用户间的连接。

计算机网络:在计算机网络中,数据包需要在各个路由器之间传输。最短路线算法可以用于确定数据包的最优传输路径,提高网络效率。

应急响应:在紧急情况下,如火灾、地震等,救援队伍需要尽快到达事发地点。最短路线算法可以帮助规划出最快的救援路径,提高救援效率。

游戏开发:在电子游戏中,角色可能需要在地图上移动到特定位置。最短路线算法可以用于计算角色的最佳移动路径,提升游戏体验。

机器人导航:在自动驾驶或机器人导航中,最短路线算法可以帮助机器人规划出避开障碍物的最优路径,实现自主导航。

旅游规划:在旅游行业中,游客可能需要从一个景点前往另一个景点。最短路线算法可以提供最佳旅游路线建议,帮助游客节省时间和费用。

可定制开发功能创新亮点->深度学习之LSTM算法

深度学习之LSTM算法:使用场景:进行时间序列的预测,主要进行未来数据的预测,比如预测未来多少天的天气情况等几点:

金融市场预测:LSTM可用于预测股票价格、汇率、交易量等金融指标的未来走势。通过分析历史交易数据,LSTM能够捕捉市场趋势和波动,为投资者提供决策支持。

销售预测:在零售和电商领域,LSTM可以根据历史销售数据预测未来一段时间内的销售量、库存需求等,帮助企业进行供应链管理和库存优化。

情感分析:通过分析文本数据中的情感倾向,LSTM可以对文本进行情感分类,判断其是正面、负面还是中性情感,这在社交媒体分析、品牌监测等领域具有重要应用价值

疾病预测:利用患者的历史医疗记录、生活习惯等数据,LSTM可以预测患者未来患某种疾病的风险。

可定制开发功能创新亮点->随机组卷算法

随机组卷是一种在教育、考试、测试等场景中广泛使用的技术,旨在从预先准备好的题库中随机选择题目,以生成个性化的试卷。这种方法有助于确保考试的公平性、减少作弊的可能性,并为学生提供多样化的测试体验。通过组卷功能,实现考试(单选,多选,判断,填空,客观题)用户自动提交,倒计时,自动+手动得分,可以高效地实现随机组卷,为考试提供科学、公平、个性化的解决方案。

可定制开发功能创新亮点->机器学习之线性回归算法

使用场景:市场营销、教育评估、人力资源管理、销售预测、交通规划等,线性回归算法因其简单性和有效性,在多个领域都有广泛应用,包括但不限于:

房价预测:通过分析房屋的各种特征(如面积、位置、装修等)来预测房价。

销售预测:基于历史销售数据和市场趋势来预测未来的销售额。

贷款额度评估:根据借款人的信用记录、收入情况等因素来评估贷款额度。

医疗健康:预测疾病风险、药物效果等。

金融市场:预测股票价格、汇率等。

员工培训时间与绩效关系:人力资源管理者可以利用线性回归模型分析员工培训时间与工作绩效之间的线性关系,以确定最有效的培训时长和方式。

工资与员工满意度关系:通过线性回归,可以研究工资水平对员工满意度的影响,帮助企业制定更具吸引力的薪酬政策。

可定制开发功能创新亮点->网络爬虫

网络爬虫:可以对对应网站爬取出对应的数据内容: 本研究将采用Hadoop技术对XXX数据进行爬取和存储,并利用可视化技术对数据进行深入分析和展示。首先爬取XXX网站的数据,用Hadoop的MapReduce框架进行并行数据处理,实现大规模数据的快速获取和存储,其次对爬取的数据进行清洗、去重、格式转换等预处理操作,提高数据质量,并将处理后的数据存储在Hadoop分布式文件系统中。利用Hadoop的Hive数据仓库工具进行数据分析,包括数据聚合、趋势预测等,以提取有价值的信息,利用如Python的Matplotlib、Seaborn等可视化工具,将数据分析结果以图表、仪表板等形式进行展示,以便用户更直观地了解xxx市场情况。

开发流程

1)环境搭建

搭建符合课题开发的环境。如果采用支持高可用的系统(例如hdfs,Hbase,Flink,Spark 等),集群至少3台服务器;

2)数据采集。可选项,根据课题需要完成数据采集的设计与开发。

3)数据预处理。

对于有缺失值的记录,按照自己定义的规则或补充或舍弃处理,对于类型数据按照规则映射为数值;对于不平衡数据需要有相应的处理措施。

4)数据存储。

必须使用数据库保存数据。 推荐使用NoSQL数据库,如 MongoDB、 Redis 等数据库,也可以使用关系数据库保存数据,如 MySQL;开发过程需要包括数据库需求分析、数据库设计、数据库建立、数据输入等部分。

5) 数据分析与预测

使用合理的数据计算框架实现数据分析,例如:Tensorflow/Pytorch、Hadoop、hive、Spark等;根据课题选择、比较各算法性能;构造出基于最佳算法的框架,编程实现并测试选取不同参数时对算法性能的影响;

6) 数据可视化

对模型建立、数据分析结果用不同可视化方式进行可视化分析。此部分可以增加对用户/会员管理功能。推荐采用B/S结构实现。

2.具体要求:

1)独立开发设计系统的模块程序,遵循软件工程开发周期进行,包括需求分析、总体方案制定、详细设计和功能规划、编程实现、调试等;

2)所开的系统能正常运行在所选的平台上,并实现相关模块的功能;

3)提供系统模块框架分析图、模块功能说明图、系统平台设计图、各分模块实现框图,在设计文档中体现;

Scrapy爬虫框架

网络爬虫是依靠预先设定好的规则而进行自动的抓取网络信息的过程 。网络爬虫通过解析网页,自动获取网页的数据。相较于人工去获取网页数据,无疑是要方便许多。本文使用 Python 的 Requests 库和 Beautifulsoup 库去解析链家网页,获取数据。同样是网络爬虫的一种。当然,网络爬虫也是有缺点的,它在对网页进行爬取时,可能会触发网页的反爬机制,从而导致失败。所以在编写爬虫程序的时候就要想办法绕过反爬机制,增加了工作量。而且网络爬虫必须要遵守相关法律法 规,不能够恶意的去爬取一些网站的信息。

Scrapy是一个Python编写的强大,灵活的网络爬虫框架和数据提取工具。它使用异步I/O网络库Twisted进行高效的爬取,并将提取到的数据存储到多种格式中。然而,在需要大规模爬取复杂的网站时,单机爬虫速度会受到限制。为了解决这个问题,Scrapy提供了分布式爬虫系统

爬虫核心代码展示

import scrapy

import pymysql

import pymssql

from ..items import xiangmuItem

import time

import re

import random

import platform

import json

import os

from urllib.parse import urlparse

import requests

import emoji

class xiangmuSpider(scrapy.Spider):

name = 'xiangmuSpider'

spiderUrl = 'https://url网址'

start_urls = spiderUrl.split(";")

protocol = ''

hostname = ''

def __init__(self, *args, **kwargs):

super().__init__(*args, **kwargs)

# 列表解析

def parse(self, response):

_url = urlparse(self.spiderUrl)

self.protocol = _url.scheme

self.hostname = _url.netloc

plat = platform.system().lower()

if plat == 'windows_bak':

pass

elif plat == 'linux' or plat == 'windows':

connect = self.db_connect()

cursor = connect.cursor()

if self.table_exists(cursor, 'xiangmu') == 1:

cursor.close()

connect.close()

self.temp_data()

return

list = response.css('ul.subject-list li.subject-item')

for item in list:

fields = xiangmuItem()

fields["laiyuan"] = self.remove_html(item.css('div.pic a.nbg::attr(href)').extract_first())

if fields["laiyuan"].startswith('//'):

fields["laiyuan"] = self.protocol + ':' + fields["laiyuan"]

elif fields["laiyuan"].startswith('/'):

fields["laiyuan"] = self.protocol + '://' + self.hostname + fields["laiyuan"]

fields["fengmian"] = self.remove_html(item.css('div.pic a.nbg img::attr(src)').extract_first())

fields["xiaoshuoming"] = self.remove_html(item.css('div.info h2 a::attr(title)').extract_first())

detailUrlRule = item.css('div.pic a.nbg::attr(href)').extract_first()

if self.protocol in detailUrlRule:

pass

elif detailUrlRule.startswith('//'):

detailUrlRule = self.protocol + ':' + detailUrlRule

else:

detailUrlRule = self.protocol + '://' + self.hostname + detailUrlRule

fields["laiyuan"] = detailUrlRule

yield scrapy.Request(url=detailUrlRule, meta={'fields': fields}, callback=self.detail_parse)

# 详情解析

def detail_parse(self, response):

fields = response.meta['fields']

try:

if '(.*?)' in '''div#info span a::text''':

fields["zuozhe"] = re.findall(r'''div#info span a::text''', response.text, re.S)[0].strip()

else:

if 'zuozhe' != 'xiangqing' and 'zuozhe' != 'detail' and 'zuozhe' != 'pinglun' and 'zuozhe' != 'zuofa':

fields["zuozhe"] = self.remove_html(response.css('''div#info span a::text''').extract_first())

else:

fields["zuozhe"] = emoji.demojize(response.css('''div#info span a::text''').extract_first())

except:

pass

# 去除多余html标签

def remove_html(self, html):

if html == None:

return ''

pattern = re.compile(r'<[^>]+>', re.S)

return pattern.sub('', html).strip()

# 数据库连接

def db_connect(self):

type = self.settings.get('TYPE', 'mysql')

host = self.settings.get('HOST', 'localhost')

port = int(self.settings.get('PORT', 3306))

user = self.settings.get('USER', 'root')

password = self.settings.get('PASSWORD', '123456')

try:

database = self.databaseName

except:

database = self.settings.get('DATABASE', '')

if type == 'mysql':

connect = pymysql.connect(host=host, port=port, db=database, user=user, passwd=password, charset='utf8')

else:

connect = pymssql.connect(host=host, user=user, password=password, database=database)

return connect

# 断表是否存在

def table_exists(self, cursor, table_name):

cursor.execute("show tables;")

tables = [cursor.fetchall()]

table_list = re.findall('(\'.*?\')',str(tables))

table_list = [re.sub("'",'',each) for each in table_list]

if table_name in table_list:

return 1

else:

return 0

论文书写大纲

绪论

1.系统分析

1.1需求分析

1.2所采用的技术关键

2系统总体设计

2.1总体功能

2.2处理流程设计

3系统详细设计

3.1概念结构设计

3.2数据库设计

3.3数据模块设计

4系统调试与测试

4.1测试环境简介

4.2测试目标

4.3测试方法

4,4程序测试

5结论

参考文献

致谢

详细视频演示

请联系我获取更详细的演示视频

源码获取

文章最下方名片联系我即可~