note

- DeepSeek-R1-Distill-Qwen-7B 的测试效果很惊艳,CoT 过程可圈可点,25 年应该值得探索更多端侧的硬件机会。

一、下载 Ollama

访问 Ollama 的官方网站 https://ollama.com/library/deepseek-r1, 根据系统提示下载适合自己电脑的版本。

二、下载 Docker

直接点击官方 https://www.docker.com/, 下载适合自己电脑的版本。

三、下载模型

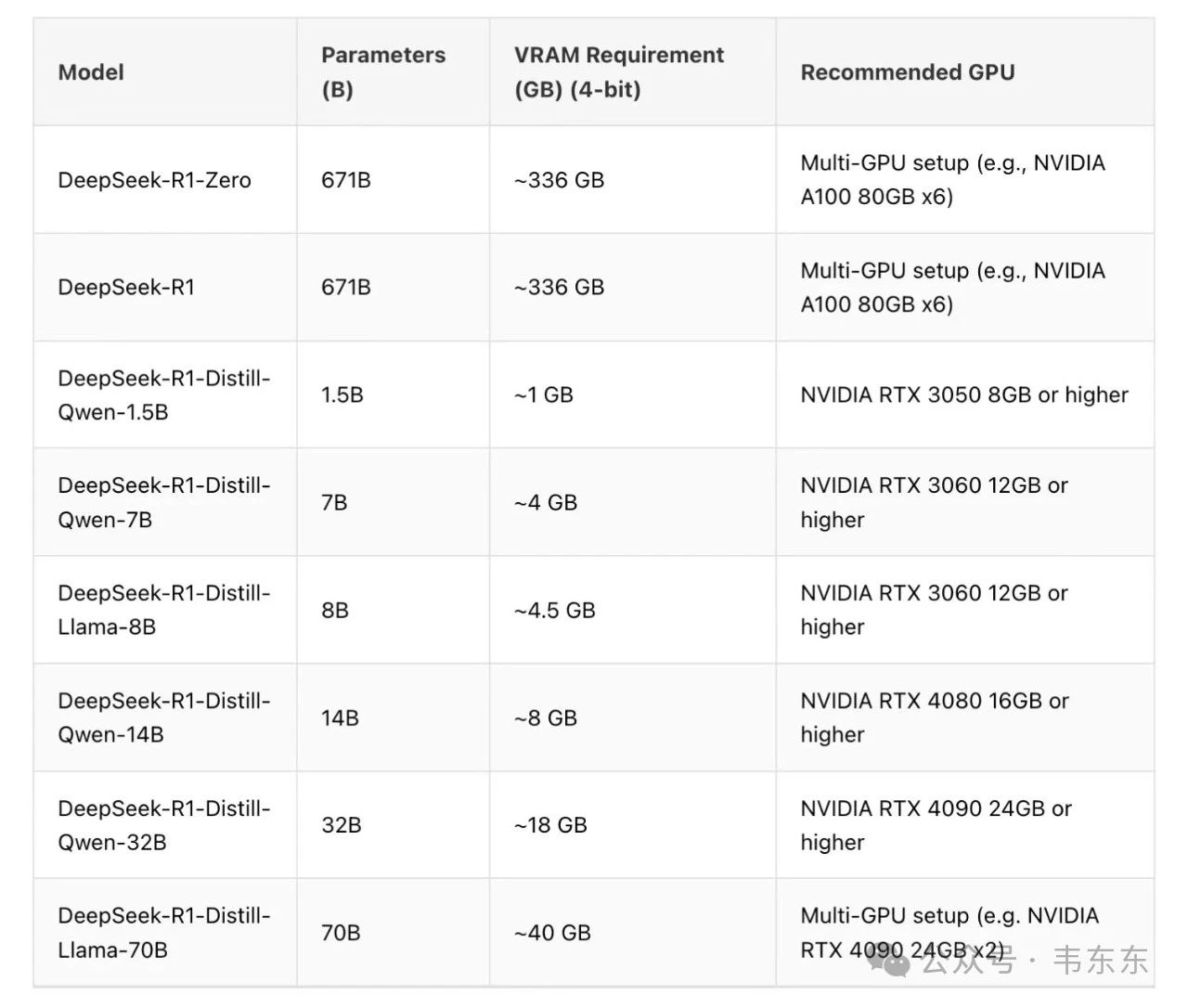

以 Distill-Qwen-7B 为例,在电脑终端中输入:ollama run deepseek-r1:7b,7b 的模型大概 4.7G 大小,等待模型下载完成之后即可在终端中输入问题进行测试。下一步会演示如何在 open webui 中使用。

四、部署 open webui

在终端中运行下述命令后,可以自动在 docker 中完成部署,然后在本地浏览器中使用

docker run -d -p 8080:8080 --add-host=host.docker.internal:host-gateway -e OLLAMA_BASE_URL=http://host.docker.internal:11434 ( http://host.docker.internal:11434 ) --name open-webui ghcr.io/open-webui/open-webui:main

Open-WebUI 提供了丰富的功能和界面,如直观的聊天界面、Markdown 和 LaTeX 支持、网页浏览能力、提示预设支持等,极大地提升了用户体验。通过 RLHF 注释功能,用户可以对消息进行评级,以创建强化学习数据集,用于训练或微调模型。