今天使用Spark进行RDD操作,当我开始运行程序时,出现Caused by: java.lang.ClassNotFoundException: scala.Product$class,

我最后检查了下,发现我项目里面的spark-core版本和整个项目的scala版本不一致所导致的。

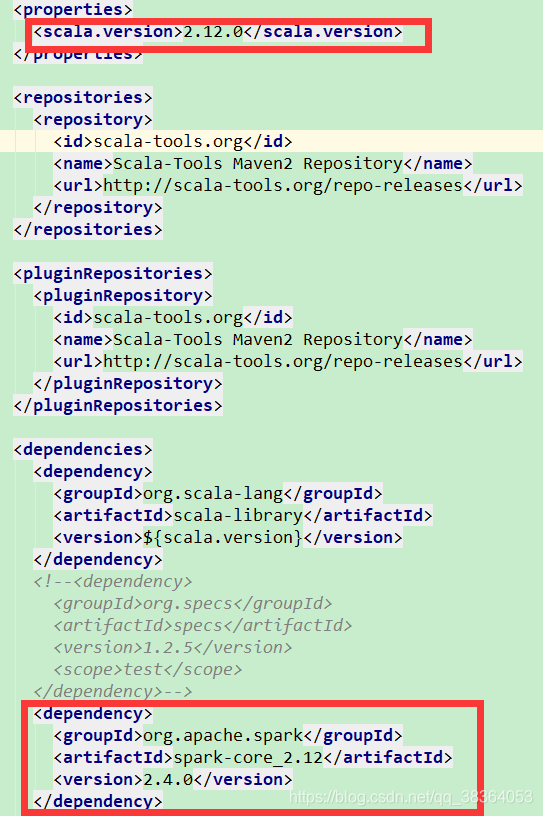

我用Maven构建的项目,pom.xml文件部分结构如下:

由于我之前出错的原因是:spark-core依赖我写的 spark-core_2.11 最后导致运行出错,这里的artifactId中的spark-core_2.12要和scala 2.12.0版本一致。