最近比较火热的国产ai deepseek火遍蛇年春节,包括到现在继续火热中,各个公司都抓住这个机会,使用ai融合到现有的公司中,不管是提高工作效率呀,还是加快公司业务线的扩展呀,又或是不断在学习中,迎接这个新ai潮流。等等等等 。。。我觉得我是后者。

好的开始准备工作

1.ollama官网 下载ollama 管理大语言模型的一个工具

https://ollama.com/

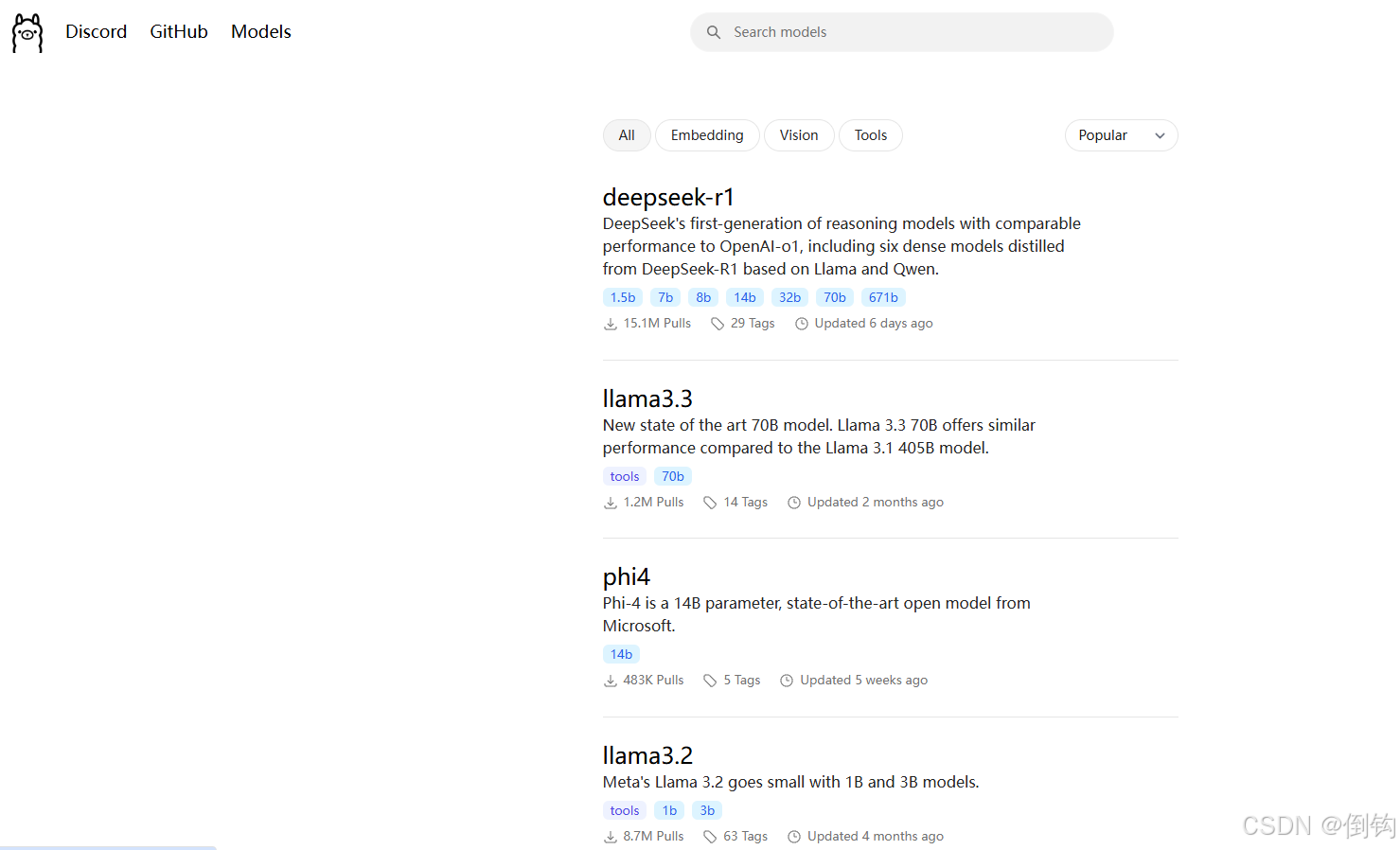

2.模型下载

https://ollama.com/search

大家可以看自己电脑配置去下载体验建议先不要一上来就干最大的模型。电脑大概率是会吉吉

3.可视化聊天工具 这个自行百度下 去官网下载

ChatBox

4.开始下载模型我这里是先下载了

ollama run deepseek-r1:8b

ollama run deepseek-coder:6.7b

ollama run deepseek-r1:14b

ollama run qwen2.5-coder:14b

这几个模型 主要是对比下编码的能力,和体验下deepseek的大语言能力

这里再介绍下ollama常用的几个命令

1.下载好的模型运行(未下载的则这个命令就是先下载) ollama run deepseek-r1:32b 2.查看本地有哪些大模型 ollama list 3.退出正在运行的模型 /bye 4.删除已经安装好的大模型 ollama rm <模型名字> 5.查看正在运行中的大模型 ollama ps 6.停止在运行的大模型 ollama stop deepseek-r1:8b

下载大模型的过程中可能会很慢,大家可以ctr+c暂停 然后在重复执行下run命令

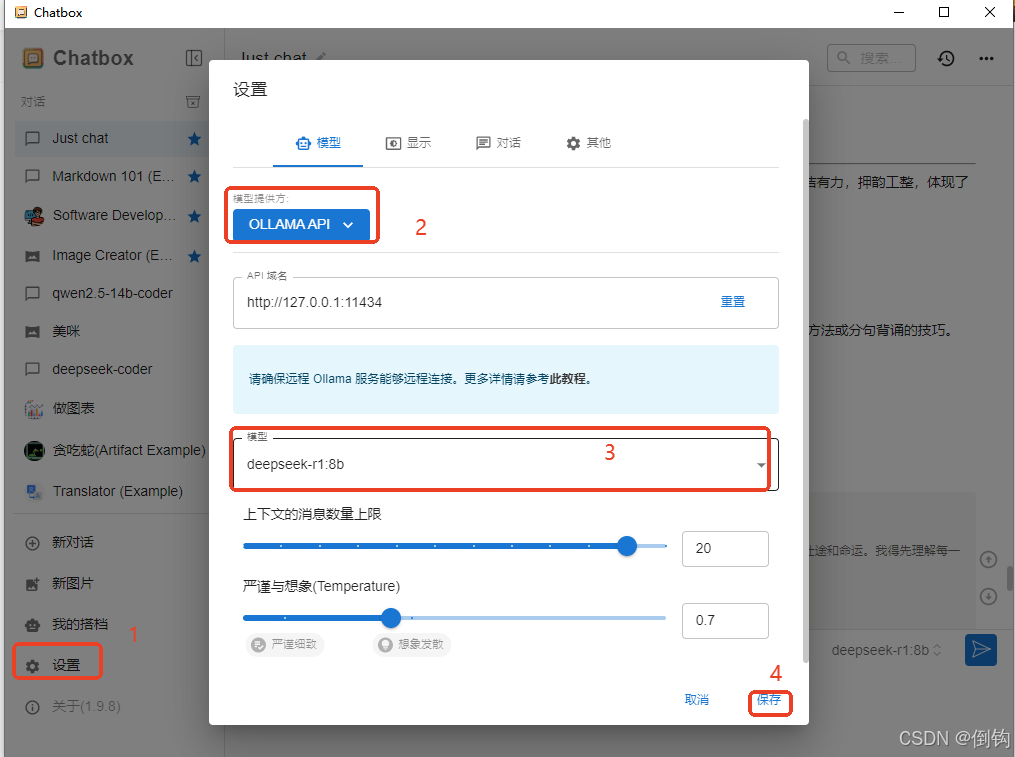

5.配置Chatbox

api服务域名一般自己的ollama程序没有改 都是默认的,大家可以不需要改

按照图片中的顺序操作并最后保存,然后就可以开始和大模型对话了,是不是很兴奋。

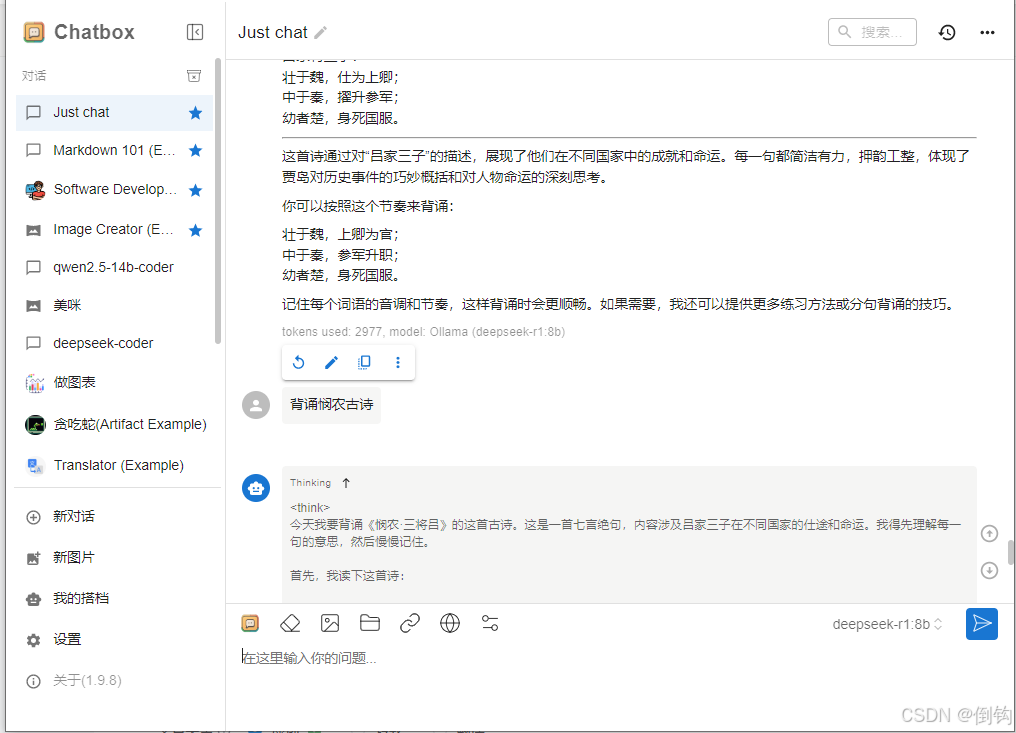

6.开始体验

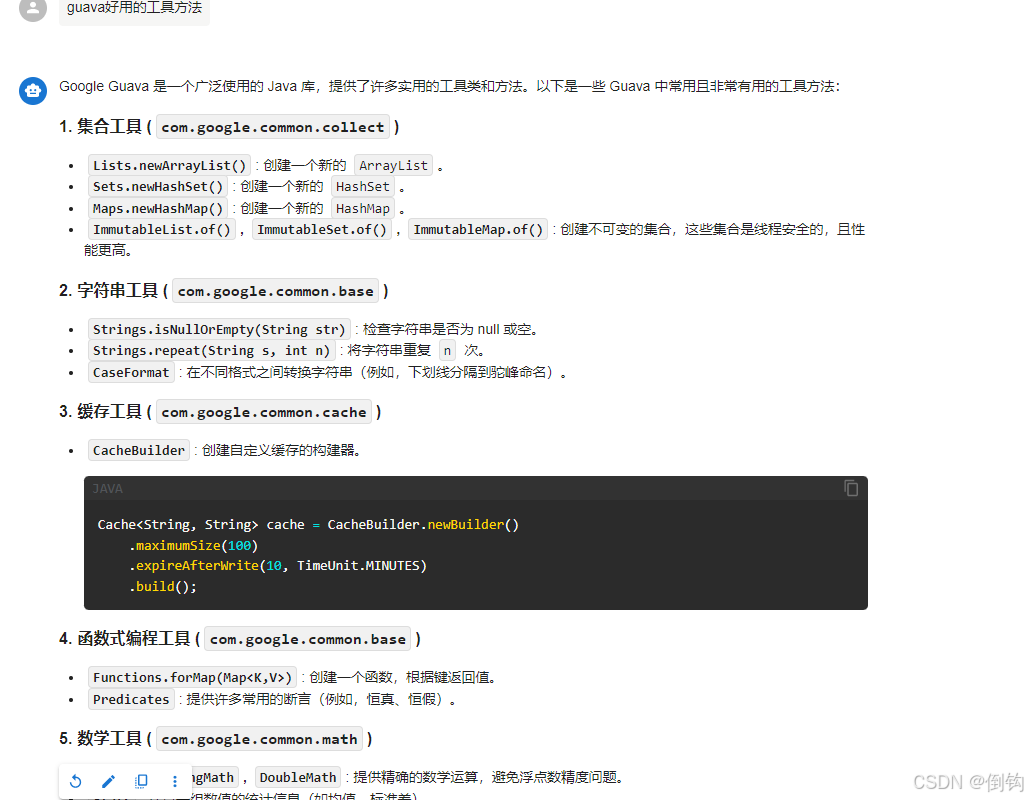

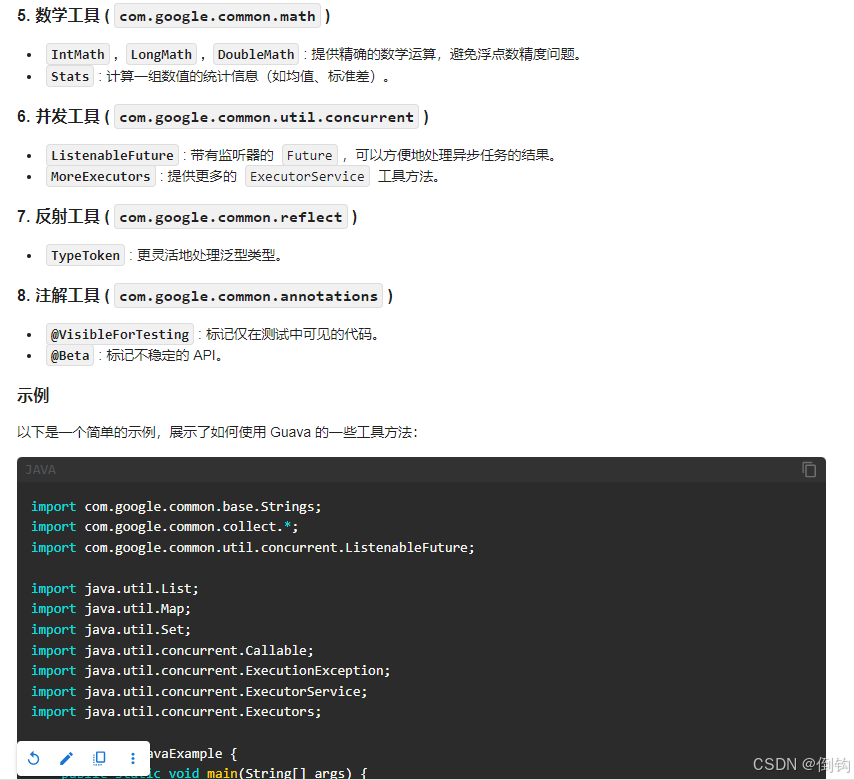

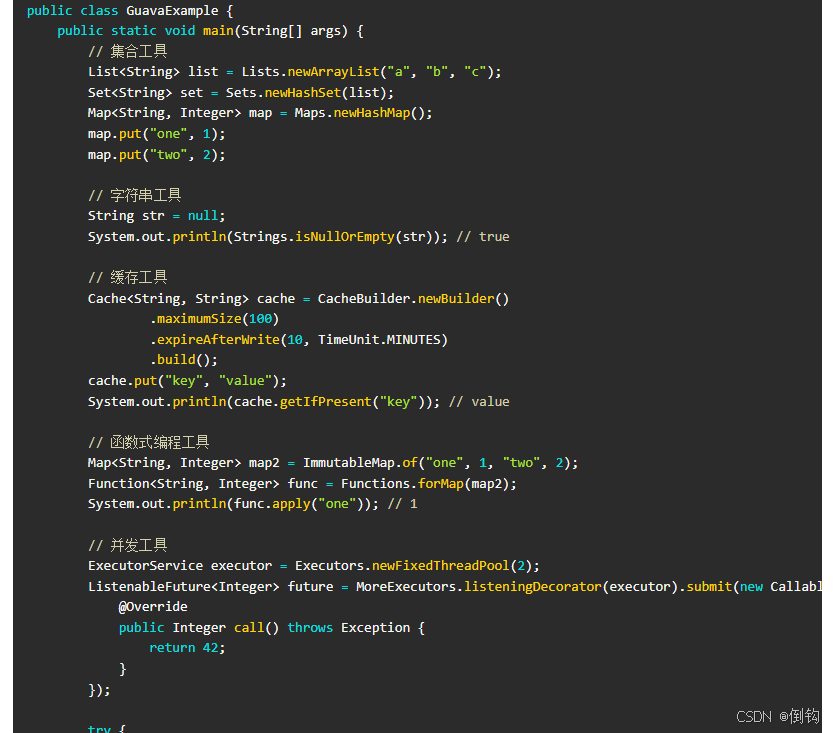

qwen2.5-coder:2.5b模型的效果如下:

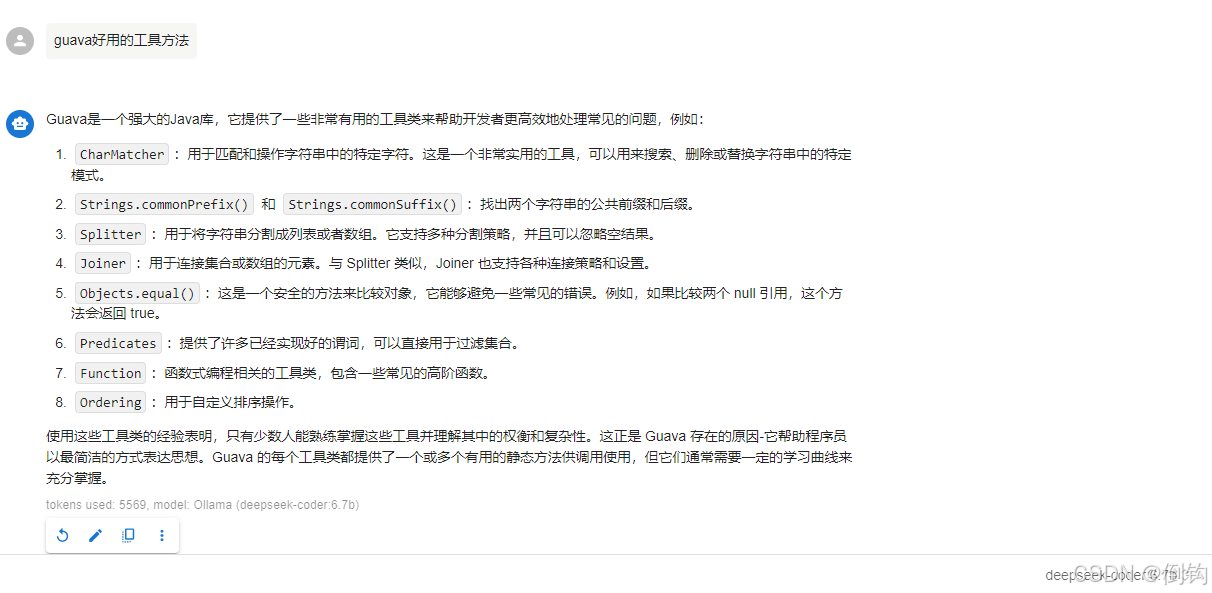

deepseek-coder:6.7b模型表现如下

当然这俩个模型对比其实对deepseek是不公平的 比较他们训练的参数模型数量不在一个量级

deepseek-coder:6.7 只有67亿参数模型

qwen2.5-coder:14b 147亿参数

当然这只是我自己试的模型的对比,还有很多我没有试的可能又会有新的发现和惊喜,大家可以自己去试。

总结:果然千问胜。

现在deepseek不能api充值 我用硅基流动也可以使用deepseek各种模型

轨基流动注册地址:

https://cloud.siliconflow.cn/i/BlTHnJS3以上纯属个人观点,如有不对,敬请理解,也欢迎大家留言评论,一块探讨。