zookeeper

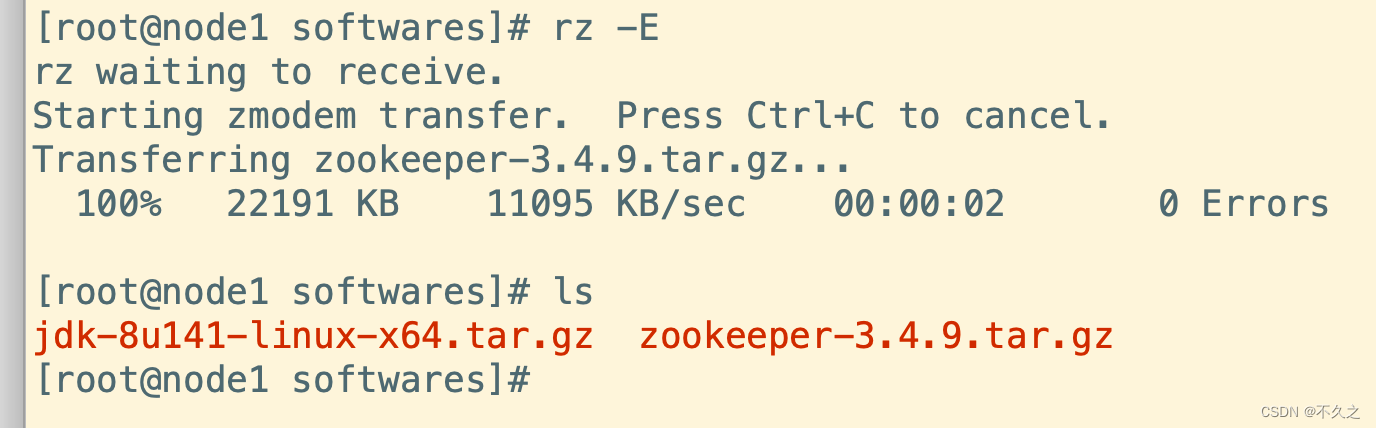

上传一下包

解压

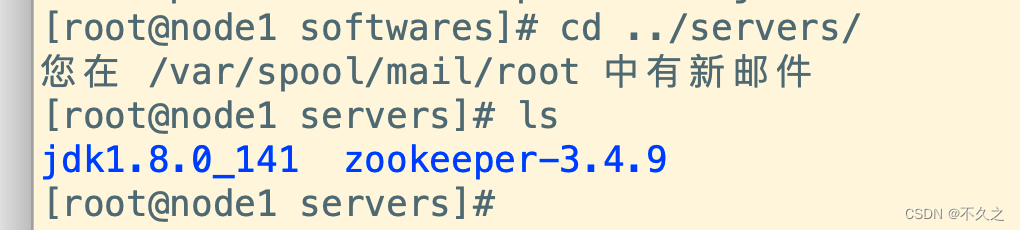

tar -zxvf zookeeper-3.4.9.tar.gz -C ../servers/

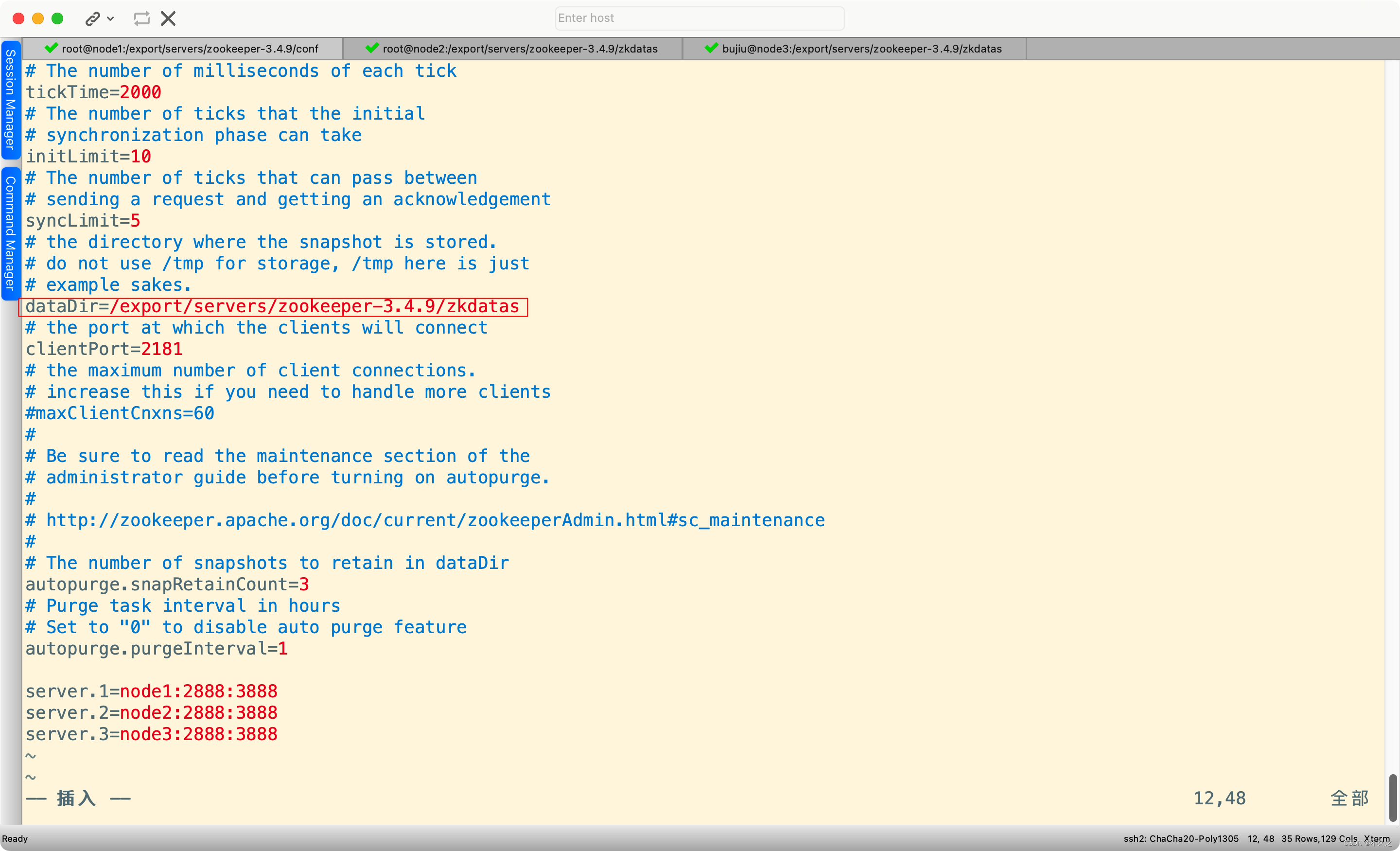

修改配置文件

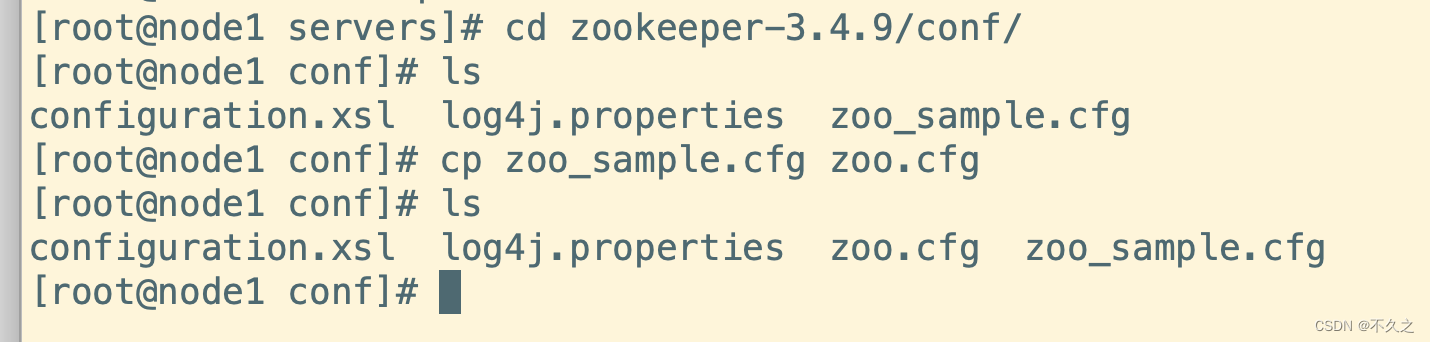

cd zookeeper-3.4.9/conf/

cp zoo_sample.cfg zoo.cfg

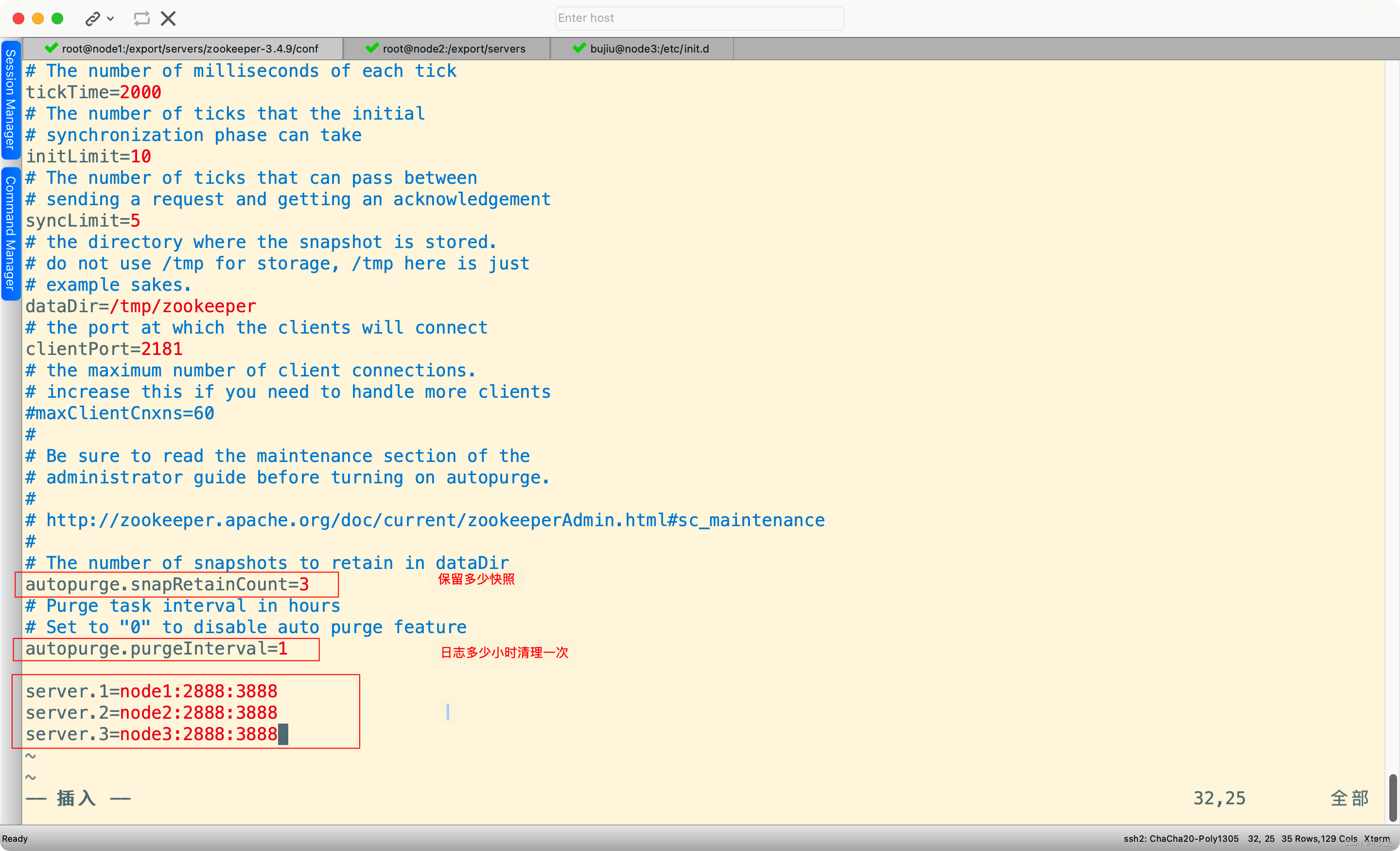

vim zoo.cfg

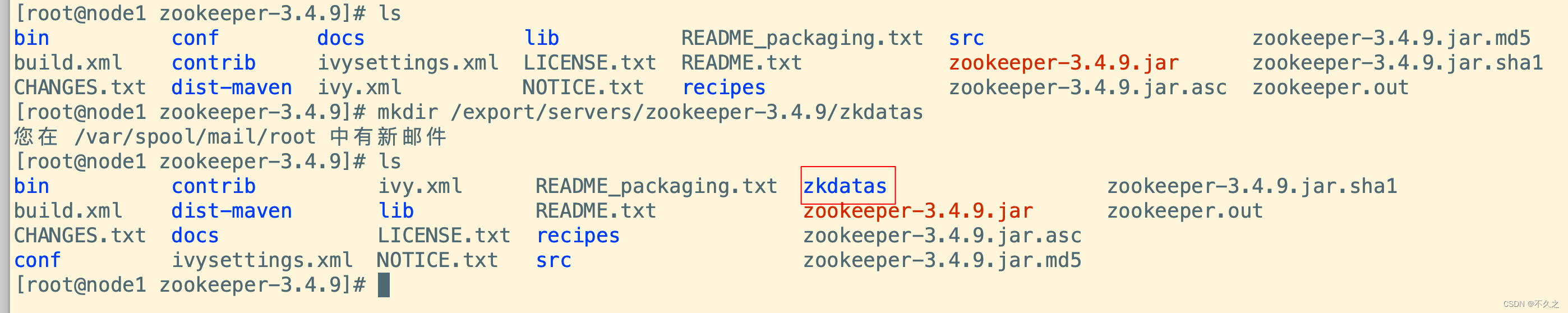

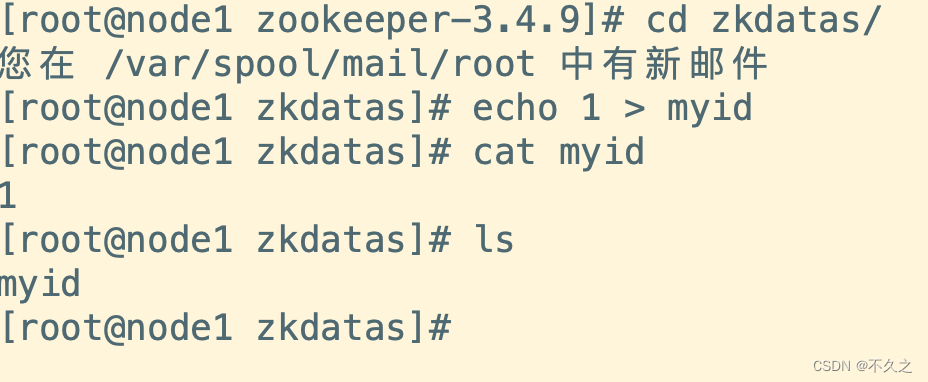

添加myid配置

mkdir /export/servers/zookeeper-3.4.9/zkdatas

echo 1 > myid

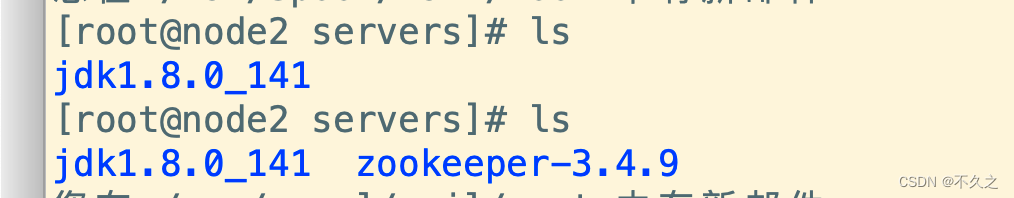

安装包分发并修改myid的值

scp -r /export/servers/zookeeper-3.4.9/ node2:/export/servers/

scp -r /export/servers/zookeeper-3.4.9/ node3:/export/servers/

检查一下

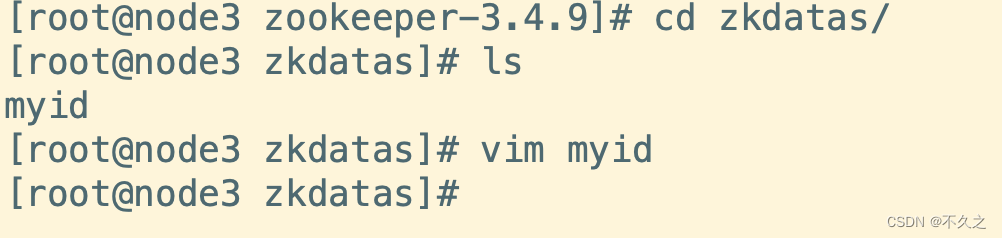

把另外两台的myid改成2和3

启动服务

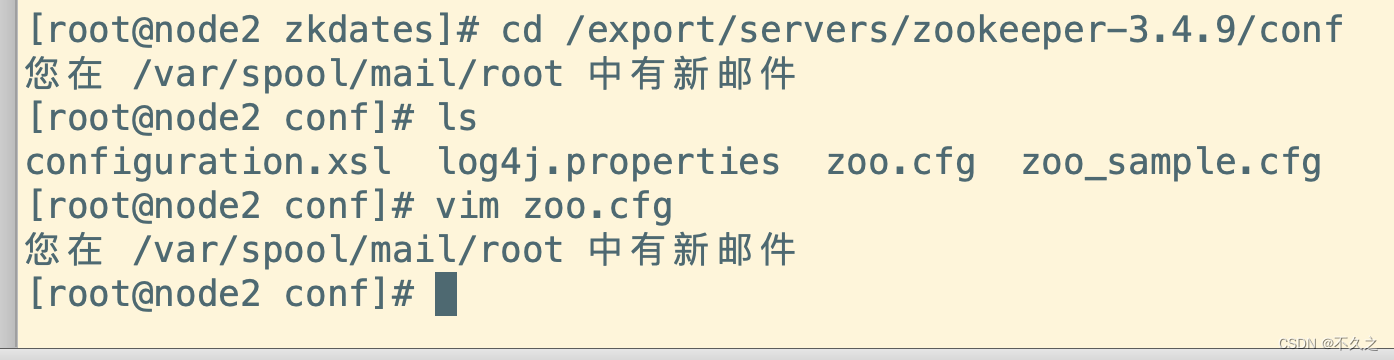

三台机子都要修改

cd /export/servers/zookeeper-3.4.9/conf

#这行粘贴过去,路径替换 /export/servers/zookeeper-3.4.9/zkdatas

## 三台都要操作

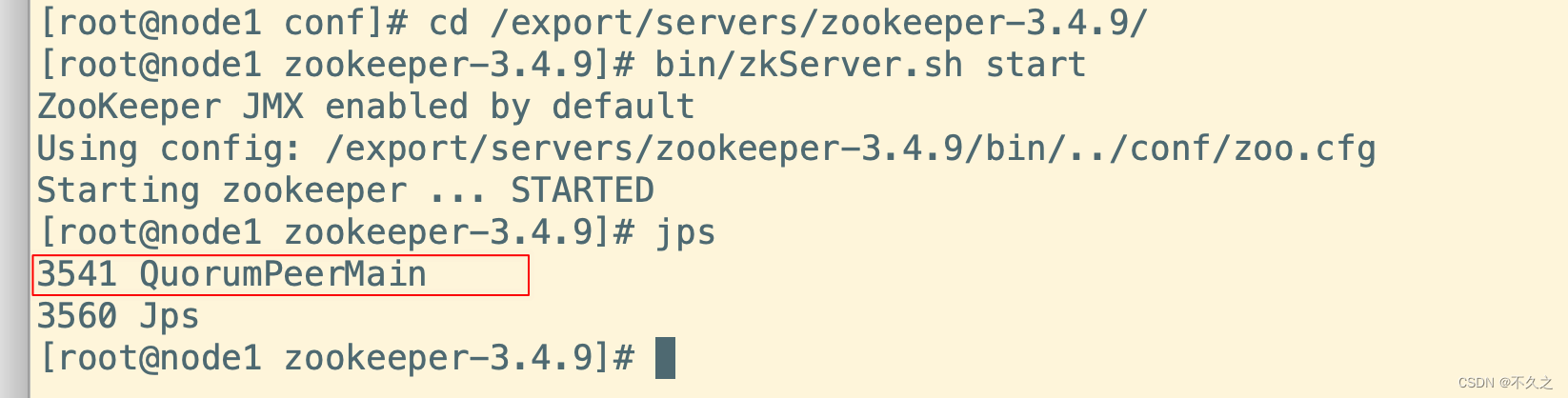

cd /export/servers/zookeeper-3.4.9/

bin/zkServer.sh start

启动成功!

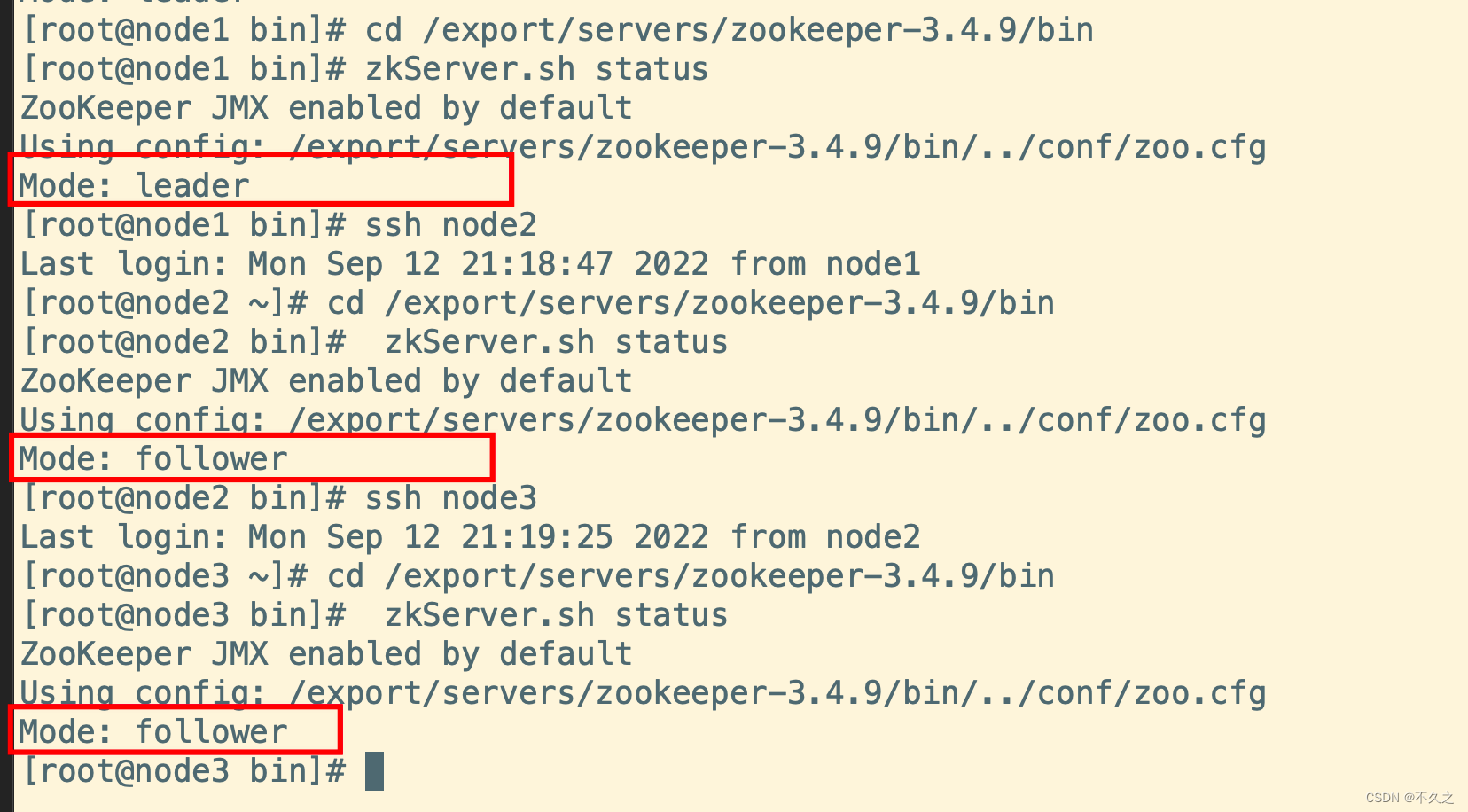

查看状态

bin/zkServer.sh status

总算成功了!!!

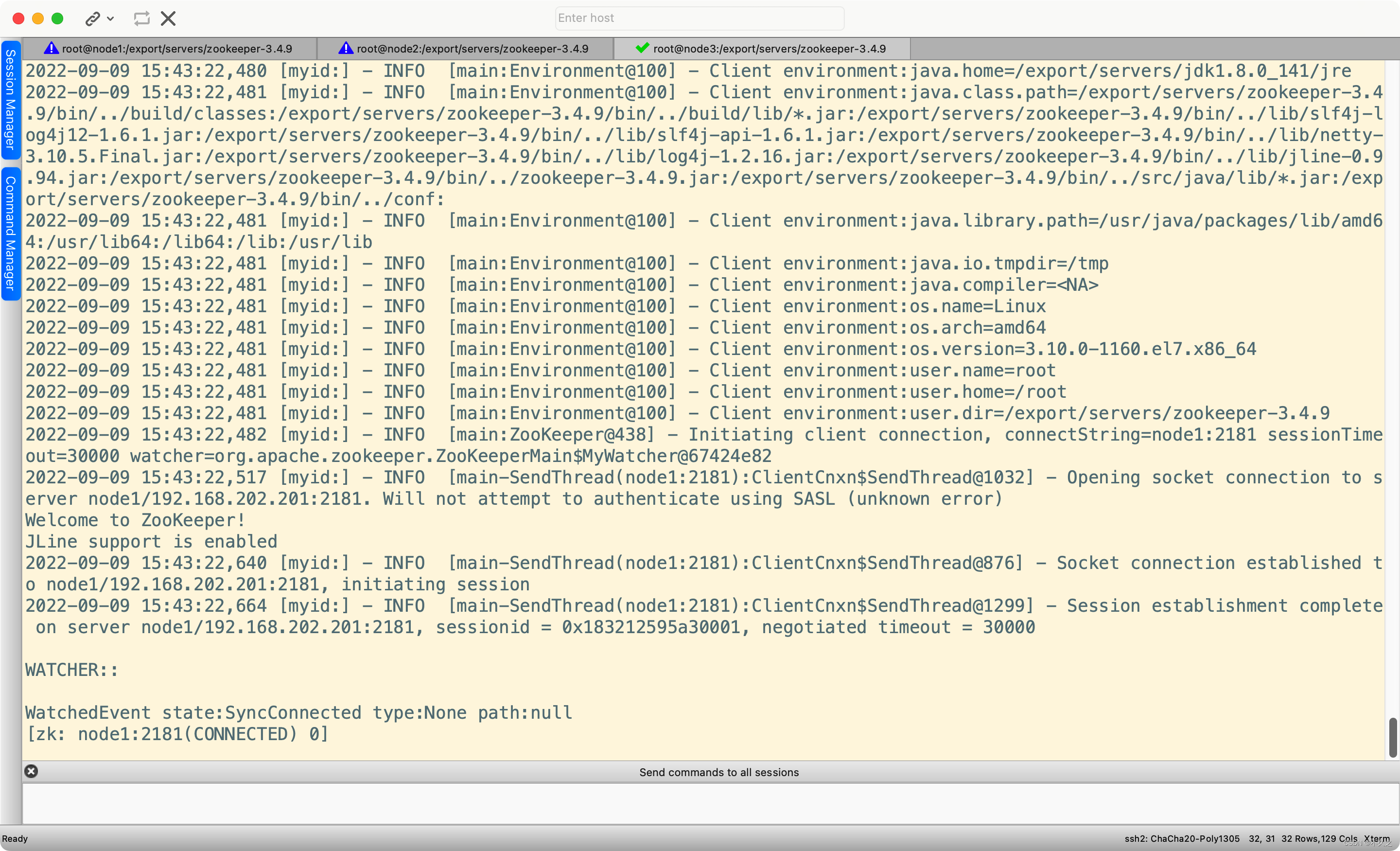

启动客户端

启动一个就行了

bin/zkCli.sh -server node1:2181

##或者

bin/zkCli.sh

hadoop

集群规划

| 服务器IP | 192.168.202.201 | 192.168.202.202 | 192.168.202.203 |

|---|---|---|---|

| 主机名 | node1 | node2 | node3 |

| NameNode | 是 | 否 | 否 |

| SecondaryNameNode | 是 | 否 | 否 |

| dataNode | 是 | 是 | 是 |

| ResourceManager | 是 | 否 | 否 |

| NodeManager | 是 | 是 | 是 |

官网链接

这里没用官网的,因为官方给的没有提供带C程序访问的接口,所以我们在使用本地库(本地库可以用来压缩,一级支持C程序等等)的时候会出现问题,需要重新编译。

编译后的包

第一步:上传apache hadoop包并解压

解压命令

cd /export/softwares

tar -zxvf hadoop-2.7.5.tar.gz -C ../servers/

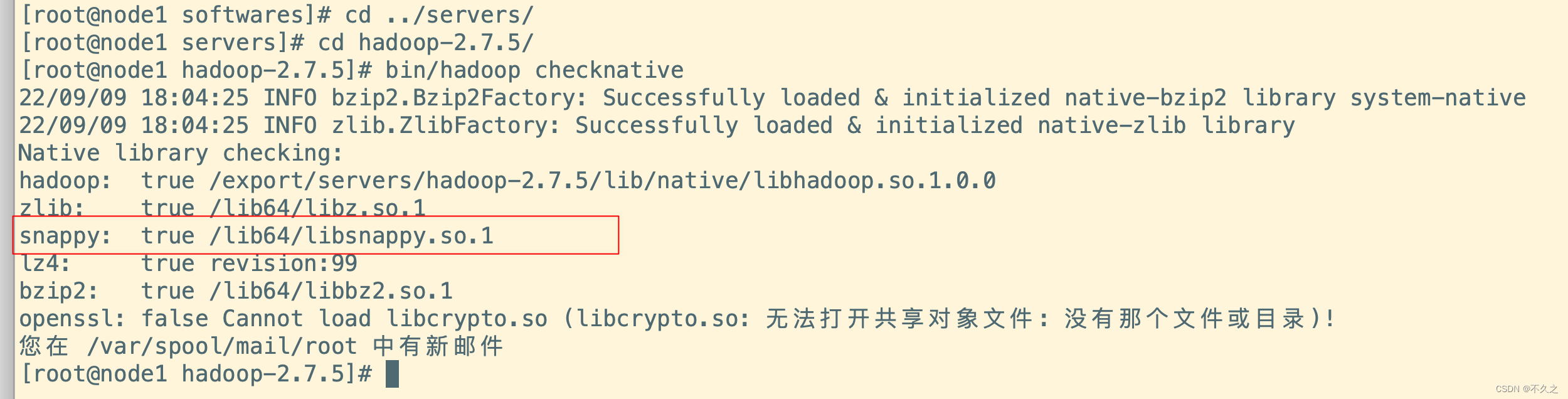

bin/hadoop checknative

# 检查一下支持的本地库

官方给的是不支持这个snappy的

第二步:修改配置文件

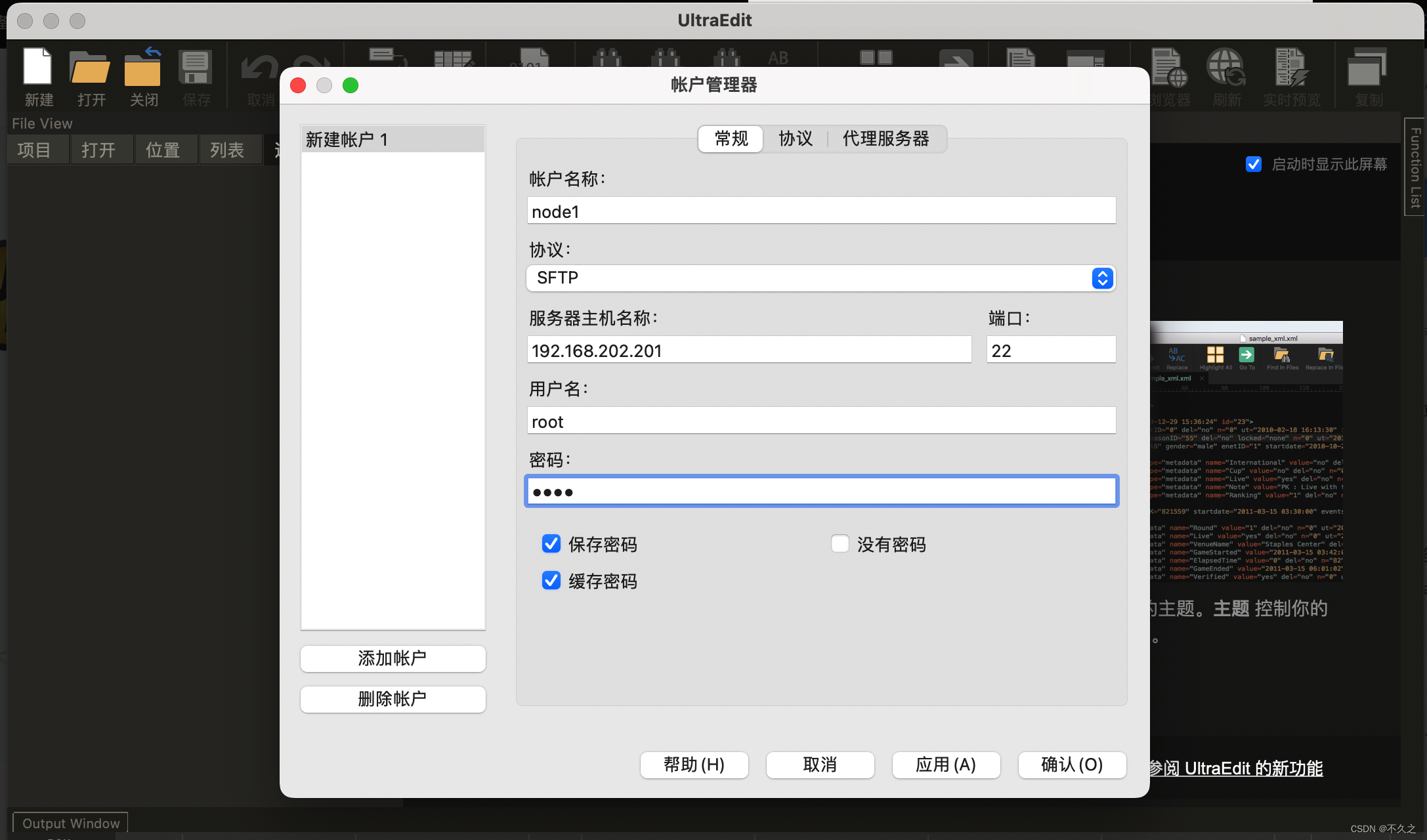

这里直接用vim很不方便,win的话就用notepad++,Mac的话就用ultraEdit

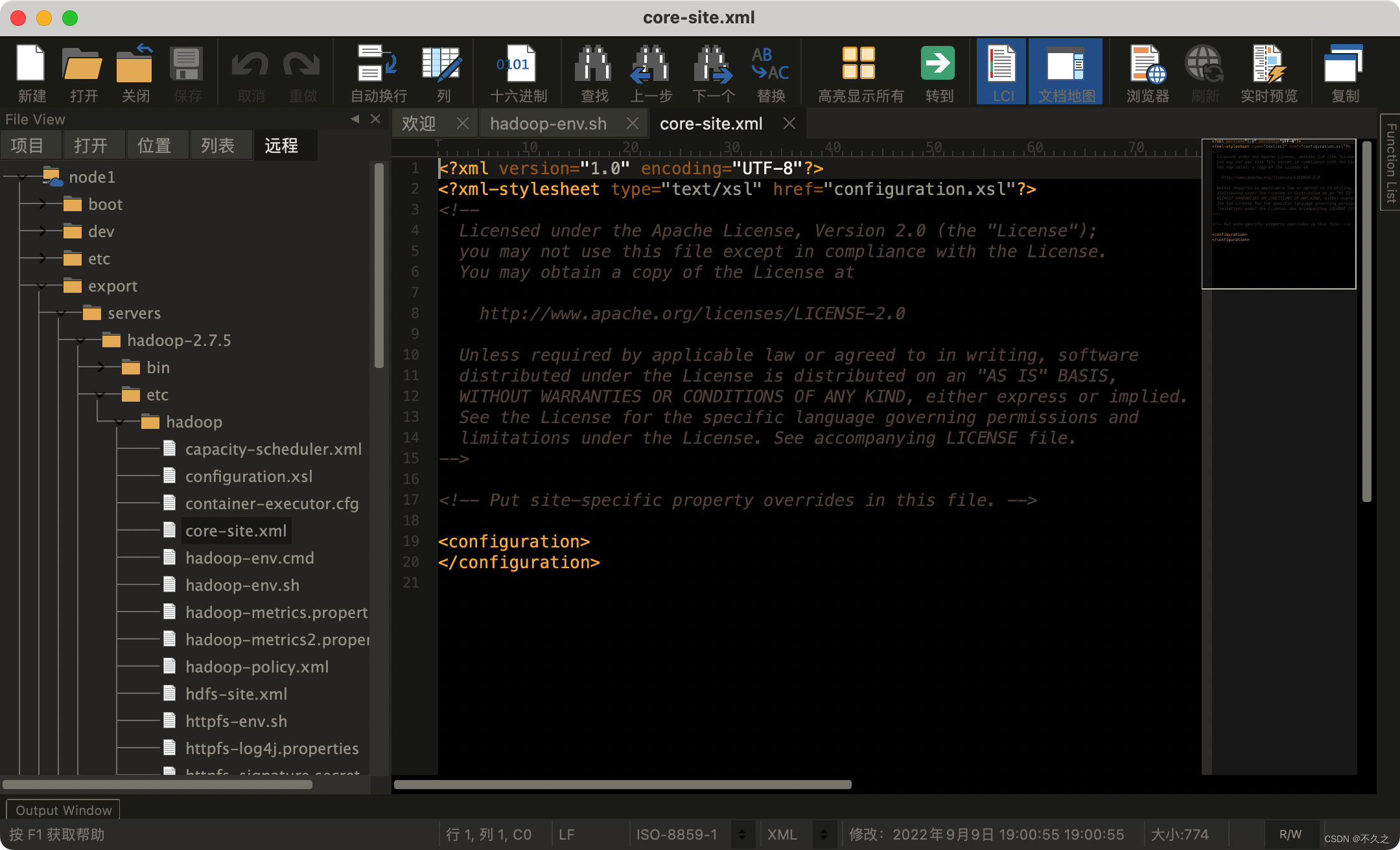

修改core-site.xml

第一台机器执行以下命令

cd /export/servers/hadoop-2.7.5/etc/hadoop

vim core-site.xml

<configuration>

<!--指定集群的文件系统类型:分布式文件系统-->

<property>

<name>fs.default.name</name>

<value>hdfs://node1:8020</value>

</property>

<!--指定临时文件存储目录-->

<property>

<name>hadoop.tmp.dir</name>

<value>/export/servers/hadoop-2.7.5/hadoopDatas/tempDatas</value>

</property>

<!-- 缓冲区大小,实际工作中根据服务器性能动态调整 -->

<property>

<name>io.file.buffer.size</name>

<value>4096</value>

</property>

<!-- 开启hdfs的垃圾桶机制,删除掉的数据可以从垃圾桶中回收,单位分钟 -->

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

</configuration>

修改hdfs-site.xml

第一台机器执行以下命令

cd /export/servers/hadoop-2.7.5/etc/hadoop

vim hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node1:50090</value>

</property>

<!-- 指定namenode的访问地址和端口 -->

<property>

<name>dfs.namenode.http-address</name>

<value>node1:50070</value>

</property>

<!-- 指定namenode的元数据的存放位置 -->

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///export/servers/hadoop-2.7.5/hadoopDatas/namenodeDatas,file:///export/servers/hadoop-2.7.5/hadoopDatas/namenodeDatas2</value