1.模型描述

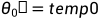

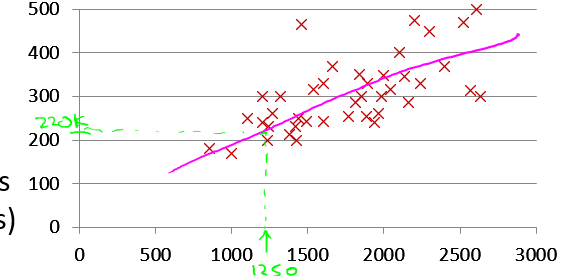

有训练集数据房子面积和卖出的价钱,我们用这组数据来模拟特定面积的房子能够卖出的价钱。

这是一个很明显的监督学习(supervised learning)的例子,因为我们的训练集里包含了正确的结果(即房子的卖价)。同时这也是典型的回归问题(regression),因为模型的输出是一个连续的数值。

下面定义模型中会用到的一些符号:

m:表示训练集中的数据个数

x:训练集中输入变量

y:训练集中输出变量

(x,y):训练集中的一个数据

:第i个训练集数据

如上图x(1)=2104,y(2)=232

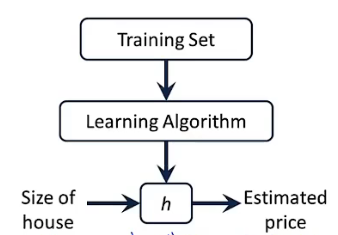

现在来看监督学习如何做这件事,我们首先向计算机提供训练集,计算机根据学习算法从训练集中学习数据特征并输出一个假设函数h(hypothesis function),h是一个x到y的映射函数。输入房子面积x来预测卖价y。

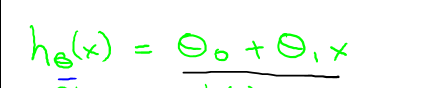

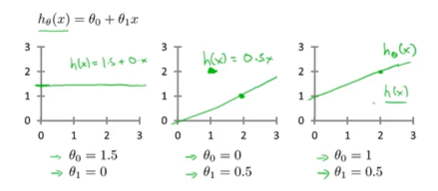

在这里,我们首先考虑最简单的情况,即房子的卖价与面积为一元线性函数关系:

我们现在要做的就是要找到合适的θ0和θ1来使得训练集中的数据到假设函数的距离最小,达到最好的拟合效果,那么如何找呢?

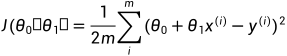

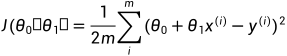

2.代价函数

我们需要一个具体的函数表达式来表示我们的假设函数

将

我们的目标就是要求出满足假设函数h到y最小距离的

需要特别注意的是,在假设函数

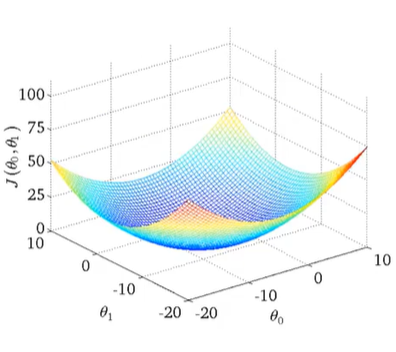

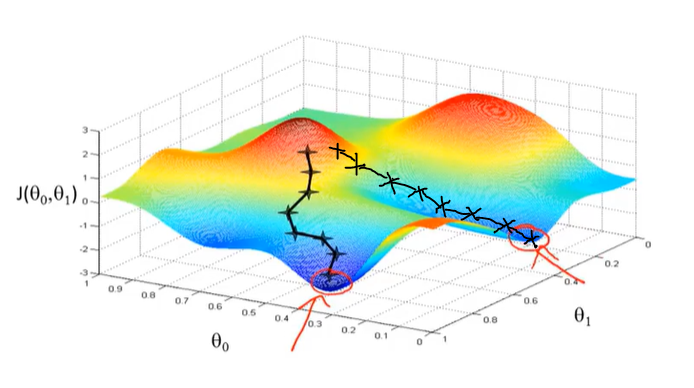

当我们有两个参数

从图中可以看出,对于同样高度的

为了得出满足该条件的

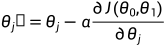

3.梯度下降算法

我们用梯度下降算法来最小化线性回归中的代价函数

算法的实施步骤:

我们首先将

,

赋初值,一般我们将两者都设为0

然后我们不断地改变

,

的值去减少

,直到我们得到最小值为止

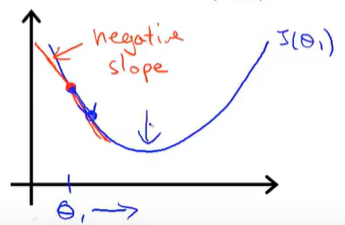

3.1梯度下降算法背后的数学原理

3.1.1 梗概

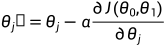

α为学习率(learning rate),也叫步长,可以形象的理解为上图下山过程中下山的步长,控制我们以多大的幅度来更新

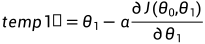

正确的求偏导方法为:同步更新,即根据给定的(

正确更新:

错误更新:

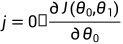

3.1.2 重点介绍偏导部分

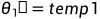

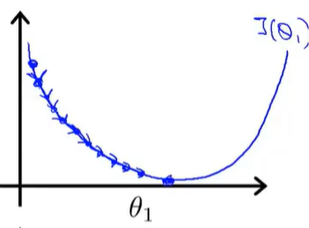

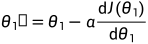

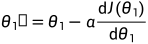

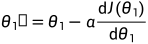

我们首先假设只有一个参数

同样的道理看下图:

3.1.4 学习率

下面我们来研究学习率

学习率太小

需要好几步才能到达局部最优点,效率低下。

学习率太大

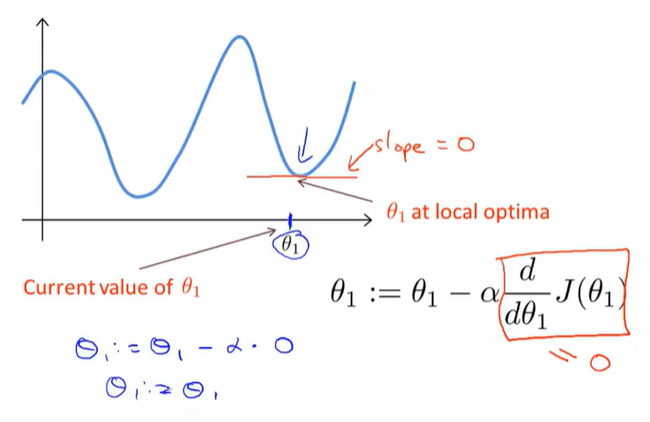

思考:如果

已处于局部最优点会怎么样?

如果

这也解释了即使学习率不变,梯度下降法也可以收敛到局部最低点的原因。因为:

根据梯度下降算法

因此我们在梯度下降算法中不必改变学习率。

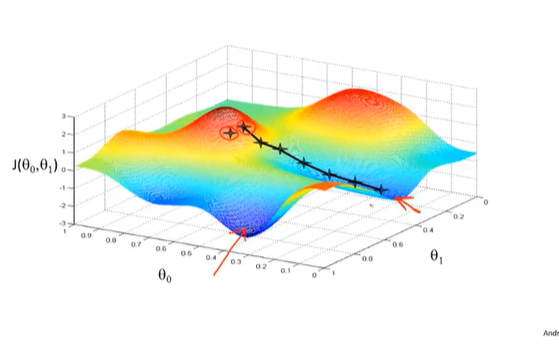

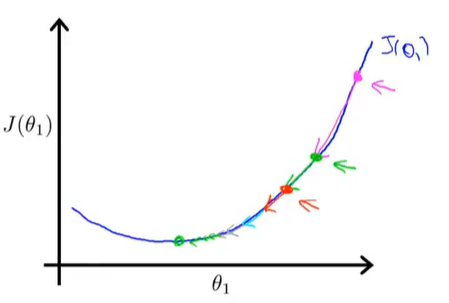

3.2 梯度下降所存在的问题

梯度下降存在一个问题,那就是容易陷入到局部最优。

如上图所示,从不同的位置出发(

在这样的代价函数上使用梯度下降,它总会收敛到全局最优,因为没有其他局部最优解。

这种每步梯度下降算法遍历所有训练集样本(

4.线性回归算法

在了解了代价函数和梯度下降算法后,我们就可以引出线性回归算法了。首先对前面的公式进行说明:

假设函数:

+

+

。假设函数是我们最后要得出的结果,根据假设函数可以预测一个

。假设函数是我们最后要得出的结果,根据假设函数可以预测一个 面积的房子可以卖多少钱

面积的房子可以卖多少钱 ,而想要得出假设函数就要得出

,而想要得出假设函数就要得出 ,

, 。

。

代价函数: 。代价函数用来对假设函数预测精度进行度量,判断假设函数的预测精度是否达到最优。(代价函数的值越小,假设函数的预测精度越高,拟合数据拟合的越好)

。代价函数用来对假设函数预测精度进行度量,判断假设函数的预测精度是否达到最优。(代价函数的值越小,假设函数的预测精度越高,拟合数据拟合的越好)

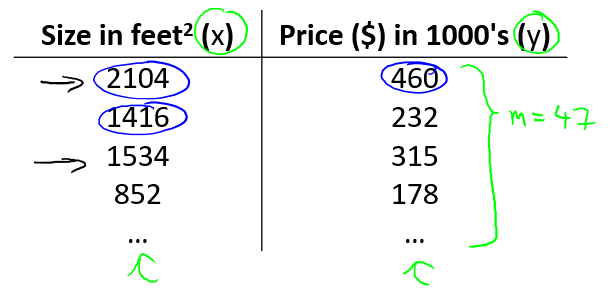

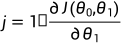

梯度下降: 。通过梯度下降来使得代价函数的值不断达到最优(局部最小值),从而找到最优的假设函数参数

。通过梯度下降来使得代价函数的值不断达到最优(局部最小值),从而找到最优的假设函数参数 ,

, 。

。 ,

, 的具体更新如下:

的具体更新如下:

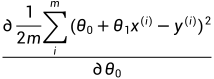

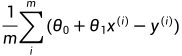

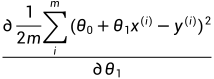

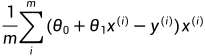

偏导函数:由代价函数 ,分别对

,分别对 ,

, 求偏导可得:

求偏导可得: =

= =

= ;

;

算法步骤:

首先我们给

,

赋初值,一般是

=0,

=0,得出假设函数。

根据假设函数计算代价函数的值。

计算偏导数带入梯度下降更新

,

(同时更新)。

根据新得到的

,

来更新假设函数。

重复2,3,4步,可以发现代价函数的值不断减小,假设函数对于数据的拟合效果越来越好,直至找到最佳的假设函数。