数据库层主要存放了向量数据库文件。同时,我们在该层实现了源数据处理、创建向量数据库的方法。

数据处理

为构建我们的本地知识库,我们需要对以多种类型存储的本地文档进行处理,读取本地文档并通过前文描述的 Embedding 方法将本地文档的内容转化为词向量来构建向量数据库。

一、源文档选取

将知识库源数据放置在../data_base/knowledge_db 目录下。

二、数据读取

1. PDF 文档

使用 LangChain 的 PyMuPDFLoader 来读取知识库的 PDF 文件。PyMuPDFLoader 是 PDF 解析器中速度最快的一种,结果会包含 PDF 及其页面的详细元数据,并且每页返回一个文档。

from langchain.document_loaders.pdf import PyMuPDFLoader

# 创建一个 PyMuPDFLoader Class 实例,输入为待加载的 pdf 文档路径

loader = PyMuPDFLoader("../../data_base/knowledge_db/pumkin_book/pumpkin_book.pdf")

# 调用 PyMuPDFLoader Class 的函数 load 对 pdf 文件进行加载

pdf_pages = loader.load()

文档加载后储存在 pages 变量中:

page的变量类型为List- 打印

pages的长度可以看到 pdf 一共包含多少页

print(f"载入后的变量类型为:{type(pdf_pages)},", f"该 PDF 一共包含 {len(pdf_pages)} 页")

载入后的变量类型为:<class 'list'>, 该 PDF 一共包含 196 页

page 中的每一元素为一个文档,变量类型为 langchain_core.documents.base.Document, 文档变量类型包含两个属性

page_content包含该文档的内容。meta_data为文档相关的描述性数据。

pdf_page = pdf_pages[1]

print(f"每一个元素的类型:{type(pdf_page)}.",

f"该文档的描述性数据:{pdf_page.metadata}",

f"查看该文档的内容:\n{pdf_page.page_content}",

sep="\n------\n")

每一个元素的类型:<class 'langchain_core.documents.base.Document'>.

------

该文档的描述性数据:{'source': './data_base/knowledge_db/pumkin_book/pumpkin_book.pdf', 'file_path': './data_base/knowledge_db/pumkin_book/pumpkin_book.pdf', 'page': 1, 'total_pages': 196, 'format': 'PDF 1.5', 'title': '', 'author': '', 'subject': '', 'keywords': '', 'creator': 'LaTeX with hyperref', 'producer': 'xdvipdfmx (20200315)', 'creationDate': "D:20230303170709-00'00'", 'modDate': '', 'trapped': ''}

------2. MD 文档

我们可以以几乎完全一致的方式读入 markdown 文档:

from langchain.document_loaders.markdown import UnstructuredMarkdownLoader

loader = UnstructuredMarkdownLoader("../../data_base/knowledge_db/prompt_engineering/1. 简介 Introduction.md")

md_pages = loader.load()

读取的对象和 PDF 文档读取出来是完全一致的:

print(f"载入后的变量类型为:{type(md_pages)},", f"该 Markdown 一共包含 {len(md_pages)} 页")

载入后的变量类型为:<class 'list'>, 该 Markdown 一共包含 1 页

md_page = md_pages[0]

print(f"每一个元素的类型:{type(md_page)}.",

f"该文档的描述性数据:{md_page.metadata}",

f"查看该文档的内容:\n{md_page.page_content[0:][:200]}",

sep="\n------\n")

每一个元素的类型:<class 'langchain_core.documents.base.Document'>.

------

该文档的描述性数据:{'source': './data_base/knowledge_db/prompt_engineering/1. 简介 Introduction.md'}

------

三、数据清洗

我们期望知识库的数据尽量是有序的、优质的、精简的,因此我们要删除低质量的、甚至影响理解的文本数据。可以看到上文中读取的pdf文件不仅将一句话按照原文的分行添加了换行符\n,也在原本两个符号中间插入了\n,使用正则表达式匹配并删除掉\n。

import re

pattern = re.compile(r'[^\u4e00-\u9fff](\n)[^\u4e00-\u9fff]', re.DOTALL)

pdf_page.page_content = re.sub(pattern, lambda match: match.group(0).replace('\n', ''), pdf_page.page_content)

print(pdf_page.page_content)

进一步分析数据,数据中还有不少的•和空格,用replace方法即可。

pdf_page.page_content = pdf_page.page_content.replace('•', '')

pdf_page.page_content = pdf_page.page_content.replace(' ', '')

print(pdf_page.page_content)

上文中读取的md文件每一段中间隔了一个换行符,同样可以使用replace方法去除。

md_page.page_content = md_page.page_content.replace('\n\n', '\n')

print(md_page.page_content)

四、文档分割

由于单个文档的长度往往会超过模型支持的上下文,导致检索得到的知识太长超出模型的处理能力,因此,在构建向量知识库的过程中,我们往往需要对文档进行分割,将单个文档按长度或者按固定的规则分割成若干个 chunk,然后将每个 chunk 转化为词向量,存储到向量数据库中。

在检索时,我们会以 chunk 作为检索的元单位,也就是每一次检索到 k 个 chunk 作为模型可以参考来回答用户问题的知识,这个 k 是我们可以自由设定的。

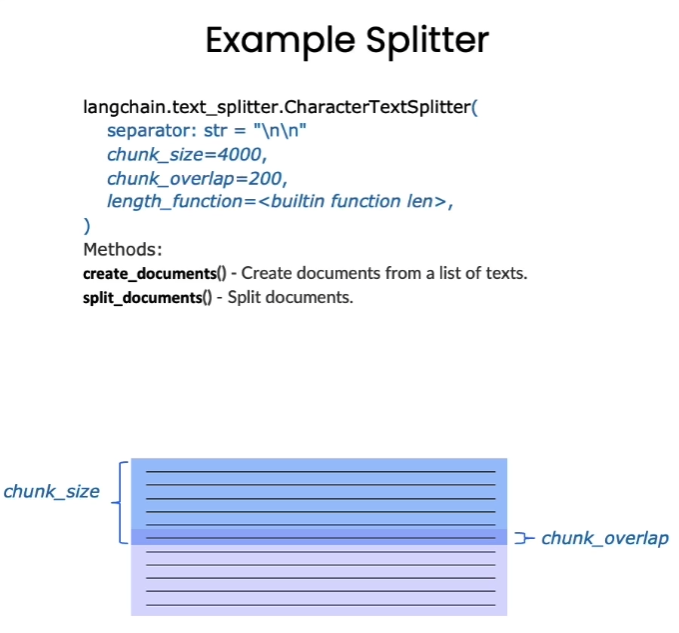

Langchain 中文本分割器都根据 chunk_size (块大小)和 chunk_overlap (块与块之间的重叠大小)进行分割。

-

chunk_size 指每个块包含的字符或 Token (如单词、句子等)的数量

-

chunk_overlap 指两个块之间共享的字符数量,用于保持上下文的连贯性,避免分割丢失上下文信息

Langchain 提供多种文档分割方式,区别在怎么确定块与块之间的边界、块由哪些字符/token组成、以及如何测量块大小

- RecursiveCharacterTextSplitter(): 按字符串分割文本,递归地尝试按不同的分隔符进行分割文本。

- CharacterTextSplitter(): 按字符来分割文本。

- MarkdownHeaderTextSplitter(): 基于指定的标题来分割markdown 文件。

- TokenTextSplitter(): 按token来分割文本。

- SentenceTransformersTokenTextSplitter(): 按token来分割文本

- Language(): 用于 CPP、Python、Ruby、Markdown 等。

- NLTKTextSplitter(): 使用 NLTK(自然语言工具包)按句子分割文本。

- SpacyTextSplitter(): 使用 Spacy按句子的切割文本。

'''

* RecursiveCharacterTextSplitter 递归字符文本分割

RecursiveCharacterTextSplitter 将按不同的字符递归地分割(按照这个优先级["\n\n", "\n", " ", ""]),

这样就能尽量把所有和语义相关的内容尽可能长时间地保留在同一位置

RecursiveCharacterTextSplitter需要关注的是4个参数:

* separators - 分隔符字符串数组

* chunk_size - 每个文档的字符数量限制

* chunk_overlap - 两份文档重叠区域的长度

* length_function - 长度计算函数

'''

#导入文本分割器

from langchain.text_splitter import RecursiveCharacterTextSplitter

# 知识库中单段文本长度 CHUNK_SIZE = 500 # 知识库中相邻文本重合长度 OVERLAP_SIZE = 50

# 使用递归字符文本分割器

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=CHUNK_SIZE,

chunk_overlap=OVERLAP_SIZE

)

text_splitter.split_text(pdf_page.page_content[0:1000])

['前言\n“周志华老师的《机器学习》(西瓜书)是机器学习领域的经典入门教材之一,周老师为了使尽可能多的读\n者通过西瓜书对机器学习有所了解,所以在书中对部分公式的推导细节没有详述,但是这对那些想深究公式推\n导细节的读者来说可能“不太友好”,本书旨在对西瓜书里比较难理解的公式加以解析,以及对部分公式补充\n具体的推导细节。”\n读到这里,大家可能会疑问为啥前面这段话加了引号,因为这只是我们最初的遐想,后来我们了解到,周\n老师之所以省去这些推导细节的真实原因是,他本尊认为“理工科数学基础扎实点的大二下学生应该对西瓜书\n中的推导细节无困难吧,要点在书里都有了,略去的细节应能脑补或做练习”。所以......本南瓜书只能算是我\n等数学渣渣在自学的时候记下来的笔记,希望能够帮助大家都成为一名合格的“理工科数学基础扎实点的大二\n下学生”。\n使用说明\n南瓜书的所有内容都是以西瓜书的内容为前置知识进行表述的,所以南瓜书的最佳使用方法是以西瓜书\n为主线,遇到自己推导不出来或者看不懂的公式时再来查阅南瓜书;对于初学机器学习的小白,西瓜书第1章和第2章的公式强烈不建议深究,简单过一下即可,等你学得',

'有点飘的时候再回来啃都来得及;每个公式的解析和推导我们都力(zhi)争(neng)以本科数学基础的视角进行讲解,所以超纲的数学知识\n我们通常都会以附录和参考文献的形式给出,感兴趣的同学可以继续沿着我们给的资料进行深入学习;若南瓜书里没有你想要查阅的公式,\n或者你发现南瓜书哪个地方有错误,\n请毫不犹豫地去我们GitHub的\nIssues(地址:https://github.com/datawhalechina/pumpkin-book/issues)进行反馈,在对应版块\n提交你希望补充的公式编号或者勘误信息,我们通常会在24小时以内给您回复,超过24小时未回复的\n话可以微信联系我们(微信号:at-Sm1les);\n配套视频教程:https://www.bilibili.com/video/BV1Mh411e7VU\n在线阅读地址:https://datawhalechina.github.io/pumpkin-book(仅供第1版)\n最新版PDF获取地址:https://github.com/datawhalechina/pumpkin-book/releases\n编委会',

'编委会\n主编:Sm1les、archwalk']

split_docs = text_splitter.split_documents(pdf_pages)

print(f"切分后的文件数量:{len(split_docs)}")

切分后的文件数量:720

print(f"切分后的字符数(可以用来大致评估 token 数):{sum([len(doc.page_content) for doc in split_docs])}")

切分后的字符数(可以用来大致评估 token 数):308931

搭建并使用向量数据库

一、前序配置

import os

from dotenv import load_dotenv, find_dotenv

# 读取本地/项目的环境变量。

# find_dotenv()寻找并定位.env文件的路径

# load_dotenv()读取该.env文件,并将其中的环境变量加载到当前的运行环境中

# 如果你设置的是全局的环境变量,这行代码则没有任何作用。

_ = load_dotenv(find_dotenv())

# 如果你需要通过代理端口访问,你需要如下配置

# os.environ['HTTPS_PROXY'] = 'http://127.0.0.1:7890'

# os.environ["HTTP_PROXY"] = 'http://127.0.0.1:7890'

# 获取folder_path下所有文件路径,储存在file_paths里

file_paths = []

folder_path = '../../data_base/knowledge_db'

for root, dirs, files in os.walk(folder_path):

for file in files:

file_path = os.path.join(root, file)

file_paths.append(file_path)

print(file_paths[:3])

['../../data_base/knowledge_db/prompt_engineering/6. 文本转换 Transforming.md', '../../data_base/knowledge_db/prompt_engineering/4. 文本概括 Summarizing.md', '../../data_base/knowledge_db/prompt_engineering/5. 推断 Inferring.md']

from langchain.document_loaders.pdf import PyMuPDFLoader

from langchain.document_loaders.markdown import UnstructuredMarkdownLoader

# 遍历文件路径并把实例化的loader存放在loaders里

loaders = []

for file_path in file_paths:

file_type = file_path.split('.')[-1]

if file_type == 'pdf':

loaders.append(PyMuPDFLoader(file_path))

elif file_type == 'md':

loaders.append(UnstructuredMarkdownLoader(file_path))

# 下载文件并存储到text texts = [] for loader in loaders: texts.extend(loader.load())

载入后的变量类型为langchain_core.documents.base.Document, 文档变量类型同样包含两个属性

page_content包含该文档的内容。meta_data为文档相关的描述性数据。

text = texts[1]

print(f"每一个元素的类型:{type(text)}.",

f"该文档的描述性数据:{text.metadata}",

f"查看该文档的内容:\n{text.page_content[0:]}",

sep="\n------\n")

每一个元素的类型:<class 'langchain_core.documents.base.Document'>.

------

该文档的描述性数据:{'source': '../../data_base/knowledge_db/prompt_engineering/4. 文本概括 Summarizing.md'}

------from langchain.text_splitter import RecursiveCharacterTextSplitter

# 切分文档

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=500, chunk_overlap=50)

split_docs = text_splitter.split_documents(texts)

二、构建Chroma向量库

Langchain 集成了超过 30 个不同的向量存储库。选择 Chroma 是因为它轻量级且数据存储在内存中,这使得它非常容易启动和开始使用。

LangChain 可以直接使用 OpenAI 和百度千帆的 Embedding,同时,我们也可以针对其不支持的 Embedding API 进行自定义,我们基于 LangChain 提供的接口,封装一个 zhupuai_embedding,来将智谱的 Embedding API 接入到 LangChain 中。

在此之后,确保通过运行 vectordb.persist 来持久化向量数据库。

vectordb.persist()

print(f"向量库中存储的数量:{vectordb._collection.count()}")

向量库中存储的数量:20

三、向量检索

3.1 相似度检索

Chroma的相似度搜索使用的是余弦距离,即: $$ similarity = cos(A, B) = \frac{A \cdot B}{\parallel A \parallel \parallel B \parallel} = \frac{\sum_1^n a_i b_i}{\sqrt{\sum_1^n a_i^2}\sqrt{\sum_1^n b_i^2}} $$ 其中$a_i$、$b_i$分别是向量$A$、$B$的分量。

当你需要数据库返回严谨的按余弦相似度排序的结果时可以使用similarity_search函数。

question="什么是大语言模型"

sim_docs = vectordb.similarity_search(question,k=3)

print(f"检索到的内容数:{len(sim_docs)}")

检索到的内容数:3

for i, sim_doc in enumerate(sim_docs):

print(f"检索到的第{i}个内容: \n{sim_doc.page_content[:200]}", end="\n--------------\n")

3.2 MMR检索

如果只考虑检索出内容的相关性会导致内容过于单一,可能丢失重要信息。

最大边际相关性 (MMR, Maximum marginal relevance) 可以帮助我们在保持相关性的同时,增加内容的丰富度。

核心思想是在已经选择了一个相关性高的文档之后,再选择一个与已选文档相关性较低但是信息丰富的文档。这样可以在保持相关性的同时,增加内容的多样性,避免过于单一的结果。

mmr_docs = vectordb.max_marginal_relevance_search(question,k=3)

for i, sim_doc in enumerate(mmr_docs):

print(f"MMR 检索到的第{i}个内容: \n{sim_doc.page_content[:200]}", end="\n--------------\n")

MMR 检索到的第0个内容:

第六章 文本转换

大语言模型具有强大的文本转换能力,可以实现多语言翻译、拼写纠正、语法调整、格式转换等不同类型的文本转换任务。利用语言模型进行各类转换是它的典型应用之一。

在本章中,我们将介绍如何通过编程调用API接口,使用语言模型实现文本转换功能。通过代码示例,读者可以学习将输入文本转换成所需输出格式的具体方法。

掌握调用大语言模型接口进行文本转换的技能,是开发各种语言类应用的重要一步。文

--------------

MMR 检索到的第1个内容:

"This phrase is to cherck chatGPT for spelling abilitty" # spelling

]

--------------

MMR 检索到的第2个内容:

room.

room. Yes, adults also like pandas

too.

too. She takes it everywhere with her, and it's super soft and

cute. One

cute. However, one of the ears is a bit lower than the other, and I don't t

--------------