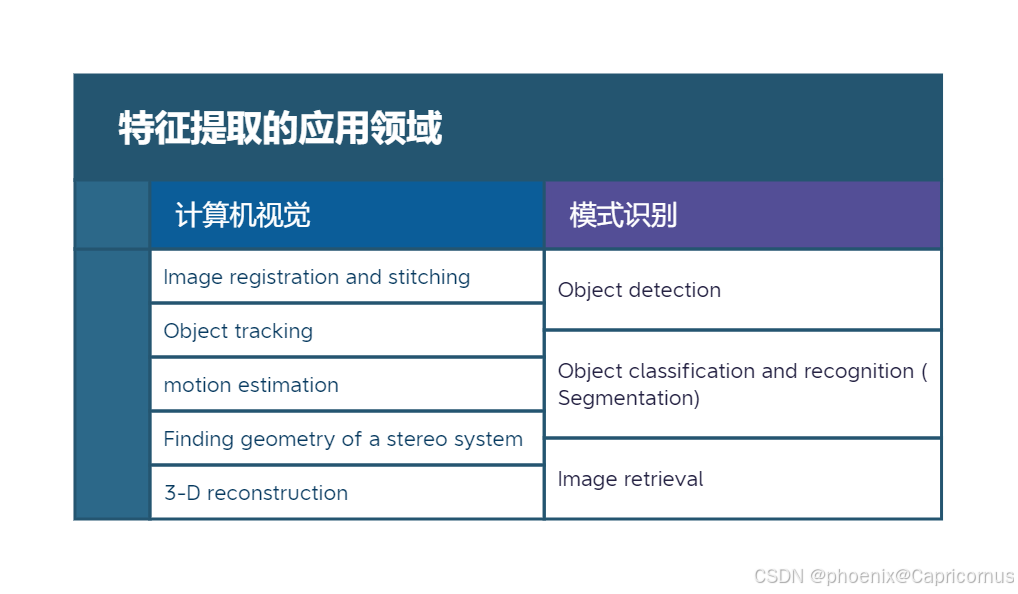

模式识别和计算机视觉是特征提取的两大重要应用领域,在近几十年特征提取方法发展迅速。

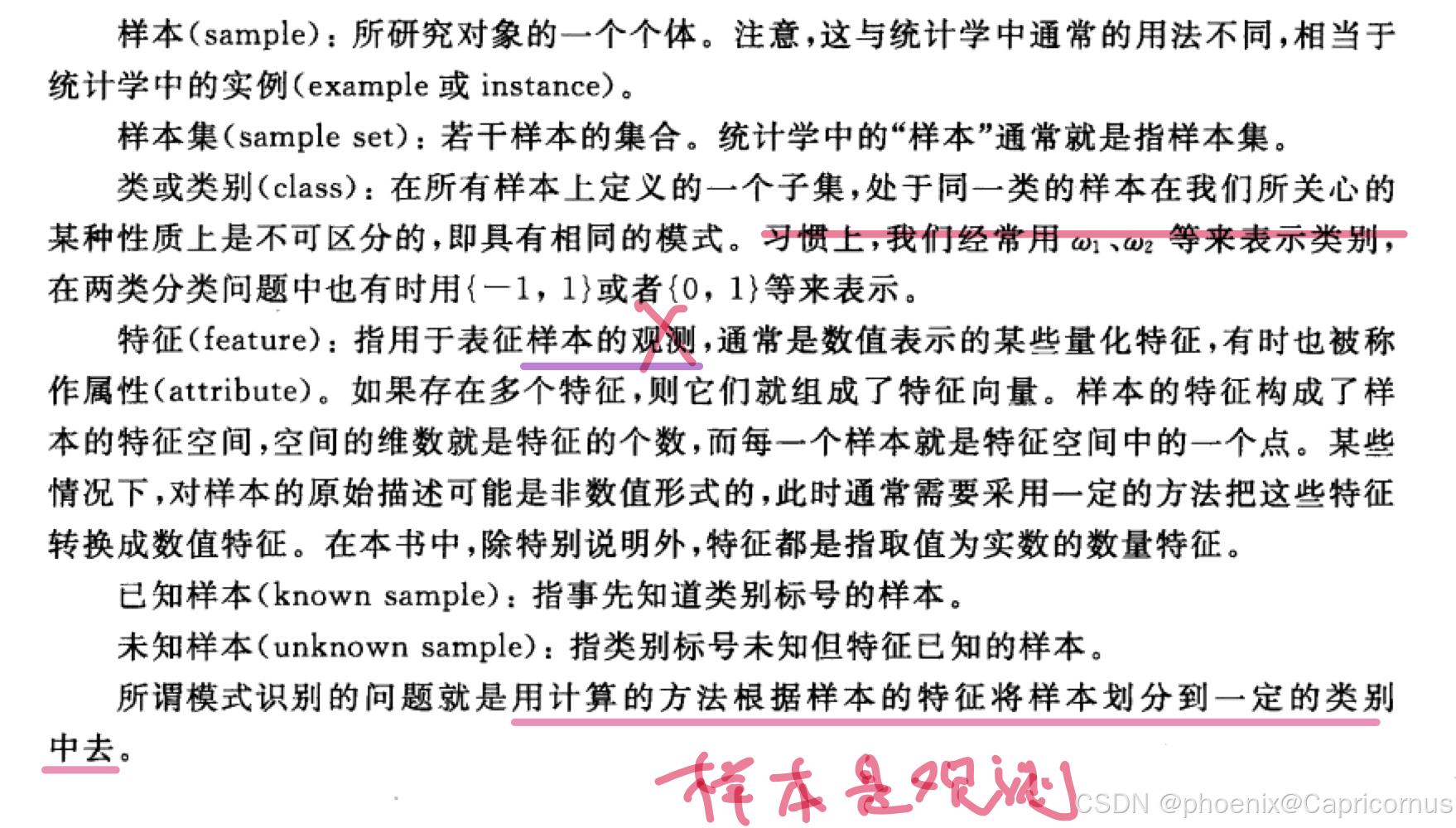

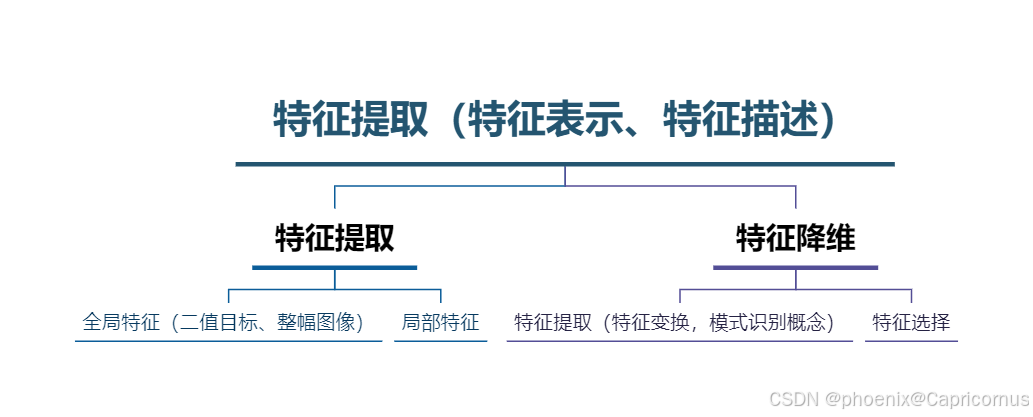

特征提取,那首先是特征和特征提取的概念。

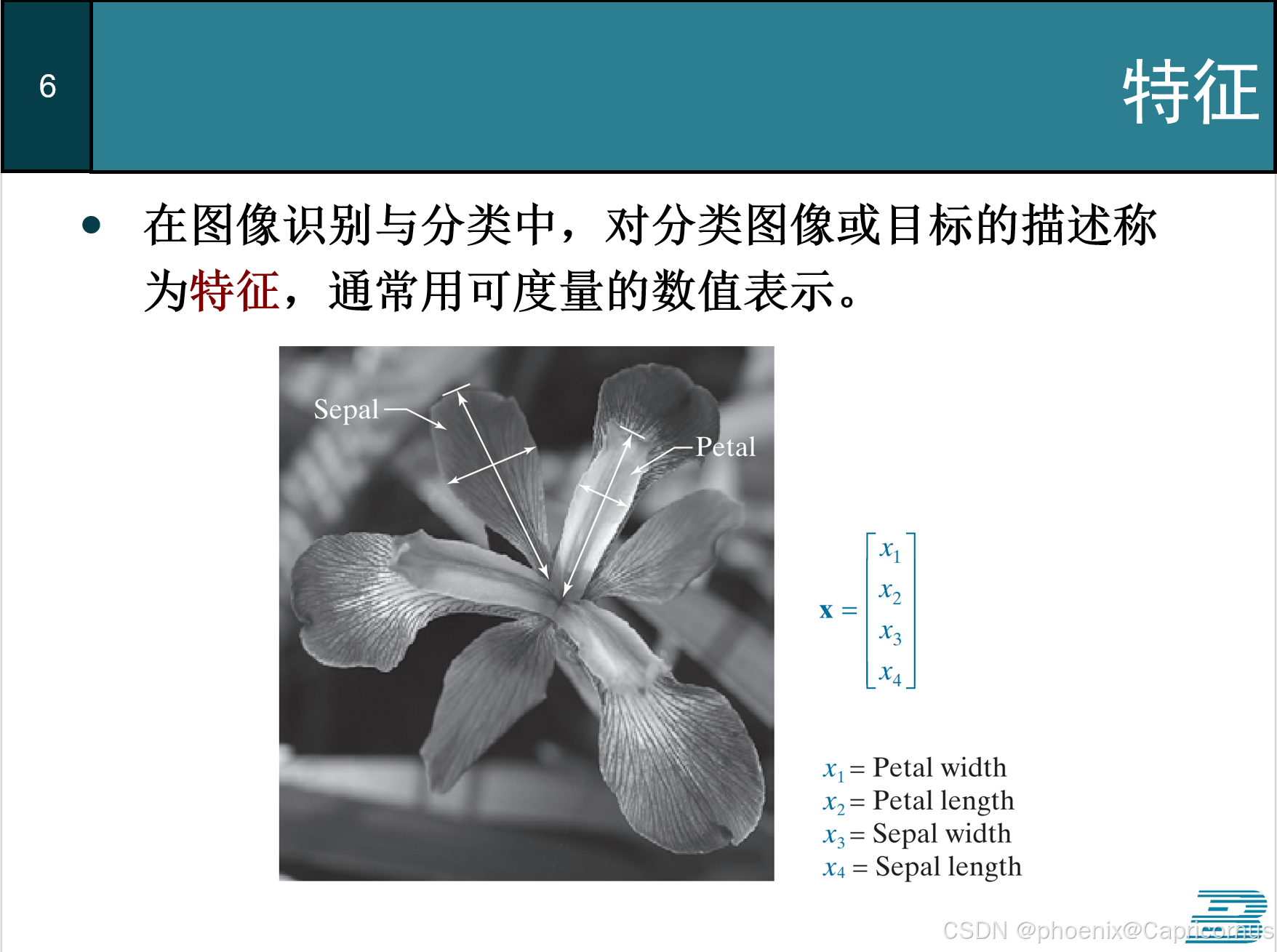

特征

特征是对事物或事件的描述,样本就是观测。所以某人这个概念是错的。

特征提取

由于学科交叉,特征提取这个术语就出现了混淆。在这幅图中出现了三次。第一个和第二个可以分为广义和狭义的概念。广义的特征提取包括特征降维,尤其是在深度学习出现后。特征提取的结果是可以直接用于分类的特征向量。狭义的特征提取是对事物或事件进行描述。第三个特征提取是模式识别中的概念,是对特征进行线性或非线性变换,因此也叫特征变换。建议模式识别学科不要使用特征提取这么大的词,也不顾名思义。

Rafael Gonzalez和Richard Woods的《数字图像处理》前两版中,这一章的标题是表示与描述,里面的方法又是过时的特征提取方法,我一直不明白这章想干嘛,等我终于想明白这章原来就是特征提取的时候,他把名字也改成特征提取了。

特征降维

特征降维是特征提取(Feature Extraction)中的一个重要组成部分,特征降维指的是减少数据集中特征的数量,同时尽量保持数据集的信息量。

降维很重要很重要。

- 减少计算复杂性:较少的特征意味着训练模型时需要的计算资源会减少,这可以加快模型训练的速度。

- 避免过拟合:过多的特征可能导致模型过于复杂,从而容易过拟合训练数据。通过减少不必要的特征,可以帮助提高模型的泛化能力。

- 改善模型性能:去除噪声特征或者高度相关的特征有助于简化模型结构,有时还能提升预测性能。

- 可视化:对于高维数据来说,很难直接进行可视化。特征降维可以将数据降至2维或3维,便于直观理解数据分布。

特征降维可以通过两种主要方法来实现:特征选择(Feature Selection)和特征变换(Feature Transformation)。

特征选择 (Feature Selection)

特征选择是从原始特征中挑选出最具代表性的子集,直接去除无关或冗余的特征。这样做的好处是保留下来的特征具有明确的意义,并且模型更容易解释。

- 过滤法(Filter Methods):基于统计测试来评估每个特征与目标变量之间的关系,独立于任何机器学习算法。常见的例子包括卡方检验、互信息等。

- 包裹法(Wrapper Methods):使用预测模型的表现作为评价标准,尝试不同的特征组合,通过搜索算法如递归特征消除(RFE)、遗传算法等找到最优特征集合。

- 嵌入法(Embedded Methods):将特征选择过程集成到模型训练过程中,利用模型自身的重要性度量来筛选特征,例如LASSO回归中的L1正则化、决策树的重要性分数等。

特征变换 (Feature Transformation)

特征变换不是简单地从现有特征中选择一个子集,而是创建一个新的特征空间,其中的特征可能是原有特征的线性或非线性组合。这种方法可能改变特征原有的物理意义,但能更有效地捕捉数据内部结构。

- 主成分分析(PCA, Principal Component Analysis):寻找数据变化最大的方向,并将数据投影到这些方向上,以达到降维的目的。

- 线性判别分析(LDA, Linear Discriminant Analysis):在分类问题中,不仅考虑最大化类间差异,还最小化类内差异。

- 核PCA(Kernel PCA):通过应用核函数将数据映射到高维空间,然后再进行PCA操作,适用于非线性可分的数据。

- t-SNE (t-distributed Stochastic Neighbor Embedding):一种用于可视化高维数据的技术,特别适合于发现数据的局部结构。

- 自动编码器(Autoencoders):一种神经网络模型,它尝试学习一个从输入到输出的恒等函数,中间层通常比输入层小,以此实现降维。常用于无监督特征学习。

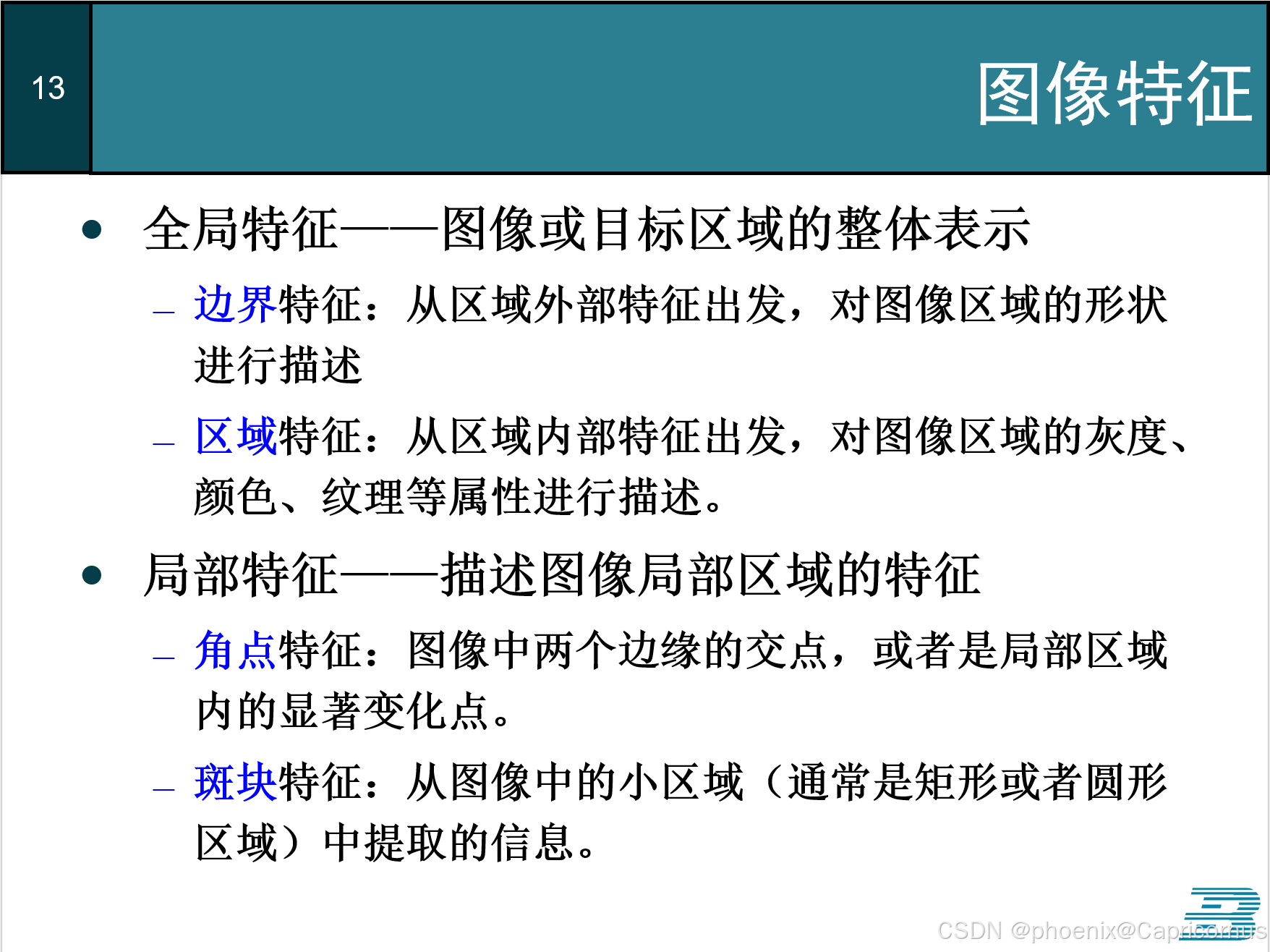

全局特征和局部特征

图像特征可分为全局特征和局部特征。

Rafael Gonzalez和Richard Woods的《数字图像处理》中,这部分的描述荒谬且离谱,不知道他怎么想的。

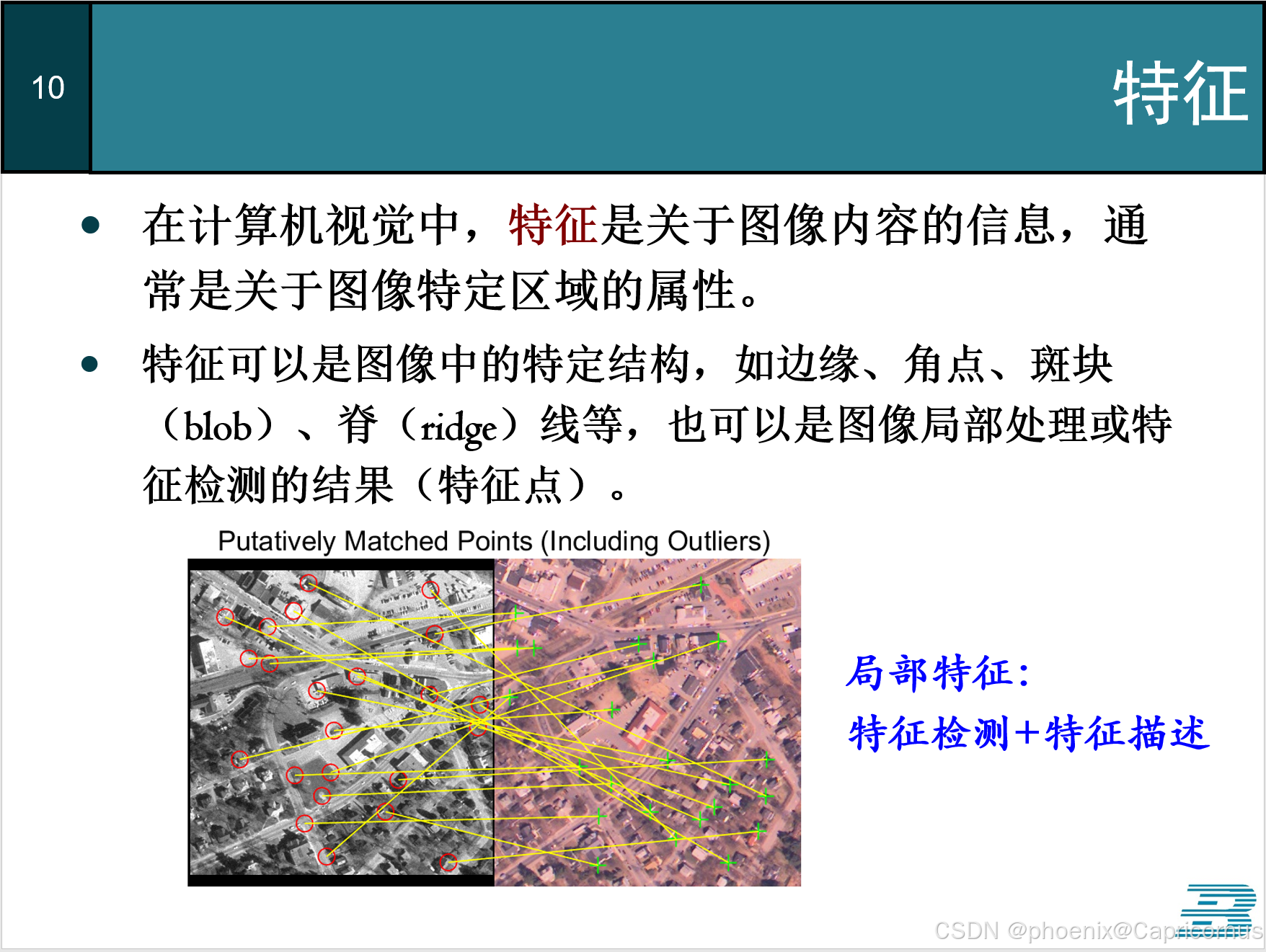

特征检测+特征描述

在视觉中,特征一般都是局部特征,而且特征提取包括特征检测的内容。

具体内容参见

禹晶、肖创柏、廖庆敏《数字图像处理(面向新工科的电工电子信息基础课程系列教材)》P308