大家好,我是木易,一个持续关注AI领域的互联网技术产品经理,国内Top2本科,美国Top10 CS研究生,MBA。我坚信AI是普通人变强的“外挂”,专注于分享AI全维度知识,包括但不限于AI科普,AI工具测评,AI效率提升,AI行业洞察。关注我,AI之路不迷路,2025我们继续出发。

这是一份由AI工程社区Latent Space发布的阅读清单,其中精选了50篇AI工程领域极具价值的论文、模型和博客,覆盖了十大AI工程核心模块,旨在帮助AI工程师和爱好者构建系统的AI知识体系,提升实战能力。

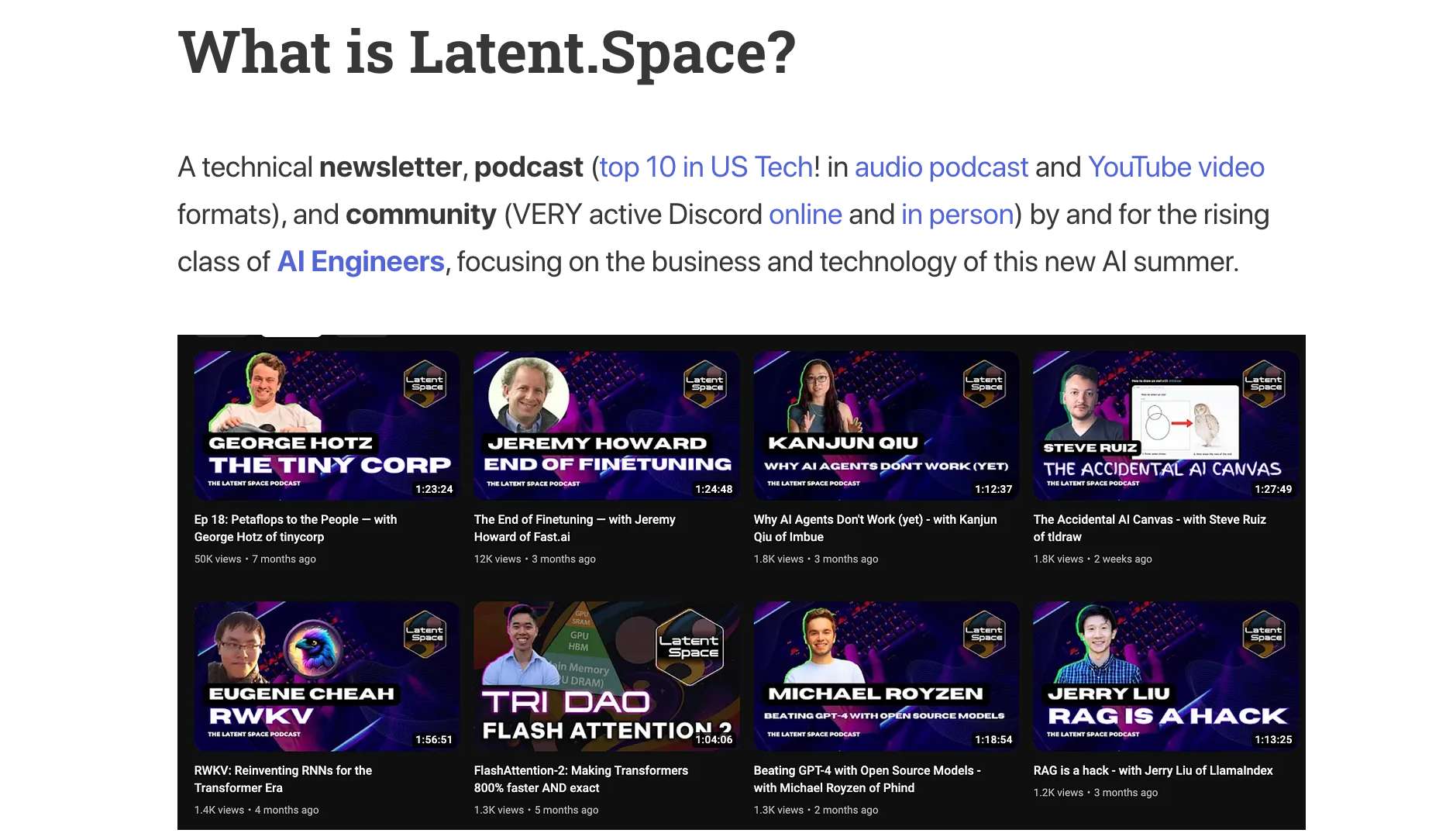

关于 Latent Space

Latent Space是一个专注于AI工程领域的技术社区,以其高质量的时事通讯、顶尖播客(在美国技术类播客中排名前十!) 和活跃的线上线下社区而闻名,被誉为“排名第一的AI工程播客”。Latent Space在X平台拥有13.1K的关注者,其中包括Elon Musk和知名播客主持人Lex Fridman!

话不多说,我们直接开始。

1. 前沿 LLM

这一部分聚焦于大语言模型 (LLM),包括 GPT 系列 (特别是 GPT-4o 的系统卡片)、Claude 3 系列、Gemini 系列等,以及 LLaMA 系列等开源模型。

清单:

OpenAI 系列:引领多次技术革新

-

GPT-1:

https://cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf(开启了预训练语言模型的新时代) -

GPT-2:

https://cdn.openai.com/better-language-models/language_models_are_unsupervised_multitask_learners.pdf(展示了大语言模型的能力) -

GPT-3:

https://arxiv.org/abs/2005.14165(里程碑式模型,具备少样本学习能力) -

Codex:

https://arxiv.org/abs/2107.03374(专注于代码生成) -

InstructGPT:

https://arxiv.org/abs/2203.02155(通过人类反馈强化学习,提升了模型的指令遵循能力) -

GPT-4 Technical Report:

https://arxiv.org/abs/2303.08774(经典多模态模型) -

GPT 3.5:

https://openai.com/index/chatgpt/(曾经 ChatGPT 背后的模型) -

GPT-4o:

https://openai.com/index/hello-gpt-4o/(最新发布,支持更强的多模态实时交互) -

o1:

https://openai.com/index/introducing-openai-o1-preview/(第一代推理模型) -

o3:

https://openai.com/index/deliberative-alignment/(第二代推理模型)

Anthropic 系列:OpenAI 有力竞争者之一

-

Claude 3:

https://www-cdn.anthropic.com/de8ba9b01c9ab7cbabf5c33b80b7bbc618857627/Model_Card_Claude_3.pdf(在多个评估基准上表现优异) -

Claude 3.5 Sonnet:

https://www.anthropic.com/news/claude-3-5-sonnet(最新模型,性能和速度进一步提升)

Google 系列:性能和多模态方面表现突出

-

Gemini 1:

https://arxiv.org/abs/2312.11805(多模态大模型,支持文本、图像、音频等多种输入) -

Gemini 2.0 Flash:

https://blog.google/technology/google-deepmind/google-gemini-ai-update-december-2024/#gemini-2-0-flash(更轻量级、更快速的版本) -

Gemini 2.0 Flash Thinking:

https://ai.google.dev/gemini-api/docs/thinking-mode(解锁模型的推理能力) -

Gemma 2:

https://arxiv.org/abs/2408.00118(Google 最新的开源模型)

Meta 系列:开源和高性能

-

LLaMA:

https://arxiv.org/abs/2302.13971(开源大语言模型的先驱) -

Llama 2:

https://arxiv.org/abs/2307.09288(性能大幅提升,支持商用) -

Llama 3:

https://arxiv.org/abs/2407.21783(最新开源模型,性能达到当前 SOTA 水平)

Mistral AI 系列:欧洲的OpenAI

-

Mistral 7B:

https://arxiv.org/abs/2310.06825(小而美的典范) -

Mixtral of Experts:

https://arxiv.org/abs/2401.04088(采用 MOE 架构) -

Pixtral 12B:

https://arxiv.org/abs/2410.07073(120亿参数的多模态模型)

DeepSeek 系列:中国AI领域的当红炸子鸡

-

DeepSeek V1:

https://arxiv.org/abs/2401.02954(DeepSeek 一代) -

DeepSeek Coder:

https://arxiv.org/abs/2401.14196(专注于代码生成) -

DeepSeek MoE:

https://arxiv.org/abs/2401.06066(DeepSeek MoE) -

DeepSeek V2:

https://arxiv.org/abs/2405.04434(DeepSeek 二代) -

DeepSeek V3:

https://github.com/deepseek-ai/DeepSeek-V3(DeepSeek 最新最强模型)

Apple 系列:端侧智能

-

Apple Intelligence:

https://arxiv.org/abs/2407.21075(苹果入局,端侧智能)

2. 基准测试和评估

如何客观衡量AI模型的“智商”?这一部分将介绍主流的模型评估基准测试和评估框架。就像真实世界里学生的考试,基准测试可以相对客观地评估AI模型在特定任务上的能力,帮助我们更好地理解模型的优缺点。

清单:

通用知识与推理能力评估

评估模型在各学科知识领域的理解和推理能力。

-

MMLU (Massive Multitask Language Understanding):

https://arxiv.org/abs/2009.03300(应用最广泛的知识型测试之一,涵盖 57 个学科,包括人文、STEM、社科等) -

MMLU Pro (Professional-Level MMLU):

https://arxiv.org/abs/2406.01574(MMLU 的升级版,难度更高,更接近专业水平测试) -

GPQA & GPQA Diamond:

https://arxiv.org/abs/2311.12022(针对研究生水平的问题进行测试,题目质量和难度极高, GPQA Diamond 是其增强版本) -

BIG-Bench:

https://arxiv.org/abs/2206.04615(包含 200 多个不同类型的任务,全面评估模型的各项能力) -

BIG-Bench Hard:

https://arxiv.org/abs/2210.09261(BIG-Bench 的增强版本,筛选了最具挑战性的任务)

长文本推理能力评估

评估模型处理长文本和进行复杂推理的能力。

-

MuSR (Multi-Step Reasoning):

https://arxiv.org/abs/2310.16049(评估模型在长文档中进行多步推理的能力) -

LongBench:

https://arxiv.org/abs/2412.15204(多任务、中英双语、长文本理解的基准测试) -

BABILong:

https://arxiv.org/abs/2406.10149(合成的长文本推理数据集) -

Lost in the Middle:

https://arxiv.org/abs/2307.03172(研究长文本中信息的利用情况) -

Needle in a Haystack:

https://github.com/gkamradt/LLMTest_NeedleInAHaystack(“大海捞针”测试,评估模型从长文本中提取关键信息的能力)

数学能力评估

评估模型的数学推理和解题能力。

-

MATH:

https://arxiv.org/abs/2103.03874(包含 12,500 道竞赛级别数学题目,涵盖代数、几何、概率等多个领域) -

AIME (American Invitational Mathematics Examination):

https://www.kaggle.com/datasets/hemishveeraboina/aime-problem-set-1983-2024(美国数学邀请赛,难度介于 AMC 和 IMO 之间) -

FrontierMath:

https://arxiv.org/abs/2411.04872(更关注高级数学推理能力,例如大学数学竞赛题目) -

AMC10 & AMC12:

https://github.com/ryanrudes/amc(美国数学竞赛,AMC10 面向 10 年级及以下学生,AMC12 面向 12 年级及以下学生)

指令遵循能力评估

评估模型理解和执行指令的能力。

-

IFEval (Instruction Following Evaluation):

https://arxiv.org/abs/2311.07911(评估模型遵循各种类型指令的能力) -

MT-Bench (Multi-Turn Benchmark):

https://arxiv.org/abs/2306.05685(多轮对话场景下评估模型的指令遵循能力)

抽象推理能力评估

评估模型的抽象推理和模式识别能力。

-

ARC AGI (Abstraction and Reasoning Corpus):

https://arcprize.org/arc(评估模型的通用智能,挑战模型像人类一样进行抽象推理)

3. 提示工程、上下文学习和思维链

如何通过提示词技术来引导模型生成更符合需求的结果?这一部分介绍提示工程、上下文学习 (ICL) 和思维链 (Chain of Thought) 等技术,帮助我们更好地与AI模型进行交互。

清单:

实战教程

-

The Prompt Report:

https://arxiv.org/abs/2406.06608(最新的提示工程综述报告) -

Lilian Weng 的博客:

https://lilianweng.github.io/posts/2023-03-15-prompt-engineering/(Lilian Weng 对提示工程的系统性总结) -

Eugene Yan 的博客:

https://eugeneyan.com/writing/prompting/(Eugene Yan 分享的提示工程技巧) -

Anthropic 的提示工程教程:

https://github.com/anthropics/prompt-eng-interactive-tutorial(Anthropic官方带你一步步学习如何构建高效的提示) -

AI Engineer Workshop:

https://www.youtube.com/watch?v=hkhDdcM5V94(提示工程实战经验分享的视频)

核心技术

-

Chain-of-Thought (CoT):

https://arxiv.org/abs/2201.11903(思维链技术的开山之作) -

Scratchpads:

https://arxiv.org/abs/2112.00114(为模型提供“草稿纸”,提升其推理能力) -

Let’s Think Step By Step:

https://arxiv.org/abs/2205.11916(经典提示词,思维链技术的标志性语句) -

Tree of Thoughts (ToT):

https://arxiv.org/abs/2305.10601(思维树,增强模型的推理和规划能力) -

Prompt Tuning:

https://aclanthology.org/2021.emnlp-main.243/(软提示/Soft Prompt,调整模型的行为) -

Prefix-Tuning:

https://arxiv.org/abs/2101.00190(添加可训练的前缀/Prefix,实现模型输出的调优) -

Adjust Decoding:

https://arxiv.org/abs/2402.10200(通过调整解码策略来提高模型性能) -

Representation Engineering:

https://vgel.me/posts/representation-engineering/(表征工程,通过直接修改模型的隐藏状态来引导生成)

自动提示工程

-

Automatic Prompt Engineering (APE):

https://arxiv.org/abs/2211.01910(自动生成和优化提示) -

DSPy:

https://arxiv.org/abs/2310.03714(DSPy 框架,通过编程,而非手动编写提示词,来构建复杂的 AI 系统)

4. 检索增强生成 (RAG)

RAG,全称 Retrieval-Augmented Generation,结合了检索和生成模型的优势,利用外部知识库来增强模型的性能。这一部分介绍 Meta 的 RAG 论文、MTEB 嵌入基准测试、GraphRAG 等,以及 RAGAS 评估框架。向量数据库 作为目前 RAG 应用的重要基础设施,也推荐了解。

清单:

基础理论

-

Introduction to Information Retrieval:

https://nlp.stanford.edu/IR-book/information-retrieval-book.html(信息检索领域的 经典教材) -

Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks:

https://arxiv.org/abs/2005.11401(Meta 的 RAG 论文,RAG 技术的开山之作) -

RAG 2.0:

https://contextual.ai/introducing-rag2/(RAG 技术的演进)

核心技术

-

HyDE (Hypothetical Document Embeddings):

https://docs.llamaindex.ai/en/stable/optimizing/advanced_retrieval/query_transformations/(通过假设性文档增强查询效果) -

Chunking:

https://research.trychroma.com/evaluating-chunking(分块策略) -

Rerank:

https://cohere.com/blog/rerank-3pt5(重排,优化检索结果的排序) -

MTEB (Massive Text Embedding Benchmark):

https://arxiv.org/abs/2210.07316(评估文本嵌入模型性能的基准测试)

高级技术

-

GraphRAG:

https://arxiv.org/pdf/2404.16130(结合知识图谱和 RAG,提升 RAG 的知识推理能力) -

RAGAS:

https://arxiv.org/abs/2309.15217(评估 RAG 系统性能的自动化框架)

实践指南

-

LlamaIndex:

https://docs.llamaindex.ai/en/stable/understanding/rag/(LlamaIndex 提供的 RAG 实战教程和工具) -

LangChain:

https://python.langchain.com/docs/tutorials/rag/(LangChain 提供的 RAG 的集成方案和示例代码)

5. 智能体 (AI Agent)

2025年的大热门,AI的未来形态,能够像人类一样感知环境、做出决策并采取行动。这一部分介绍 SWE-Bench、ReAct、MemGPT、Voyager 等重要的智能体相关论文。

-

清单:

基准测试

-

SWE-Bench:

https://arxiv.org/abs/2310.06770(评估 Agent 解决真实世界 GitHub 软件工程问题的能力) -

SWE-Agent:

https://arxiv.org/abs/2405.15793(基于LLM的软件工程师Agent) -

SWE-Bench Multimodal:

https://arxiv.org/abs/2410.03859(多模态 SWE-Bench) -

Konwinski Prize:

https://kprize.ai/(奖励在软件工程自动化方面有突出贡献的 Agent)

核心技术

-

ReAct: Synergizing Reasoning and Acting in Language Models:

https://arxiv.org/abs/2210.03629(ReAct 框架, 结合了推理 (Reasoning) 和行动 (Acting)) -

MemGPT: Towards LLMs as Operating Systems:

https://arxiv.org/abs/2310.08560(赋予 Agent 长期记忆能力) -

MetaGPT: The Multi-Agent Framework:

https://arxiv.org/abs/2308.00352(多智能体元编程框架, 通过角色分配和协作,使多个 Agent 能够像一个团队一样工作) -

AutoGen: Enabling Next-Gen LLM Applications via Multi-Agent Conversation:

https://arxiv.org/abs/2308.08155(微软的开源框架,支持通过定义和组合多个 Agent 来构建复杂的 LLM 应用) -

Smallville: Generative Agents: Interactive Simulacra of Human Behavior:

https://arxiv.org/abs/2304.03442&https://github.com/joonspk-research/generative_agents(来自斯坦福和谷歌, 创建具有社交行为的模拟智能体) -

Voyager: An Open-Ended Embodied Agent with Large Language Models:

https://arxiv.org/abs/2305.16291(NVIDIA 的 Minecraft Agent, 能够在 Minecraft 世界中持续学习、探索和发现) -

Agent Workflow Memory:

https://arxiv.org/abs/2409.07429(通过引入工作流记忆机制来提高Agent的规划和执行能力)

实践指南

-

Building Effective Agents:

https://www.anthropic.com/research/building-effective-agents(Anthropic 分享的构建高效 Agent 的实践经验和思考) -

OpenAI Swarm:

https://github.com/openai/swarm(OpenAI 推出的多智能体工具)

6. 代码生成

这一部分介绍 The Stack 代码数据集、HumanEval/Codex 基准测试、AlphaCodeium 论文等。

-

清单:

数据集

-

The Stack:

https://arxiv.org/abs/2211.15533(大规模、多语言的源代码数据集,3 TB)

代码生成模型

-

DeepSeek-Coder:

https://arxiv.org/abs/2401.14196(DeepSeek-Coder 模型论文) -

Code Llama:

https://ai.meta.com/research/publications/code-llama-open-foundation-models-for-code/(Meta 开源的一系列代码生成模型) -

Qwen2.5-Coder:

https://arxiv.org/abs/2409.12186(通义千问2.5系列的代码生成模型) -

AlphaCodium:

https://arxiv.org/abs/2401.08500(DeepMind 开发的代码生成模型)

评估基准

-

HumanEval/Codex:

https://arxiv.org/abs/2107.03374(评估代码生成模型解决基本编程问题的能力) -

Aider:

https://aider.chat/docs/leaderboards/(Aider 整理的多个代码生成基准测试的排行榜) -

Codeforces:

https://arxiv.org/abs/2312.02143(用于评估模型的竞赛级编程能力) -

BigCodeBench:

https://huggingface.co/spaces/bigcode/bigcodebench-leaderboard(BigCode 项目推出的代码生成多维度评估套件) -

LiveCodeBench:

https://livecodebench.github.io/(关注代码生成模型输出的正确性和运行时行为) -

SciCode:

https://buttondown.com/ainews/archive/ainews-to-be-named-5745/(评估代码生成模型在科学计算领域的性能)

AI代码审查

-

CriticGPT:

https://criticgpt.org/criticgpt-openai/(OpenAI 内部用来帮助人类程序员发现代码缺陷的工具)

7. 视觉模型

这一部分介绍 CLIP、Segment Anything Model 等视觉模型,以及多模态大模型的发展趋势。

-

清单:

目标检测

-

YOLO (You Only Look Once):

https://arxiv.org/abs/1506.02640(经典的目标检测模型,以速度和准确性而闻名) -

DETRs Beat YOLOs on Object Detection:

https://arxiv.org/abs/2304.08069(DETR 系列模型,一种基于 Transformer 的目标检测方法,性能更优)

视觉-语言预训练

-

CLIP (Contrastive Language-Image Pre-training):

https://arxiv.org/abs/2103.00020(OpenAI 的里程碑式工作,通过对比学习将图像和文本联系起来) -

MMVP Benchmark: Multimodal Video Pretraining for Video Action Recognition:

https://arxiv.org/abs/2401.06209(多模态视频基准测试)

图像分割

-

Segment Anything Model (SAM):

https://arxiv.org/abs/2304.02643(Meta 的图像分割模型,可以通过提示 (prompt) 分割出图像中的任意物体)

多模态大模型

-

Flamingo: a Visual Language Model for Few-Shot Learning:

https://huyenchip.com/2023/10/10/multimodal.html(DeepMind 的多模态模型,支持少样本学习) -

Chameleon: Mixed-Modal Early-Fusion Foundation Models:

https://arxiv.org/abs/2405.09818(Meta 的多模态模型, 采用早融合的方式) -

GPT-4V system card:

https://cdn.openai.com/papers/GPTV_System_Card.pdf(GPT-4V 的系统卡片)

8. 语音模型

从语音识别到语音合成,AI 正在改变我们与机器交互的方式。这一部分介绍 Whisper、AudioPaLM、NaturalSpeech 等语音模型,以及相关的应用案例。

-

清单:

语音识别 (ASR)

-

Whisper:

https://arxiv.org/abs/2212.04356(OpenAI 开源的语音识别模型,支持多种语言)

语音合成 (TTS)

-

NaturalSpeech:

https://arxiv.org/abs/2205.04421(微软的高质量语音合成模型)

语音大模型

-

AudioPaLM:

https://audiopalm.github.io/(Google 的音频-文本多模态大模型,可以处理和生成音频和文本内容)

实时语音技术

-

Kyutai Moshi:

https://arxiv.org/html/2410.00037v2(支持全双工语音-文本转换的开源模型,低延迟) -

OpenAI Realtime API:

https://platform.openai.com/docs/guides/realtime(OpenAI 推出的实时 API)

9. 图像/视频模型

Stable Diffusion、Sora 等生成模型,让我们看到了 AI 在图像和视频生成方面的巨大潜力。这一部分介绍图像和视频模型相关的论文,以及 ComfyUI 等工具。

-

清单:

扩散模型 (Diffusion Models)

-

Latent Diffusion Models:

https://arxiv.org/abs/2112.10752(Stable Diffusion 的核心技术) -

Consistency Models:

https://arxiv.org/abs/2303.01469(引入一致性约束,加快扩散模型的采样速度,大幅减少采样步骤) -

DiT (Diffusion Transformers):

https://arxiv.org/abs/2212.09748(Sora 的核心技术, 将 Transformer 架构应用于扩散模型,为生成高质量视频奠定了基础)

图像生成模型

-

DALL-E:

https://arxiv.org/abs/2102.12092(OpenAI 的开创性工作,根据文本描述生成图像) -

DALL-E 2:

https://arxiv.org/abs/2204.06125(DALL-E 的升级版,生成图像的分辨率和质量更高) -

DALL-E 3:

https://cdn.openai.com/papers/dall-e-3.pdf(进一步提升图像生成质量,并更好地理解和遵循文本描述) -

Imagen:

https://arxiv.org/abs/2205.11487(Google 的文本到图像生成模型) -

Imagen 2:

https://deepmind.google/technologies/imagen-2/(Imagen 的升级版,支持更多样化的图像编辑功能) -

Imagen 3:

https://arxiv.org/abs/2408.07009(Google 最新的图像生成模型)

视频生成模型

-

Sora:

https://openai.com/index/sora/(OpenAI 的文本转视频生成模型,现已发布)

工具

-

ComfyUI:

https://github.com/comfyanonymous/ComfyUI(基于节点流程的 Stable Diffusion WebUI, 提供了灵活可控的图像和视频生成流程)

10. 模型微调

如何根据特定领域的特定需求来定制化模型?这部分介绍 LoRA/QLoRA、DPO 等微调技术,以及如何利用这些技术来提高模型的性能。

-

清单:

参数高效微调 (Parameter-Efficient Fine-Tuning, PEFT)

-

LoRA: Low-Rank Adaptation of Large Language Models:

https://arxiv.org/abs/2106.09685(参数高效微调的经典之作,通过低秩适配器在大型语言模型中插入少量可训练参数,即可实现高效微调) -

QLoRA: Efficient Finetuning of Quantized LLMs:

http://arxiv.org/abs/2305.14314(将 LoRA 与 4 位量化相结合,进一步降低了微调所需的计算资源)

偏好对齐微调 (Preference Alignment Fine-Tuning)

-

DPO: Direct Preference Optimization: Your Language Model is Secretly a Reward Model:

https://arxiv.org/abs/2305.18290(一种直接优化策略的算法,无需训练奖励模型即可将 LLM 与人类偏好对齐) -

ReFT: Representation Finetuning for Language Models:

https://arxiv.org/abs/2404.03592(通过微调模型的隐藏层表征来进行模型对齐, 可作为 DPO 的补充)

数据构建

-

Orca 3/AgentInstruct: Agentic Instruction Generation

https://www.microsoft.com/en-us/research/blog/orca-agentinstruct-agentic-flows-can-be-effective-synthetic-data-generators/(利用智能体生成指令数据来进行模型微调)

强化学习微调 (RL Fine-Tuning)

-

RL Finetuning for o1:

https://www.interconnects.ai/p/openais-reinforcement-finetuning(OpenAI 近期推出的基于强化学习的微调技术) -

Let’s Verify Step By Step:

https://arxiv.org/abs/2305.20050(通过逐步验证的方式,提升 RLHF 的效果)

教程

-

How to fine-tune open LLMs:

https://www.philschmid.de/fine-tune-llms-in-2025(一份实用的 LLM 微调教程)

结语

学而时习之,不亦说乎?!

精选推荐

都读到这里了,点个赞鼓励一下吧,小手一赞,年薪百万!😊👍👍👍。关注我,AI之路不迷路,原创技术文章第一时间推送🤖。