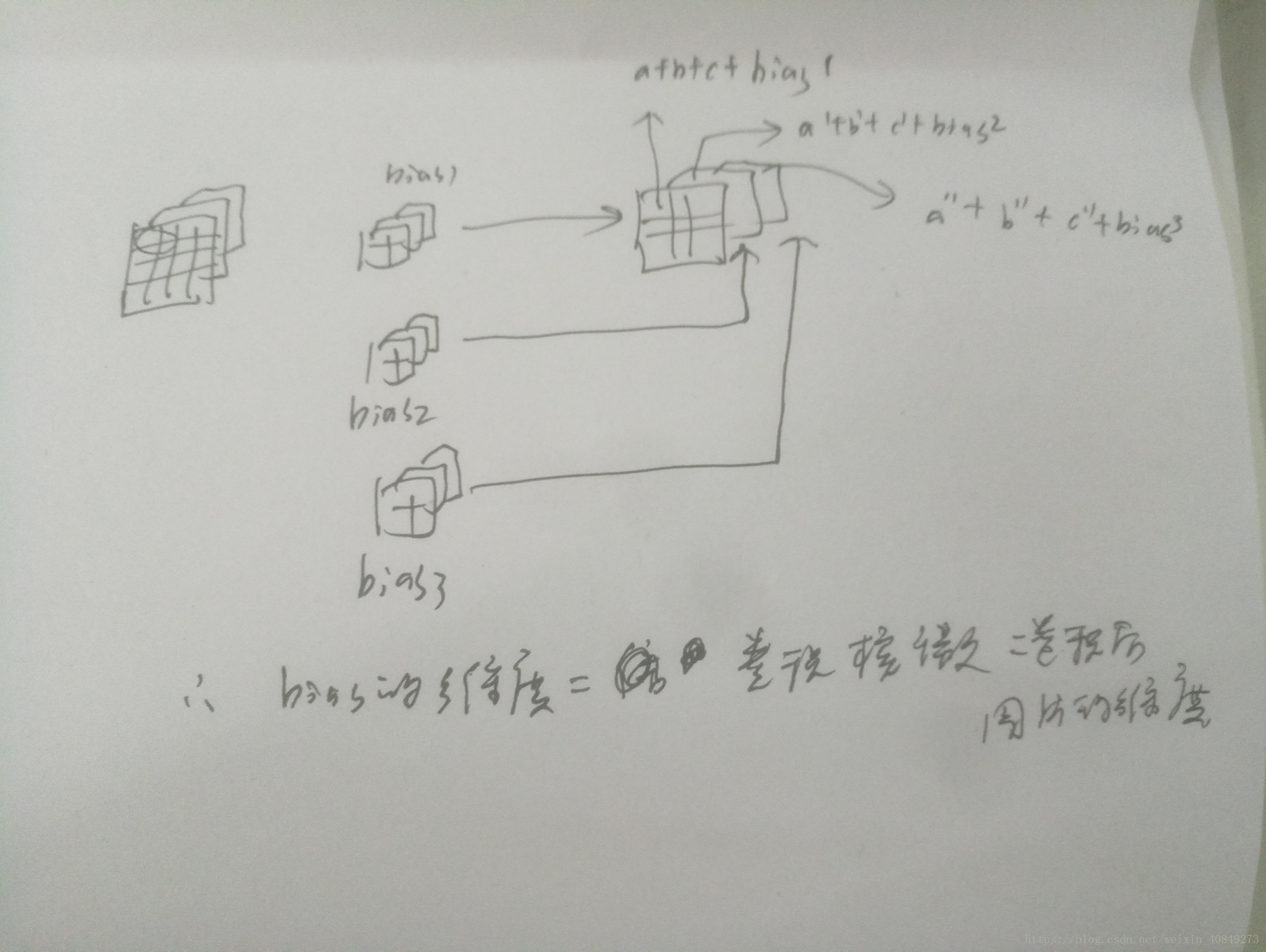

每走一步,得到的图片的值为a+b+c+bias,其中a为卷积核在第一个信道上卷积的值,b为卷积和在第二个信道上卷积的值,c为卷积核在第三个信道上卷积的值,将他们加起来再加上偏置。

而在TensorFlow中为什么用conv1_biases = tf.get_variable("bias",[CONV1_DEEP],initiallizer=tf.constant_initializer(0.0))中

的CONV1_DEEP也就是卷积后的深度来表示偏置的参数呢,是因为卷积后的图片的信道数对应

以下图片介绍为什么偏置的维度等于卷积核个数: