📖标题:Fast Video Generation with SLIDING TILE ATTENTION

🌐来源:arXiv, 2502.04507

🌟摘要

🔸具有3D全注意力的扩散变换器(DiTs)能够生成最先进的视频,但计算成本过高——当生成一个5秒的720P视频时,仅注意力就需要945秒的总推理时间中的800秒。

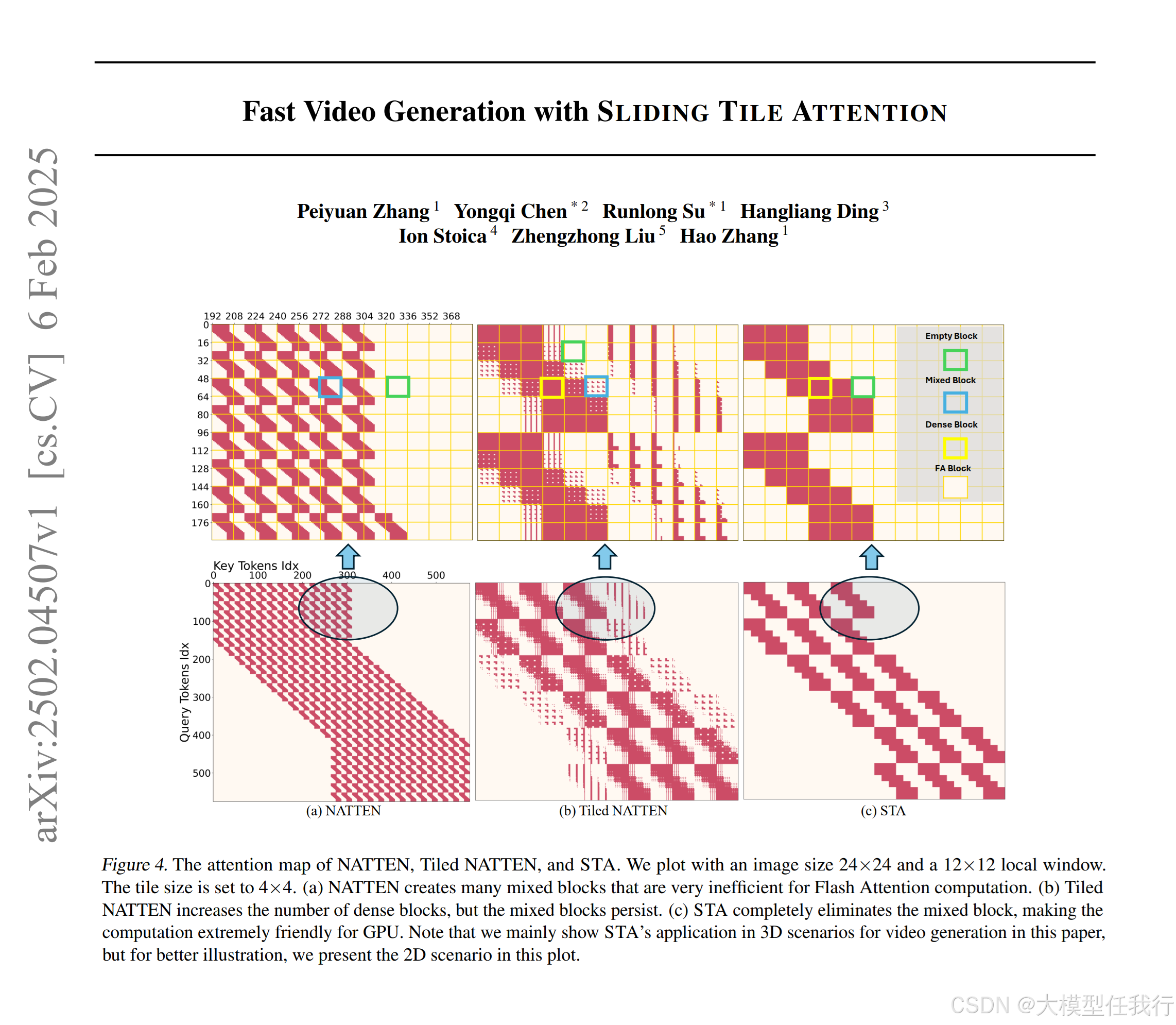

🔸本文引入滑动窗口注意力(STA)来解决这一挑战。STA利用了预训练视频扩散模型中的注意力得分主要集中在局部3D窗口内的观察结果。通过在局部时空区域上滑动和关注,STA消除了全神贯注的冗余。与传统的令牌式滑动窗口注意力(SWA)不同,STA采用新颖的硬件感知滑动窗口设计逐块操作,在保持硬件效率的同时保持表现力。

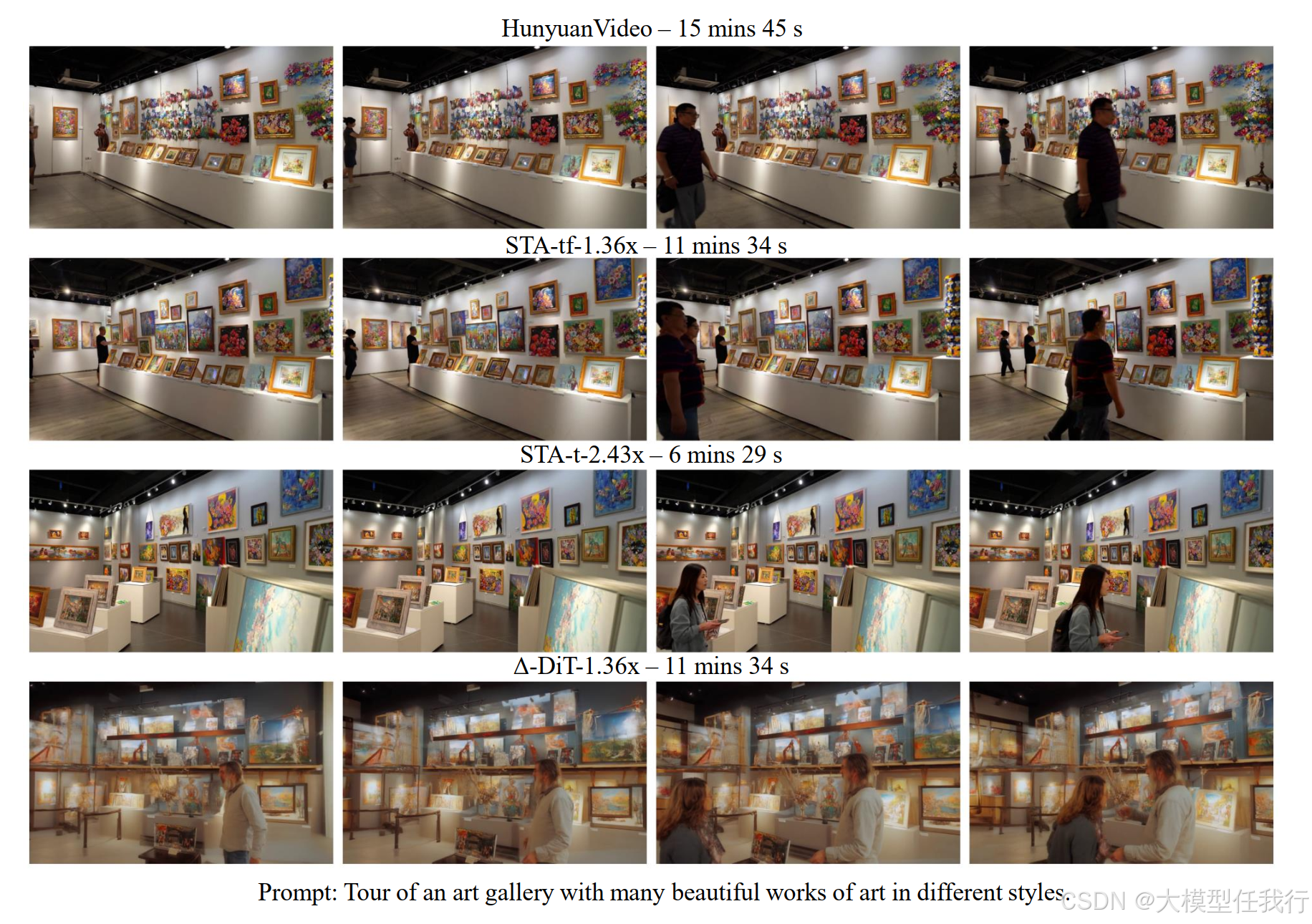

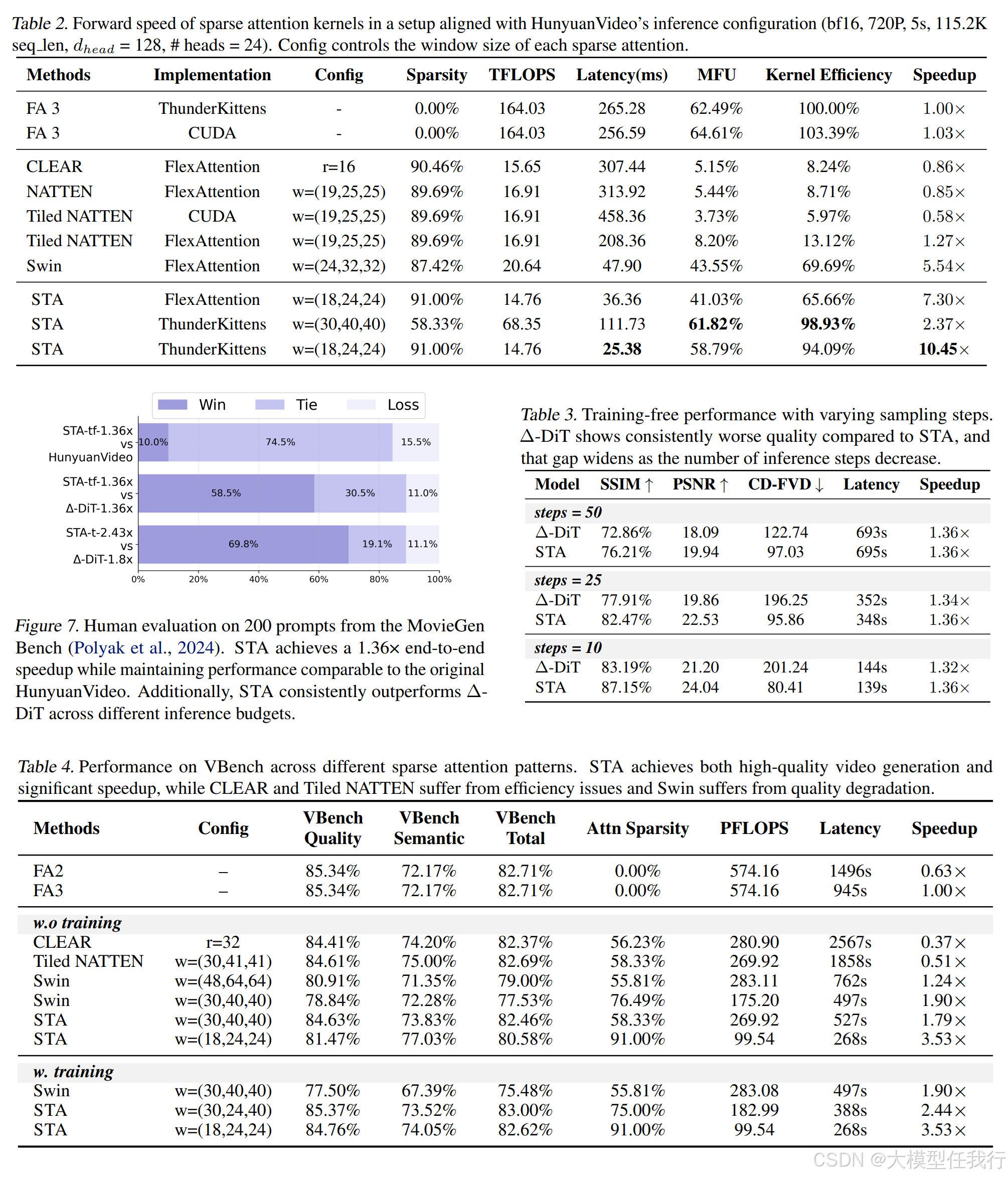

🔸通过仔细的内核级优化,STA提供了第一个高效的2D/3D滑动窗口式注意力实现,实现了58.79%的MFU。准确地说,STA的注意力比FlashAttention-2(FA2)提高了2.8-17倍,比FlashAttntion-3(FA3)提高了1.6-10倍。在领先的视频DiT HunyuanVideo上,STA将端到端延迟从945秒(FA3)降低到685秒,而不会降低质量,不需要训练。启用微调进一步将延迟降低到268秒,VBench上的延迟仅下降了0.09%。

🛎️文章简介

🔸研究问题:高分辨率和长时长视频生成中的计算开销过大,导致现有的3D全注意力机制在实际应用中的效率低下。

🔸主要贡献:论文提出了一种名为SLIDING TILE ATTENTION(STA)的新型滑动窗口注意力机制,显著提高了视频生成的计算效率和速度,同时保持了输出质量。

📝重点思路

🔸提出STA,一种基于滑动窗口的注意力机制,重新设计了注意力计算方式,使其在处理视频时能够更高效地利用GPU的内存和计算能力。

🔸通过系统和算法的协同设计,STA在每个窗内进行密集计算,避免了其他方法中的显式注意力掩码的计算开销。

🔸在注意力头的窗口大小方面进行了自动配置,充分利用不同头部的特性,以实现效率与质量的平衡。

🔸进行了多种实验,包括与现有注意力机制(如FlashAttention、Tiled NATTEN等)的比较,以验证STA的有效性。

🔎分析总结

🔸STA在视频生成中实现了超过10倍的注意力计算加速和高达3.53倍的端到端生成速度提升,且几乎没有质量损失。

🔸STA在处理高维数据时减少了混合块的生成,降低了计算复杂度,提升了内存访问效率和并行计算能力。

🔸在与其他基线方法的比较中,STA在保持视频质量的同时,显著减少了生成时间,尤其是在高稀疏度下的表现尤为突出。

🔸人类评估结果表明,STA在多个视频生成模型中表现出更优的质量效率权衡。

💡个人观点

论文提出的注意力机制实现了3D局部性和硬件效率的结合,为视频扩散模型的加速提供了新的解决方案。

🧩附录