爬取基金数据案例

爬虫常规思路:

1.分析网页

2.对网页发送请求,获取响应

3.提取解析数据

4.保存数据

本案例所用到的模块:

import requests

import time

import csv

import re

网址链接:http://fund.eastmoney.com/Data/Fund_JJJZ_Data.aspx

一、分析网页

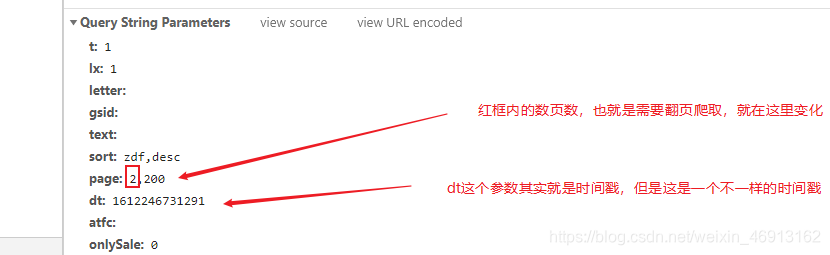

其实这个网站的网页数据没有太多的反爬,就是网页需要构建一个params的参数,该参数里面包含了网页翻页的数据,时间戳的数据,这些是动态的,需要怎么自己指定一下,如图所示:

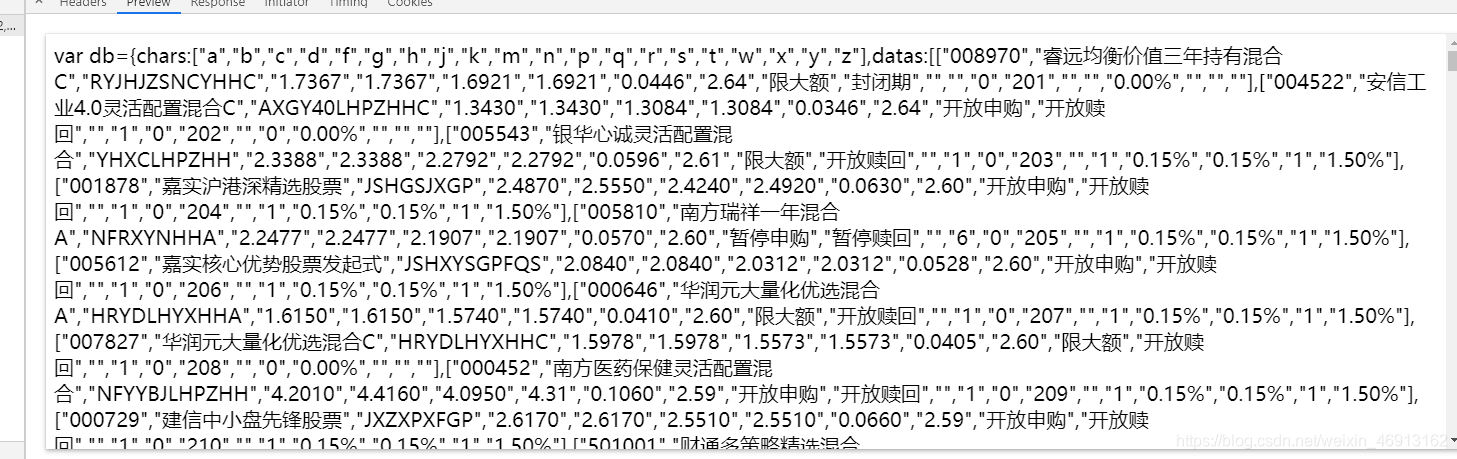

如上分析后,就可以对该链接发送请求了,但是这个网站还有一个和别的地方不一样的,他给你返回的不是html源码,也不是json数据,而是字符数据,如图:

我们可以看到这些不同html和json数据,所以就需要用到正则表达式老进行过滤提取了。

经过以上分析,我的大体思路就是,先爬取一页的数据,利用正则提取,能成功爬取到一页的数据后,只用做一个循环遍历,就可以爬取多页的数据了。

二、先构建需要请求网页所需的params参数

代码如下:

def get_params(self):

"""

构建params参数的方法

:return:

"""

params = {

"t": "1",

"lx": "1",

"letter": "",

"gsid": "",

"text": "",

"sort": "zdf,desc",

"page": f"{str(self.page)},200",

"dt": str(self.TIMESTRF),

"atfc": "",

"onlySale": "0",

}

return params

dt这个参数上面说了,是一个不正规的时间戳,那么我们怎么办,思路是,用time模块先提取出真正的当前时间戳,然后用int()把它强制转换成整数,然后乘以1000,就可以得到这个不正规的时间戳了,在构建的时候,在把这个时间戳转换成str()就可以了。

int(time.time()) * 1000

三、对网页发送请求,获取响应

def parse_url(self, url):

"""

发送请求,获取响应数据的方法

:param url:

:return:

"""

params = self.get_params()

response = requests.get(url, headers=self.headers, params=params)

if response.status_code == 200:

return response.content.decode()

四、提取解析数据

def get_data(self, data_str):

"""

提取基金数据的方法

:param data_str:

:return:

"""

str_data = re.findall('var db=.*,datas:(.*),count:.*}', data_str, re.S)[0]

data_list = eval(str_data)

for data in data_list:

yield {

'基金代码': data[0],

'基金简称': data[1],

'单位净值': data[3],

'累计净值': data[4],

'日增长值': data[6],

'日增长率': data[7],

'手续费': data[17]

}

这一步就是提取数据的时候,先把这些请求到的字符数据,使用正则表达式,提取出像列表一样的字符数据,然后转换成真正的列表数据,遍历这个列表数据,这个列表数据是一个,大列表里面包含了很多小列表,每一个小列表里面就是我们需要爬取的数据,我们通过索引取值的方法,把我们需要的数据给提取出来。

五、完整思路和保存数据

def run(self):

"""

实现主要逻辑思路

:return:

"""

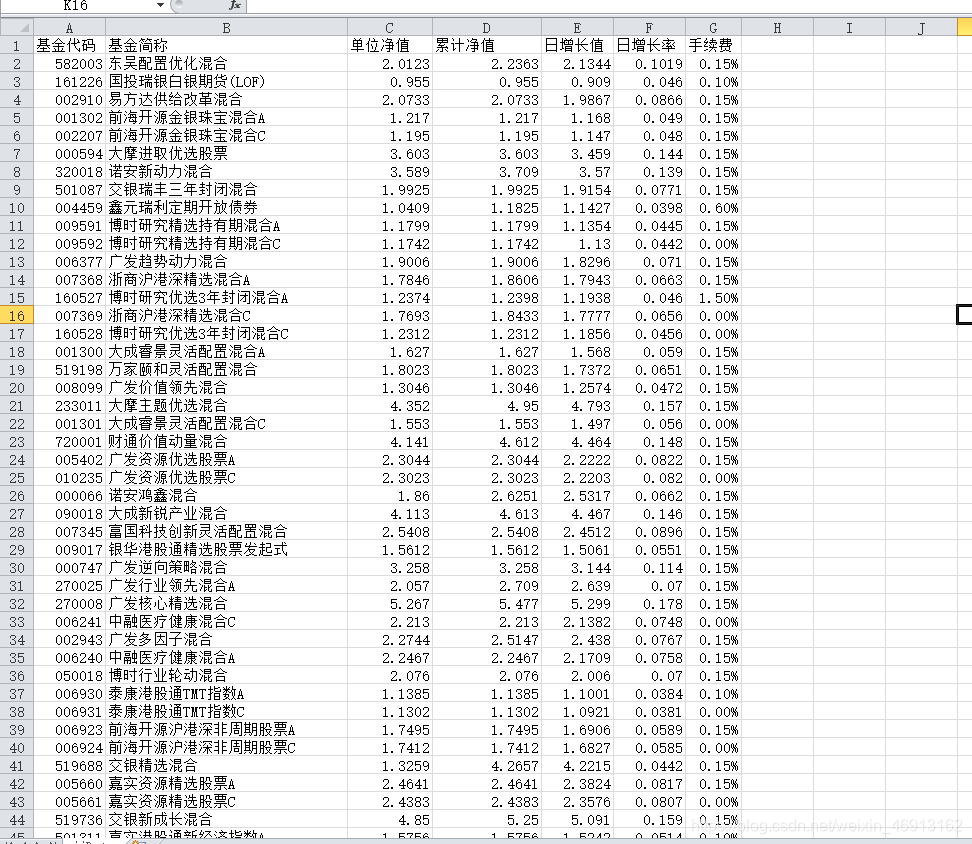

with open('./jjData.csv', 'a', encoding='utf-8-sig', newline="") as csvfile:

fieldnames = ['基金代码', '基金简称', '单位净值', '累计净值', '日增长值', '日增长率', '手续费']

write_dict = csv.DictWriter(csvfile, fieldnames=fieldnames)

write_dict.writeheader()

# 1,发送请求,获取响应数据

data_str = self.parse_url(self.API_URL)

# 2,提取数据

fund_data_list = self.get_data(data_str)

for fund_data in fund_data_list:

print(fund_data)

# 3,保存数据

write_dict.writerow(fund_data)

保存后的数据效果:

六、完整代码

# 导入需要的模块

import requests

import time

import csv

import re

class TtFundSpider:

"""天天基金爬取"""

def __init__(self, page):

self.API_URL = 'http://fund.eastmoney.com/Data/Fund_JJJZ_Data.aspx'

self.headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.104 Safari/537.36 FS'

}

self.TIMESTRF = int(time.time()) * 1000

self.page = page

def get_params(self):

"""

构建params参数的方法

:return:

"""

params = {

"t": "1",

"lx": "1",

"letter": "",

"gsid": "",

"text": "",

"sort": "zdf,desc",

"page": f"{str(self.page)},200",

"dt": str(self.TIMESTRF),

"atfc": "",

"onlySale": "0",

}

return params

def parse_url(self, url):

"""

发送请求,获取响应数据的方法

:param url:

:return:

"""

params = self.get_params()

response = requests.get(url, headers=self.headers, params=params)

if response.status_code == 200:

return response.content.decode()

def get_data(self, data_str):

"""

提取基金数据的方法

:param data_str:

:return:

"""

str_data = re.findall('var db=.*,datas:(.*),count:.*}', data_str, re.S)[0]

data_list = eval(str_data)

for data in data_list:

yield {

'基金代码': data[0],

'基金简称': data[1],

'单位净值': data[3],

'累计净值': data[4],

'日增长值': data[6],

'日增长率': data[7],

'手续费': data[17]

}

def run(self):

"""

实现主要逻辑思路

:return:

"""

with open('./jjData.csv', 'a', encoding='utf-8-sig', newline="") as csvfile:

fieldnames = ['基金代码', '基金简称', '单位净值', '累计净值', '日增长值', '日增长率', '手续费']

write_dict = csv.DictWriter(csvfile, fieldnames=fieldnames)

write_dict.writeheader()

# 发送请求,获取响应数据

data_str = self.parse_url(self.API_URL)

# 提取数据

fund_data_list = self.get_data(data_str)

for fund_data in fund_data_list:

print(fund_data)

# 保存数据

write_dict.writerow(fund_data)

if __name__ == '__main__':

for page in range(1, 6):

ttFund_spider = TtFundSpider(page)

ttFund_spider.run()