在当今人工智能快速发展的时代,本地部署大语言模型赋予了用户更高的灵活性和个性化服务体验。本文介绍了如何准备环境、安装Ollama框架、下载并部署DeepSeek大语言模型,以及如何通过终端交互、Api接口和Web界面(Chatbox)调用该模型进行简单交互。

一、环境准备

硬件需求:

- 最低配置:CPU(支持 AVX2 指令集)+ 16GB 内存 + 30GB 存储。

- 推荐配置:NVIDIA GPU(RTX 3090 或更高)+ 32GB 内存 + 50GB 存储。

软件依赖: - 操作系统:Windows、macOS 或 Linux。

二、安装 Ollama

Ollama 是一个基于 Go 语言的本地大语言模型运行框架,类 Docker 产品(支持 list,pull,push,run 等命令),事实上它保留了 Docker 的操作习惯,支持上传大语言模型仓库 (有 deepseek、llama 2,mistral,qwen 等模型,你也可以自定义模型上传)。

在管理模型的同时,它还提供了一些 Api 接口,让你能够像调用 OpenAI 提供的接口那样进行交互。

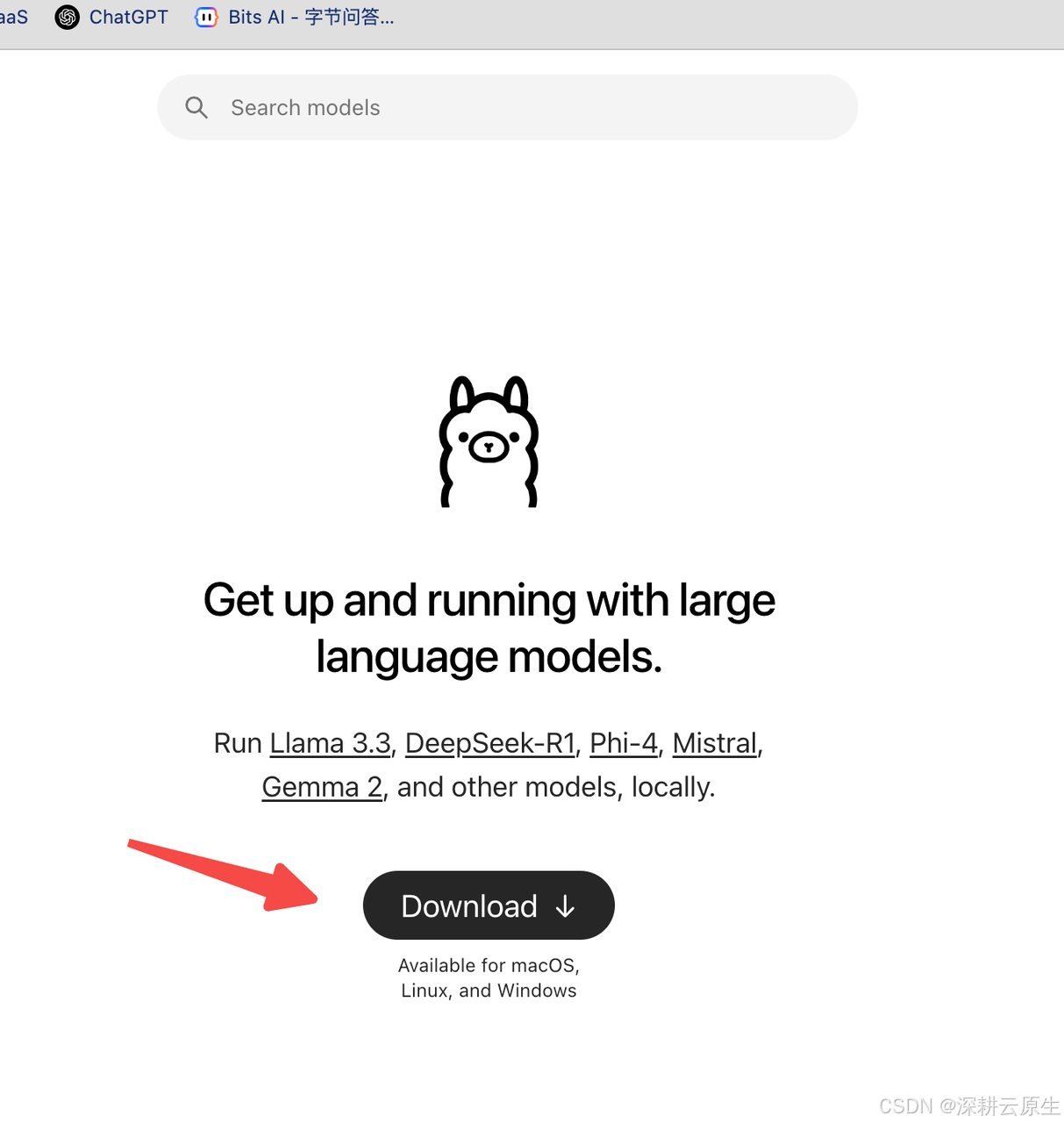

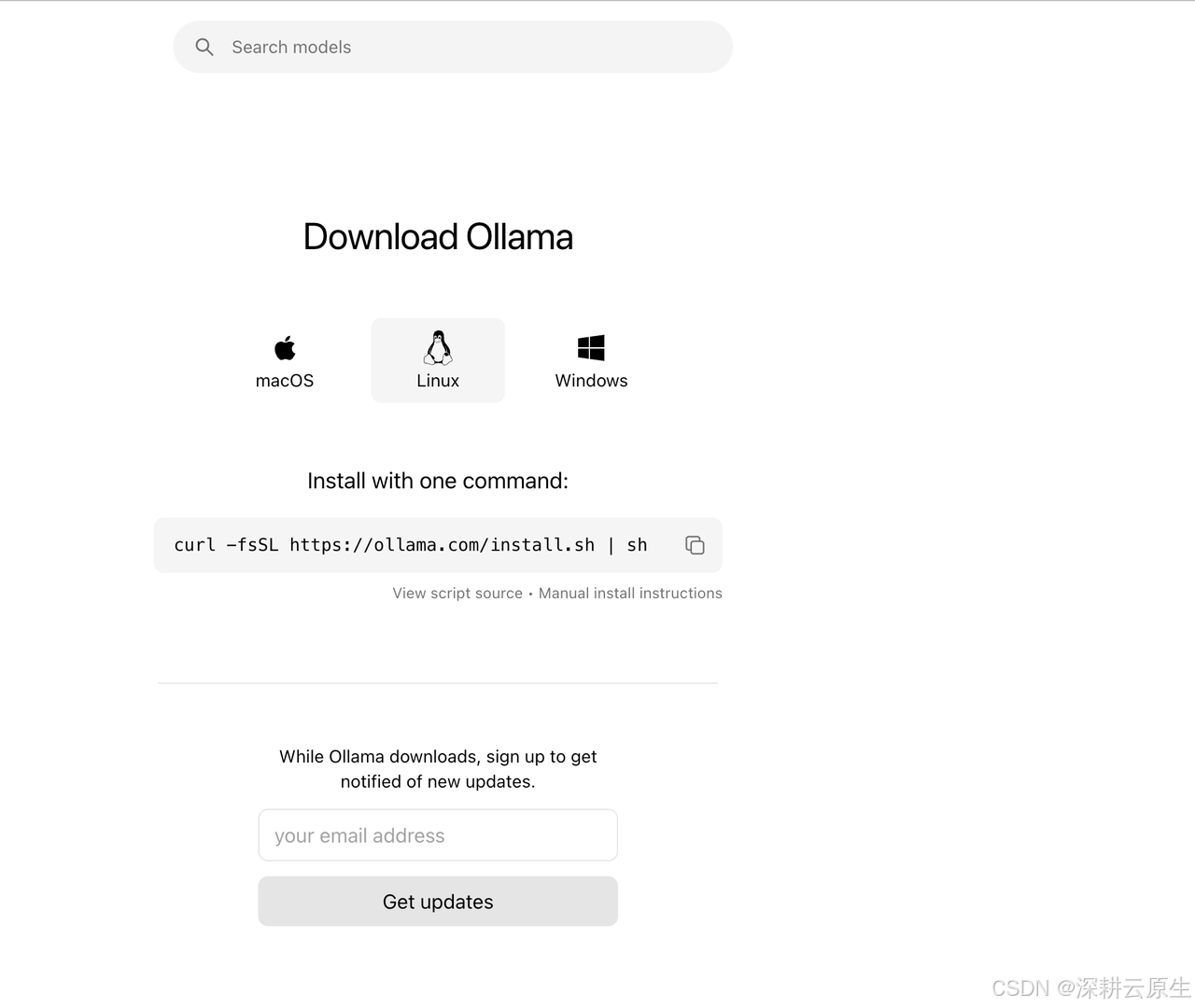

访问 Ollama 官网:前往 Ollama 官网,点击“Download”按钮。

- 下载安装包:根据你的操作系统选择对应的安装包。下载完成后,直接双击安装文件并按照提示完成安装。

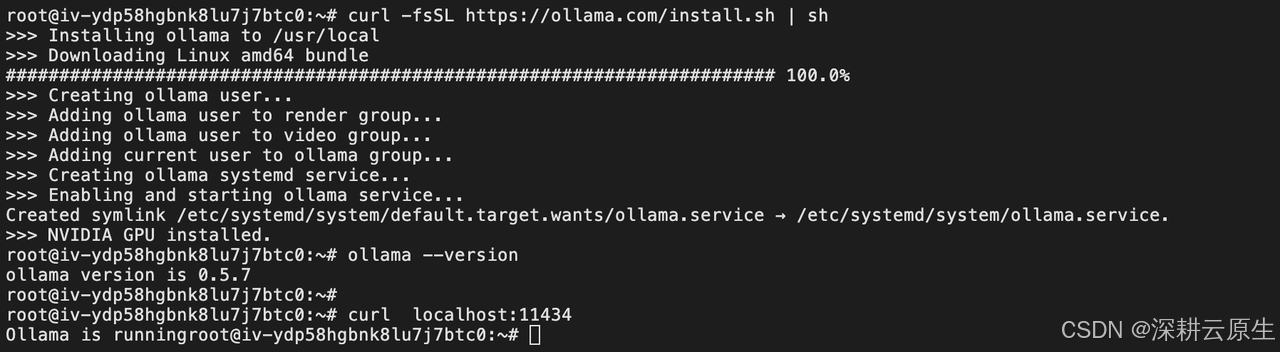

- 验证安装:安装完成后,在终端输入以下命令,检查 Ollama 版本:

ollama --version

#运行之后,访问 localhost:11434,查看是否正常运行:

curl localhost:11434

三、下载并部署 DeepSeek 模型

ollama 安装之后,其同时还是一个命令,与模型交互就是通过命令来进行的。

-

ollama list:显示模型列表。

-

ollama show:显示模型的信息

-

ollama pull:拉取模型

-

ollama push:推送模型

-

ollama cp:拷贝一个模型

-

ollama rm:删除一个模型

-

ollama run:运行一个模型

官方提供了一个模型仓库,https://ollama.com/library, 你可以搜索你想要的模型。 -

入门级:1.5B 版本,适合初步测试。

-

中端:7B 或 8B 版本,适合大多数消费级 GPU。

-

高性能:14B、32B 或 70B 版本,适合高端 GPU。

官方建议:应该至少有 8 GB 可用 RAM 来运行 7 B 型号,16 GB 来运行 13 B 型号,32 GB 来运行 33 B 型号。

在这里我选择下载目前最火的开源 deepseek-r1 模型来做演示。模型地址为:https://ollama.com/library/deepseek-r1

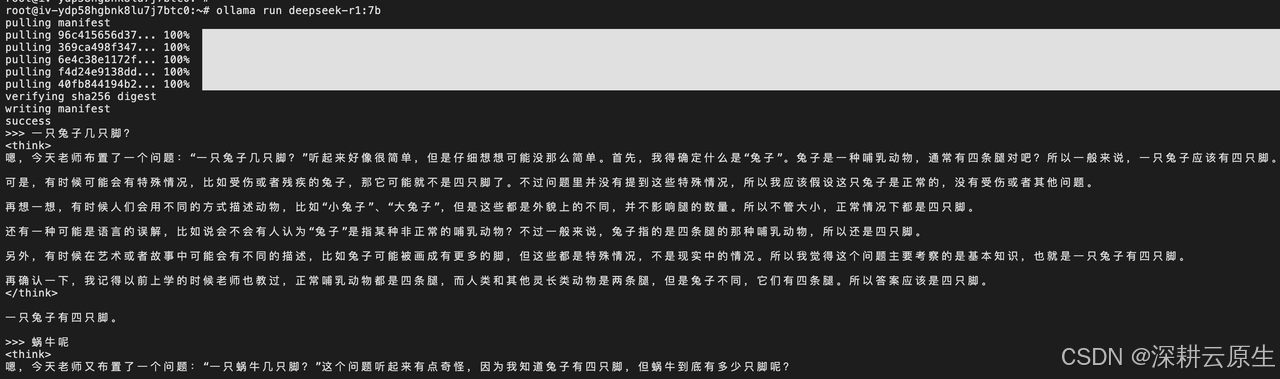

下载模型:打开终端,输入以下命令下载并运行 DeepSeek 模型。例如,下载 7B 版本的命令为:

ollama run deepseek-r1:7b

四、简单交互

模型运行之后,会默认进入到交互状态,你可以按下 Ctrl + D 退出交互,但此时模型并不会退出,仍旧可以正常通过 Api 接口交互。

终端交互示例:

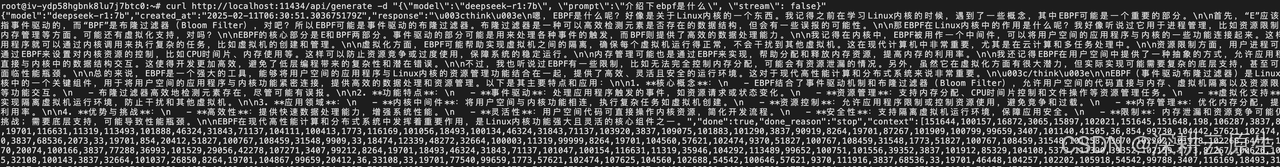

口请求参考官方文档的介绍 API 文档,下边是简单的示例:

curl http://localhost:11434/api/generate -d "{\"model\":\"deepseek-r1:7b\", \"prompt\":\"介绍下ebpf是什么\", \"stream\": false}"

接口请求支持 stream 模式(可以 边生成边返回 数据),请求响应长,建议使用 stream 模式,体验会提升不少。

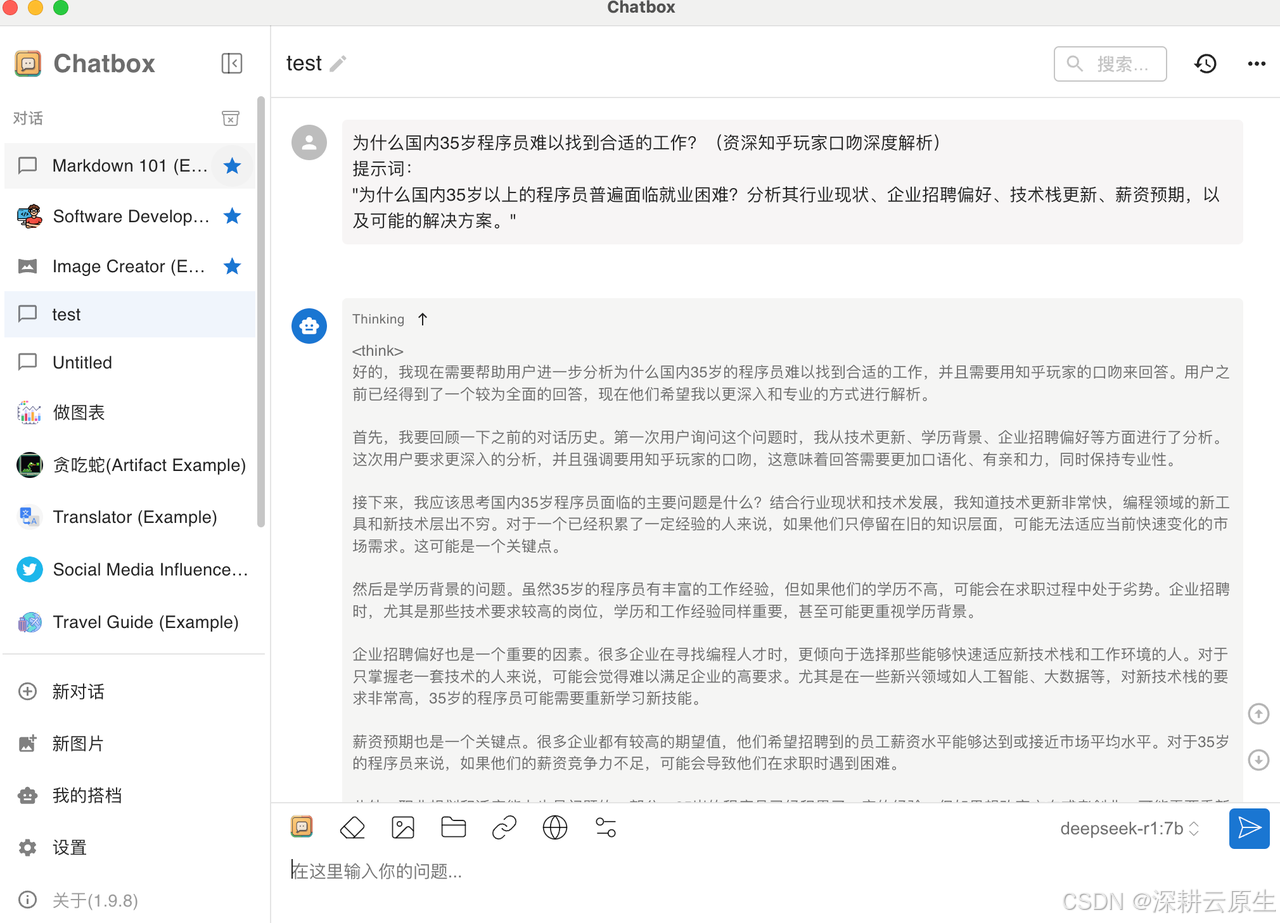

五、通过 Web 界面调用大模型

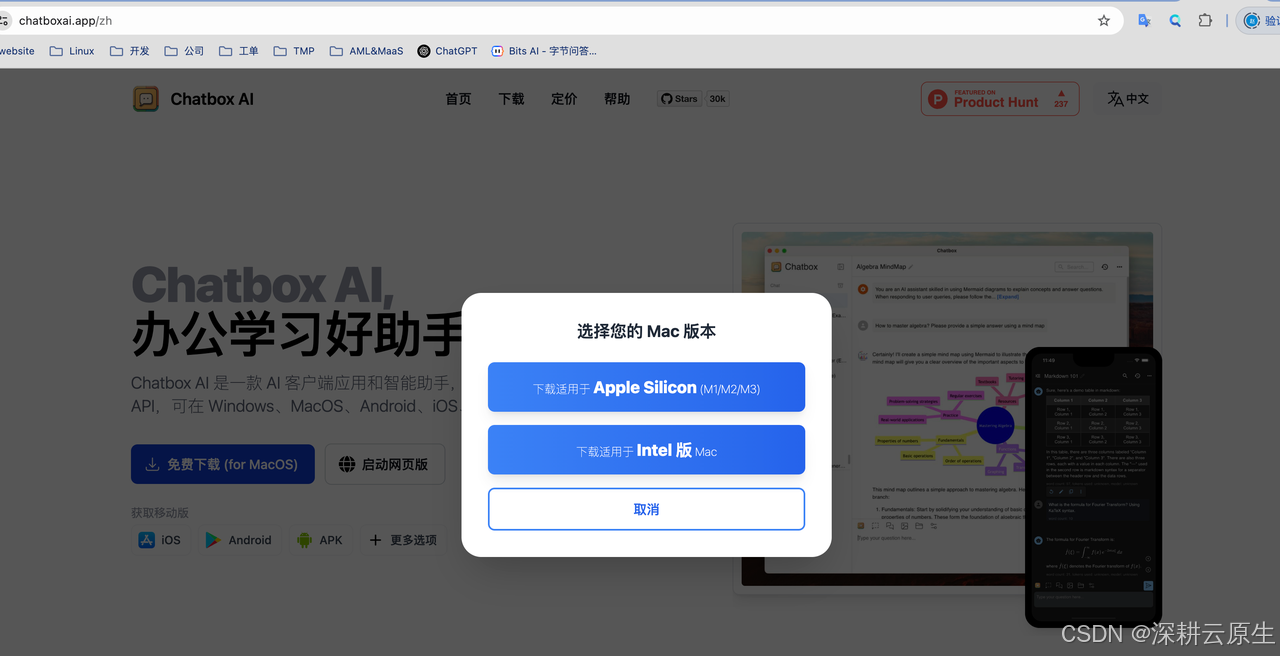

chatbox提供了可视化的对话界面,支持windows、macOS、Linux等系统,也支持安卓和苹果手机系统

1.chatbox官网https://chatboxai.app/zh下载,我这里下载的是macos版本

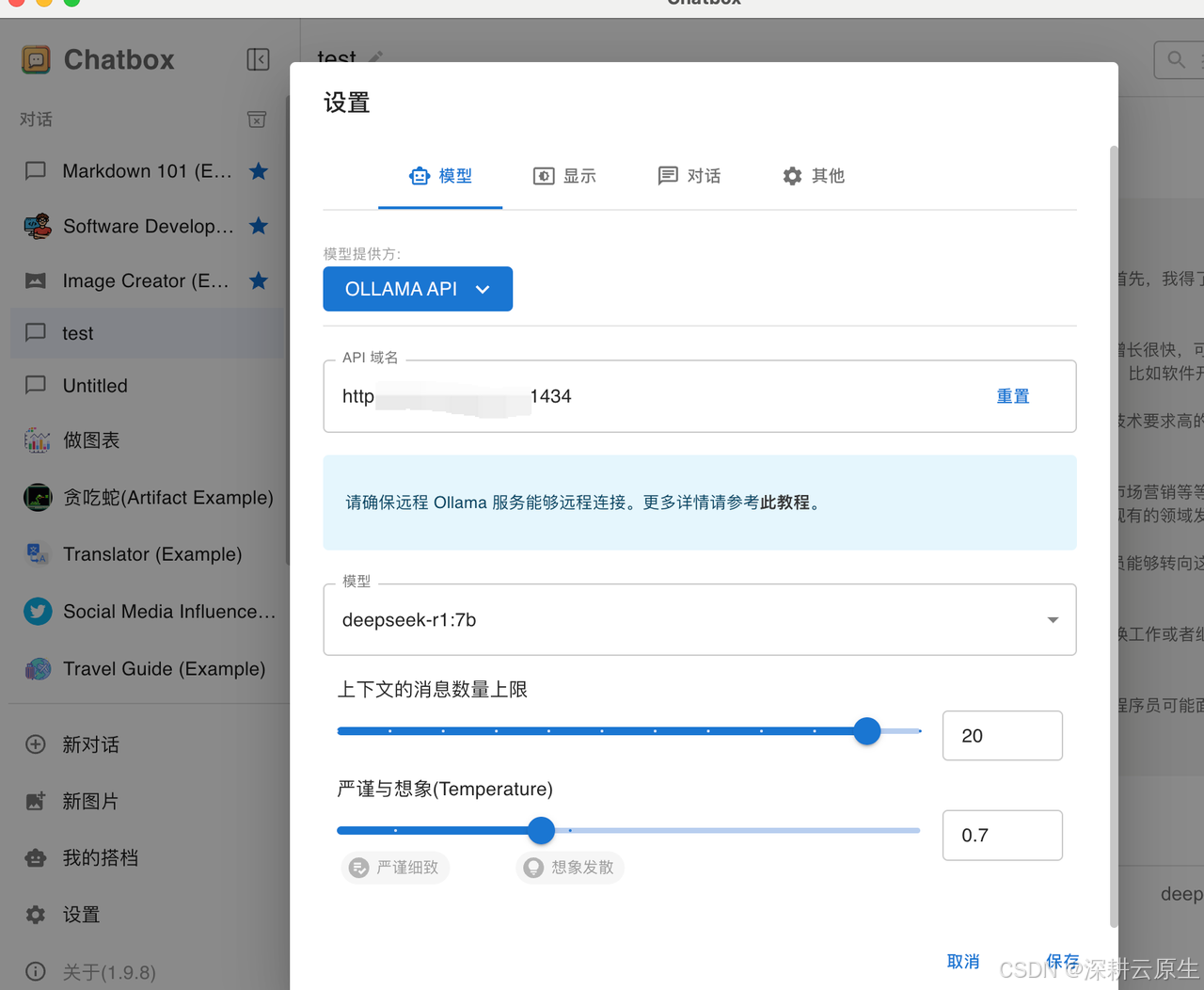

2.在chatbox里设置ollama提供的模型服务

如何将 Chatbox 连接到远程 Ollama 服务:逐步指南

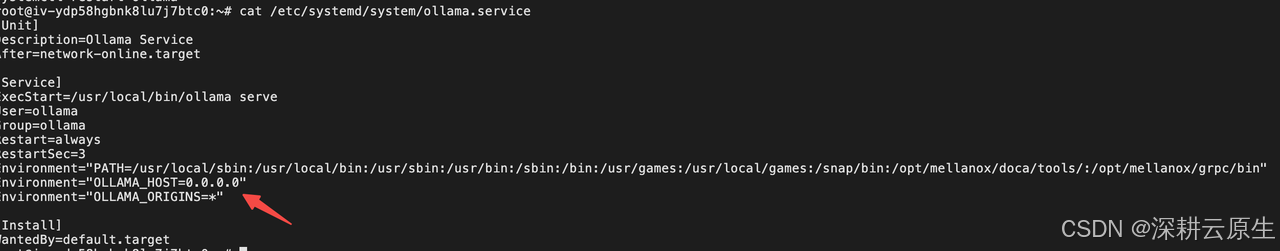

如果是公网访问,需要更改ollama 的本地监听IP地址:

修改 ollama 的本地监听IP地址, 将

Environment="OLLAMA_ORIGINS=*"

Environment="OLLAMA_HOST=0.0.0.0"

添加到 ollama 的系统服务文件( /etc/systemd/system/ollama.service)中

需要让 ollama 监听在 0.0.0.0:11434 ,这样它才能接受来自局域网或外部主机的连接。

sudo systemctl daemon-reload

sudo systemctl restart ollama

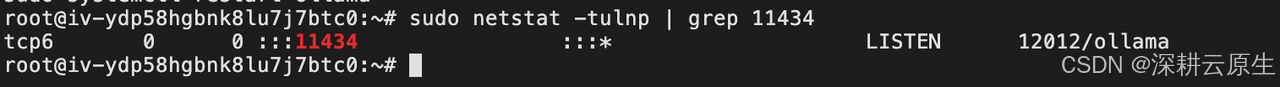

sudo netstat -tulnp | grep 11434

ollama 的本地监听IP地址修改后就可以打开chatbox,在设置里配置连接远程 Ollama 服务了。

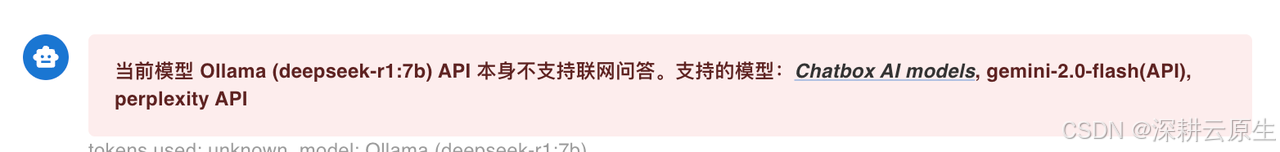

Chatbox 不支持对于本地部署 DeepSeek 模型的联网功能,如果需要实现联网问答,可考虑使用 Page Assist 插件来扩展这一能力。

DeepSeek本地部署如何开启联网搜索?