1.1 研究背景

自1997年互联网开始在国内的招聘行业发展至今已有二十几年的历史,互联网招聘进入了蓬勃发展的“黄金时代”。根据智研咨询发布的《2023年中国互联网招聘行业发展现状》报告显示,截至2023年5月,中国互联网招聘平台中,智联招聘、前程无忧、Boss直聘等月活用户量均呈现强劲增长态势,用户规模庞大且持续增长。随着用户在互联网招聘平台上留下大量“痕迹”,海量、冗杂的招聘数据不断积累,然而这些数据的关联性较低,使得求职者难以快速获取所需信息,从而降低了找到理想工作的可能性,可能导致人才流失和企业人才缺口问题。

为了解决这一现象,通过python对招聘数据进行分析及可视化技术的应用变得至关重要。学者们通过应用相关算法和统计分析,从招聘数据中挖掘出隐藏的有用信息,反映了行业对人才的各方面要求,如学历、工作经验、工作技能等。这有助于求职者更好地了解市场需求,提升工作技能,从而在求职竞争中占据有利地位。

随着数据量的爆炸式增长,人们对数据的价值和重要性有了更深刻的认识。数据可视化作为一种重要的信息传达方式,通过视觉展示数据,使复杂的信息更易于理解和应用。在招聘领域,应用可视化技术能够帮助用户更清晰、有效地理解招聘信息,实现对数据的深层洞察,为求职者和企业提供更好的决策支持。

1.2 研究的目的与意义

Python招聘数据分析可视化系统的研究通过数据分析和可视化技术,解放用户从海量、冗杂的招聘数据中,快速准确地获取所需信息,提高求职者对市场需求的了解和匹配程度。通过图形图像的直观展示,用户可以更快速、有效地理解和分析招聘数据信息,使得招聘信息传递更加明确、有效,提升用户的学习方向明晰度和工作技能掌握程度,从而提高用户体验和数据处理效率。数据可视化和分析技术的研究与应用为处理海量数据提供了新的方式,帮助用户从复杂数据中快速获取隐藏信息。借助图形的直观性,用户可以更清晰地了解数据模式,促进数据背后信息的发现和利用。而研究招聘网站数据的可视化分析平台,不仅能总结出企业人才招聘的规律,为求职者提供信息支持,还能为高校人才培养提供理论指导,促进人才结构优化,降低人才流失率,实现人才需求的供给平衡。同时,在数据分析和可视化展示方面的优化,提高了分析准确率和稳定性,增强了用户的视觉体验和数据检索效率。

1.3 国内外研究现状

1.3.1 国外研究现状

在全球研究的前沿招聘数据分析领域的探索愈发深入其研究触角广泛延伸至数据挖掘的精细运用、技能需求的详尽剖析、职位间的技能对比以及就业市场的宏观趋势分析等多个层面。这些研究不仅为我们提供了多元化的观察角度也极大地丰富了人才招聘与市场需求的匹配路径。Ningrum等学者以数据挖掘技术为工具深入挖掘招聘信息背后的隐含信息。他们利用先进的文本挖掘技术从海量的在线招聘广告中提炼出高质量的数据探讨了性别歧视等社会热点问题。这一研究不仅揭示了招聘过程中的深层现象也为构建更为公正、平等的招聘环境提供了实证支持。Verma等研究者则聚焦于专业领域的技能需求分析。他们通过对数据科学家、商业分析师等热门岗位的招聘信息进行深入研究分析并排列出各个职位的核心技能要求。这一研究为求职者提供了明确的职业发展方向也为教育机构在课程设置上提供了有益的参考。在技能对比研究方面Amit Verma和Kirill M.Yurov等人对数据分析师与数据科学家等相似职位的技能需求进行了详细对比。这一研究不仅有助于我们理解不同岗位间的细微差别也为人才培养和招聘策略提供了精准的指南。而Luo W等人则着眼于网络招聘的整体趋势。他们通过对网络招聘数据的深入分析总结了企业的招聘流程探讨了网络招聘方式对各方参与者的影响。这一研究为我们把握招聘市场的整体脉搏提供了宝贵的参考。

1.3.2 国内研究现状

近年来,国内在招聘数据分析领域展开了多方面的研究。比如田书丽等人致力于利用数据挖掘技术来分析招聘数据,通过爬虫技术获取数据并运用聚类算法、关联规则算法等工具进行深入挖掘,以揭示招聘市场的特征和趋势。同时,他们也在中文分词技术上进行优化研究,以提高分词效果和准确性,确保后续数据分析的可靠性。

招聘数据可视化展示成为研究热点,王慧玲等人设计并实现了招聘数据可视化系统,通过图表、图形等形式直观呈现分析结果,帮助用户更好地理解数据、发现模式,提高用户的数据理解和决策效率。同时,王瑞梅等人也着力设计并实现招聘数据分析系统,整合数据获取、处理、分析和可视化等模块,帮助用户深入了解招聘市场状况,为求职者提供定位和决策支持。

这些研究对于国内招聘数据分析至关重要为求职者和企业提供深刻的市场洞察助力他们精准把握招聘动态提高决策的科学与准确性。随着互联网科技日新月异招聘数据分析的研究将进一步拓展深化为市场优化和人才匹配贡献更多智慧与力量。

1.4 结构

第一章绪论。本文首先阐述了招聘领域在互联网时代的重要性和研究意义,随后简要介绍了国内外招聘数据分析和可视化研究现状。最后概述了本文的研究内容和组织结构,旨在利用数据可视化技术对招聘信息进行深入分析,为求职者和企业提供更精准的招聘信息匹配和决策支持。本文将重点探讨招聘数据的充分分析以及分析结果的可视化设计,以提升招聘数据处理效率和用户体验,促进人才市场的平衡发展。

第二章相关技术介绍。内容涵盖了关键技术的详细介绍。前端采用了layui作为界面框架,后端则选用了flask与MySQL数据库进行开发。在数据可视化方面,采用了echart框架实现数据的直观展示。此外,算法部分运用了随机森林预测算法进行数据分析与预测。通过这些技术的结合,平台得以高效运作,为用户提供更加便捷和直观的体验。

第三章系统需求分析。本章针对实际需求特点,对系统的业务流程进行了深入分析。随后详细探讨了系统数据采集与存储、数据处理与分析、以及数据可视化展示、预测等4大模块功能的具体需求。通过系统需求分析,能够更好地把握用户需求,确保系统设计与实际应用场景相契合,提升系统的实用性和用户体验。

第四章系统的总体设计。本章主要是结合了对系统业务流程和需求的分析,首先简要概述了系统的架构设计,然后对数据采集、处理分析、可视化以及预测模块进行了详细设计。通过系统总体设计,确保系统各模块间协同工作,实现高效数据流转和处理,提升系统整体性能和稳定性,从而更好地满足用户需求并提供优质的用户体验。

第五章系统的实现与分析。本章主要探讨了招聘网站数据可视化分析平台各关键功能模块的实际实现过程。首先运用爬虫技术完成了数据的采集与存储,随后对招聘文本数据进行了处理和分析,最终实现了系统的数据可视化与预测功能。通过这一过程,系统能够有效地处理和展示招聘相关数据,为用户提供直观、易懂的数据呈现,帮助用户更好地理解和分析招聘市场的情况。

第六章汇聚与展望。在这一章节中我们全面总结了全文的核心成果针对招聘网站数据可视化分析平台深入探讨了其改进的可能方向。通过细致的梳理我们发现了系统在实践中的闪光点与待提升之处为系统的未来优化明确了方向。同时我们也对系统未来的发展潜力进行了展望勾勒出其创新的蓝图为系统的持续优化与创新提供了源源不断的动力和灵感。

第五章 系统设计与实现

5.1数据爬取设计与实现

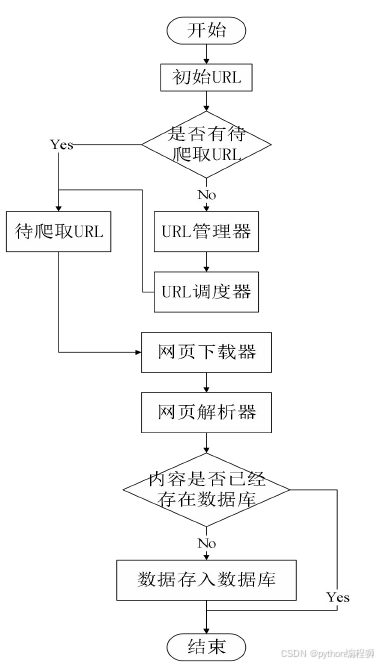

招聘数据可视化分析平台的数据采集模块通过网络爬虫实现对招聘数据的抓取、解析和存储。主要选取了前程无忧等招聘网站作为数据来源,使用python的selenium框架采集数据,其中该网站采取了较多的反爬取策略。数据采集流程图如下5.1所示。

图5.1 数据采集流程

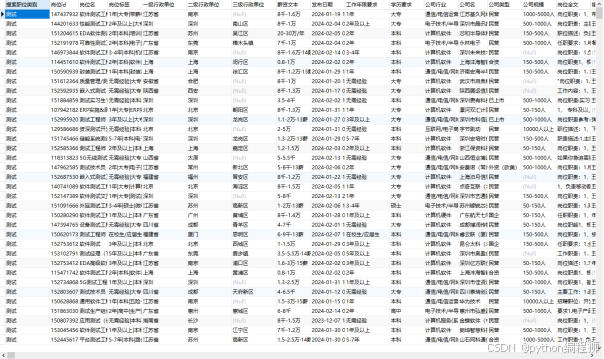

数据采集在数据采集流程中,首先选择需要爬取的网页和初始链接,然后通过模拟浏览器的方式访问网站并抓取所需信息。为应对反爬取策略,采用构建请求头来伪装爬虫,模拟浏览器的访问行为,避免被网站拦截。常见的反爬取策略包括User-Agent、IP地址、Cookie等检测,需要在构造请求头时模拟网站的Request Headers部分。另外,为防止被封IP,可使用代理IP构建代理IP池,实现IP切换和降低访问频率。通过这些策略和技术手段,数据采集模块能够有效抓取并处理招聘数据,为后续的数据分析和可视化提供可靠的数据支持。数据采集结果如图5.2所示。

图5.2 采集数据展示

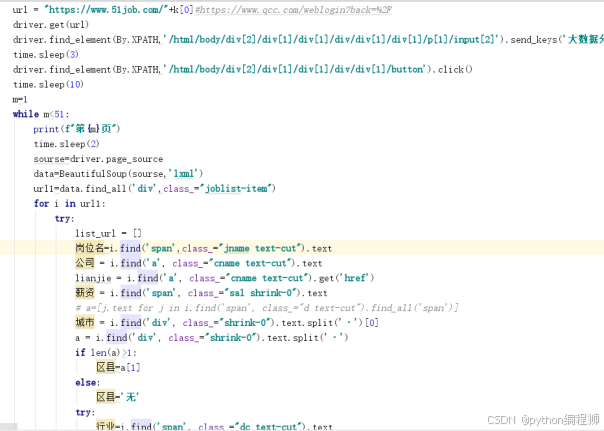

爬虫代码:

图5.2 爬虫代码

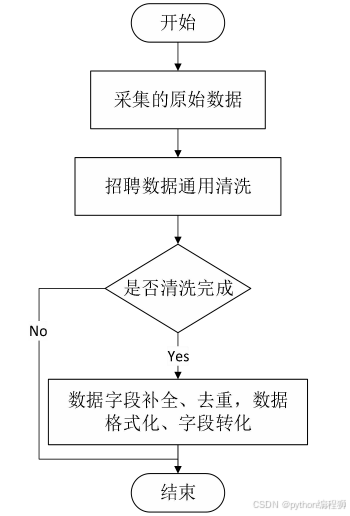

5.2数据清洗与预处理

对在招聘数据处理过程中,经常会遇到数据缺失、异常值、重复数据等问题,需要进行数据清洗和处理以确保数据质量。首先对数据使用info方法进行筛查,发现缺失或异常值的数据,根据缺失程度使用fillna进行填充处理,保证数据完整性。对于重复数据,按照岗位描述进行去重,保留唯一不重复数据,删除重复数据。部分字段如薪资水平、工作年限、教育背景格式混乱,通过自定义函数,对薪资等内容统一格式并划分区间以便后续分析。针对中文文本数据,进行中文分词处理,利用jieba库实现分词,去除停用词提高分词质量。进一步对分词结果进行观察和处理,去除无意义词语。清洗后的数据进行结构化处理,统一岗位名称、工作地点、工作经验、学历、薪资等字段格式,以便后续数据分析。通过这些数据处理和清洗步骤,可以确保数据质量和准确性,为后续的数据分析和可视化提供可靠的基础。数据清洗与预处理流程如图5.3所示:

图5.3 数据清洗与预处理流程

5.3 数据预测实现

数据预测是利用机器学习算法根据已有的数据对未知数据进行推断和预测。本论文采用了随机森林回归模型来进行数据预测。随机森林是一种集成学习算法,通过多个决策树组成的森林来进行预测,最终取平均值或多数投票结果作为最终预测结果。随机森林在决策树的基础上引入了随机性,通过随机选择特征和数据样本来增加模型的多样性,提高预测准确性和泛化能力。

5.3.1 随机森林算法原理

随机采样:从训练集中随机选择一定数量的样本和特征,构建多个决策树模型。

随机特征选择:在每个节点分裂时,随机选择一部分特征进行划分,增加模型的多样性。

Bagging集成:通过Bootstrap抽样方法生成多个不同的训练集,每个训练集训练一个决策树,最终进行投票或取平均值得到最终预测结果。

5.3.2 随机森林算法公式

随机森林算法的核心在于随机选择特征和样本进行训练,以构建多个决策树,并通过投票或平均值来进行预测。以下是随机森林算法的基本公式:

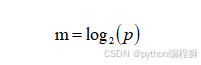

(1)随机选择特征:在每个节点分裂时,随机选择一部分特征进行划分。特征选择公式:

其中,m 为每个节点随机选择的特征数,p 为总特征数。

(2)Bootstrap抽样:通过随机采样生成多个不同的训练集。

(3)训练决策树:对于每棵决策树的训练过程,采用CART算法,选择最佳的划分特征和划分点。每棵决策树的训练过程通常采用CART(Classification and Regression Trees)算法,该算法既适用于分类问题也适用于回归问题。在训练决策树时,选择最佳的划分特征和划分点是关键步骤之一,这个过程可以用基尼指数(Gini index)或均方误差(Mean Squared Error,MSE)来衡量。

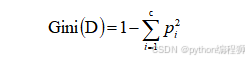

CART算法训练决策树的划分规则公式:

分类问题:

基尼指数(Gini index):用于衡量数据的纯度,计算公式如下:

其中,( D ) 表示数据集,( c ) 表示类别数,( ) 表示第 ( i ) 类样本在数据集中的占比。

信息增益(Information Gain):衡量特征对分类结果的影响,选择最佳划分特征。

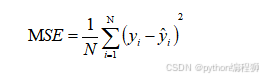

回归问题:

均方误差(Mean Squared Error,MSE):用于衡量预测值和真实值之间的差异,计算公式如下:

其中,( N ) 表示样本数量,( ) 表示真实值,( ) 表示预测值。

在训练决策树时,通过计算基尼指数或均方误差来选择最佳的划分特征和划分点,使得划分后的子节点更加纯净或误差更小,从而构建出具有良好泛化能力的决策树模型。CART算法的核心思想是递归地对数据集进行划分,直到满足停止条件为止,得到一棵用于分类或回归的决策树。

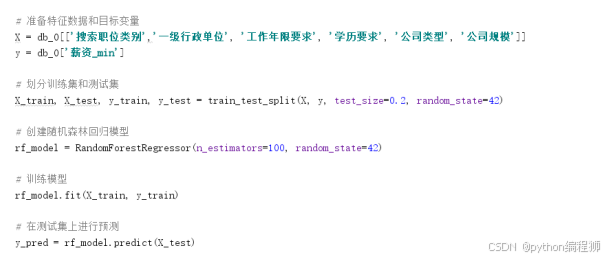

在代码实现中,首先从数据库中读取数据,包括搜索职位类别、一级行政单位、工作年限要求、学历要求、公司类型、公司规模等特征数据以及薪资最小值作为目标变量。然后将数据分为训练集和测试集,测试集和训练集占比等于2:8,模型训练完成后,在测试集上进行预测,得到预测结果。通过计算均方误差来评估模型的预测性能。

在进行预测时,构建包含待预测数据的DataFrame,根据预测数据的特征值,利用训练好的随机森林回归模型进行预测,得到待预测数据的薪资最小值预测结果。最后将预测结果加入DataFrame中,并将测试数据和预测数据进行对比展示。

整个数据预测过程涉及数据准备、模型训练、预测计算和结果展示等步骤,通过机器学习算法随机森林回归模型,可以实现对未知数据薪资最小值的准确预测,为招聘数据分析和人才招聘决策提供重要参考。预测代码如下图5.4所示:

图5.4预测代码

5.4 数据可视化展示

5.4.1 登录

系统登录如下图所示。

图5.5登录界面

5.4.2注册

注册界面如下图5.所示。

图5.5用户信息界面

5.4.3首页

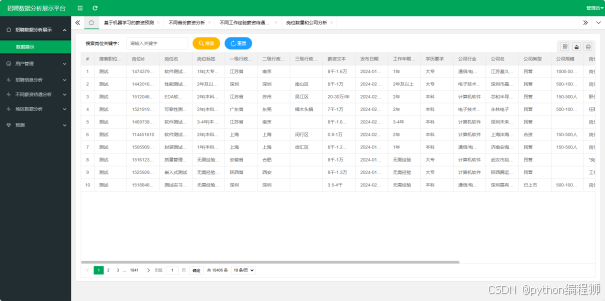

首页如下图5.6所示,用户可以根据关键搜索数据,查看岗位情况。

图5.6首页

5.4.4招聘信息分析

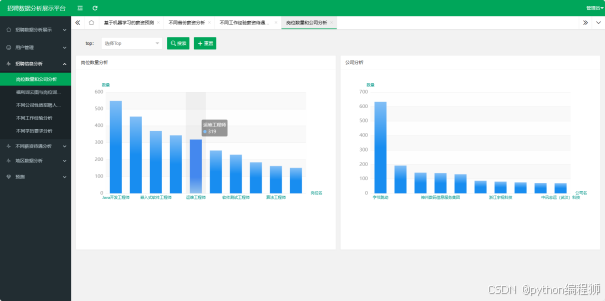

招聘信息分析通过Flask搭建Web应用,结合MySQL数据库存储招聘数据,实现了岗位数量和公司分析、福利词云和岗位词频分析、不同公司性质招聘人数分析、不同工作经验分析、不同学历要求分析等功能。用户可以通过API接口传入参数,获取相应的数据分析结果。其中,对岗位数量和公司进行统计分析,福利词云展示关键词频率,不同公司性质招聘人数分析显示招聘数量,不同工作经验分析展示薪资情况,不同学历要求分析展示薪资水平。结合数据可视化展示分析结果,帮助用户更好地了解招聘市场信息,为求职者和招聘方提供参考和决策支持。整体实现了数据分析与可视化展示的功能,为招聘信息的深入研究提供了有力工具支持。可视化效果如下图5-7到图5-11所示。

图5.7岗位数量和公司分析

根据图5.7岗位数量和公司分析可知,Java开发工程师是需求量最高的岗位,共有548个岗位需求;字节跳动是提供岗位最多的公司,共有633个岗位需求。硬件工程师和嵌入式软件工程师紧随其后,需求量分别为455和370。亚信科技(中国)和美团是提供岗位较多的公司之一,分别有192和143个岗位需求。这些结果反映了市场对技术类岗位的需求较大,相应公司也在加大招聘力度,提供更多就业机会。需要重点关注的岗位包括Java开发工程师和硬件工程师,以及与之相关的公司如字节跳动和亚信科技(中国)。

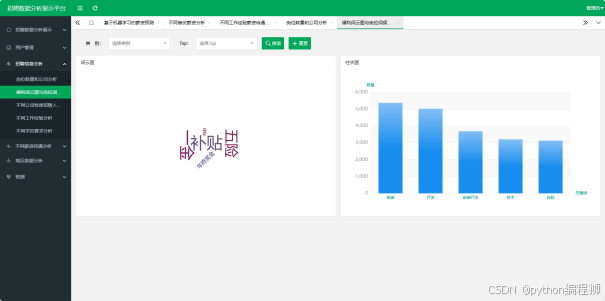

图5.8福利词云和岗位词频分析

根据图5.8福利词云分析结果,补贴、一金、五险是企业提供的主要福利,其中补贴额度最高,达1529,体现了企业对员工福利的重视。年终奖金和体检也是常见的福利待遇,分别为880和783。岗位词频分析显示前端、开发、技术等词频较高,说明技术类岗位需求较大,前端开发领域尤为热门。企业在招聘中注重提供丰厚的福利待遇,以吸引和留住优秀人才,同时对技术类岗位的需求量较大,求职者可重点关注这些热门岗位领域。

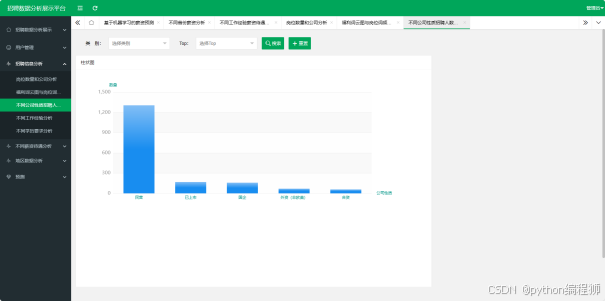

图5.9不同公司性质招聘人数分析

根据图5.9不同公司性质招聘人数分析结果,民营企业是招聘需求最大的公司类型,共有1305个岗位需求,说明民营企业在市场中占据重要地位。已上市公司和国有企业紧随其后,分别有168和158个岗位需求,显示出市场对这两类公司的需求较高。外资(非欧美)和合资企业也有一定数量的岗位需求,创业公司、外资(欧美)以及事业单位、非营利组织的需求量相对较少。求职者可以根据不同公司性质的招聘需求量,有针对性地选择适合自己发展的公司类型。

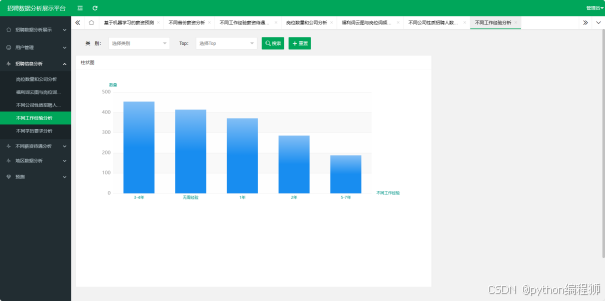

图5.10不同工作经验分析

如图5.10所展现不同工作经验背景下学历与岗位需求呈现出一幅鲜明图景。大专及本科学历求职者成为市场的宠儿岗位需求分别高达891和1325彰显出这两个学历层次在市场上的广泛需求。相比之下中技/中专与高中学历求职者亦有一定数量的岗位青睐分别录得62和51个职位空缺。然而初中及以下学历和硕士学历求职者则遭遇市场的较为冷淡需求分别仅为18和11。尤其值得注意的是博士学历的岗位需求极为稀缺仅有一个岗位匹配。这一趋势清晰地反映出大部分岗位更偏爱拥有大专和本科学历的求职者而其他学历层次则稍显逊色。

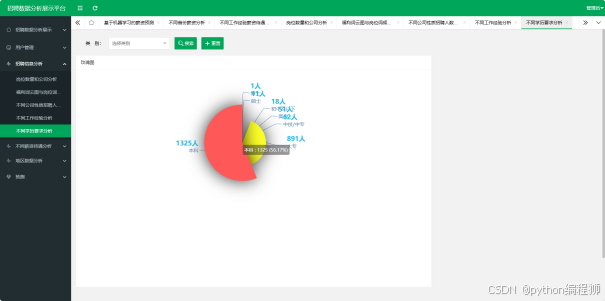

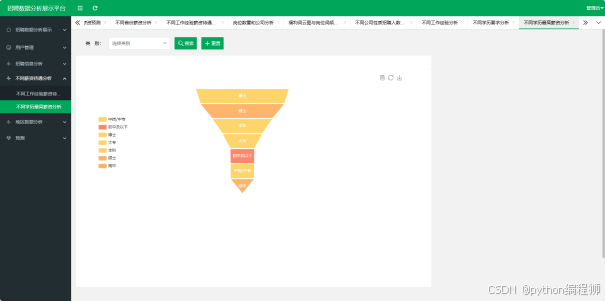

图5.11不同工作经验分析

图5.11揭示了不同学历在岗位需求中的分布态势。博士学历需求傲视群雄高达36%硕士学历紧随其后占据32.5%的比例充分显露出对高级知识分子的殷切期待。本科学历占得23.2%大专则有15.4%相较于前述两类学历略显逊色。至于中技/中专和高中学历分别仅占比9.2%和9.1%初中及以下学历更是仅占9.3%显示了对较低学历层次的相对冷落。综上所述岗位明显倾向于招募高学历人才中专以下学历的需求则显得捉襟见肘。

5.4.5不同薪资待遇分析

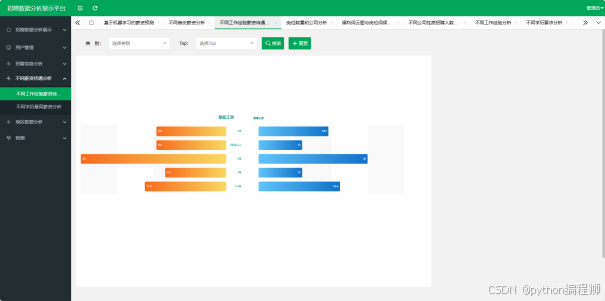

不同薪资待遇分析通过Flask搭建Web应用,结合MySQL数据库存储招聘数据,实现了不同工作经验工资待遇分析、不同学历最高薪资等功能。用户可以通过API接口传入参数,获取相应的数据分析结果。如图5.12到5.13所示:

图5.12不同工作经验工资待遇分析

根据图5.11不同工作经验工资待遇分析结果,博士学历的平均工资待遇最高,达到36万,其次是硕士学历,占比为32.5万,显示出高学历人才在薪资方面具有明显优势。本科学历的平均工资待遇为23.2万,大专学历为15.4万,中技/中专和高中学历的平均工资待遇较低,分别为9.2万和9.1万。初中及以下学历的平均工资待遇最低,为9.3千。整体来看,随着学历的提高,工资待遇也随之增加,企业更倾向于给予高学历人才更高的薪资水平,对于初中以下学历的员工薪资相对较低。

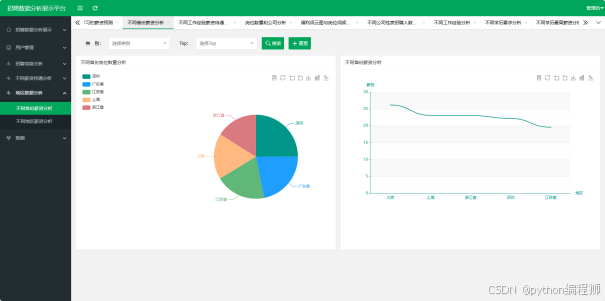

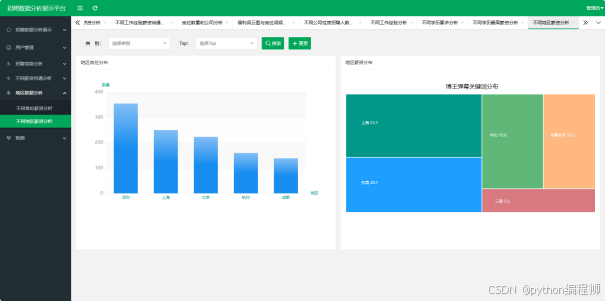

5.4.6地区数据分析

地区数据分析包括不同省份薪资分析、不同地区薪资分析等。如下图所示。

图5.14不同省份薪资分析

图5.14揭示了不同省份的薪资差异。深圳以356的数量领跑全国紧随其后的是广东和江苏分别以312和278紧随其后。上海和浙江则以251和229紧随其后体现了各自的薪资优势。其中深圳尤为瞩目其高薪资无疑彰显了该地区就业市场的繁荣与活力。而广东、江苏、上海、浙江等地也呈现出不俗的薪资水平为求职者提供了多元化的就业选择。求职者可根据自身需求结合各省份的薪资情况进行更为精准的就业规划。

深掘图5.15可见各地区薪资水平犹如波澜壮阔的海洋高低起伏层次分明。深圳无疑是这海洋中的高峰,平均薪资高达356雄踞榜首。紧随其后的是上海和北京分别以251和224的薪资水平位列第二、第三彰显了其作为一线城市的就业市场繁荣与薪资优厚。杭州与成都虽非一线城市却也以160和139的薪资水平展现出不俗的魅力。而在非一线城市中三亚更是异军突起以7.2的薪资水平领跑东莞和中山紧随其后分别为20.1和15.6。乌鲁木齐则以13.2的薪资水平为求职者提供了另一选择。总体来看一线城市薪资诱人非一线城市亦不乏吸引力求职者可根据自身情况权衡选择。

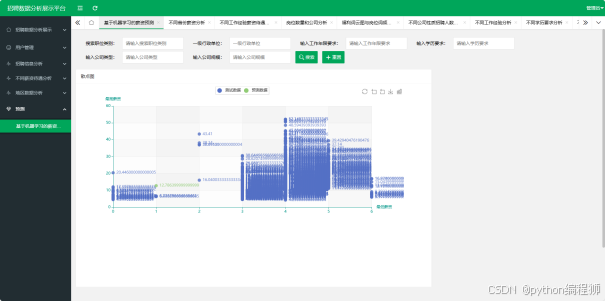

5.4.7最低薪资预测

最低薪资预测需要在页面输入包括搜索职位类别、一级行政单位、工作年限要求、学历要求、公司类型、公司规模等特征数据以及薪资最小值作为目标变量。然后将数据分为训练集和测试集,测试集和训练集占比等于2:8,模型训练完成后,在测试集上进行预测,得到预测结果。如图5-16最低薪资预测所示,生成测试集数据散点图和预测数据结果散点图,其中绿色点为预测值。

图5.16最低薪资预测