服务器linux部署Deepseek671B满血版 ollama本地部署教程

摘要

服务器Linux部署Deepseek671B满血版Ollama本地部署教程摘要

本文介绍了在Linux服务器上部署Deepseek 671B模型的完整流程,基于Ollama框架和Open-WebUI工具。主要内容包括:

-

Ollama安装与配置

使用curl -fsSL https://ollama.com/install.sh | sh命令安装Ollama,并通过ollama serve启动服务。通过修改/etc/systemd/system/ollama.service文件,配置环境变量(如OLLAMA_HOST和OLLAMA_MODELS),解决服务启动失败或无法连接的问题。 -

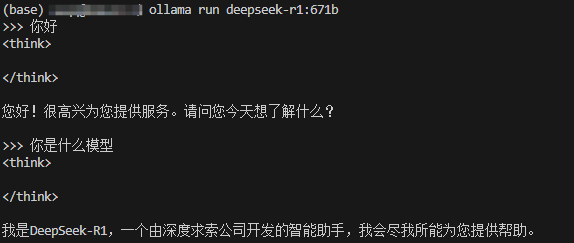

模型运行与API测试

使用ollama run deepseek-r1:671b命令加载Deepseek 671B模型,并通过API接口验证模型响应。 -

Open-WebUI部署

通过Docker部署Open-WebUI,支持GPU加速,并配置NVIDIA Container Toolkit以确保Docker能够使用GPU资源。 -

常见问题解决

针对Ollama服务反复重启、无法连接到Ollama应用等问题,提供了修改服务配置文件、设置环境变量等解决方案。 -

参考资源

提供了相关教程和技术文章链接,供读者参考。

本文为用户在Linux环境下快速部署和使用Deepseek 671B模型提供了详细的步骤和解决方案。

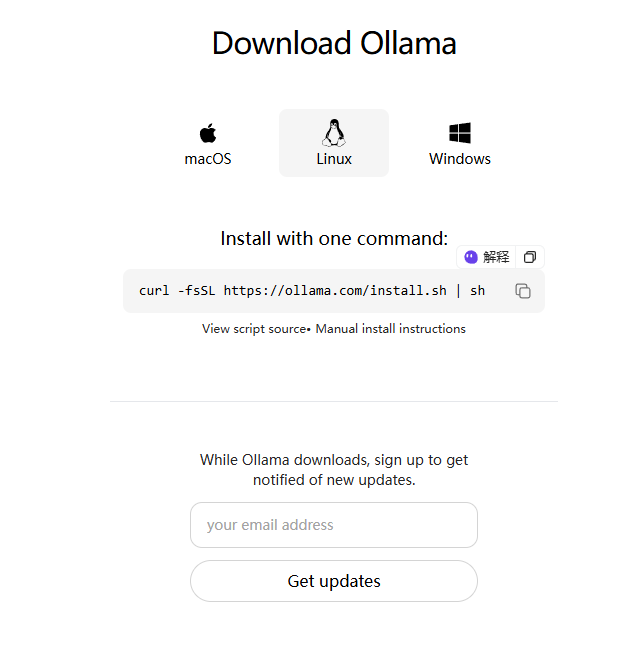

下载安装ollama

安装:

curl -fsSL https://ollama.com/install.sh | sh

等待安装完成。安装脚本会自动下载所需的组件,并完成Ollama的安装与配置。

安装完成后,可以通过以下命令启动Ollama:

ollama serve

查看ollama状态:

sudo systemctl status ollama

重启ollama:

sudo systemctl restart ollama

ollama服务反复重启失败- 错误

- 服务配置中的自动重启设置

Ollama 的服务文件/etc/systemd/system/ollama.service中可能配置了Restart=always,这会导致服务在失败后自动重启

解决方法:

1. 权限问题

如果 Ollama 服务以特定用户(如 ollama)运行,但该用户对某些目录或文件没有足够的权限,可能会导致服务启动失败并不断重启。

sudo chown -R ollama:ollama /usr/share/ollama/.ollama

sudo chown -R ollama:ollama /path/to/your/models

2.环境变量问题

服务文件中的环境变量配置可能不正确,导致 Ollama 无法正常启动。

解决方法

检查服务文件中的环境变量是否正确。例如:

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_MODELS=/path/to/your/models"

如果路径或配置有误,可能会导致服务启动失败。

确保 OLLAMA_HOST 和 OLLAMA_MODELS 等环境变量指向正确的路径。

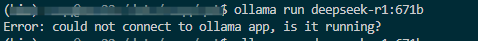

命令行输入ollama run deepseek-r1:671b时出现错误:

Error: could not connect to ollama app, is it running?

解决方法:

1.修改服务配置文件

找到 Ollama 的服务文件 /etc/systemd/system/ollama.service,并添加或修改 `OLLAMA_HOST`` 环境变量:

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

修改后,重新加载并重启服务:

sudo systemctl daemon-reload

sudo systemctl restart ollama

2. 环境变量未正确传递

当直接运行 ollama 时,客户端可能未使用正确的 OLLAMA_HOST 环境变量。通过显式设置环境变量,可以确保客户端连接到正确的地址。

echo "export OLLAMA_HOST=127.0.0.1:11434" >> ~/.bashrc

source ~/.bashrc

更改模型保存路径 以及 公网访问

编辑ollama配置服务

sudo vim /etc/systemd/system/ollama.service

添加配置:

修改模型保存路径:

Environment="OLLAMA_MODELS=/data/ollama/models"

设置外网访问:

Environment="OLLAMA_HOST=0.0.0.0:11435"

完整内容如下:

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin"

Environment="OLLAMA_MODELS=/data/ollama/models"

Environment="OLLAMA_HOST=0.0.0.0:11435"

Environment="OLLAMA_ORIGINS=*"

[Install]

WantedBy=default.target

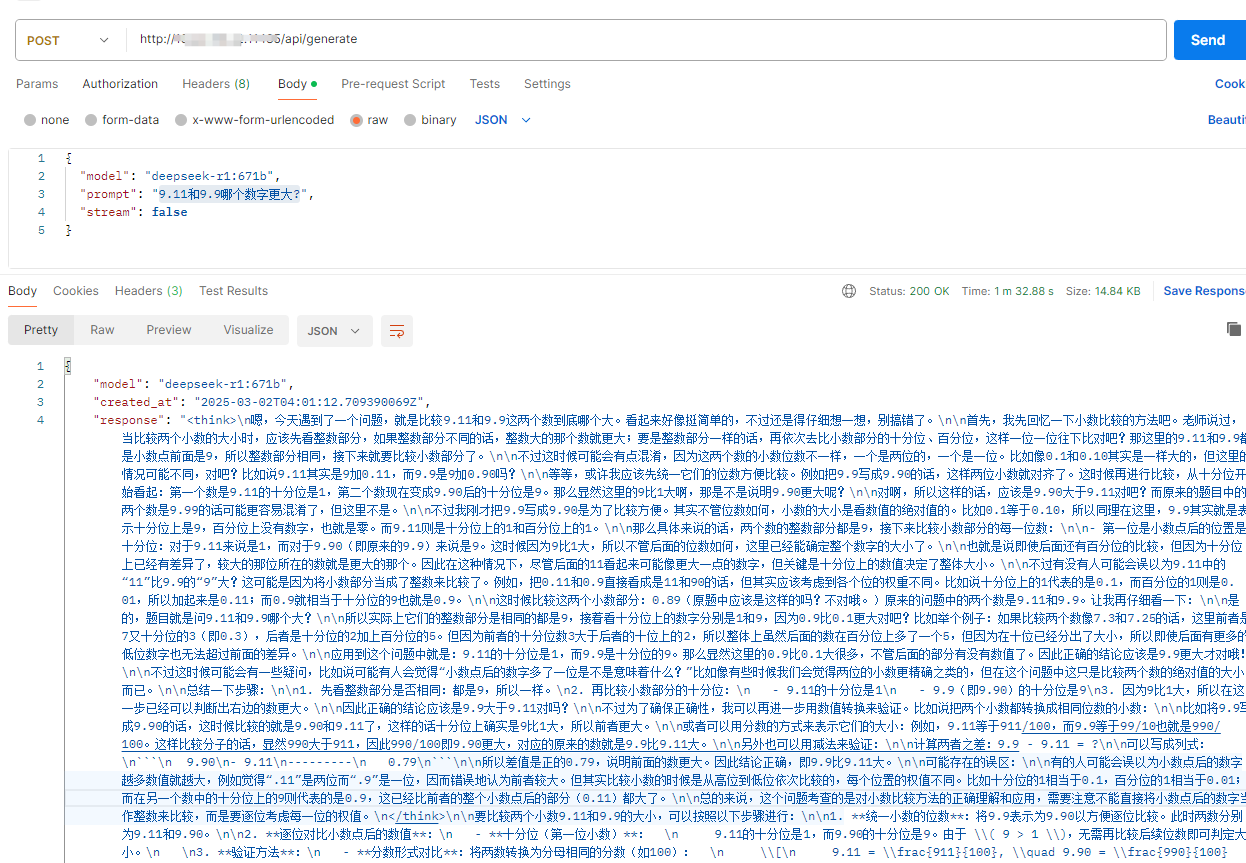

测试api成功响应

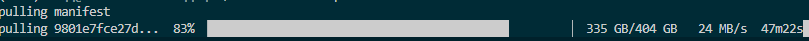

安装满血版deepseek:

ollama run deepseek-r1:671b

等待安装完成:

http://xxxxxx:11435/api/generate

{

"model": "deepseek-r1:671b",

"prompt": "9.11和9.9哪个数字更大?",

"stream": false

}

WebUI配置

此处主要参考:https://jishuzhan.net/article/1886356694607335426

- 安装Open-WebUI

使用 Docker 的方式部署 open-webui ,使用gpu的话按照如下命令进行

sudo docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

官方的地址可能会出现网络问题,可以使用国内地址:

sudo docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always registry.cn-shenzhen.aliyuncs.com/funet8/open-webui:cuda

需要安装nvidia-container-toolkit并配置docker以使用该工具包。

参考官网给出的指南:https://docs.nvidia.com/datacenter/cloud-native/container-toolkit/latest/install-guide.html

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \

&& curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list