25年2月20日智能机器人公司 Figure.AI 发布的 VLA 模型 “Helix: A Vision-Language-Action Model for Generalist Humanoid Control”。

Helix 是一种通才的视觉-语言-动作 (VLA) 模型,它将感知、语言理解和学习控制统一起来,以克服机器人领域的多个长期挑战。Helix 的创新点:

全上身控制:Helix 是第一个输出整个人形上身(包括手腕、躯干、头部和各个手指)的高速率连续控制的 VLA。

多机器人协作:Helix 是第一个同时在两个机器人上运行的 VLA,使它们能够解决共享的、长期操纵任务,处理它们从未见过的目标。

拿起任何东西:配备 Helix 的 Figure Robot 现在可以拿起几乎任何小型家用物品,包括它们从未遇到过的数千件物品,只需遵循自然语言提示即可。

一个神经网络:与之前的方法不同,Helix 使用一组神经网络权重来学习所有行为(拾取和放置物品、使用抽屉和冰箱、以及跨机器人交互),而无需任何特定于任务的微调。

商业就绪:Helix 是一款完全在嵌入式低功耗 GPU 上运行的 VLA,可立即投入商业部署。

人形机器人的规范化

家庭是机器人面临的最大挑战。与受控的工业环境不同,家中堆满了无数物品——精致的玻璃器皿、皱巴巴的衣服、散落的玩具——每件物品的形状、大小、颜色和纹理都不可预测。要使机器人在家庭中发挥作用,它们需要能够按需产生智能的新行为,尤其是对于它们从未见过的物体。

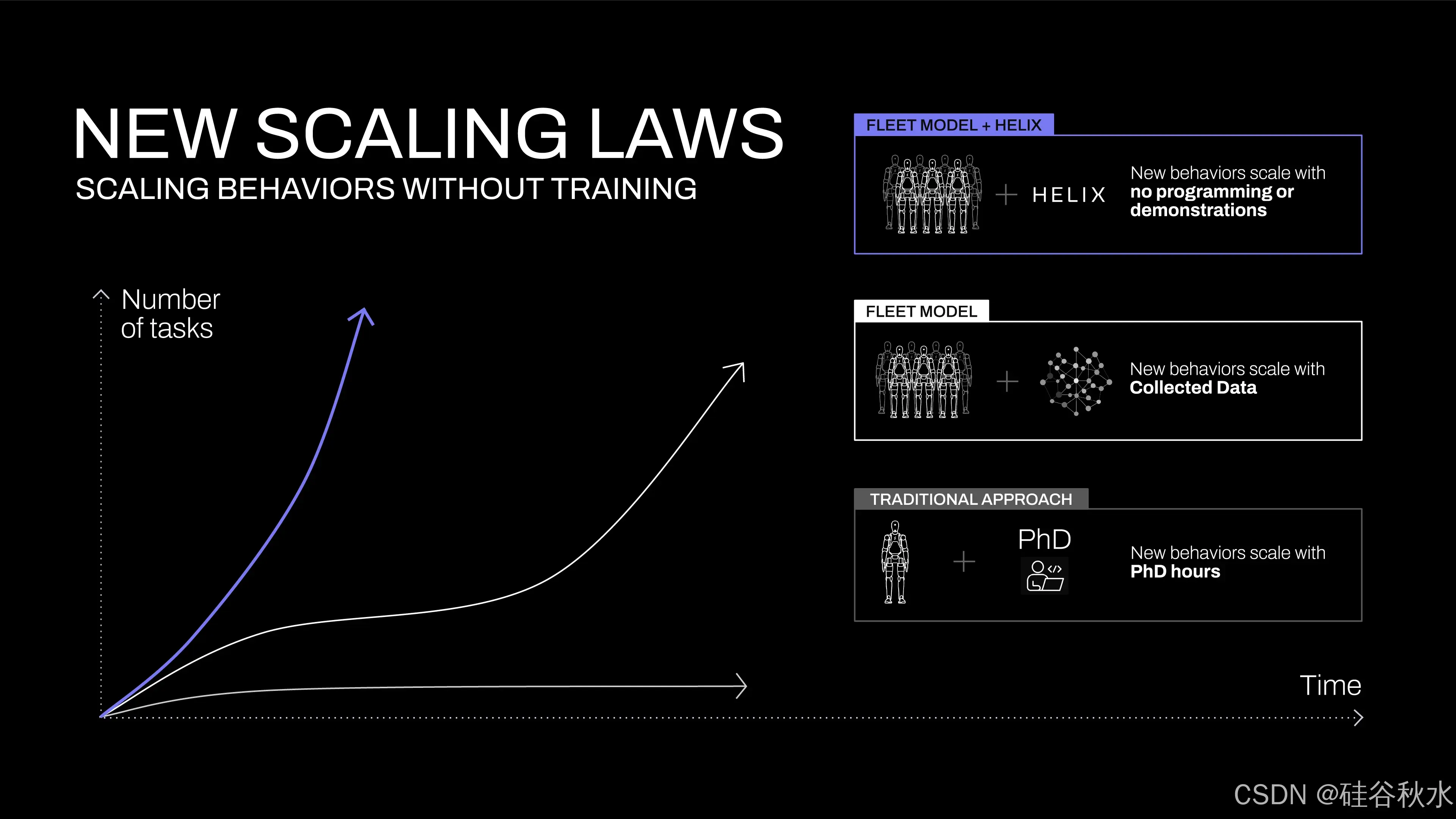

如果不进行重大改变,目前的机器人技术状态将无法规模化到家庭。目前,教机器人哪怕是一种新行为也需要大量的人力:要么是数小时的博士级专家手动编程,要么是数千次演示。考虑到家庭问题确实如此庞大,这两种方法都过于昂贵。

但人工智能的其他领域已经掌握这种即时泛化。如果能简单地将视觉-语言模型 (VLM) 中捕获的丰富语义知识直接转化为机器人动作,会怎么样?这种新功能将从根本上改变机器人的规模化轨迹,如上图所示。突然之间,曾经需要数百次演示的新技能只需用自然语言与机器人交谈即可立即获得。关键问题是:如何从 VLM 中提取所有这些常识性知识并将其转化为可泛化的机器人控制?Figure-AI 构建 Helix 来弥补这一差距。

Helix:用于整个上半身控制的“系统 1、系统 2” VLA

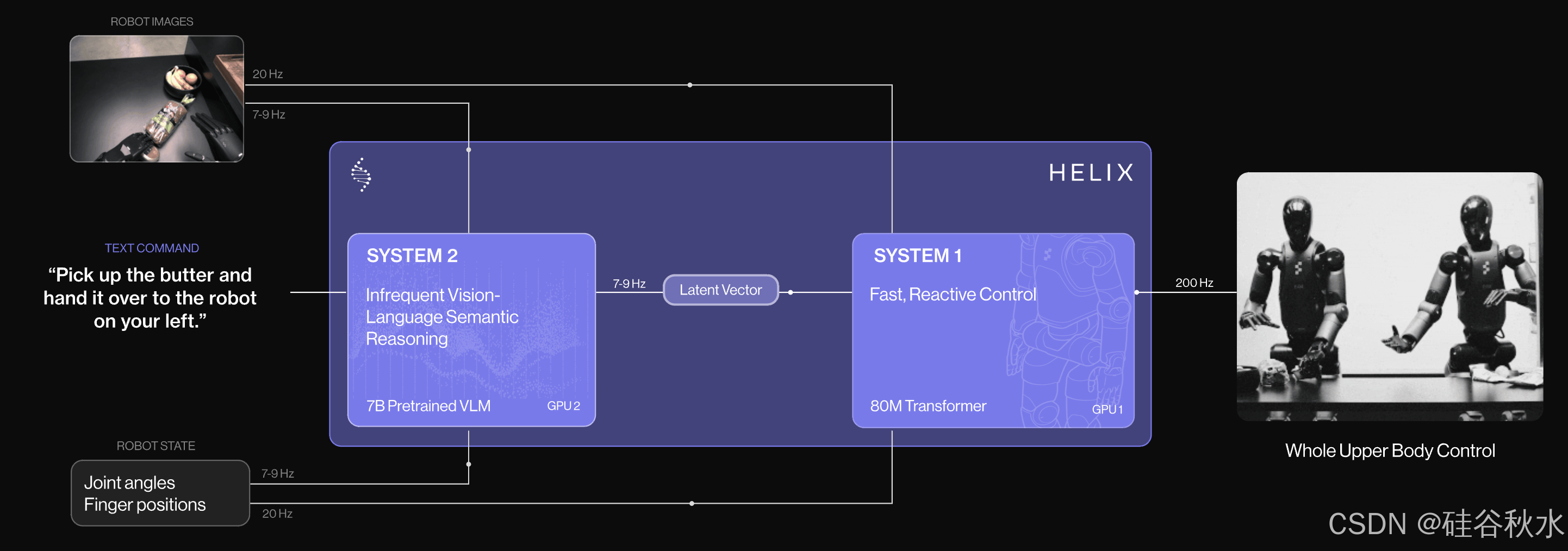

Helix 是一个“系统 1、系统 2” VLA 模型,用于高速、灵巧地控制整个人形机器人上半身。

先前的方法面临一个根本性的权衡:VLM 主干是通用的,但速度不快,而机器人视觉运动策略是快速的,但不是通用的。Helix 通过两个互补的系统解决这一权衡,这两个系统经过端到端的训练,可以进行通信:

系统 2 (S2):一个机载互联网预训练的 VLM,以 7-9 Hz 运行,用于场景理解和语言理解,实现跨目标和上下文的广泛泛化。

系统 1 (S1):一种快速反应的视觉运动策略,可将 S2 产生的潜语义表征转换为 200 Hz 的精确连续机器人动作。

这种解耦架构,允许每个系统在其最佳时间尺度上运行。 S2 可以“慢慢思考”高层次目标,而 S1 可以“快速思考”实时执行和调整动作。例如,在协作行为中,S1 可以快速适应伙伴机器人不断变化的动作,同时保持 S2 的语义目标。

Helix 的设计与现有方法相比,具有以下几个优点:

速度和泛化:Helix 的速度与专门的单任务行为克隆策略相匹配,同时将零样本泛化到数千个新测试目标。

可规模化:Helix 直接输出高维动作空间的连续控制,避免之前 VLA 方法中使用的复杂动作token化方案,这些方案在低维控制设置(例如二值并行夹持器)中取得一些成功,但在高维人形控制中面临规模化挑战。

架构简单:Helix 使用标准架构 - 系统 2 的开源、开放权重 VLM 和 S1 的简单基于Transformer的视觉运动策略。

关注点分离:将 S1 和 S2 解耦,能够分别在每个系统上进行迭代,而不受寻找统一观察空间或动作表示的限制。

模型和训练细节

数据

收集高质量的多机器人、多操作员数据集,其中包含各种遥控行为,总共约 500 小时。为了生成自然语言条件训练对,用自动标注 VLM 来生成事后指令。VLM 处理来自机载机器人摄像头的分段视频片段,并提示:“您会给机器人什么指令来获得此视频中看到的动作?”训练期间处理的所有项目均排除在评估之外,以防止污染。

架构

系统由两个主要组件组成:S2(VLM 主干)和 S1(潜条件视觉运动Transformer)。S2 建立在 7B 参数开源、开放权重 VLM 上,该 VLM 在互联网规模数据上进行预训练。它将单目机器人图像和机器人状态信息(包括手腕姿势和手指位置)投影到视觉语言嵌入空间后进行处理。结合指定所需行为的自然语言命令,S2 将所有语义任务相关信息提炼为单个连续潜向量,并传递给 S1 以调节其低级操作。

S1 是一个 80M 参数交叉注意编码器-解码器Transformer,用于处理低级控制。它依靠全卷积、多尺度视觉主干进行视觉处理,该主干由完全在模拟中完成的预训练初始化。虽然 S1 接收与 S2 相同的图像和状态输入,但它以更高的频率处理它们,以实现响应更快的闭环控制。来自 S2 的潜向量被投射到 S1 的 token 空间中,并沿序列维度与来自 S1 视觉主干的视觉特征连接起来,提供任务调节。

S1 以 200hz 输出完整的上半身人形控制,包括所需的手腕姿势、手指屈曲和外展控制以及躯干和头部方向目标。在动作空间中附加一个合成的“任务完成百分比”动作,使 Helix 能够预测自己的终止条件,从而更容易对多个学习的行为进行排序。

训练

Helix 完全是端到端训练的,从原始像素和文本命令映射到具有标准回归损失的连续动作。梯度通过用于调节 S1 行为的潜通信向量从 S1 反向传播到 S2,从而允许对两个组件进行联合优化。Helix 不需要特定于任务的调整;它保持单个训练阶段和单个神经网络权重集,而无需单独的动作头或每个任务的微调阶段。

在训练期间,在 S1 和 S2 输入之间添加时间偏移。此偏移经过标定以匹配 S1 和 S2 部署推理延迟之间的差距,确保部署期间的实时控制要求准确反映在训练中。

优化的流式推理

Helix 的训练设计可在 Figure Robot 上实现高效的模型并行部署,每个机器人都配备双低功耗嵌入式 GPU。推理流水线分为 S2(高级潜规划)和 S1(低级控制)模型,每个模型都在专用 GPU 上运行。S2 作为异步后台进程运行,使用最新的观察结果(机载摄像头和机器人状态)和自然语言命令。它不断更新编码高级行为意图的共享内存潜向量。

S1 作为单独的实时进程执行,保持平稳整个上身动作所需的关键 200Hz 控制回路。它采用最新观察结果和最新的 S2 潜向量。S2 和 S1 推理之间固有的速度差异,自然导致 S1 在机器人观察上以更高的时间分辨率运行,从而为反应控制创建更紧密的反馈回路。

这种部署策略刻意反映训练中引入的时间偏移,最大限度地减少训练推理分布差距。异步执行模型允许两个进程以其最佳频率运行,能够以与最快的单任务模仿学习策略一样快的速度运行 Helix。

结果

细粒度 VLA 整个上身控制

Helix 以 200Hz 的频率协调 35 自由度动作空间,控制从单个手指运动到末端执行器轨迹、头部注视和躯干姿势等一切。头部和躯干控制带来独特的挑战——当它们移动时,会改变机器人可以触及的范围和可以看到的范围,从而产生反馈循环,而这种反馈循环在历史上会导致不稳定。如下演示这种协调的实际操作:机器人用头部平稳地跟踪双手,同时调整躯干以获得最佳触及范围,同时保持精确的手指控制以进行抓握。从历史上看,在如此高维的动作空间中实现这种精度水平被认为是极具挑战性的,即使对于单个已知任务也是如此。

零样本多机器人协调

在具有挑战性的多智体操作场景中将 Helix 推向极限:两个 Figure Robot 之间的协作零样本杂货存储。上面第一个演示展示两个基本进步:机器人成功地操作全新的杂货(训练期间从未遇到过的物品),展示了对各种形状、大小和材料的稳健泛化。此外,两个机器人都使用相同的 Helix 模型权重进行操作,无需进行针对机器人的训练或明确的角色分配。它们通过自然语言提示实现协调,例如“将一袋饼干递给你右边的机器人”或“从你左边的机器人那里接过一袋饼干并将其放在打开的抽屉里”。这是首次使用 VLA 展示多个机器人之间灵活、扩展的协作操作,鉴于它们成功处理全新的目标,这一点尤为重要。

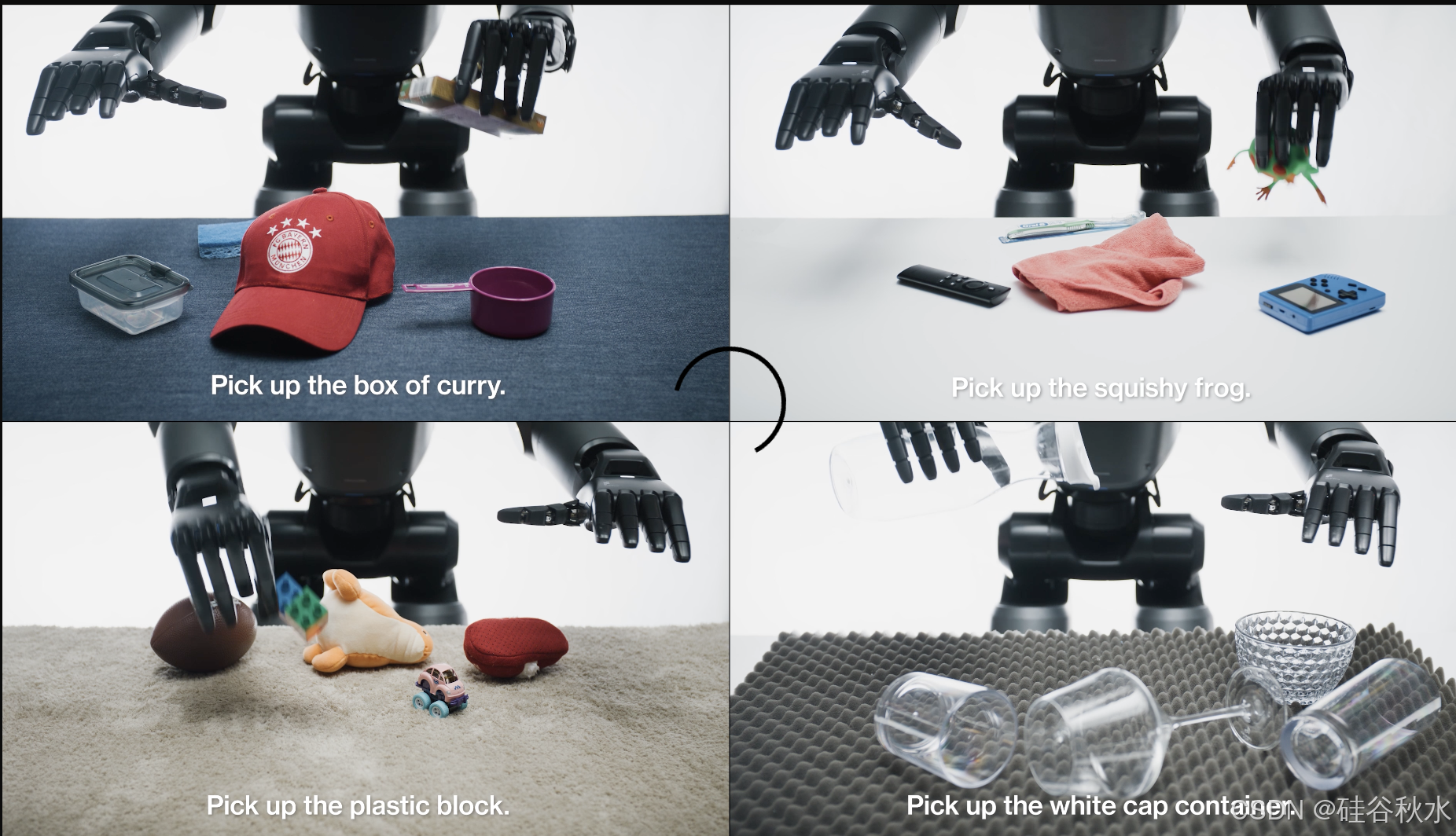

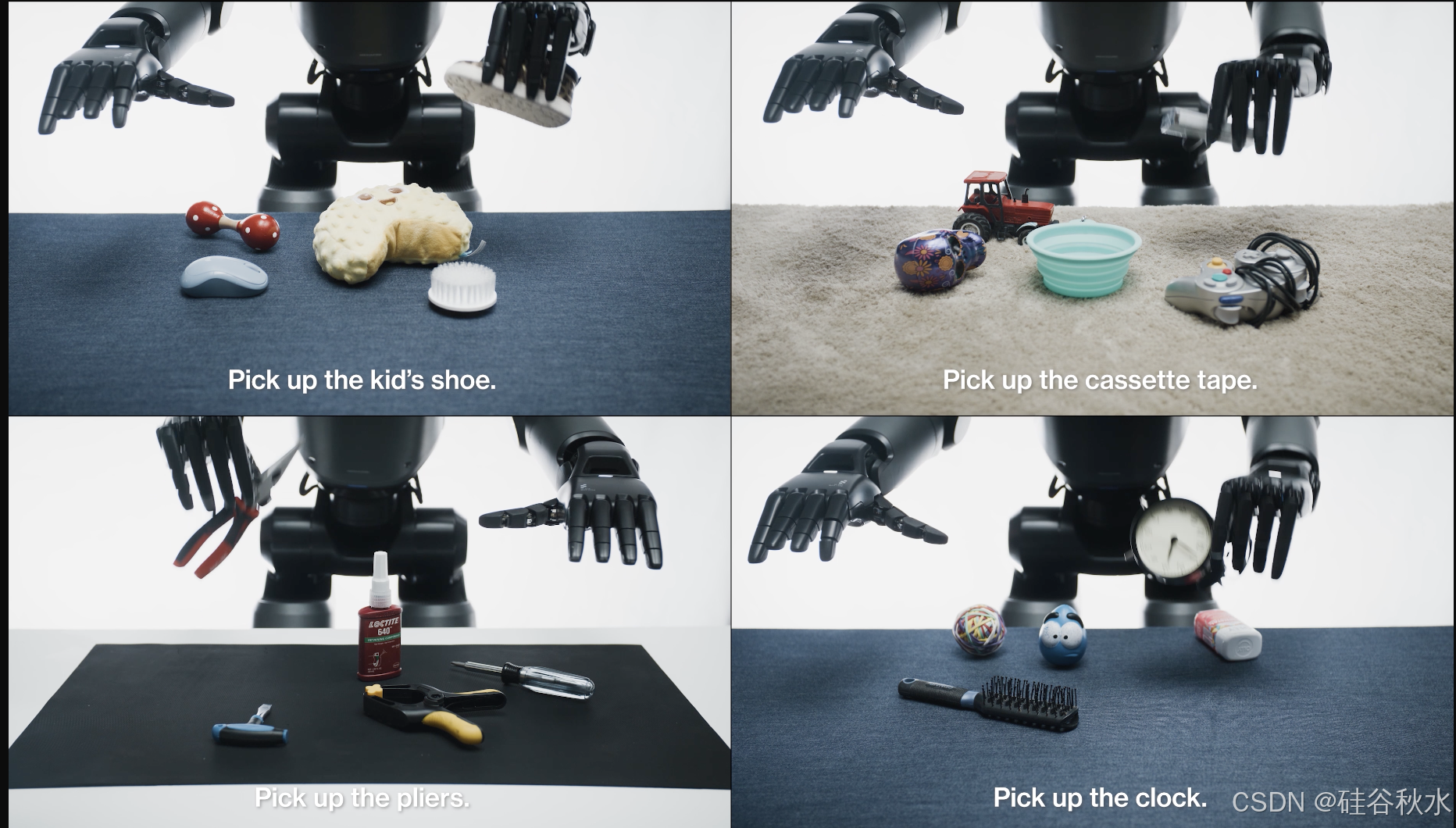

涌现的“拾起任何东西”能力

配备 Helix 的 Figure Robot 只需发出简单的“拾起 [X]”命令,便可拾起几乎任何小型家用物品。在系统测试中,机器人成功处理杂乱无章的数千件新奇物品——从玻璃器皿和玩具-到-工具和衣物——无需任何事先演示或自定义编程。

特别值得注意的是, Helix 如何弥合互联网规模的语言理解和精确的机器人控制之间的差距。例如,当提示“拾起沙漠物品”时,Helix 不仅识别出玩具仙人掌符合这个抽象概念,而且还会选择最近的手并执行安全抓住它所需的精确运动命令。

这种通用的“语言-到-动作”抓取能力,为在非结构化环境中部署人形机器人开辟令人兴奋的新可能性。

讨论

Helix 的训练效率极高

Helix 以极少的资源实现强大的目标泛化。总共使用约 500 小时的高质量监督数据来训练 Helix,这仅仅是之前收集的 VLA 数据集的一小部分(<5%),并且不依赖于多机器人具身收集或多阶段训练。这种收集规模更接近现代单任务模仿学习数据集。尽管数据需求相对较小,但 Helix 可以扩展到更具挑战性的全上身人形控制动作空间,具有高速率、高维度的输出。

一组权重

现有的 VLA 系统通常需要专门的微调或专用动作头来优化不同高级行为的性能。值得注意的是,Helix 使用单一统一模型在不同任务中实现强大的性能。仅使用一组神经网络权重(系统-2 为 7B,系统-1 为 80M),Helix 就可以在各种容器中拾取和放置物品、操作抽屉和冰箱、协调灵巧的多机器人交接以及操纵数千个新目标。

结论

Helix 是一个通过自然语言直接控制整个人形机器人上半身的视觉-语言-动作模型。与早期的机器人系统不同,Helix 能够即时生成长距离、协作、灵巧的操作,而无需任何特定于任务的演示或大量的手动编程。Helix 表现出强大的目标泛化能力,能够拾取数千种形状、大小、颜色和材料特性各异的新奇家居用品,这些物品在训练中从未遇到过,只需用自然语言询问即可。这代表 Figure 在扩展人形机器人行为方面迈出变革性的一步——随着机器人越来越多地协助日常家庭环境,这一步将至关重要。

虽然这些早期结果确实令人兴奋,但它们只是触及了可能性的表面。渴望看到将 Helix 扩大 1,000 倍甚至更多时会发生什么。