Moss前沿AI

【OpenAI】获取OpenAI API Key的多种方式全攻略:从入门到精通,再到详解教程!!

【VScode】VSCode中的智能AI-GPT编程利器,全面揭秘ChatMoss & ChatGPT中文版

【GPT-o1系列模型!支持Open API调用、自定义助手、文件上传等强大功能,助您提升工作效率!】>>> - CodeMoss & ChatGPT-AI中文版

本文将系统性地介绍如何在SpringBoot项目中整合Avro与Kafka,涵盖环境配置、依赖管理、代码实现等各个环节,帮助读者从零开始,快速掌握这一整合过程。

相关技术简介

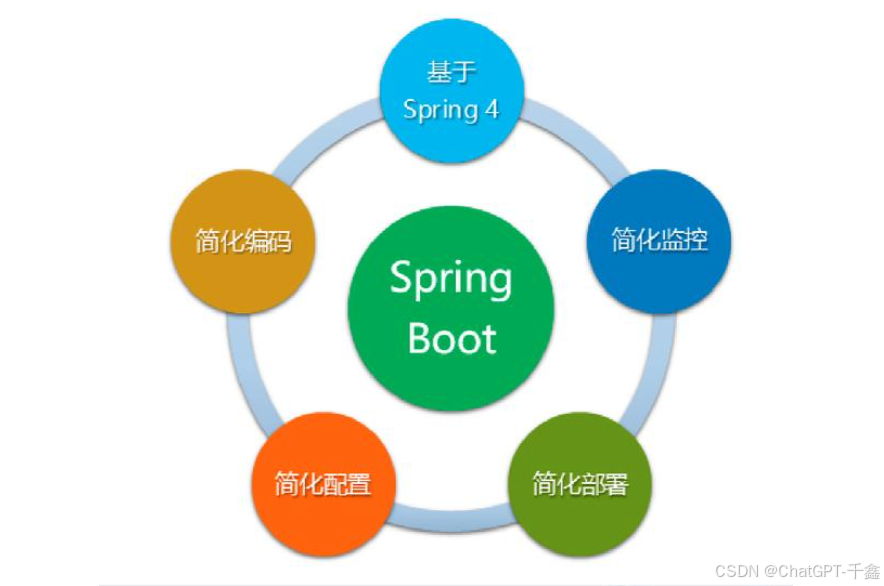

SpringBoot概述

SpringBoot是基于Spring框架的快速开发平台,旨在简化Spring应用的配置与部署。通过约定优于配置的理念,SpringBoot极大地降低了项目的初始设置和开发成本,广泛应用于现代微服务架构中。

Avro简介

Avro是Apache推出的一款数据序列化系统,具有紧凑的二进制格式、高效的序列化与反序列化速度,以及强大的数据模式支持。Avro常用于大数据处理、消息传输等场景,特别适合与Kafka等消息系统结合使用。

Kafka概述

Kafka是由Apache开发的分布式流平台,具备高吞吐量、低延迟、可水平扩展和容错性强等特点。Kafka主要用于实时数据流处理、日志聚合、消息队列等应用场景,是现代数据架构中的关键组件之一。

环境配置

系统需求与依赖安装

在开始整合之前,请确保您的开发环境满足以下要求:

- 操作系统:Windows 10 或更新版本,macOS,Linux

- Java版本:Java 8 或更高

- 构建工具:Maven 或 Gradle

- IDE:IntelliJ IDEA、Eclipse等

- 其他工具:Git、Docker(可选,用于部署Kafka)

安装Java

确保已安装Java,并配置好JAVA_HOME环境变量。可以通过以下命令检查Java版本:

java -version

安装Maven

如果使用Maven作为构建工具,请确保已安装Maven,并配置好MAVEN_HOME环境变量。

mvn -v

搭建Apache Kafka环境

您可以选择本地安装Kafka,或使用Docker快速启动Kafka集群。以下以Docker为例,介绍快速搭建Kafka环境的方法。

使用Docker启动Kafka

首先,确保已安装Docker。然后,创建一个docker-compose.yml文件,内容如下:

version: '2'

services:

zookeeper:

image: wurstmeister/zookeeper

ports:

- "2181:2181"

kafka:

image: wurstmeister/kafka

ports:

- "9092:9092"

environment:

KAFKA_ADVERTISED_HOST_NAME: localhost

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181

volumes:

- /var/run/docker.sock:/var/run/docker.sock

启动Kafka服务:

docker-compose up -d

通过以下命令验证Kafka是否成功启动:

docker ps

确保kafka和zookeeper容器正在运行。

创建SpringBoot项目

使用Spring Initializr快速创建一个SpringBoot项目。

-

访问 Spring Initializr,选择以下配置:

- Project: Maven Project

- Language: Java

- Spring Boot: 选择最新稳定版本

- Project Metadata:

- Group: com.example

- Artifact: avro-kafka-integration

- Dependencies:

- Spring Web

- Spring for Apache Kafka

- Avro

-

点击“Generate”,下载项目压缩包并解压。

-

使用IDE导入该项目。

SpringBoot与Avro集成

Avro在SpringBoot中的应用

Avro作为高效的序列化框架,常用于在微服务之间传输结构化数据。它通过定义数据模式(Schema),确保数据的兼容性和一致性。此外,Avro支持与多种编程语言的互操作,使其成为分布式系统中的理想选择。

Avro依赖配置与生成模型

首先,在pom.xml中添加Avro相关依赖和插件:

<dependencies>

<!-- Avro依赖 -->

<dependency>

<groupId>org.apache.avro</groupId>

<artifactId>avro</artifactId>

<version>1.11.1</version>

</dependency>

<!-- 其他依赖 -->

</dependencies>

<build>

<plugins>

<!-- Avro代码生成插件 -->

<plugin>

<groupId>org.apache.avro</groupId>

<artifactId>avro-maven-plugin</artifactId>

<version>1.11.1</version>

<executions>

<execution>

<phase>generate-sources</phase>

<goals>

<goal>schema</goal>

</goals>

<configuration>

<sourceDirectory>${project.basedir}/src/main/avro</sourceDirectory>

<outputDirectory>${project.basedir}/src/main/java</outputDirectory>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>

创建Avro模式文件

在项目的src/main/avro目录下创建一个User.avsc文件,定义数据模式:

{

"namespace": "com.example.avrokafka",

"type": "record",

"name": "User",

"fields": [

{"name": "id", "type": "int"},

{"name": "name", "type": "string"},

{"name": "email", "type": "string"}

]

}

生成Avro模型类

运行以下命令生成Java类:

mvn clean compile

此时,User.java将自动生成在src/main/java/com/example/avrokafka目录下。

序列化与反序列化示例

为了在Kafka中传输Avro数据,我们需要配置序列化与反序列化器。

首先,创建Avro序列化器和反序列化器:

package com.example.avrokafka.config;

import org.apache.kafka.common.serialization.Serializer;

import org.apache.kafka.common.serialization.Deserializer;

import org.apache.avro.specific.SpecificRecordBase;

import org.apache.avro.io.BinaryEncoder;

import org.apache.avro.io.DatumWriter;

import org.apache.avro.io.DatumReader;

import org.apache.avro.io.BinaryDecoder;

import org.apache.avro.io.DecoderFactory;

import org.apache.avro.io.EncoderFactory;

import org.apache.avro.specific.SpecificDatumWriter;

import org.apache.avro.specific.SpecificDatumReader;

import java.io.ByteArrayOutputStream;

import java.io.IOException;

import java.util.Map;

public class AvroSerializer<T extends SpecificRecordBase> implements Serializer<T> {

@Override

public void configure(Map<String, ?> configs, boolean isKey) { }

@Override

public byte[] serialize(String topic, T data) {

ByteArrayOutputStream out = new ByteArrayOutputStream();

DatumWriter<T> writer = new SpecificDatumWriter<>(data.getSchema());

BinaryEncoder encoder = EncoderFactory.get().binaryEncoder(out, null);

try {

writer.write(data, encoder);

encoder.flush();

} catch (IOException e) {

throw new RuntimeException("Failed to serialize Avro message", e);

}

return out.toByteArray();

}

@Override

public void close() { }

}

public class AvroDeserializer<T extends SpecificRecordBase> implements Deserializer<T> {

private Class<T> type;

public AvroDeserializer(Class<T> type) {

this.type = type;

}

@Override

public void configure(Map<String, ?> configs, boolean isKey) { }

@Override

public T deserialize(String topic, byte[] data) {

DatumReader<T> reader = new SpecificDatumReader<>(type);

BinaryDecoder decoder = DecoderFactory.get().binaryDecoder(data, null);

try {

return reader.read(null, decoder);

} catch (IOException e) {

throw new RuntimeException("Failed to deserialize Avro message", e);

}

}

@Override

public void close() { }

}

这些序列化器和反序列化器将在Kafka生产者和消费者中使用,以确保数据能够正确地被编码和解码。

SpringBoot与Kafka集成

Kafka在SpringBoot中的应用

Kafka作为高性能的消息传递系统,广泛应用于实时数据处理、日志收集、事件驱动架构等场景。通过与SpringBoot的无缝集成,开发者可以轻松地在应用中实现消息的生产与消费。

Kafka依赖配置与基本设置

在pom.xml中添加Spring for Apache Kafka依赖:

<dependencies>

<!-- Spring for Apache Kafka -->

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

<version>3.0.7</version>

</dependency>

<!-- 其他依赖 -->

</dependencies>

配置Kafka属性

在application.properties或application.yml中添加Kafka相关配置:

spring:

kafka:

bootstrap-servers: localhost:9092

producer:

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: com.example.avrokafka.config.AvroSerializer

consumer:

group-id: avro-consumer-group

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

value-deserializer: com.example.avrokafka.config.AvroDeserializer

auto-offset-reset: earliest

注意:在消费者配置中,value-deserializer需要指定Avro反序列化器,同时需要提供Avro模型的类。

生产者与消费者示例

创建Kafka生产者

package com.example.avrokafka.producer;

import com.example.avrokafka.User;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.stereotype.Service;

@Service

public class UserProducer {

private static final String TOPIC = "users";

@Autowired

private KafkaTemplate<String, User> kafkaTemplate;

public void sendUser(User user) {

kafkaTemplate.send(TOPIC, user.getName(), user);

System.out.println("Sent user: " + user);

}

}

创建Kafka消费者

package com.example.avrokafka.consumer;

import com.example.avrokafka.User;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.stereotype.Service;

@Service

public class UserConsumer {

@KafkaListener(topics = "users", groupId = "avro-consumer-group")

public void consume(User user) {

System.out.println("Consumed user: " + user);

}

}

测试生产者与消费者

创建一个REST控制器,触发消息的发送和消费:

package com.example.avrokafka.controller;

import com.example.avrokafka.User;

import com.example.avrokafka.producer.UserProducer;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.*;

@RestController

@RequestMapping("/api/users")

public class UserController {

@Autowired

private UserProducer userProducer;

@PostMapping

public String createUser(@RequestParam int id, @RequestParam String name, @RequestParam String email) {

User user = new User(id, name, email);

userProducer.sendUser(user);

return "User sent to Kafka!";

}

}

启动SpringBoot应用后,通过发送POST请求到/api/users,即可触发Kafka消息的发送与消费。

SpringBoot整合Avro与Kafka

整合步骤详细解析

将Avro与Kafka整合进SpringBoot项目,需完成以下几个关键步骤:

- 配置Avro序列化器与反序列化器:确保Kafka能够正确处理Avro数据。

- 定义Avro数据模型:通过Avro的schema定义数据结构,并生成相应的Java类。

- 配置Kafka生产者与消费者:指定使用Avro序列化器与反序列化器。

- 实现消息的生产与消费逻辑。

综合代码示例

以下是一个完整的整合示例,展示如何在SpringBoot项目中结合Avro与Kafka,实现高效的数据传输。

项目结构

src

├── main

│ ├── avro

│ │ └── User.avsc

│ ├── java

│ │ └── com.example.avrokafka

│ │ ├── AvroKafkaIntegrationApplication.java

│ │ ├── config

│ │ │ ├── AvroDeserializer.java

│ │ │ ├── AvroSerializer.java

│ │ │ └── KafkaConfig.java

│ │ ├── controller

│ │ │ └── UserController.java

│ │ ├── consumer

│ │ │ └── UserConsumer.java

│ │ ├── producer

│ │ │ └── UserProducer.java

│ │ └── User.java

│ └── resources

│ └── application.yml

└── pom.xml

完整代码文件

AvroKafkaIntegrationApplication.java

package com.example.avrokafka;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

@SpringBootApplication

public class AvroKafkaIntegrationApplication {

public static void main(String[] args) {

SpringApplication.run(AvroKafkaIntegrationApplication.class, args);

}

}

KafkaConfig.java

package com.example.avrokafka.config;

import com.example.avrokafka.User;

import org.apache.kafka.clients.consumer.ConsumerConfig;

import org.apache.kafka.clients.producer.ProducerConfig;

import org.apache.kafka.common.serialization.StringDeserializer;

import org.apache.kafka.common.serialization.StringSerializer;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.kafka.annotation.EnableKafka;

import org.springframework.kafka.core.*;

import java.util.HashMap;

import java.util.Map;

@EnableKafka

@Configuration

public class KafkaConfig {

@Bean

public ProducerFactory<String, User> producerFactory() {

Map<String, Object> configProps = new HashMap<>();

configProps.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

configProps.put(ProducerConfig.KEY_SERIALIZER_CLASS_CONFIG, StringSerializer.class);

configProps.put(ProducerConfig.VALUE_SERIALIZER_CLASS_CONFIG, AvroSerializer.class);

return new DefaultKafkaProducerFactory<>(configProps);

}

@Bean

public KafkaTemplate<String, User> kafkaTemplate() {

return new KafkaTemplate<>(producerFactory());

}

@Bean

public ConsumerFactory<String, User> consumerFactory() {

Map<String, Object> props = new HashMap<>();

props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, "localhost:9092");

props.put(ConsumerConfig.GROUP_ID_CONFIG, "avro-consumer-group");

props.put(ConsumerConfig.KEY_DESERIALIZER_CLASS_CONFIG, StringDeserializer.class);

props.put(ConsumerConfig.VALUE_DESERIALIZER_CLASS_CONFIG, AvroDeserializer.class);

return new DefaultKafkaConsumerFactory<>(props, new StringDeserializer(), new AvroDeserializer<>(User.class));

}

@Bean

public ConcurrentKafkaListenerContainerFactory<String, User> kafkaListenerContainerFactory() {

ConcurrentKafkaListenerContainerFactory<String, User> factory = new ConcurrentKafkaListenerContainerFactory<>();

factory.setConsumerFactory(consumerFactory());

return factory;

}

}

User.java

package com.example.avrokafka;

import org.apache.avro.specific.SpecificRecordBase;

public class User extends SpecificRecordBase {

private int id;

private String name;

private String email;

// 默认构造方法

public User() {}

public User(int id, String name, String email) {

this.id = id;

this.name = name;

this.email = email;

}

// Getters 和 Setters

public int getId() {

return id;

}

public void setId(int id) {

this.id = id;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public String getEmail() {

return email;

}

public void setEmail(String email) {

this.email = email;

}

}

UserProducer.java

package com.example.avrokafka.producer;

import com.example.avrokafka.User;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.kafka.core.KafkaTemplate;

import org.springframework.stereotype.Service;

@Service

public class UserProducer {

private static final String TOPIC = "users";

@Autowired

private KafkaTemplate<String, User> kafkaTemplate;

public void sendUser(User user) {

kafkaTemplate.send(TOPIC, user.getName(), user);

System.out.println("Sent user: " + user);

}

}

UserConsumer.java

package com.example.avrokafka.consumer;

import com.example.avrokafka.User;

import org.springframework.kafka.annotation.KafkaListener;

import org.springframework.stereotype.Service;

@Service

public class UserConsumer {

@KafkaListener(topics = "users", groupId = "avro-consumer-group")

public void consume(User user) {

System.out.println("Consumed user: " + user);

}

}

UserController.java

package com.example.avrokafka.controller;

import com.example.avrokafka.User;

import com.example.avrokafka.producer.UserProducer;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.*;

@RestController

@RequestMapping("/api/users")

public class UserController {

@Autowired

private UserProducer userProducer;

@PostMapping

public String createUser(@RequestParam int id, @RequestParam String name, @RequestParam String email) {

User user = new User(id, name, email);

userProducer.sendUser(user);

return "User sent to Kafka!";

}

}

application.yml

spring:

kafka:

bootstrap-servers: localhost:9092

producer:

key-serializer: org.apache.kafka.common.serialization.StringSerializer

value-serializer: com.example.avrokafka.config.AvroSerializer

consumer:

group-id: avro-consumer-group

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

value-deserializer: com.example.avrokafka.config.AvroDeserializer

auto-offset-reset: earliest

运行项目并测试

-

启动Kafka服务(确保Docker中的Kafka容器已运行)。

-

启动SpringBoot应用。

-

通过工具(如Postman)发送POST请求到

http://localhost:8080/api/users,例如:POST /api/users?id=1&name=John Doe&[email protected] HTTP/1.1 Host: localhost:8080 -

观察控制台输出,您将看到生产者发送的消息以及消费者接收到的消息。

性能优化与最佳实践

Avro与Kafka的优化策略

- Schema Registry:使用Schema Registry(如Confluent Schema Registry)集中管理Avro模式,确保生产者和消费者使用统一的模式,避免版本兼容性问题。

- 压缩配置:在Kafka生产者配置中启用压缩(如Snappy或GZIP),减少网络传输的数据量,提高性能。

- 批量处理:配置生产者和消费者进行批量发送和接收,提高吞吐量。

- 并行消费:增加消费者实例,实现消费的并行化处理,提升处理能力。

常见问题及解决方案

-

Avro反序列化失败:

- 原因:生产者与消费者使用的Avro模式不一致。

- 解决:确保所有服务使用一致的Avro模式,并通过Schema Registry统一管理。

-

Kafka连接问题:

- 原因:Kafka服务未启动或网络配置错误。

- 解决:检查Kafka服务状态,确保

bootstrap-servers配置正确,网络通畅。

-

性能瓶颈:

- 原因:单个消费者处理能力不足。

- 解决:增加消费者实例,或优化消费者的处理逻辑,使用异步处理等方式提升性能。

总结

通过本文的详细讲解,您已经掌握了在SpringBoot项目中整合Avro与Kafka的完整过程。从环境配置到代码实现,从序列化与反序列化,到生产者与消费者的搭建,每一个步骤都为您揭示了高效微服务架构的关键要点。Avro与Kafka的结合,不仅提升了数据传输的效率,还确保了系统的高可靠性和可扩展性。

在实际项目中,您可以根据具体需求,进一步优化配置,采用Schema Registry等高级工具,构建更加健壮和高效的微服务系统。希望本文能够为您的开发工作提供实质性的帮助,助力您在微服务领域取得更大的成功。