先给出原文链接:https://arxiv.org/abs/1711.01124v1

代码暂未放出。

该论文核心思想:使用光流信息帮助跟踪。用光流信息指导历史特征融合,得到更好的目标模型,类似于根据光流做了特征对齐。

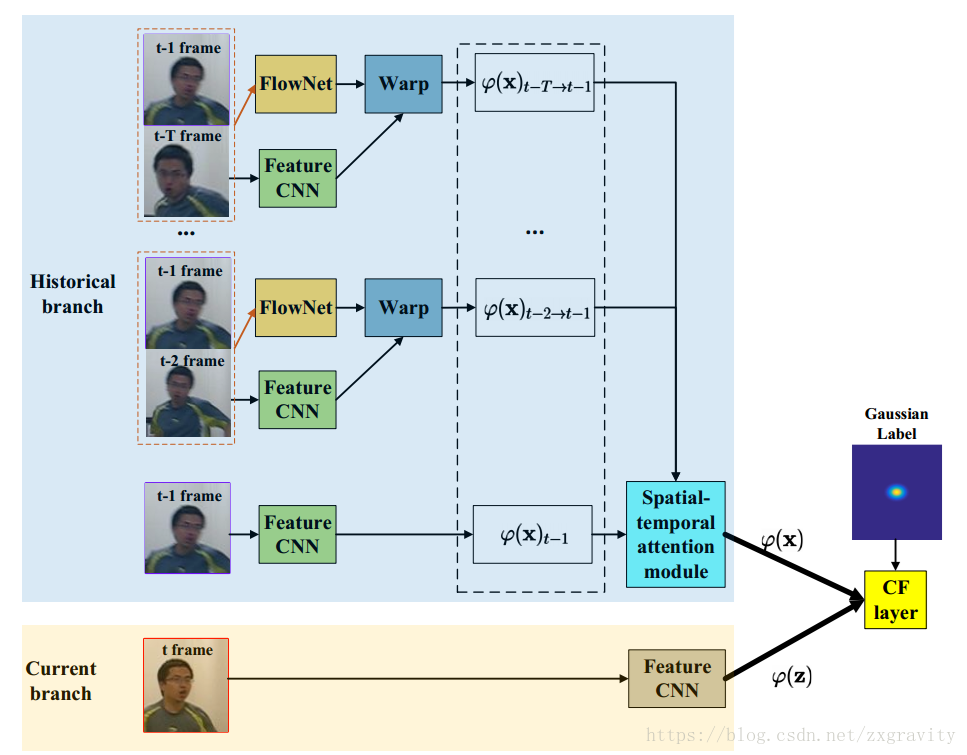

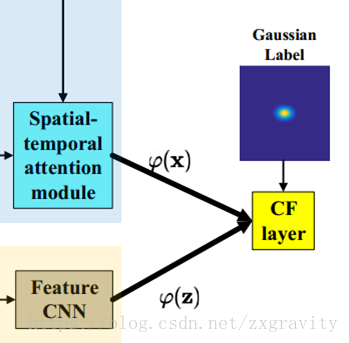

先上总框架:

(1)跟踪使用的特征由Feature CNN提取;

(2)光流信息由FlowNet提取;

(3)Warp操作指的是在光流的指导下将最近几帧(文章中使用5帧)的目标特征对齐到t-1帧;

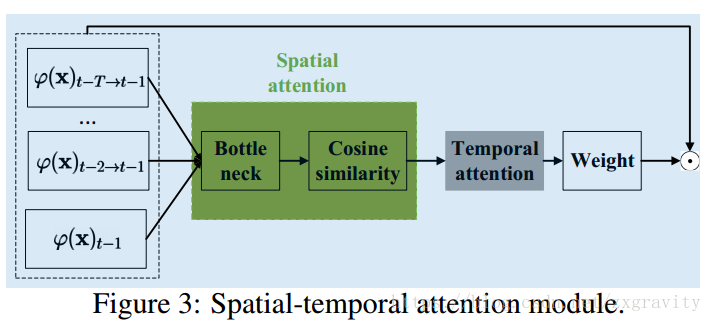

(4)Spatial-temporal attention给各通道特征赋予权值;

(5)在训练阶段,使用CF layer执行相关滤波操作,得到响应图,目的是方便端到端训练网络,CF layer层最早在CF Net中提出,该论文也给出了其正反向传播的推导,有兴趣可参看原文。测试阶段CF layer被换成了标准相关滤波模块。

训练过程中,各个有参数层或结构统一端到端训练。

下面分别来看看各个部分的结构和细节。

Feature CNN:由三个卷积层构成(3x3x128, 3x3x128, 3x3x96)。

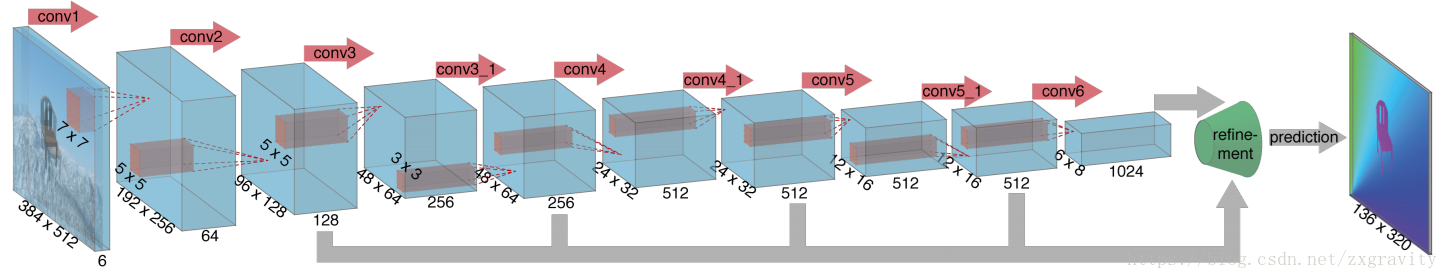

FlowNet:2015年被提出,是用来提取光流场的深度网络,9层卷积,如下图。

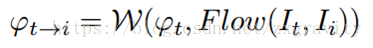

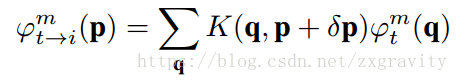

Warp操作:

Warp操作按特征通道进行:

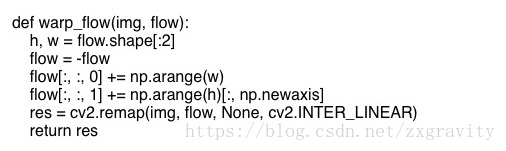

(1)算出第i帧目标到第t-1帧的光流场;

(2)然后对光流场取相反数,就认为是第t-1帧到第i帧的目标区域的光流场;

(3)然后从t-1帧图像的整像素点,根据光流逆推回去,得到第t-1帧中的整像素点对应到第i帧应该在什么位置(不一定是整数点);

(4)然后使用remap函数插值得到第i帧Warp到第t-1帧的特征。

这个操作存在的疑问是:认为第i帧到第t-1帧的光流直接取反即为t-1帧整像素点到第i帧的光流并不准确,直接取反,只能知道t-1帧对应于第i帧整像素点的那些像素点的光流(即a图中的红点),这个光流应该与t-1帧整像素点光流有差异。

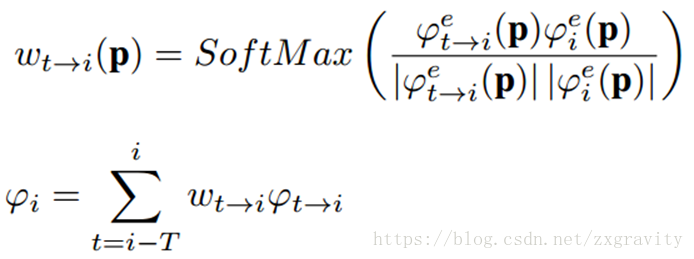

Spatial attention:

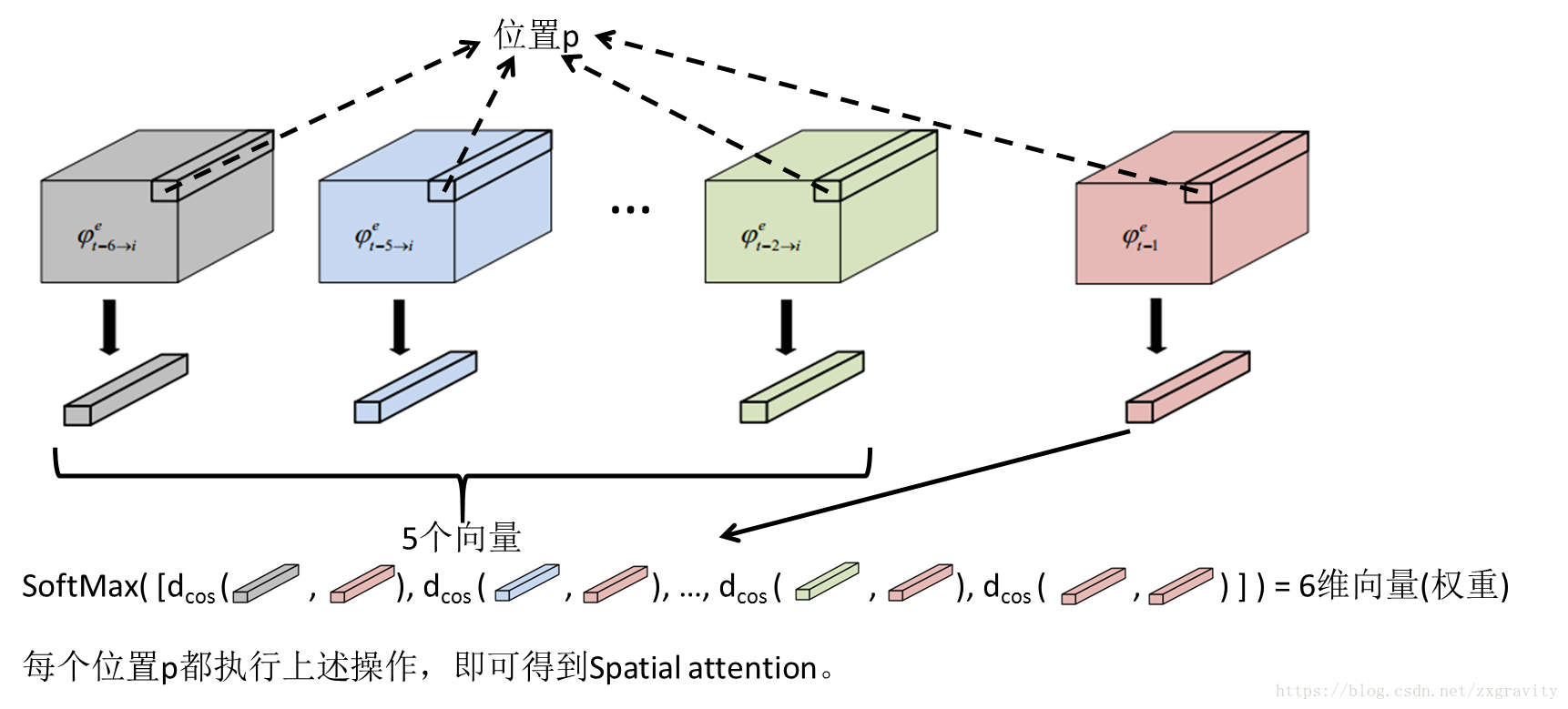

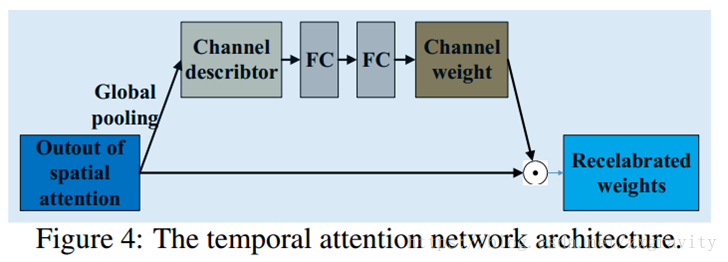

Temporal attention:

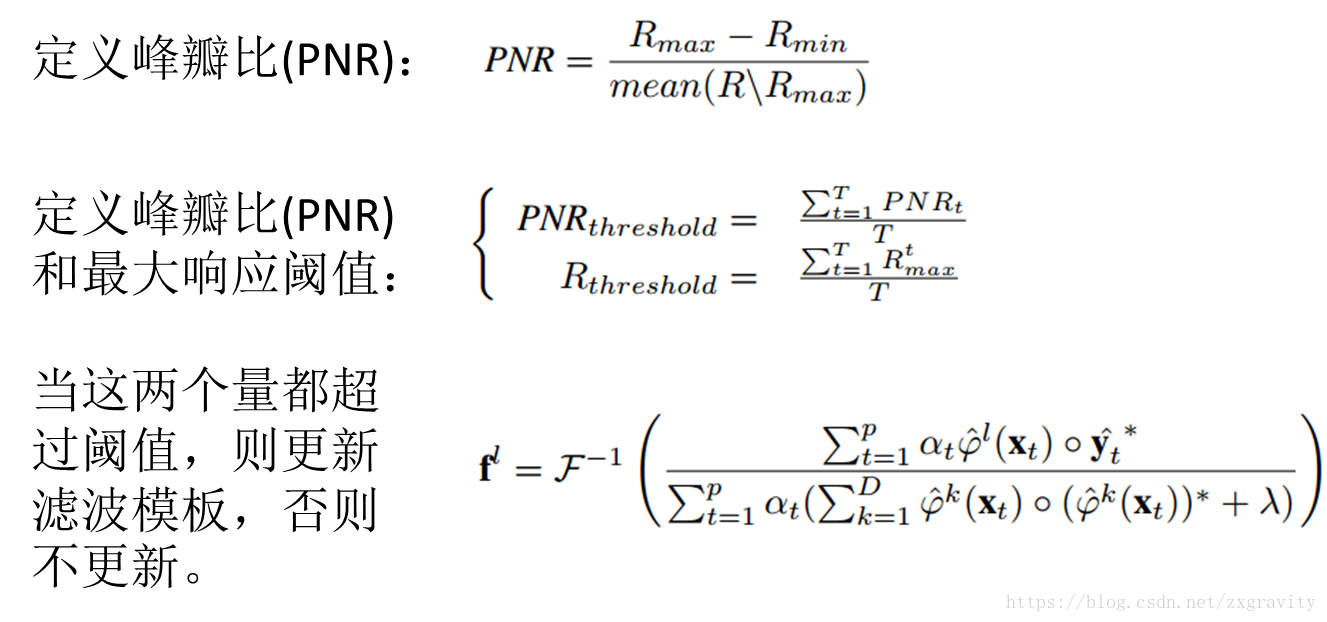

在线更新:

最后来看一看该论文的在线更新方法。

在跟踪阶段(testing),将CF layer替换成标准相关滤波跟踪模块,在线更新即是更新相关滤波模板。

其中,R为响应图,f为滤波模板。可以看出,阈值为历史值得平均(不知道是所有历史值的平均还是最近几帧的平均)。

最后给出部分实验结果:

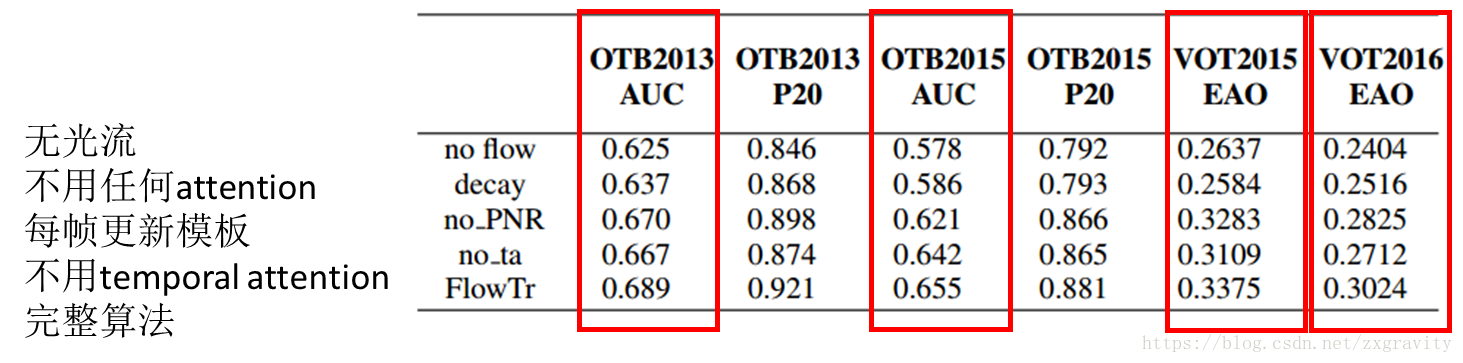

1.Ablation study:

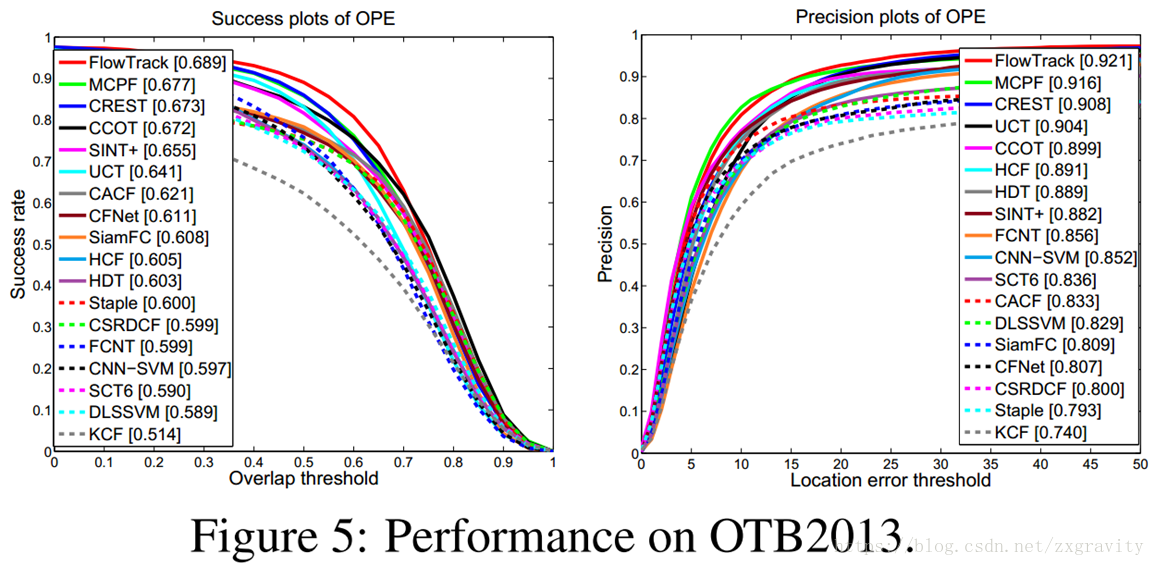

2.与其他算法对比:

完整实验结果参看论文原文。