每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

点击下面视频观看在B站本周AI更新:

B 站 链接 观看:

本周AI新闻:小型模型井喷_哔哩哔哩_bilibili

1) Mistral 基础模型 (https://huggingface.co/mistralai/Mistral-Nemo-Base-2407)和指令模型(https://huggingface.co/mistralai/Mistral-Nemo-Instruct-2407)

2) Project Oscar (https://go.googlesource.com/oscar/+/refs/heads/master/README.md)

Mistral NeMo

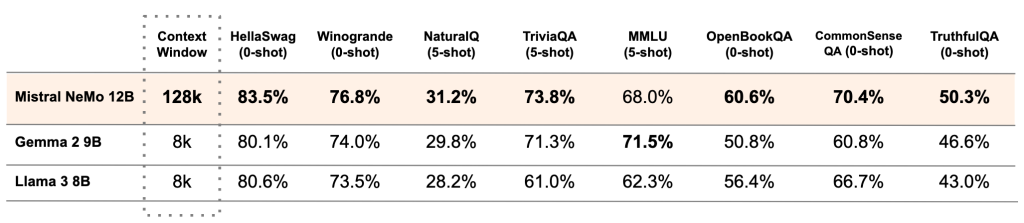

今天,Mistral NeMo正式发布,这是一个与NVIDIA合作打造的12B模型。Mistral NeMo拥有高达128k标记的大型上下文窗口,其推理能力、世界知识和编程准确性在同类规模中达到了最先进的水平。由于采用标准架构,Mistral NeMo使用起来非常方便,可以无缝替换任何使用Mistral 7B的系统。为了促进研究人员和企业的采用,预训练的基础模型和指令调优检查点都在Apache 2.0许可证下发布。Mistral NeMo通过量化感知训练,实现了在FP8推理下无性能损失。下表比较了Mistral NeMo基础模型与最近两个开源预训练模型Gemma 2 9B和Llama 3 8B的准确性

多语言模型的普及

Mistral NeMo专为全球多语言应用而设计。它经过功能调用训练,具有大上下文窗口,在英语、法语、德语、西班牙语、意大利语、葡萄牙语、中文、日语、韩语、阿拉伯语和印地语等语言上表现特别强劲。这是让前沿AI模型普及到每个人手中的重要一步,涵盖了人类文化的各种语言。

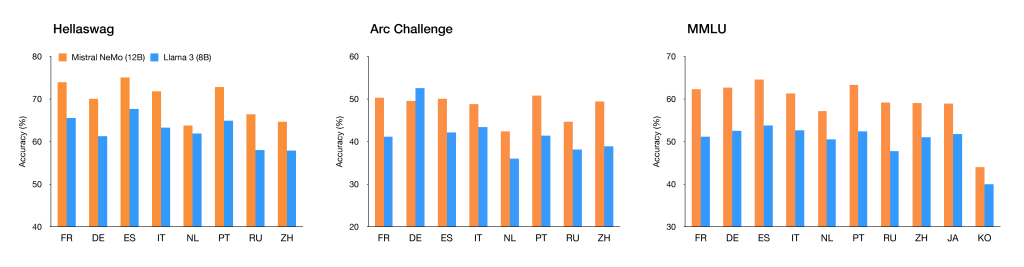

Mistral NeMo在多语言基准上的表现

图1:Mistral NeMo在多语言基准上的表现。

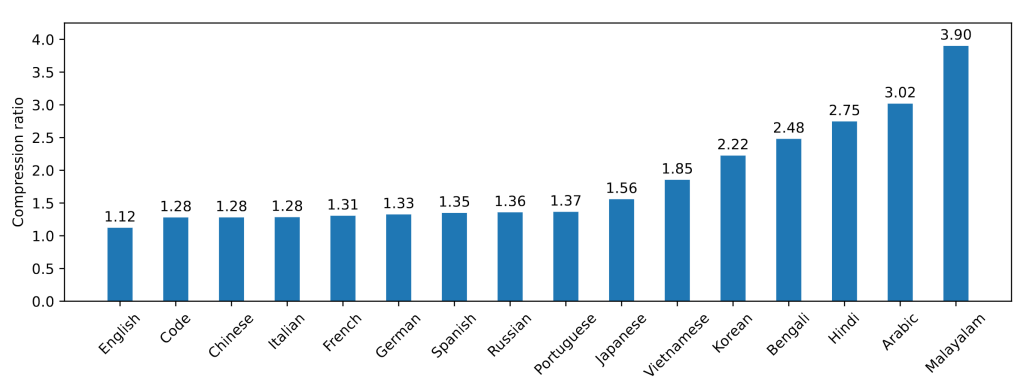

更高效的分词器——Tekken

Mistral NeMo使用了新的分词器Tekken,基于Tiktoken训练,覆盖100多种语言,比之前的Mistral模型使用的SentencePiece分词器更有效地压缩自然语言文本和源代码。特别是在压缩源代码、中文、意大利语、法语、德语、西班牙语和俄语方面,其效率提升了约30%;在压缩韩语和阿拉伯语方面,其效率分别提升了2倍和3倍。与Llama 3的分词器相比,Tekken在约85%的语言中表现更佳。

Tekken压缩率

图2:Tekken压缩率。

指令微调

Mistral NeMo经历了高级微调和对齐阶段。与Mistral 7B相比,它在遵循精确指令、推理、处理多轮对话和生成代码方面表现更佳。

Mistral NeMo指令调优模型的准确性

表2:Mistral NeMo指令调优模型的准确性。评估由GPT4o在官方参考资料上进行。

链接

基础模型 (https://huggingface.co/mistralai/Mistral-Nemo-Base-2407)和指令模型(https://huggingface.co/mistralai/Mistral-Nemo-Instruct-2407)的权重托管在HuggingFace。现在可以通过mistral-inference试用Mistral NeMo,并通过mistral-finetune进行适配。Mistral NeMo在la Plateforme上以open-mistral-nemo-2407的名称展示,还作为NVIDIA NIM推理微服务打包在容器中,可在ai.nvidia.com获取。

OpenAI GPT-4o Mini

OpenAI发布了一款面向开发者的轻量版模型——GPT-4o Mini。它的成本显著低于完整版模型,且被认为比GPT-3.5更强大。

使用OpenAI的模型构建应用程序可能会产生高昂费用,许多开发者无法负担,转而选择更便宜的模型,如Google的Gemini 1.5 Flash或Anthropic的Claude 3 Haiku。现在,OpenAI也进入了轻量模型市场。

API平台产品负责人Olivier Godement在接受《The Verge》采访时表示,“GPT-4o Mini真正体现了OpenAI让AI更广泛可及的使命。如果我们希望AI能惠及世界每个角落、每个行业、每个应用,就必须让AI更加负担得起。”

从今天起,ChatGPT的免费、Plus和团队计划用户可以使用GPT-4o Mini替代GPT-3.5 Turbo,企业用户将在下周获得访问权限。这意味着ChatGPT用户将无法再选择GPT-3.5,但开发者仍可通过API使用GPT-3.5,直到它被逐步淘汰。

Godement表示,“我认为它会非常受欢迎。”

新的轻量模型还将在API中支持文本和视觉处理,公司表示它很快将能够处理所有多模态输入和输出,包括视频和音频。这意味着未来可能会有更强大的虚拟助手,能够理解旅行行程并提供建议。然而,这款模型主要用于简单任务,所以并不能廉价地打造类似Siri的高级助手。

在测量大规模多任务语言理解(MMLU)基准考试中,GPT-4o Mini取得了82%的成绩。MMLU是一项包含57个学科大约16,000道多项选择题的考试。首次引入时,大多数模型表现不佳,目的是因为之前的基准考试已经无法考验这些模型的能力。GPT-3.5在这一测试中得分70%,GPT-4o得分88.7%,Google声称其Gemini Ultra创下了90%的最高分。相比之下,竞争对手Claude 3 Haiku和Gemini 1.5 Flash的得分分别为75.2%和78.9%。

需要注意的是,研究人员对MMLU等基准测试持谨慎态度,因为不同公司对测试的实施方式略有不同,使得模型间的得分难以直接比较。此外,AI可能会在其数据集中已有这些答案,从而“作弊”,而且通常没有第三方评估者参与。

对于渴望廉价构建AI应用的开发者来说,GPT-4o Mini的推出为他们提供了新的工具。OpenAI让金融科技初创公司Ramp测试了该模型,使用GPT-4o Mini构建了一个从收据中提取费用数据的工具。用户可以上传收据照片,模型会自动整理数据。电子邮件客户端Superhuman也测试了GPT-4o Mini,用它创建了一个电子邮件回复自动建议功能。

目标是为开发者提供轻量且廉价的工具,帮助他们创建无法用更大、更昂贵模型实现的应用。许多开发者在面对高昂的计算成本时,会选择Claude 3 Haiku或Gemini 1.5 Flash,而非支付运行最强大模型的费用。

那么,OpenAI为何花了这么长时间才推出轻量版模型?Godement表示,这是因为公司的优先事项一直是打造更大更强的模型,如GPT-4,这需要大量的“人力和计算资源”。随着时间推移,OpenAI注意到开发者越来越倾向于使用小型模型,因此决定现在是投入资源开发GPT-4o Mini的最佳时机。

Godement补充道,“我认为它会非常受欢迎。无论是已经使用OpenAI所有AI的现有应用,还是此前因价格被拒之门外的许多应用。”