AI大模型新纪元:哪四大趋势引领未来智能革命?

在人工智能热潮持续居高不下背景下,虽然全球AI大模型企业卷参数的激烈程度有所放缓,但大模型仍不断朝着万亿、十万亿参数发展,并推动多模态持续演进以通向AGI。同时,大模型也在朝向轻量化、高效化、垂直多元化发展,进而逐步形成“多点开花”的生态图谱。

一定程度上,卷参数昭示“理想”,卷应用则更重“现实”。受困于高投入和回报难等问题,一众AI大模型企业在机遇、挑战、探索、未知中,试图通过卷应用留在牌桌上,这使得更多细分、专业的大模型应用不断涌现。然而,大模型应用究竟在B端还是C端更有机会?答案众说纷纭。但可以确信的是,目前整个行业都期待着“AI超级或杀手级应用”。

若将探索大模型B、C应用视为“横轴”,聚焦AI云端、端侧应用则是“纵轴”。横纵之间,重要的趋势是AI应用正快速从云端向PC、手机等端侧“下沉”迁移。但云端、端侧大模型各有优劣、互为补充,端云协同基本被业界认同为未来大模型的主流应用模式。

Scaling Law面临放缓

自OpenAI发布1750亿参数的GPT-3以来,GPT系列模型的性能持续演进,客观验证了Scaling Law(缩放定律)的有效性。Scaling Law是指模型的性能与模型规模、数据集大小和训练用的计算量之间存在幂律关系,即模型性能会随着这些因素的指数增加而线性提高。

因此,业界仍然信奉“大力出奇迹”。摩尔线程创始人兼CEO张建中表示,作为大模型时代的牛顿定律,持续奏效的Scaling Law是引领大模型之争的暴力美学,而万卡集群已成为大模型预训练的最低标配。“只有万卡以上的智算中心才有价值,如果一个智算中心只有500P、1000P算力,要在模型加工厂里训练出一个很有竞争力的大模型难度非常高。”

在张建中看来,虽然万卡集群是千卡集群的数量增加10倍,但背后的复杂度指数级增加。其中有两个非常重要的问题,一是通讯,二是稳定性。前者在于要做到计算、存储和通信之间的平衡;后者则在于集群规模越大越不稳定,而提高稳定性还有很多方面需要改进。

阶跃星辰创始人、CEO姜大昕也称,大模型参数量将来再提高一个数量级依然成立。“目前,Scaling Law仍然奏效,模型性能在随着参数量、数据量和计算量的增加呈幂次方增长。在这一发展过程中,万亿参数量已经成为一个基本的入门门槛。”

不过,也不乏多位业内人士认为Scaling Law以及卷参数不再是AI行业的铁律或唯一解。

谈及大模型未来的演进发展,上海科学智能研究院院长、复旦大学浩清特聘教授漆远表示,“Scaling Law必然会迎来天花板时刻。”虽然就像是牛顿定律,Scaling Law能够把很多观察的数据压缩,总结出一个规律,但是真正的AGI应该是“爱因斯坦”,把语言模型和逻辑推理结合起来,而不仅仅是通过数据推导,这就好比把铁路修得再长也去不了月球。”

此外,“高效”等理念逐渐深入至大模型企业的发展。其中,面壁智能联合创始人、CEO李大海指出,高效大模型是通向AGI的更现实路径,要打造更高效的Scaling Law增长曲线,实现同等参数性能更优、同等性能参数更小的效果。面壁智能CTO曾国洋也称,一味地追求模型参数量这条路走不通,大模型效率很关键,企业需结合自身状况和优势制定发展策略。

在大模型时代中,虽然业内围绕“Scaling Law还能走多远”尚未形成共识,但几乎均认可传统的摩尔定律已失效。清华大学计算机系长聘副教授、面壁智能首席科学家刘知远指出,大模型的知识密度(知识密度=模型能力/推理算力消耗)平均每8个月将提升一倍。

多模态是AGI关键路径

近年来,在Scaling Law的显性作用下,继ChatGPT引爆生成式AI后,Sora再将文生视频模型的发展推向高潮,而多模态也被业界广泛视为大模型未来演进的关键路径。姜大昕认为,探索AGI路径,“Scaling Law”和“多模态”是相辅相成、缺一不可的两个方向。

大模型要更全面、真实地理解世界,势必需要多模态数据融合。姜大昕进一步称,“多模态是构建世界模型的基础能力,是通向AGI的必经之路。从算法角度看,世界模型的演进会分为模拟世界、探索世界、归纳世界三个阶段,而多模态是贯穿这三个阶段的基本能力。”

在多位行业人士看来,大模型行业正在从单模态走向多模态,再到全模态的演进。

腾讯集团副总裁蒋杰举例称,在文生图领域,采用DiT架构的模型融合了早前主要用于文本生成的Transformer架构,并在图像和视频生成任务中展现出了显著的优势;在文生视频领域,视频生成正朝着更高分辨率、更长时长、更精细的方向发展,一些较好的模型已经能够生成长达数分钟高清的视频。这为医疗、教育、影视等领域带来了广阔的应用想象空间。

目前,全球科技巨头、初创企业都在积极推进多模态大模型的研发。启明创投主管合伙人周志峰认为,三年内视频生成将全面爆发,结合3D能力,可控的视频生成将对影视、动画、短片的生产模式带来变革。同时,压缩更多模态信息的超级多模态大模型将出现,如文本、图像、语音、音乐、3D、传感器数据(控制信号、眼动信号、手势信息、雷达信号等)。

纵观全球,中美持续引领大模型产业的发展,而多模态大模型将成大模型竞逐的绝对高地。商汤科技研发总监卢乐炜表示,国外在多模态领域的研究较早,但中国在单点技术(如视觉和听觉识别)和产业应用方面具有优势,这为中国在多模态领域提供了与国外几乎相同的起点。他强调,“多模态对中国是一个巨大的机遇,有可能在这个领域实现快速发展。”

但与文本语言、图片模型相比,全球多模态大模型发展也面临着更多更大的挑战和桎梏。

其中,姜大昕指出,“目前,视觉的理解模型和生成模型是分开发展的,这造成的结果就是理解模型的理解能力强而生成能力弱,或者生成模型的生成能力强而理解能力弱”。他认为,多模态大模型接下来面临的一项关键挑战,就是能否将理解和生成统一在一个模型里。

此外,模态之间的语义对齐和信息融合是重要的技术难点。卢乐炜表示,“多模态大模型特别是处理视频等大规模数据时,对计算资源和存储能力提出了更高的要求。为了克服多模态之间的数据和模态鸿沟,需要设计创新的算法来实现不同模态数据的有效对齐和融合。”未来,大模型能力在多模态方面的突破,将为AI的落地应用和赋能普惠等开启更多的可能性。

整个行业期待“超级应用”

受困于高投入和回报难等问题,AI大模型企业如何落地相关应用乃至开拓出规模化应用场景早已成为业界焦点议题。行业分析称,如今,随着大模型产品和工具的完善再加上降价潮,让其可商用迈入了一个全新的阶段。同时,从通用大模型占主流到垂直领域大模型兴起,AI大模型厂商正使出浑身解数拼应用,促使更多精细、专业的大模型和应用不断涌现。

根据企业服务领域的惯性,大模型to B应用可以带来更大的行业价值和变现,但传统企业普遍不敢用、高管不想用、企业不愿为软件付费。创新工场创始人、零一万物CEO李开复表示,“短期来看大模型在中国to C的应用更有机会,但挑战在于推理成本高,在考虑产品市场匹配度时,还要考虑技术需求、技术难度和成本以及把握时间窗口等因素。”

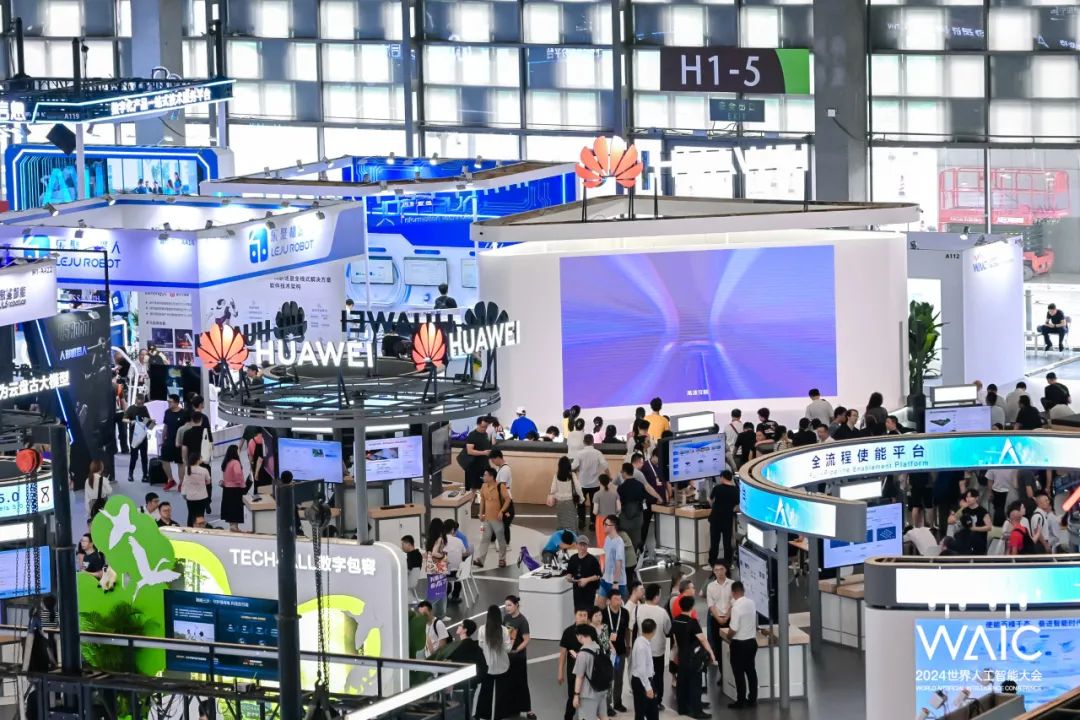

某种程度上,大模型在B端落地更难,但也不全是如此。例如过去一年时间里,在多数厂商仍处于POC阶段时,华为盘古大模型已在30多个行业、400多个场景中落地,包括从高铁巡检、气象预报到钢厂场景仿真、具身智能,再到工业互联网等各类场景。

华为常务董事、华为云CEO张平安表示,基于千行万业的业务场景和全球最大的软件创新人群,中国的AI发展道路应追求在行业领域构筑大模型的全球领先地位。如果各行各业都积极拥抱AI并开放行业应用场景,中国很有机会在2B领域构筑起全球领先优势。

但鉴于华为在B端落地的经验和势能并不具备可复制性,产业界更呼唤的是“超级应用“。

在商汤科技董事长徐立的描述中,整个人工智能行业都期待着“超级应用”。“无论是ChatGPT带来的聊天式应用,Sora带来的视频应用,都不能真正赋能垂直行业,引起广泛变化。真正的AI杀手级应用,应该能跨越理论鸿沟,进入大众市场并迎来爆发。”

至于AI“超级应用”到底是什么?业界尚无定论。不过,百度CEO李彦宏曾作过相关表述。他阐述道,“在大模型加持下,只要用人话把工作流说清楚,再配以专有知识库,即可做出一个很有价值的智能体,比互联网时代制作一个网页还简单。”未来千行百业都会依据自己的场景和特有经验、规则、数据等做出各种智能体,进而形成规模数量级的庞大生态。

然而,智能体是否能成为超级应用还有待观察。从业者呼吁,对于应用落地的短期期望不应过高,应该少一些对于发展速度的苛求,因为其中涉及技术、市场、资金和政策等多重因素。例如谷歌打造出世界第一的搜索引擎,到探索出成功的商业落地路径花了6年时间。

无论如何,为了推进商业化落地,当前各大模型厂商做出的各种技术突破以及应用场景探索等已经更有深度。而随着更多痛点问题在动态过程中解决,大模型将进一步迸发其强势潜力。

端云协同将成主流模式

在探索大模型落地应用的进程中,业内正在发生的两个重要趋势:第一个趋势是大模型正在越做越“小”。第二个趋势是,在适合端侧推理的小模型陆续出现之后,终端厂商正在积极尝试把模型装进PC、智能手机中,即现在广泛热议的“AI PC”、“AI手机”概念。

目前,凭借在成本、隐私、延时性和可靠性等方面的优势,端侧AI发展逐渐成为全球趋势。李大海表示,端侧模型具有更强的可靠性、实时性。模型部署在终端可以实时、连续地与环境进行互动,但云端模型很难保持连续性。同时,端侧模型能够更好地保证用户隐私。随着AI应用不断深入,隐私问题将变得更加严重,而本地化的端侧模型在保障数据隐私上更优。

但端侧大模型并不是所有,只是大模型生态的一块重要拼图。李大海称,“我们相信‘端’和‘云’协同在一起,才能够完整地把用户的所有需求满足好。很多和世界模型相关的请求其实仍然需要云做,不能让用户对于端侧有过高的预期,好像什么都能做而不再需要云。”

综合多位业界人士的观点,端云协同基本被认同为未来大模型的主流应用模式。

爱芯元智创始人、董事长仇肖莘表示,在AI发展从云端向端侧迁移趋势下,大模型的大规模落地需要云、边、端三级紧密结合。智慧城市和智能汽车都是非常具有代表性的应用场景。她还称,“目前端侧大模型落地依然在前期探索阶段,AI手机、AIPC和智能汽车将是第一批落地的场景,而智能驾驶之所以需要端侧大模型原因在于汽车对实时性的要求更高。”

另据《2024年中国AI大模型产业发展报告》内容指出,AI大模型成功的关键在于行业大模型、端侧、端云结合等多种模式并行。不过,端侧大模型的部署所面临的挑战和云端完全不同,需要克服能耗的限制,以及需要在足够小的参数下做到大部分日常工作等。

此外,由于端侧大模型受限较多,相关收益与损失方面还难以界定。行业人士指出,端侧大模型只能本地运行限制了其计算能力和性能表现,而大多数重要功能仍依赖云端大模型强大的处理能力和灵活性,其优势更为突出且将愈发明显。同时,大模型也在持续迭代,例如谷歌近期发布的轻量化模型Gemini 1.5 Flash,采用“蒸馏”技术使其在不同平台高效运行。

然而,高通公司中国区董事长孟樸持有不同观点。他表示,“虽然当前生成式AI的研发和应用主要集中在云端,并且云计算仍将发挥重要作用,但如果将20%的生成式AI工作负载转移到终端侧,预计到2028年将节省160亿美元的计算资源成本。”终端与云端的紧密结合,将成为推动生成式AI规模化扩展、加速数字化转型的关键所在。

“未来,要实现生成式AI在终端上的落地,将创新转化为极具实用性的应用和体验,就需要在终端侧打造高性能AI处理器,以及对生成式AI模型不断进行优化训练。”孟樸说。