大家好,我是向阳

你是否曾幻想过自己置身于动漫世界,拥有那些令人羡慕的二次元特征?随着人工智能技术的飞速发展,这一幻想已不再遥不可及。在本文中,我们将一起揭开Stable Diffusion技术的神秘面纱,探索如何利用这一技术将你的真实照片转换成充满魅力的动漫形象。我们将一步步引导你完成这个充满创意的过程。让我们一起开启这场视觉与想象的奇幻之旅吧!

前期准备

本文会使用到Tagger插件反推图片的提示词,如果还没有安装的可以使用如下方式进行安装:

点击 扩展 -> 点击 从网址安装 ->扩展的 GitHub仓库网址框输https://github.com/picobyte/stable-diffusion-webui-wd14-tagger -> 点击 安装,安装完成后重启stable diffusion。

注意:该方法需要科学上网,如无法下载,请扫描获取插件安装包文件

风格转换步骤

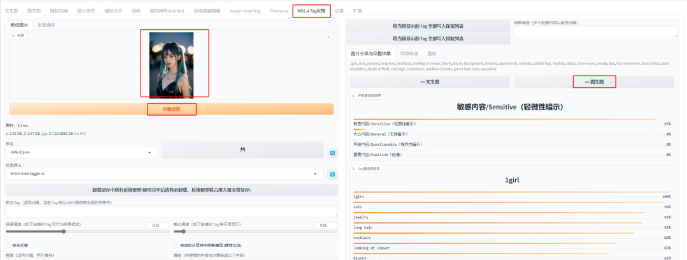

1、反推提示词

点击Tag反推标签 -> 上传图片-> 点击 开始反推->点击 图生图 发送提示词

2、选择大模型/修改提示词

大模型选择:动漫风格的模型,这里使用Anything的模型

提示词:删除反推提示词中和真实风格相关关键词,比如realistic

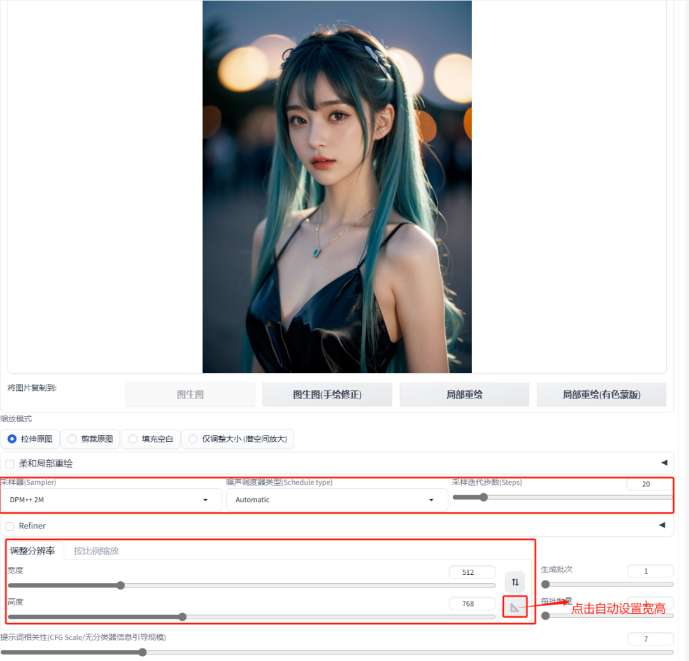

3、修改图生图参数

设置完上图所示的参数后,我们直接点击图片生成看下效果。对于重绘幅度我们通过设置X/Y/Z脚本来看不同重绘幅度下生成的效果。

从图中可以看到,随着重绘幅度的增加,图片人物姿势与原图差异越来越大,所以我们新增ControlNet的OpenPose来控制人物姿势。

4、使用ControlNet的open pose预处理器和模型

主要设置如下图所示,设置完成后,我们再次生成图片。

图片效果如下所示:

从图中可以看到,随着重绘幅度的增加,图片人物姿势与原图基本一致。但是图片的整体质量感觉还不是特别清晰,所以我们再使用一个ControlNet的Tile(分块控制)来增加图片的整体细节。

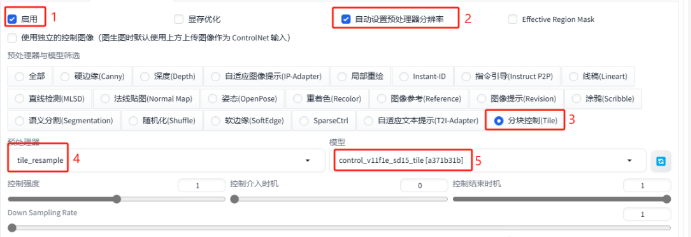

5、使用ControlNet的tile预处理器和模型

主要设置如下图所示,设置完成后,我们再次生成图片。

图片效果如下所示,整体效果看起来是可以接受的了。

最后看下转换效果对比:

到这里真人转换动漫风格基本处理完了,如果在处理过程中对于脸部细节有要求,可以使用Adetailer面部修复插件进行处理。当然,如果在具体操作过程中有任何问题可以随时沟通讨论。

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。

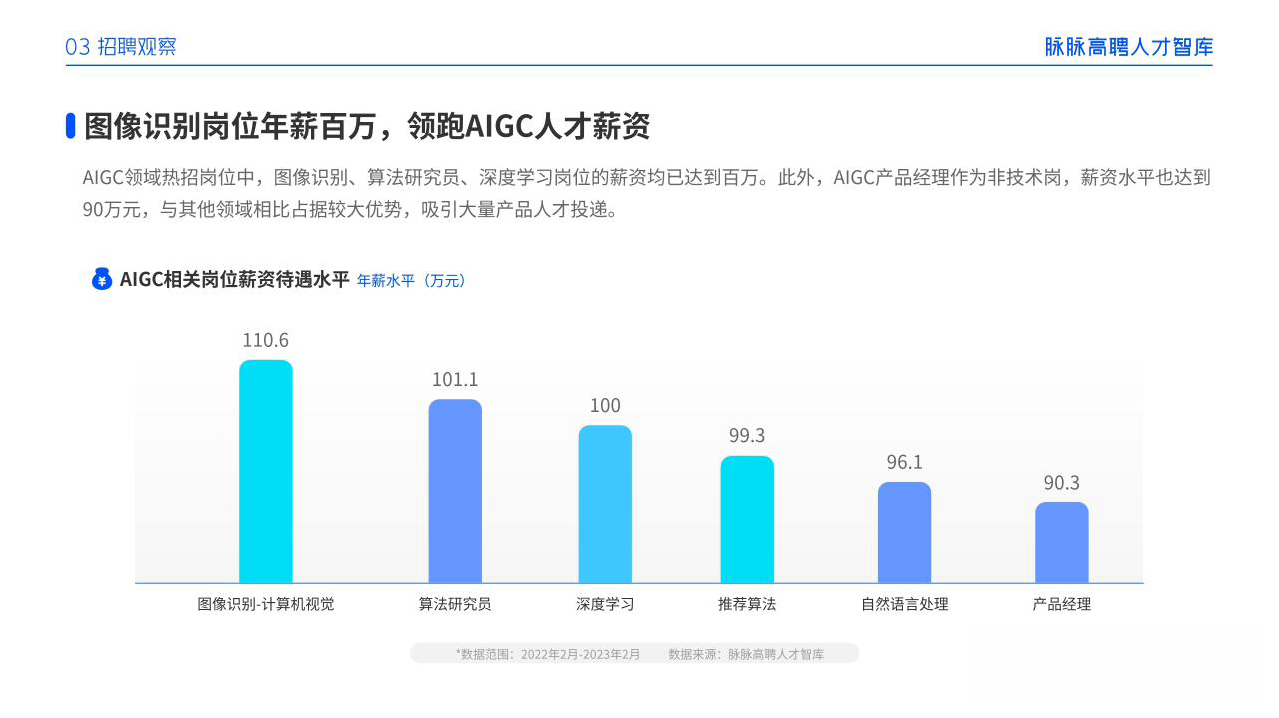

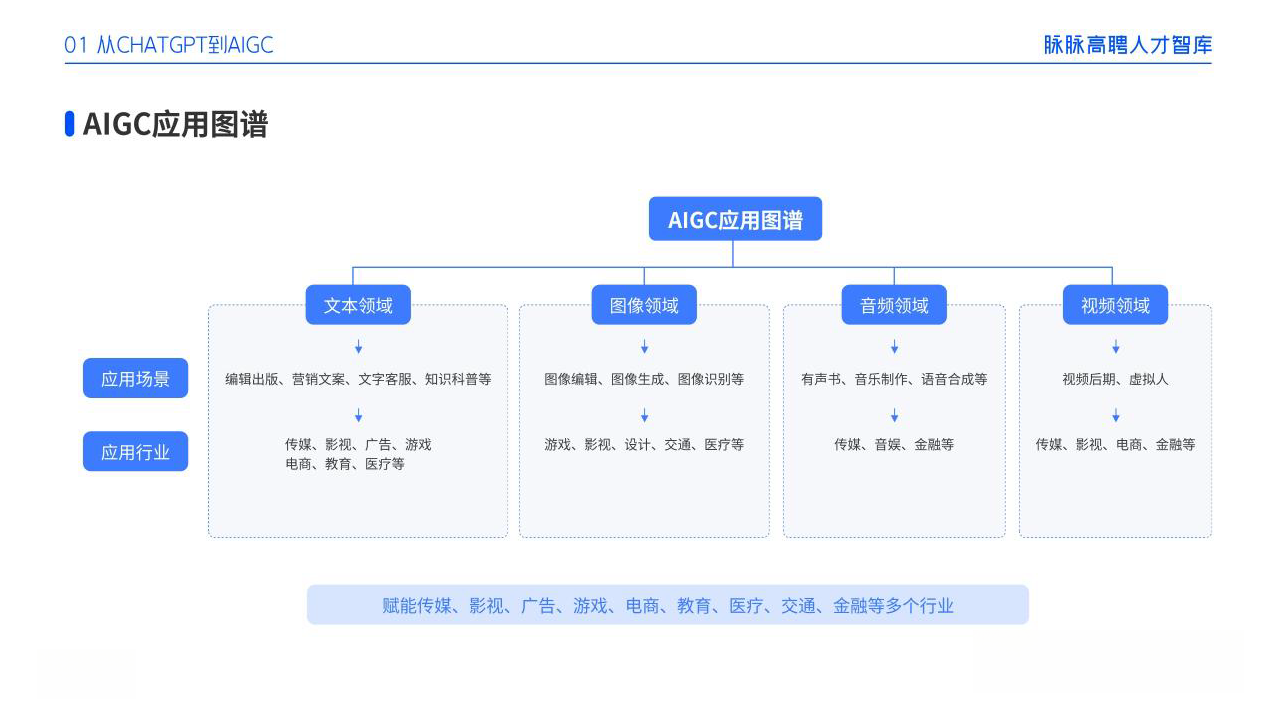

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

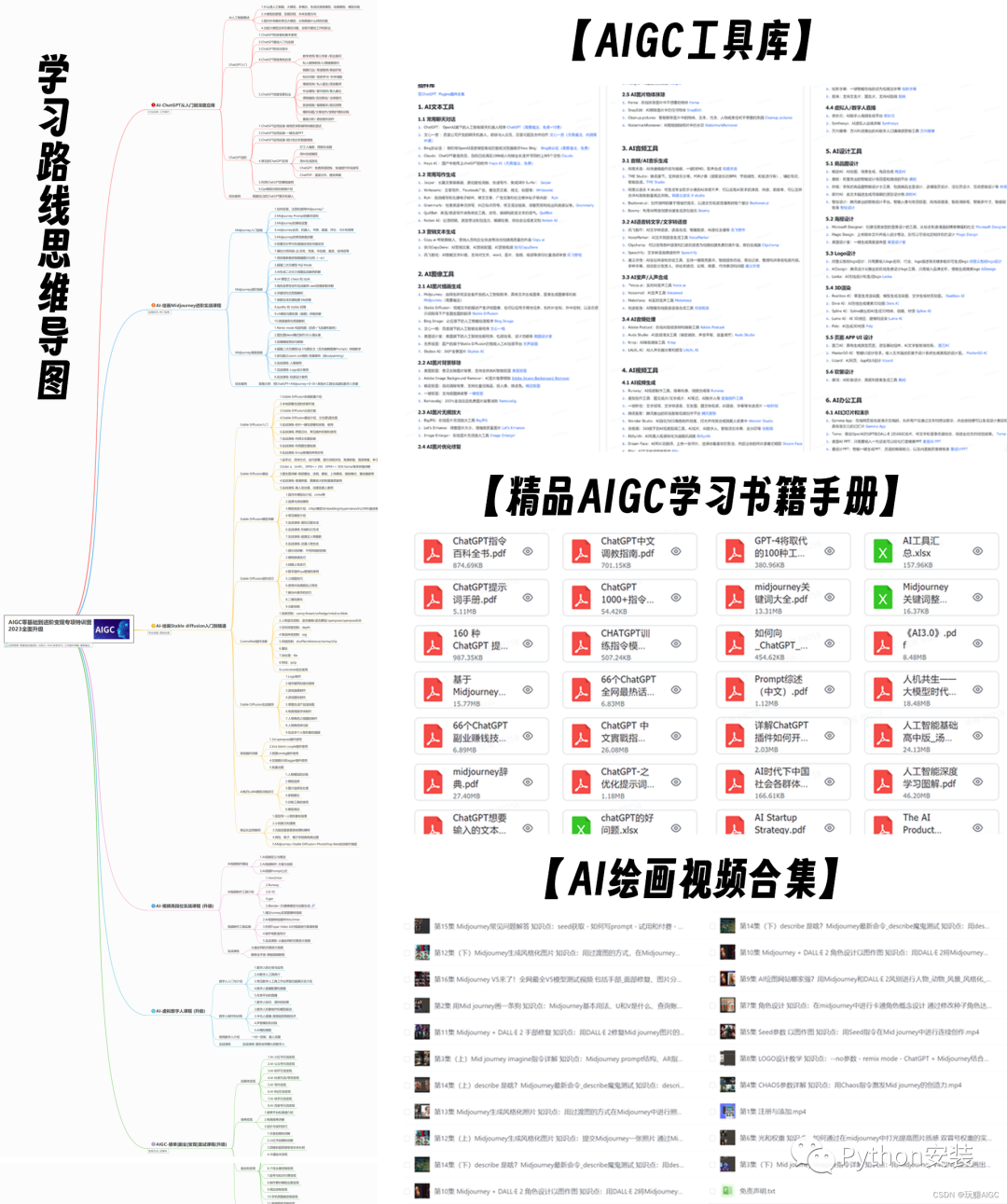

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

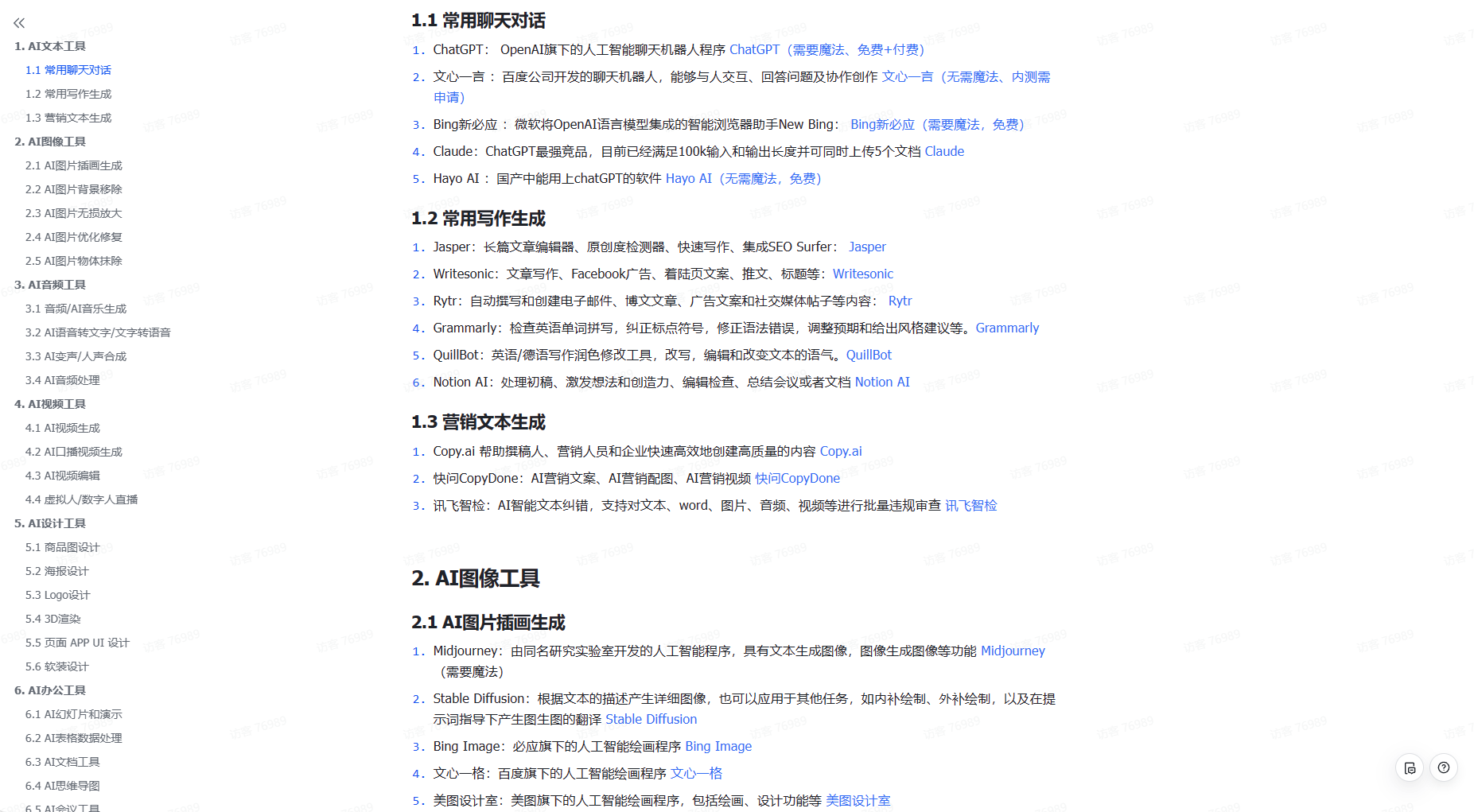

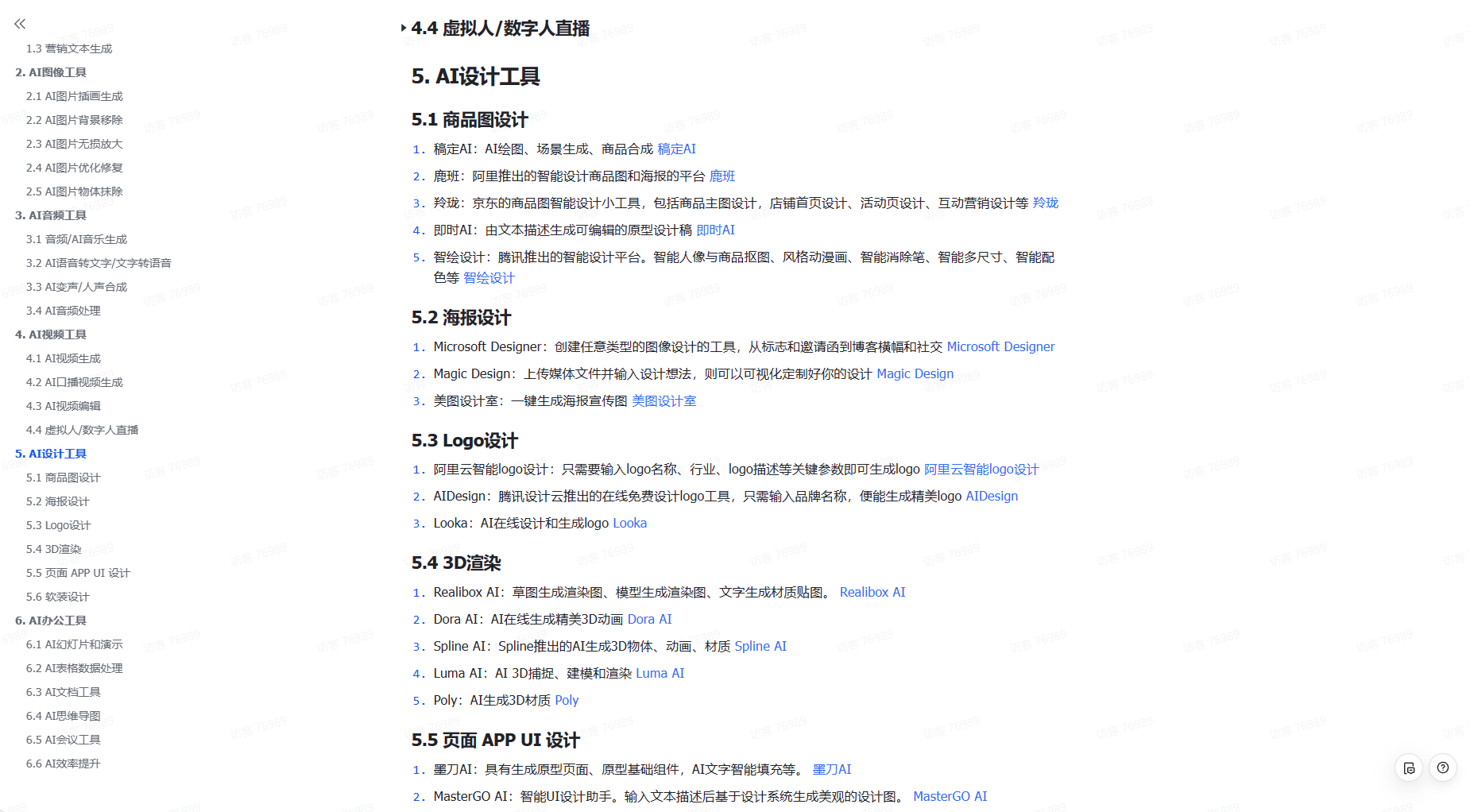

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除

若有侵权,请联系删除