【算法介绍】

基于YOLOv8的手语类型检测系统是一种创新的人机交互解决方案,该系统利用深度学习技术,特别是YOLOv8算法,实现了对手语动作的快速、准确识别。YOLOv8以其高效的性能和准确性,在实时性要求较高的手势识别领域表现出色。

该系统通过训练模型来识别图像或视频中的手语动作,并将其分类为预定义的类别。在本例中,系统能够识别的手语类型包括但不限于80种,如“additional”、“alcohol”、“allergy”、“bacon”、“bag”、“barbecue”等,涵盖了日常生活中的各种常见词汇和表达。

为了实现这一目标,系统采用了大量的手语数据集进行训练,这些数据集包含了从不同角度、光照条件和背景环境下拍摄的手语动作。通过深度学习,模型能够学习到手语的特征,并在实际应用中准确识别。

此外,该系统还具备较高的实时性,能够实时处理来自摄像头或视频流的数据,并立即给出识别结果。这使得该系统在聋哑人交流、智能家居控制、虚拟现实等领域具有广泛的应用前景。

总之,基于YOLOv8的手语类型检测系统是一种高效、准确且实时性强的手势识别解决方案,能够为用户带来更加便捷、自然的交互体验。随着技术的不断进步,这种技术有望在更多领域得到应用,为人们的生活带来更多的便利和乐趣。

【效果展示】

【操作步骤】

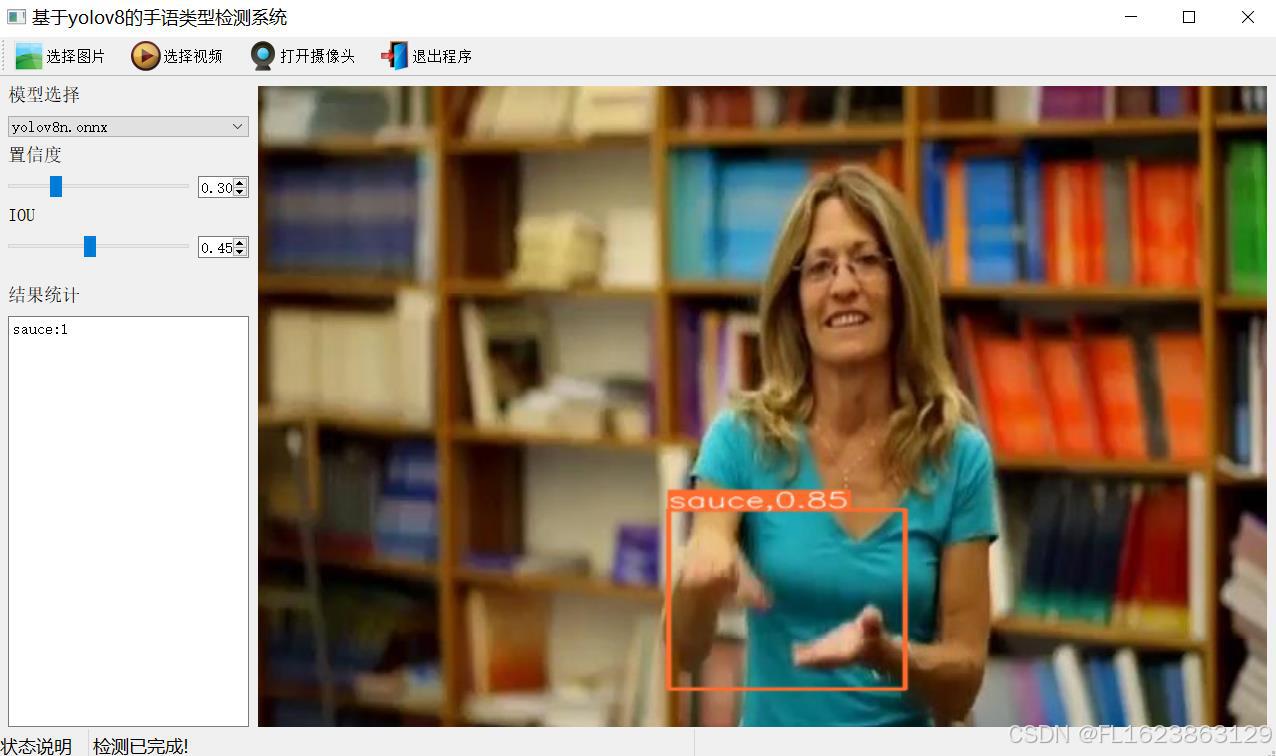

当然,以下是根据您提供的图片信息重新描述的手语识别程序的使用步骤:

手语识别程序使用步骤:

- 启动程序:

- 首先,在电脑上安装并打开手语识别程序。程序界面设计直观,功能区域划分明确,便于用户操作。

- 加载模型:

- 在程序启动时或根据需要,选择并加载YOLOv8模型(。这个模型是手语识别程序的核心,负责对手语动作进行识别。

- 设置参数:

- 在进行手语识别之前,需要设置一些关键参数,如置信度阈值和IOU(交并比)阈值。这些参数决定了程序在识别过程中对于检测到的手语动作的置信程度以及手语框与真实框的重叠程度。从图片中可以看到,置信度被设置为0.30,IOU被设置为0.45,但用户可以根据实际需求进行调整。

- 准备识别:

- 接下来,用户需要准备进行手语识别的图像或视频。这可以通过实时拍摄、上传本地图像或视频文件来实现。

- 执行识别:

- 一旦图像或视频准备好,程序将自动开始手语识别过程。在识别过程中,程序会在图像或视频上绘制出检测到的手语区域(如蓝色矩形框所示),并尝试识别出对应的手语动作。

- 查看结果:

- 识别完成后,用户可以在程序界面上的“结果”区域或类似功能区域查看识别结果。这些结果可能包括识别到的手语动作名称、置信度评分以及可能的分类标签等信息。

在实际使用过程中,请务必参考程序的官方文档或用户手册以获取准确的使用方法和注意事项。同时,由于手语识别技术的复杂性,识别结果可能受到多种因素的影响,包括光照条件、拍摄角度、手语动作的准确性和清晰度等。因此,在使用手语识别程序时,请确保在合适的条件下进行识别以获得最佳效果。

【测试环境】

windows10

anaconda3+python3.8

torch==2.3.0

ultralytics==8.3.81

【模型可以检测出80类别】

additional,alcohol,allergy,bacon,bag,barbecue,bill,biscuit,bitter,bread,burger,bye,cake,cash,cheese,chicken,coke,cold,cost,coupon,credit card,cup,dessert,drink,drive,eat,eggs,enjoy,fork,french fries,fresh,hello,hot,icecream,ingredients,juicy,ketchup,lactose,lettuce,lid,manager,menu,milk,mustard,napkin,no,order,pepper,pickle,pizza,please,ready,receipt,refill,repeat,safe,salt,sandwich,sauce,small,soda,sorry,spicy,spoon,straw,sugar,sweet,thank-you,tissues,tomato,total,urgent,vegetables,wait,warm,water,what,would,yoghurt,your

【训练信息】

| 参数 | 值 |

| 训练集图片数 | 6746 |

| 验证集图片数 | 1741 |

| 训练map | 99.0% |

| 训练精度(Precision) | 97.6% |

| 训练召回率(Recall) | 98.5% |

【验证集精度】

| 类别 | MAP50 |

| all | 99 |

| additional | 100 |

| alcohol | 100 |

| allergy | 100 |

| bacon | 100 |

| bag | 100 |

| barbecue | 100 |

| bill | 100 |

| biscuit | 100 |

| bitter | 99 |

| bread | 100 |

| burger | 100 |

| bye | 100 |

| cake | 100 |

| cash | 100 |

| cheese | 100 |

| chicken | 100 |

| coke | 100 |

| cold | 99 |

| cost | 100 |

| coupon | 100 |

| credit card | 100 |

| cup | 100 |

| dessert | 100 |

| drink | 100 |

| drive | 100 |

| eat | 100 |

| eggs | 97 |

| enjoy | 100 |

| fork | 100 |

| french fries | 90 |

| fresh | 100 |

| hello | 100 |

| hot | 97 |

| icecream | 100 |

| ingredients | 95 |

| juicy | 100 |

| ketchup | 100 |

| lactose | 100 |

| lettuce | 100 |

| lid | 100 |

| manager | 100 |

| menu | 100 |

| milk | 100 |

| mustard | 100 |

| napkin | 100 |

| no | 100 |

| order | 100 |

| pepper | 100 |

| pickle | 88 |

| pizza | 100 |

| please | 100 |

| ready | 100 |

| receipt | 100 |

| refill | 100 |

| repeat | 100 |

| safe | 100 |

| salt | 100 |

| sandwich | 100 |

| sauce | 97 |

| small | 100 |

| soda | 100 |

| sorry | 100 |

| spicy | 100 |

| spoon | 100 |

| straw | 97 |

| sugar | 100 |

| sweet | 100 |

| thank-you | 100 |

| tissues | 100 |

| tomato | 100 |

| total | 100 |

| urgent | 100 |

| vegetables | 100 |

| wait | 100 |

| warm | 95 |

| water | 100 |

| what | 100 |

| would | 100 |

| yoghurt | 100 |

| your | 100 |

【部分实现源码】

class Ui_MainWindow(QtWidgets.QMainWindow):

signal = QtCore.pyqtSignal(str, str)

def setupUi(self):

self.setObjectName("MainWindow")

self.resize(1280, 728)

self.centralwidget = QtWidgets.QWidget(self)

self.centralwidget.setObjectName("centralwidget")

self.weights_dir = './weights'

self.picture = QtWidgets.QLabel(self.centralwidget)

self.picture.setGeometry(QtCore.QRect(260, 10, 1010, 630))

self.picture.setStyleSheet("background:black")

self.picture.setObjectName("picture")

self.picture.setScaledContents(True)

self.label_2 = QtWidgets.QLabel(self.centralwidget)

self.label_2.setGeometry(QtCore.QRect(10, 10, 81, 21))

self.label_2.setObjectName("label_2")

self.cb_weights = QtWidgets.QComboBox(self.centralwidget)

self.cb_weights.setGeometry(QtCore.QRect(10, 40, 241, 21))

self.cb_weights.setObjectName("cb_weights")

self.cb_weights.currentIndexChanged.connect(self.cb_weights_changed)

self.label_3 = QtWidgets.QLabel(self.centralwidget)

self.label_3.setGeometry(QtCore.QRect(10, 70, 72, 21))

self.label_3.setObjectName("label_3")

self.hs_conf = QtWidgets.QSlider(self.centralwidget)

self.hs_conf.setGeometry(QtCore.QRect(10, 100, 181, 22))

self.hs_conf.setProperty("value", 25)

self.hs_conf.setOrientation(QtCore.Qt.Horizontal)

self.hs_conf.setObjectName("hs_conf")

self.hs_conf.valueChanged.connect(self.conf_change)

self.dsb_conf = QtWidgets.QDoubleSpinBox(self.centralwidget)

self.dsb_conf.setGeometry(QtCore.QRect(200, 100, 51, 22))

self.dsb_conf.setMaximum(1.0)

self.dsb_conf.setSingleStep(0.01)

self.dsb_conf.setProperty("value", 0.25)

self.dsb_conf.setObjectName("dsb_conf")

self.dsb_conf.valueChanged.connect(self.dsb_conf_change)

self.dsb_iou = QtWidgets.QDoubleSpinBox(self.centralwidget)

self.dsb_iou.setGeometry(QtCore.QRect(200, 160, 51, 22))

self.dsb_iou.setMaximum(1.0)

self.dsb_iou.setSingleStep(0.01)

self.dsb_iou.setProperty("value", 0.45)

self.dsb_iou.setObjectName("dsb_iou")

self.dsb_iou.valueChanged.connect(self.dsb_iou_change)

self.hs_iou = QtWidgets.QSlider(self.centralwidget)

self.hs_iou.setGeometry(QtCore.QRect(10, 160, 181, 22))

self.hs_iou.setProperty("value", 45)

self.hs_iou.setOrientation(QtCore.Qt.Horizontal)

self.hs_iou.setObjectName("hs_iou")

self.hs_iou.valueChanged.connect(self.iou_change)

self.label_4 = QtWidgets.QLabel(self.centralwidget)

self.label_4.setGeometry(QtCore.QRect(10, 130, 72, 21))

self.label_4.setObjectName("label_4")

self.label_5 = QtWidgets.QLabel(self.centralwidget)

self.label_5.setGeometry(QtCore.QRect(10, 210, 72, 21))

self.label_5.setObjectName("label_5")

self.le_res = QtWidgets.QTextEdit(self.centralwidget)

self.le_res.setGeometry(QtCore.QRect(10, 240, 241, 400))

self.le_res.setObjectName("le_res")

self.setCentralWidget(self.centralwidget)

self.menubar = QtWidgets.QMenuBar(self)

self.menubar.setGeometry(QtCore.QRect(0, 0, 1110, 30))

self.menubar.setObjectName("menubar")

self.setMenuBar(self.menubar)

self.statusbar = QtWidgets.QStatusBar(self)

self.statusbar.setObjectName("statusbar")

self.setStatusBar(self.statusbar)

self.toolBar = QtWidgets.QToolBar(self)

self.toolBar.setToolButtonStyle(QtCore.Qt.ToolButtonTextBesideIcon)

self.toolBar.setObjectName("toolBar")

self.addToolBar(QtCore.Qt.TopToolBarArea, self.toolBar)

self.actionopenpic = QtWidgets.QAction(self)

icon = QtGui.QIcon()

icon.addPixmap(QtGui.QPixmap(":/images/1.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.actionopenpic.setIcon(icon)

self.actionopenpic.setObjectName("actionopenpic")

self.actionopenpic.triggered.connect(self.open_image)

self.action = QtWidgets.QAction(self)

icon1 = QtGui.QIcon()

icon1.addPixmap(QtGui.QPixmap(":/images/2.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.action.setIcon(icon1)

self.action.setObjectName("action")

self.action.triggered.connect(self.open_video)

self.action_2 = QtWidgets.QAction(self)

icon2 = QtGui.QIcon()

icon2.addPixmap(QtGui.QPixmap(":/images/3.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.action_2.setIcon(icon2)

self.action_2.setObjectName("action_2")

self.action_2.triggered.connect(self.open_camera)

self.actionexit = QtWidgets.QAction(self)

icon3 = QtGui.QIcon()

icon3.addPixmap(QtGui.QPixmap(":/images/4.png"), QtGui.QIcon.Normal, QtGui.QIcon.Off)

self.actionexit.setIcon(icon3)

self.actionexit.setObjectName("actionexit")

self.actionexit.triggered.connect(self.exit)

self.toolBar.addAction(self.actionopenpic)

self.toolBar.addAction(self.action)

self.toolBar.addAction(self.action_2)

self.toolBar.addAction(self.actionexit)

self.retranslateUi()

QtCore.QMetaObject.connectSlotsByName(self)

self.init_all()【使用步骤】

使用步骤:

(1)首先根据官方框架安装好yolov8环境,并安装好pyqt5

(2)切换到自己安装的yolov8环境后,并切换到源码目录,执行python main.py即可运行启动界面,进行相应的操作即可

【提供文件】

python源码

yolov8n.onnx模型(不提供pytorch模型)

训练的map,P,R曲线图(在weights\results.png)

测试图片(在test_img文件夹下面)

注意不提供数据集

【常用评估参数介绍】

在目标检测任务中,评估模型的性能是至关重要的。你提到的几个术语是评估模型性能的常用指标。下面是对这些术语的详细解释:

- Class:

- 这通常指的是模型被设计用来检测的目标类别。例如,一个模型可能被训练来检测车辆、行人或动物等不同类别的对象。

- Images:

- 表示验证集中的图片数量。验证集是用来评估模型性能的数据集,与训练集分开,以确保评估结果的公正性。

- Instances:

- 在所有图片中目标对象的总数。这包括了所有类别对象的总和,例如,如果验证集包含100张图片,每张图片平均有5个目标对象,则Instances为500。

- P(精确度Precision):

- 精确度是模型预测为正样本的实例中,真正为正样本的比例。计算公式为:Precision = TP / (TP + FP),其中TP表示真正例(True Positives),FP表示假正例(False Positives)。

- R(召回率Recall):

- 召回率是所有真正的正样本中被模型正确预测为正样本的比例。计算公式为:Recall = TP / (TP + FN),其中FN表示假负例(False Negatives)。

- mAP50:

- 表示在IoU(交并比)阈值为0.5时的平均精度(mean Average Precision)。IoU是衡量预测框和真实框重叠程度的指标。mAP是一个综合指标,考虑了精确度和召回率,用于评估模型在不同召回率水平上的性能。在IoU=0.5时,如果预测框与真实框的重叠程度达到或超过50%,则认为该预测是正确的。

- mAP50-95:

- 表示在IoU从0.5到0.95(间隔0.05)的范围内,模型的平均精度。这是一个更严格的评估标准,要求预测框与真实框的重叠程度更高。在目标检测任务中,更高的IoU阈值意味着模型需要更准确地定位目标对象。mAP50-95的计算考虑了从宽松到严格的多个IoU阈值,因此能够更全面地评估模型的性能。

这些指标共同构成了评估目标检测模型性能的重要框架。通过比较不同模型在这些指标上的表现,可以判断哪个模型在实际应用中可能更有效。

【常见问题】

目标检测训练中,Mean Average Precision(MAP)偏低可能有以下原因:

原因一:欠拟合:如果训练数据量过小,模型可能无法学习到足够的特征,从而影响预测效果,导致欠拟合,进而使MAP偏低。因此可以加大数据集数量

原因二:小目标:如果数据集包含大部分小目标则一般会有可能产生map偏低情况,因为小目标特征不明显,模型很难学到特征。

原因三:模型调参不对:比如学习率调整过大可能会导致学习能力过快,模型参数调节出现紊乱

原因四:过拟合(现在模型基本不存在这种情况):如果模型在训练数据上表现非常好,但在验证或测试数据上表现较差,可能是出现了过拟合。这通常是因为模型参数过多,而训练数据量相对较小,导致模型学习到了训练数据中的噪声或特定模式,而无法泛化到新的数据。如今现在目标检测模型都对这个情况做的很好,很少有这种情况发生。

原因五:场景不一样:验证集验证精度高,测试集不行,则有可能是与训练模型场景图片不一致导致测试map过低

针对以上原因,可以采取以下措施来提高MAP:

(1)优化模型结构:根据任务和数据集的特点选择合适的模型,并尝试使用不同的网络架构和构件来改进模型性能。

(2)增强数据预处理:对数据进行适当的预处理和增强,如数据归一化、缺失值填充、数据扩增等,以提高模型的泛化能力。

(3)调整损失函数:尝试使用不同的损失函数或组合多种损失函数来优化模型性能。

(4)优化训练策略:调整学习率、批次大小、训练轮数等超参数,以及使用学习率衰减、动量等优化算法来改善模型训练效果。

(5)使用预训练模型:利用在大规模数据集上预训练的模型进行迁移学习,可以加速模型收敛并提高性能。

(6)增加数据集数量,尽可能提供多场景图片,提高模型泛化能力,增强模型特征学习能力。

综上所述,提高目标检测训练的MAP需要从多个方面入手,包括优化模型结构、增强数据预处理、调整损失函数、优化训练策略以及使用预训练模型等。