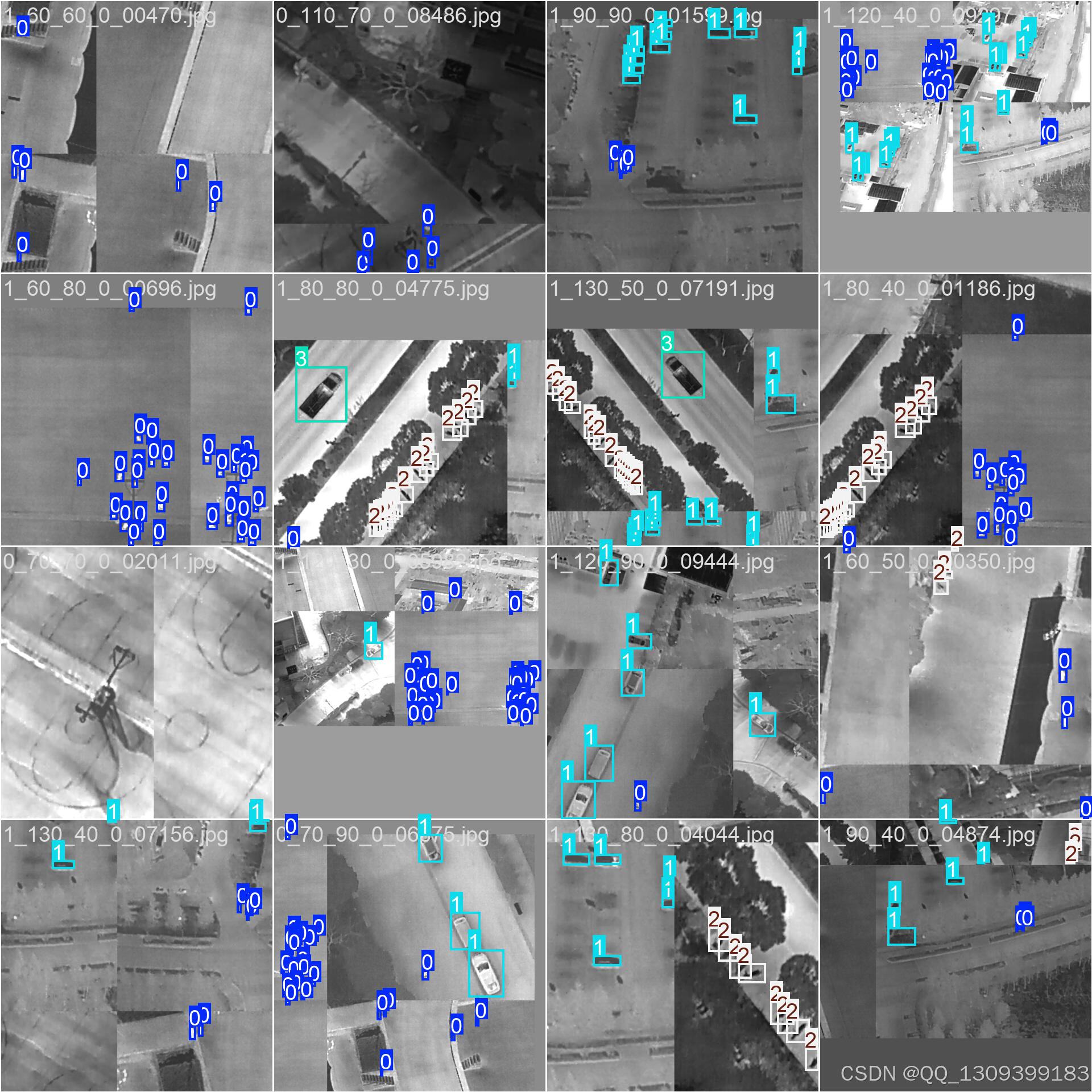

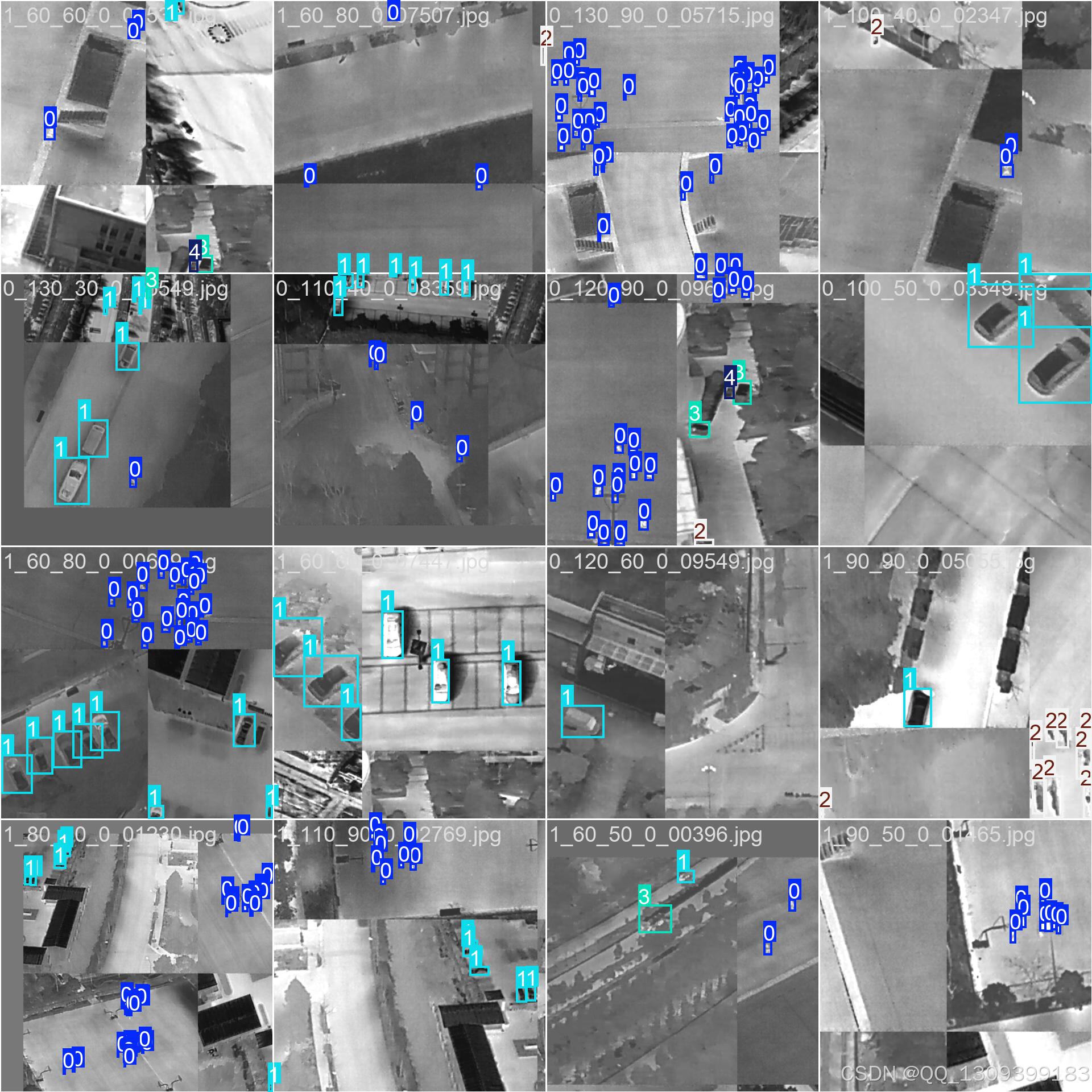

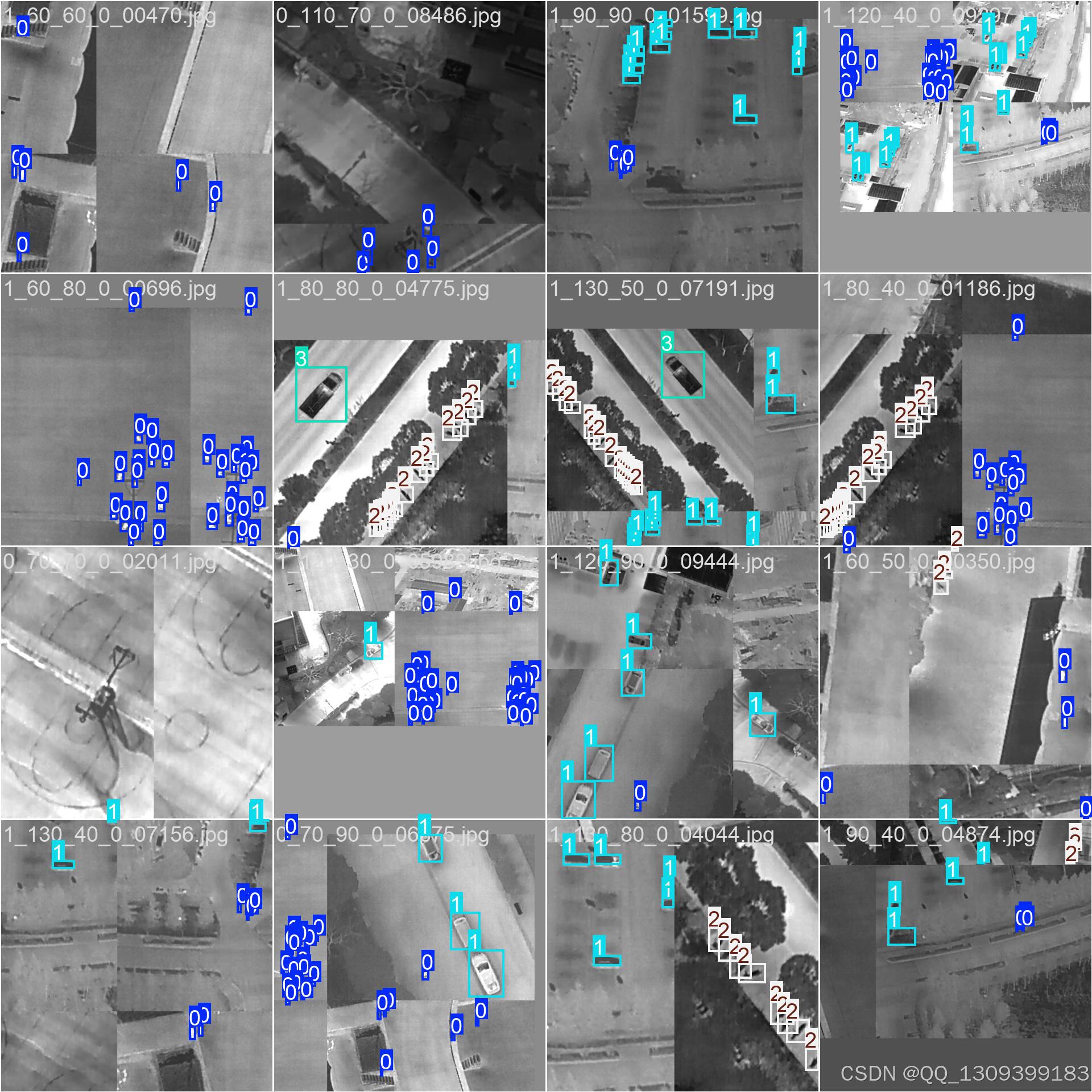

YOLOv11 红外小目标检测与红外无人机视角行人/车辆检测流程

一、引言

随着深度学习技术的发展,YOLO(You Only Look Once)系列算法因其快速的检测速度和较高的准确性而广泛应用于目标检测任务中。本文将详细介绍如何使用YOLOv11进行红外图像中的小目标检测,特别是针对无人机视角下的行人和车辆检测任务。我们将从原理介绍到格式转换,再到训练模型,最后部署到实际应用,提供一个完整的解决方案。

二、YOLOv11 原理概述

2.1 模型架构

YOLOv11是YOLO系列的一个假设版本,它在保持原有高效性的同时,可能引入了新的改进点如更深层次的网络结构、优化后的特征提取器(例如CSPDarknet53)、多尺度预测机制等。这些改进有助于提高对复杂背景或低对比度场景(如红外图像)中小目标的检测能力。

2.2 工作流程

- 输入:接收一张或多张图片作为输入。

- 骨干网(Backbone):通过一系列卷积层提取图像特征。

- 颈部(Neck):通常包括FPN(Feature Pyramid Network)或其他形式的空间金字塔池化,用于融合不同层次的特征图。

- 头部(Head):负责最终的边界框回归和分类任务,输出每个候选区域的概率分布及坐标信息。

- 后处理:利用非极大值抑制(Non-Maximum Suppression, NMS)去除冗余检测结果,保留最有可能的目标。

三、数据准备与格式转化

3.1 数据收集

为了确保模型能够有效地识别红外图像中的行人和车辆,需要收集足够数量且多样化的红外图像数据集。可以从公开的数据源获取,也可以自行采集符合特定应用场景的数据。

3.2 标注工具选择

使用专业的标注工具(如LabelImg、CVAT等)为图像添加边界框标签,并指定类别(行人、车辆)。对于红外图像而言,由于其特殊性质,可能还需要特别注意标注精度和一致性。

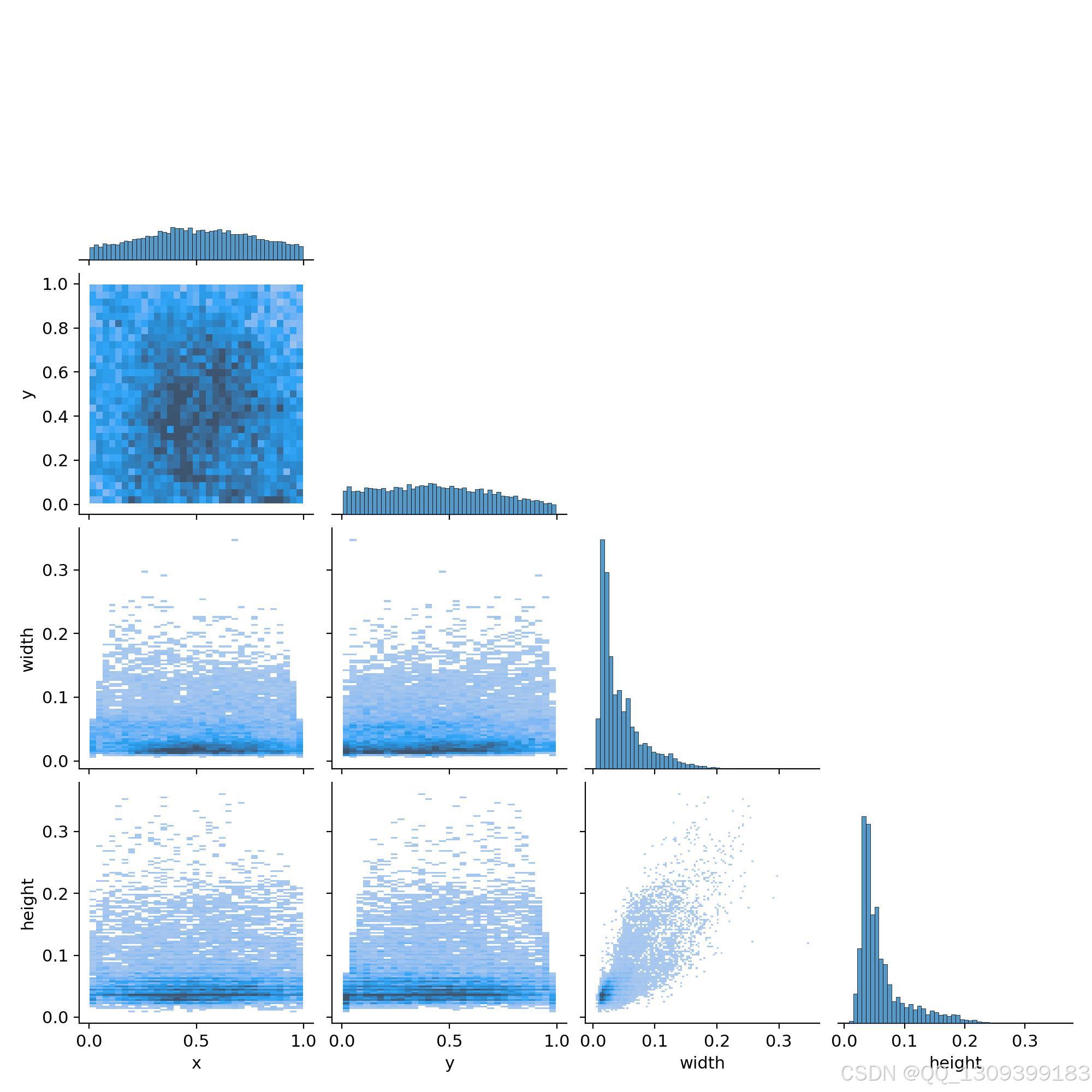

3.3 数据集划分

将标注好的数据集按照一定比例划分为训练集、验证集和测试集。一般推荐的比例为70%训练、15%验证、15%测试。

3.4 格式转化

YOLOv11要求输入的数据格式通常是.txt文件,每行包含一个对象的信息,格式如下:

<class_id> <x_center> <y_center> <width> <height>

其中,<class_id>是从0开始的整数编号;其余四个参数是以归一化的方式表示边界框的位置和大小(相对于整个图像宽度和高度)。因此,需要编写脚本来读取原始的XML或其他格式的标注文件,并将其转换为上述格式。

0 0.3171875 0.5673828125 0.0125 0.052734375

0 0.3859375 0.615234375 0.0125 0.0390625

0 0.5734375 0.4287109375 0.0125 0.044921875

0 0.584375 0.4775390625 0.0125 0.041015625

0 0.609375 0.470703125 0.0125 0.04296875

0 0.6171875 0.4072265625 0.009375 0.041015625

0 0.63671875 0.4501953125 0.0171875 0.056640625

4 0.46171875 0.6357421875 0.0671875 0.080078125

0 0.70859375 0.4873046875 0.0140625 0.048828125

0 0.690625 0.5263671875 0.0125 0.041015625

四、模型训练

4.1 环境搭建

安装必要的依赖库(如PyTorch、CUDA等),并配置好YOLOv11的开发环境。可以参考官方文档或社区资源来完成这一步骤。

4.2 配置文件调整

根据自己的硬件条件和数据特点修改YOLOv11的配置文件(.cfg),包括但不限于输入尺寸、批量大小、学习率等超参数设置。

4.3 开始训练

使用预训练权重初始化网络,然后加载自己准备的数据集进行finetune。训练过程中要密切关注损失函数的变化趋势以及验证集上的性能指标,及时调整策略以获得更好的效果。

五、模型评估与优化

5.1 性能评估

在测试集上评估模型的表现,计算常用的评价指标如mAP(mean Average Precision)、Precision、Recall等。同时,也可以通过可视化的方式检查一些具体的检测结果,以便发现问题所在。

5.2 结果分析与优化

如果发现某些类型的误检或漏检较多,则考虑增加相关类别的样本量或者尝试不同的数据增强方法。此外,还可以探索其他高级技巧如迁移学习、知识蒸馏等来进一步提升模型性能。

六、部署实施

6.1 模型导出

训练完成后,将模型导出为适用于目标平台的格式(如ONNX、TensorRT等),以便后续集成到应用程序中。

6.2 应用集成

根据实际需求选择合适的编程语言和技术栈实现模型的调用接口。对于无人机系统来说,可能涉及到嵌入式设备上的实时推理,这时就需要考虑资源限制并优化推理效率。

6.3 测试与反馈

最后,在真实的环境中进行全面测试,收集用户反馈并持续改进系统。特别是在无人机视角下,还需关注飞行稳定性、拍摄角度等因素对检测结果的影响。

七、总结

通过以上步骤,我们可以构建一个基于YOLOv11的红外小目标检测系统,专门用于红外无人机视角下的行人和车辆检测。尽管这里提到的是YOLOv11,但很多原则和方法同样适用于其他版本的YOLO或其他类似的目标检测框架。希望这份指南能够帮助读者顺利完成从理论到实践的过渡,打造出高性能的目标检测解决方案。