引言

序列标注任务是自然语言处理(NLP)中的核心任务之一,广泛应用于信息抽取、文本分类、机器翻译等领域。随着深度学习技术的快速发展,序列标注任务的性能得到了显著提升。本文将从基础概念入手,逐步深入探讨序列标注任务的原理、方法及其在实际应用中的表现。通过本文,读者将能够全面理解序列标注任务的技术细节,并掌握如何在实际项目中应用这些技术。

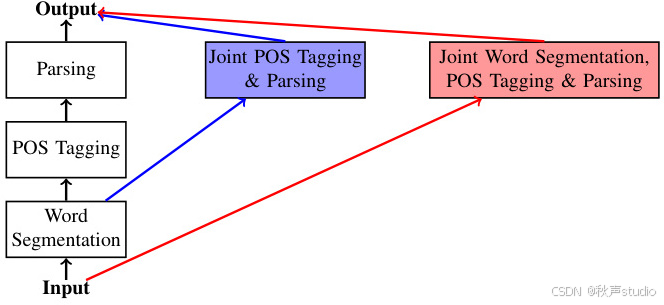

一、序列标注任务概述

1.1 什么是序列标注任务?

序列标注任务的目标是为输入序列中的每个元素分配一个对应的标签。这些标签可以是词性、命名实体、语义角色等。例如,在命名实体识别(NER)任务中,模型需要为句子中的每个单词分配一个标签,如“人名”、“地名”或“组织机构名”。

1.2 序列标注任务的应用场景

序列标注任务在自然语言处理中有着广泛的应用,主要包括:

-

命名实体识别(NER):从文本中识别出具有特定意义的实体,如人名、地名、组织名等。

-

词性标注(POS Tagging):为文本中的每个单词赋予准确的词性标签,如名词、动词、形容词等。

-

语义角色标注(SRL):识别句子中谓词与各个论元之间的语义关系。

-

分块(Chunking):将文本划分为具有特定语法功能的短语块,如名词短语、动词短语等。

二、传统序列标注方法

2.1 隐马尔可夫模型(HMM)

隐马尔可夫模型(HMM)是一种基于概率统计的生成模型,广泛应用于序列标注任务。HMM的核心假设是当前状态仅依赖于前一状态,而与更早的状态无关。

2.1.1 HMM的数学原理

HMM由以下三个部分组成:

- 状态转移概率矩阵:描述从一个状态转移到另一个状态的概率。

- 观测概率矩阵:描述在某个状态下生成某个观测值的概率。

- 初始状态概率向量:描述初始状态的概率分布。

HMM的数学公式如下:

P ( O ∣ λ ) = ∑ Q P ( O ∣ Q , λ ) P ( Q ∣ λ ) P(O|λ) = \sum_{Q} P(O|Q, λ)P(Q|λ) P(O∣λ)=Q∑P(O∣Q,λ)P(Q∣λ)

其中, O O O 是观测序列, Q Q Q 是状态序列, λ λ λ 是模型参数。

2.1.2 HMM的局限性

尽管HMM在序列标注任务中表现出色,但它也存在一些局限性:

- 独立性假设:HMM假设观测数据之间相互独立,忽略了单词之间的依赖关系。

- 局部最优解:HMM容易陷入局部最优解,难以捕捉数据中的复杂模式。

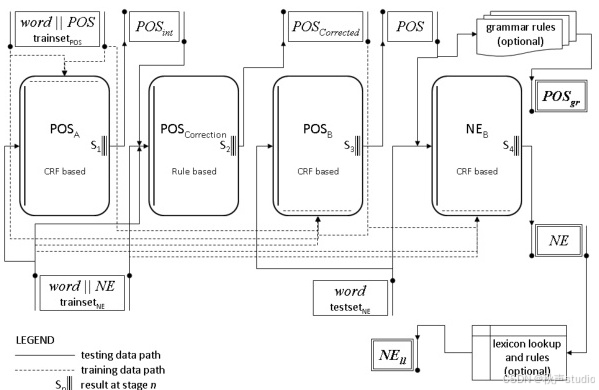

2.2 条件随机场(CRF)

条件随机场(CRF)是一种判别式概率图模型,能够有效克服HMM的局限性。CRF直接对条件概率 P ( Y ∣ X ) P(Y|X) P(Y∣X) 进行建模,能够捕捉标签之间的依赖关系。

2.2.1 CRF的数学原理

CRF的数学公式如下:

P ( Y ∣ X ) = 1 Z ( X ) exp ( ∑ i = 1 n ∑ k = 1 m λ k f k ( y i − 1 , y i , x i ) ) P(Y|X) = \frac{1}{Z(X)} \exp \left( \sum_{i=1}^{n} \sum_{k=1}^{m} λ_k f_k(y_{i-1}, y_i, x_i) \right) P(Y∣X)=Z(X)1exp(i=1∑nk=1∑mλkfk(yi−1,yi,xi))

其中, Z ( X ) Z(X) Z(X) 是归一化因子, f k f_k fk 是特征函数, λ k λ_k λk 是特征函数的权重。

2.2.2 CRF的优势

- 全局信息建模:CRF能够考虑整个序列的全局信息,避免标记偏置问题。

- 丰富的特征函数:CRF可以灵活地引入各种特征函数,捕捉单词的词性、词形、上下文词等信息。

三、深度学习序列标注方法

3.1 BiLSTM-CRF模型

BiLSTM-CRF模型结合了双向长短期记忆网络(BiLSTM)和条件随机场(CRF)的优势,在序列标注任务中表现出色。

3.1.1 BiLSTM的优势

- 双向处理:BiLSTM通过前向和后向两个方向的LSTM网络同时处理输入序列,全面捕捉上下文信息。

- 长距离依赖处理:BiLSTM通过门控机制(输入门、遗忘门、输出门)控制信息流动和记忆,有效解决传统RNN在处理长距离依赖关系时的局限性。

3.1.2 CRF的作用

在BiLSTM-CRF模型中,CRF优化了标签依赖关系。虽然BiLSTM能够提取丰富的序列特征,但在预测标签序列时,缺乏对标签之间全局依赖关系的考虑。CRF通过构建无向图结构,对整个标签序列的联合概率进行建模,在预测标签时综合考虑全局信息,避免出现不合理的标签组合。

3.1.3 BiLSTM-CRF代码示例

以下是一个简单的BiLSTM-CRF模型的PyTorch实现:

import torch

import torch.nn as nn

import torch.optim as optim

class BiLSTM_CRF(nn.Module):

def __init__(self, vocab_size, tag_to_ix, embedding_dim, hidden_dim):

super(BiLSTM_CRF, self).__init__()

self.embedding_dim = embedding_dim

self.hidden_dim = hidden_dim

self.vocab_size = vocab_size

self.tag_to_ix = tag_to_ix

self.tagset_size = len(tag_to_ix)

self.word_embeds = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, hidden_dim // 2,

num_layers=1, bidirectional=True)

self.hidden2tag = nn.Linear(hidden_dim, self.tagset_size)

self.crf = CRF(self.tagset_size)

def forward(self, sentence):

embeds = self.word_embeds(sentence)

lstm_out, _ = self.lstm(embeds.view(len(sentence), 1, -1))

lstm_out = lstm_out.view(len(sentence), self.hidden_dim)

lstm_feats = self.hidden2tag(lstm_out)

return lstm_feats

# CRF层的实现略,可以参考开源库如torchcrf

3.2 基于注意力机制的模型

基于注意力机制的模型在序列标注任务中展现出强大潜力,为提升模型性能提供新思路。

3.2.1 注意力机制的工作原理

注意力机制通过计算查询(Query)、键(Key)和值(Value)之间的相关性,动态关注序列中的重要信息。其数学公式如下:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax} \left( \frac{QK^T}{\sqrt{d_k}} \right) V Attention(Q,K,V)=softmax(dkQKT)V

其中, d k d_k dk 是键的维度。

3.2.2 注意力机制的优势

- 动态关注关键信息:注意力机制使模型能够自动关注到与当前任务最相关的信息,抑制无关信息的干扰。

- 长距离依赖处理:注意力机制能帮助模型更好地处理长距离依赖关系,直接关注到与当前位置相关的关键信息。

3.2.3 注意力机制代码示例

以下是一个简单的注意力机制的PyTorch实现:

import torch

import torch.nn as nn

import torch.nn.functional as F

class Attention(nn.Module):

def __init__(self, hidden_dim):

super(Attention, self).__init__()

self.hidden_dim = hidden_dim

self.attn = nn.Linear(hidden_dim * 2, hidden_dim)

self.v = nn.Parameter(torch.rand(hidden_dim))

def forward(self, hidden, encoder_outputs):

max_len = encoder_outputs.size(0)

h = hidden.repeat(max_len, 1, 1).transpose(0, 1)

energy = torch.tanh(self.attn(torch.cat((h, encoder_outputs), 2)))

energy = energy.transpose(1, 2)

v = self.v.repeat(encoder_outputs.size(1), 1).unsqueeze(1)

attention_scores = torch.bmm(v, energy).squeeze(1)

return F.softmax(attention_scores, dim=1)

四、模型性能比较

4.1 数据规模对模型的影响

- 数据规模较小时:HMM在小数据场景下能够较快地收敛并给出相对合理的标注结果。

- 数据规模增大时:BiLSTM能够从大量数据中学习到丰富的特征,在处理大规模复杂数据时表现出色。

4.2 场景需求与模型选择

- 命名实体识别:BiLSTM + CRF在处理领域广泛、实体类型多样的文本时表现最佳。

- 对标注速度要求高且数据简单时:HMM计算复杂度相对较低,模型结构简单,适合快速推理和标注。

4.3 训练和推理成本分析

- CRF:训练成本高,需要计算和优化大量特征。

- HMM和BiLSTM:训练成本较低,HMM训练过程相对简单,BiLSTM具有高效的并行计算能力。

五、应用案例分析

5.1 命名实体识别案例

在医疗文本处理领域,BiLSTM-CRF模型被用于从电子病历数据中提取疾病名称、药物名称、症状等关键实体信息。识别结果可应用于医疗研究、临床决策支持、医疗信息系统的智能化升级等方面。

5.1.1 模型应用

- BiLSTM:从前向和后向两个方向捕捉文本中的语义信息和上下文关联,例如,在处理“肺炎”时,BiLSTM能理解其作为疾病名称的关键实体。

- CRF:考虑整个句子中标签之间的依赖关系,确保识别出的实体在语法和逻辑上的连贯性,例如,将“阿莫西林”“头孢曲松”识别为药物名称。

5.1.2 应用价值

识别结果可应用于医疗研究、临床决策支持、医疗信息系统的智能化升级等方面,提高医疗信息的管理效率。

5.2 词性标注案例

CRF在处理复杂句子结构时展现出卓越的准确性。例如,对句子“在那个阳光明媚的早晨,他带着愉悦的心情,迅速地奔跑在美丽的公园里”进行词性标注时,CRF能够准确分析每个单词的上下文信息,并综合考虑句子的整体结构和语义。

5.2.1 模型应用

- 上下文信息分析:CRF分析每个单词的上下文信息,例如,将“阳光明媚”识别为形容词短语,修饰“早晨”。

- 语法和语义关系分析:CRF综合考虑句子的整体结构和语义,例如,将“奔跑”识别为动词,并分析其与前后成分的关系。

5.2.2 应用价值

准确的词性标注结果为后续的自然语言处理任务,如句法分析、语义理解等,提供了可靠的基础。

六、序列标注任务的挑战与解决方案

6.1 数据稀疏性问题

在序列标注任务中,数据稀疏性是一个常见的挑战。特别是在处理低频词或罕见实体时,模型可能无法从有限的训练数据中学习到足够的特征。

6.1.1 解决方案

- 数据增强:通过数据增强技术,如同义词替换、随机插入、随机删除等,增加训练数据的多样性。

- 预训练语言模型:使用预训练语言模型(如BERT、GPT)作为特征提取器,能够有效缓解数据稀疏性问题。

6.2 长距离依赖问题

序列标注任务中,某些标签的预测可能依赖于较远的上下文信息。传统的RNN模型在处理长距离依赖时表现不佳。

6.2.1 解决方案

- 注意力机制:通过引入注意力机制,模型能够动态关注到与当前任务相关的远距离上下文信息。

- Transformer架构:Transformer模型通过自注意力机制,能够有效捕捉长距离依赖关系。

6.3 跨领域迁移问题

序列标注模型在一个领域上训练后,迁移到另一个领域时,性能往往会大幅下降。

6.3.1 解决方案

- 领域自适应:通过领域自适应技术,如对抗训练、领域对抗网络(DANN),使模型能够适应新领域的特征分布。

- 多任务学习:通过多任务学习,模型能够同时学习多个相关任务的特征,提升跨领域迁移能力。

七、序列标注任务的未来展望

7.1 模型架构的创新

随着深度学习技术的不断发展,序列标注任务的模型架构也在不断创新。未来,我们可以期待更多基于Transformer架构的模型在序列标注任务中的应用。

7.2 多模态融合

未来的序列标注任务可能会更多地结合多模态数据,如文本、图像、语音等。通过多模态融合,模型能够从不同模态的数据中提取更丰富的特征,提升标注的准确性。

7.3 自监督学习

自监督学习是一种无需大量标注数据的学习方法,未来有望在序列标注任务中得到广泛应用。通过自监督学习,模型能够从未标注的数据中学习到有用的特征,减少对标注数据的依赖。

结语

序列标注任务作为NLP领域的重要组成部分,随着技术的不断发展,其方法和应用也在不断演进。未来,随着人工智能技术的飞速发展,序列标注任务将在更多领域发挥更大的作用,为实现智能化的人机交互和信息处理提供更强大的技术支持。

参考文献

- Conditional Random Fields: Probabilistic Models for Segmenting and Labeling Sequence Data

- Bidirectional LSTM-CRF Models for Sequence Tagging

- Attention Is All You Need

未觉池塘春草梦,阶前梧叶已秋声。

学习是通往智慧高峰的阶梯,努力是成功的基石。

我在求知路上不懈探索,将点滴感悟与收获都记在博客里。

要是我的博客能触动您,盼您 点个赞、留个言,再关注一下。

您的支持是我前进的动力,愿您的点赞为您带来好运,愿您生活常暖、快乐常伴!

希望您常来看看,我是 秋声,与您一同成长。

秋声敬上,期待再会!