博主介绍:✌程序员徐师兄、7年大厂程序员经历。全网粉丝12w+、csdn博客专家、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和毕业项目实战✌

🍅文末获取源码联系🍅

👇🏻 精彩专栏推荐订阅👇🏻 不然下次找不到哟

2022-2024年最全的计算机软件毕业设计选题大全:1000个热门选题推荐✅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

文章目录

前言

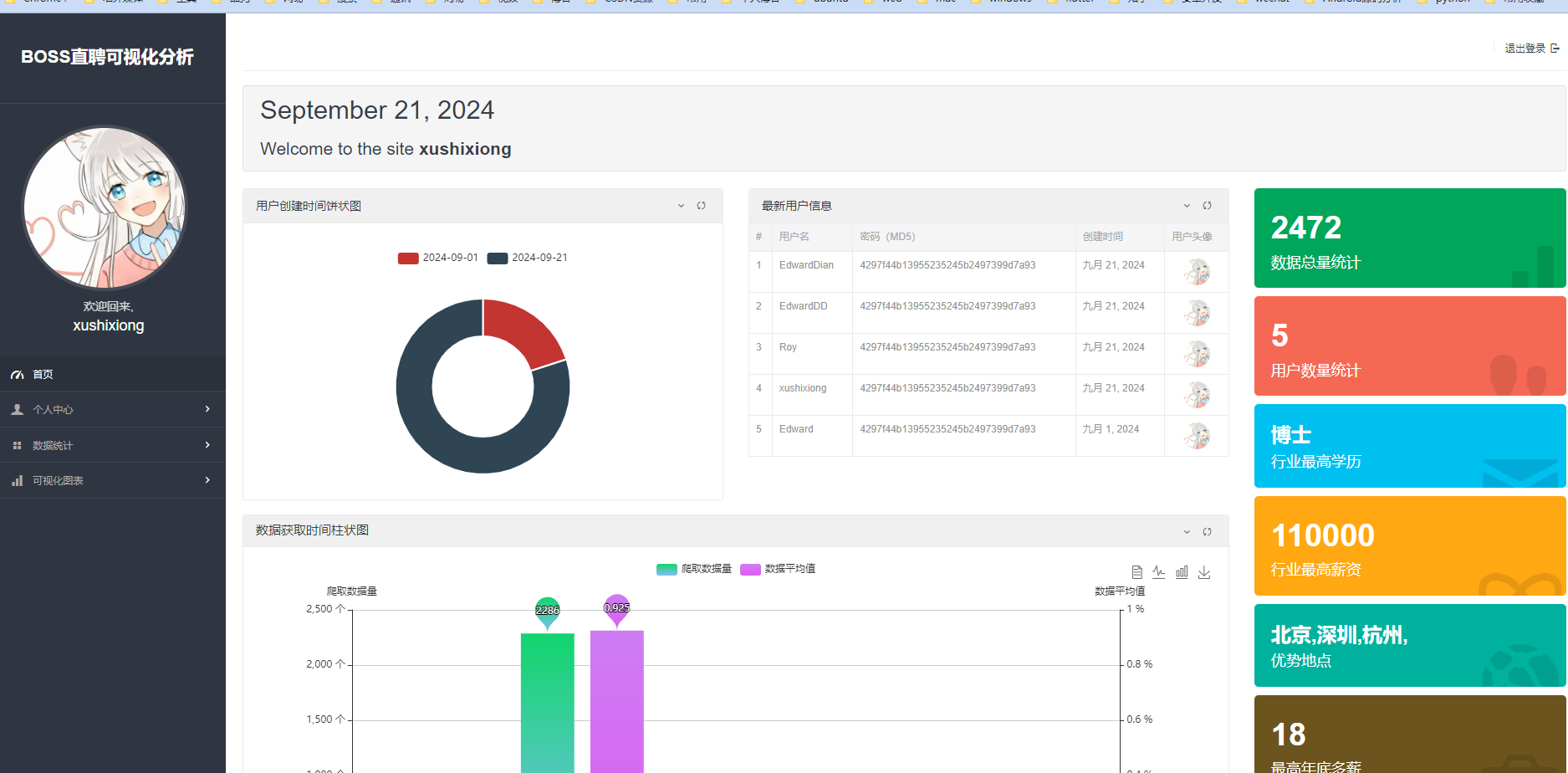

大家好!今天给大家带来的是一个基于 Python + Django 的招聘数据可视化系统 —— Boss直聘招聘数据分析 项目。该项目结合了 Django 框架、MySQL 数据库以及 Selenium 爬虫技术,通过爬取 Boss 直聘网站上的招聘信息,并进行清洗与可视化分析。界面美观,功能强大,适合想要了解如何通过爬虫抓取数据并在 Django 中进行展示的开发者。

1. 项目涉及的技术栈

后端语言与框架

- Python(Django)

前端页面布局与展示

- Bootstrap(响应式布局,快速开发)

数据可视化

- ECharts(交互式图表)

- HTML 与 CSS

数据存储

- MySQL 数据库(用于存储招聘信息)

数据获取方式

- Selenium 爬虫(动态网页抓取)

- XPath(定位网页元素)

2. Django 介绍

Django 的背景与特点

Django 是一个由 Adrian Holovaty 和 Simon Willison 于 2005 年开发的开源 Web 框架。最初是为了快速开发新闻类网站而设计的,至今已经广泛应用于各类网站的开发。Django 采用 MTV(Model-Template-View) 架构模式,功能丰富且安全性高,是一个非常适合快速开发的框架。

Django 的核心优势

- 快速开发:自带丰富的功能,可以迅速搭建一个完整的 Web 项目。

- 强大的 ORM 系统:使得数据库操作更加简洁。

- 自动生成 Admin 界面:自动生成后台管理系统,极大提高开发效率。

- 多数据库支持:支持 PostgreSQL、MySQL、SQLite 等主流数据库。

- 内置安全机制:防止 SQL 注入、跨站请求伪造(CSRF)、跨站脚本(XSS)等。

- 良好的社区与文档支持:有着非常活跃的社区和详尽的官方文档,极大帮助开发者快速上手。

Django 的不足之处

- 学习曲线:对于初学者来说,Django 的学习曲线相对较陡。

- 较重的框架:对于简单的小型应用,Django 可能显得有些“重”。

- 定制性问题:虽然 Django 提供了大量开箱即用的功能,但在某些情况下,这些内置功能会限制项目的高度定制化。

总体来说,Django 是一个功能强大且快速开发的 Web 框架,适合用来构建复杂且功能完备的应用。

3. Python 爬虫功能实现

爬虫技术允许我们模拟用户浏览器的行为,从网页中提取信息。Selenium 是一个广泛应用于网页自动化操作的工具,它不仅可以用于网页抓取,还能够模拟用户点击、输入等行为。通过 Selenium 和 XPath,我们可以高效地从 Boss 直聘等网站上抓取招聘数据。

爬虫基本原理

爬虫的工作原理通常是通过模拟浏览器行为,向目标网站发送 HTTP 请求,获取网页内容,然后从中提取我们需要的数据。爬虫程序还需要具备网页解析、数据存储和反爬虫策略等功能。在本项目中,我们使用 Selenium 来抓取动态加载的网页数据,利用 BeautifulSoup 来解析静态网页数据。

爬虫技术的挑战与应对

- 反爬虫机制:目标网站可能会对爬虫进行防护措施(例如通过验证码、IP 屏蔽等方式),我们需要通过使用代理 IP 或模拟人类行为等方式来绕过这些限制。

- 数据清洗:爬取的数据往往是不规范的,需要进行数据清洗和格式化,以便后续分析。

爬虫代码示例

使用 Requests 库进行简单网页抓取

import requests

from bs4 import BeautifulSoup

url = 'http://example.com'

response = requests.get(url)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.find('title').text

print('网页标题:', title)

for link in soup.find_all('a'):

print(link.get('href'))

else:

print('请求失败,状态码:', response.status_code)

使用 Selenium 进行动态网页抓取

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.common.keys import Keys

import time

driver = webdriver.Chrome()

driver.get('http://example.com')

# 等待页面加载

time.sleep(3)

# 查找并输入关键词进行搜索

input_element = driver.find_element(By.NAME, 'q')

input_element.send_keys('Python')

input_element.send_keys(Keys.RETURN)

time.sleep(3)

print(driver.title)

# 关闭浏览器

driver.quit()

使用代理与请求头进行爬取

import requests

url = 'http://example.com'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.110 Safari/537.36'

}

proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'https://10.10.1.10:1080',

}

response = requests.get(url, headers=headers, proxies=proxies)

if response.status_code == 200:

print(response.text)

else:

print('请求失败,状态码:', response.status_code)

注意事项

- 在使用爬虫时,务必遵守目标网站的 robots.txt 协议,避免过频繁地访问同一网站,以免造成不必要的负担。

- 合理设置请求间隔,使用代理 IP 等反爬虫技术来提高稳定性。

4. 项目功能详解

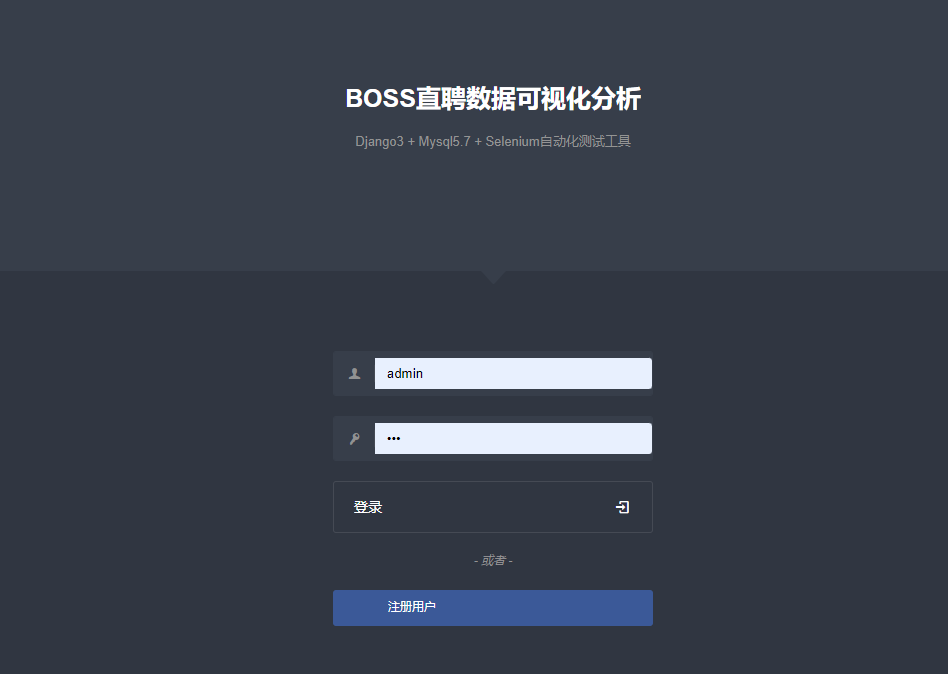

1. 登录与注册

该系统支持用户注册和登录功能,爬取的数据会存储在 MySQL 数据库中,数据库中有 三个表:用户信息表、招聘信息表、岗位收藏表。用户可以注册并登录查看自己收藏的招聘信息。

2. 首页展示与导航

登录成功后,用户将进入系统首页,左侧为导航栏,展示个人中心、数据统计、招聘数据等模块。用户可以查看自己的个人信息、修改密码,查看数据统计,分析招聘数据。

3. 招聘数据展示与分页

招聘信息是通过爬虫抓取并存储在 MySQL 数据库中的,可以通过分页展示。每页展示多个岗位信息,用户可以进行翻页查看不同的数据。

4. 数据可视化

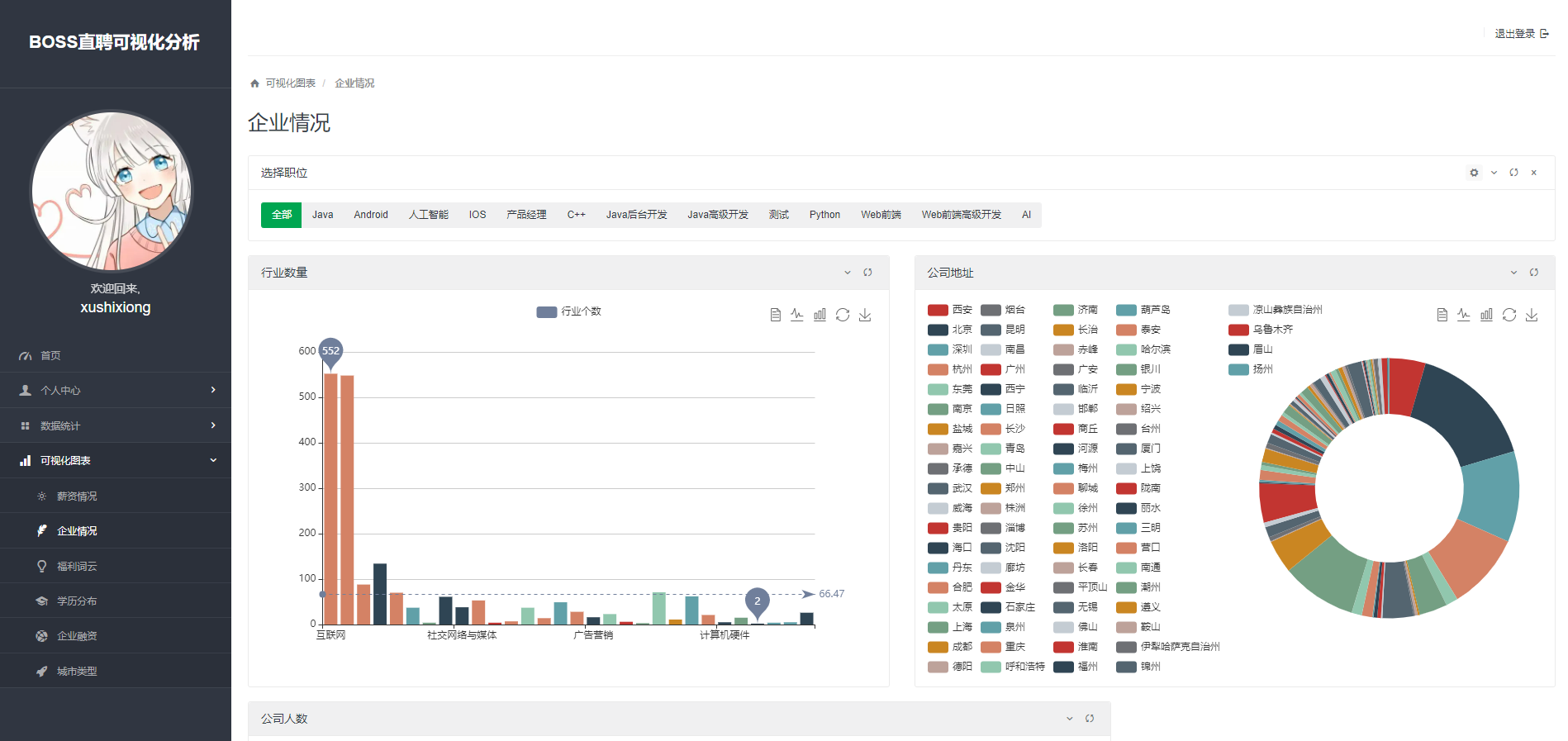

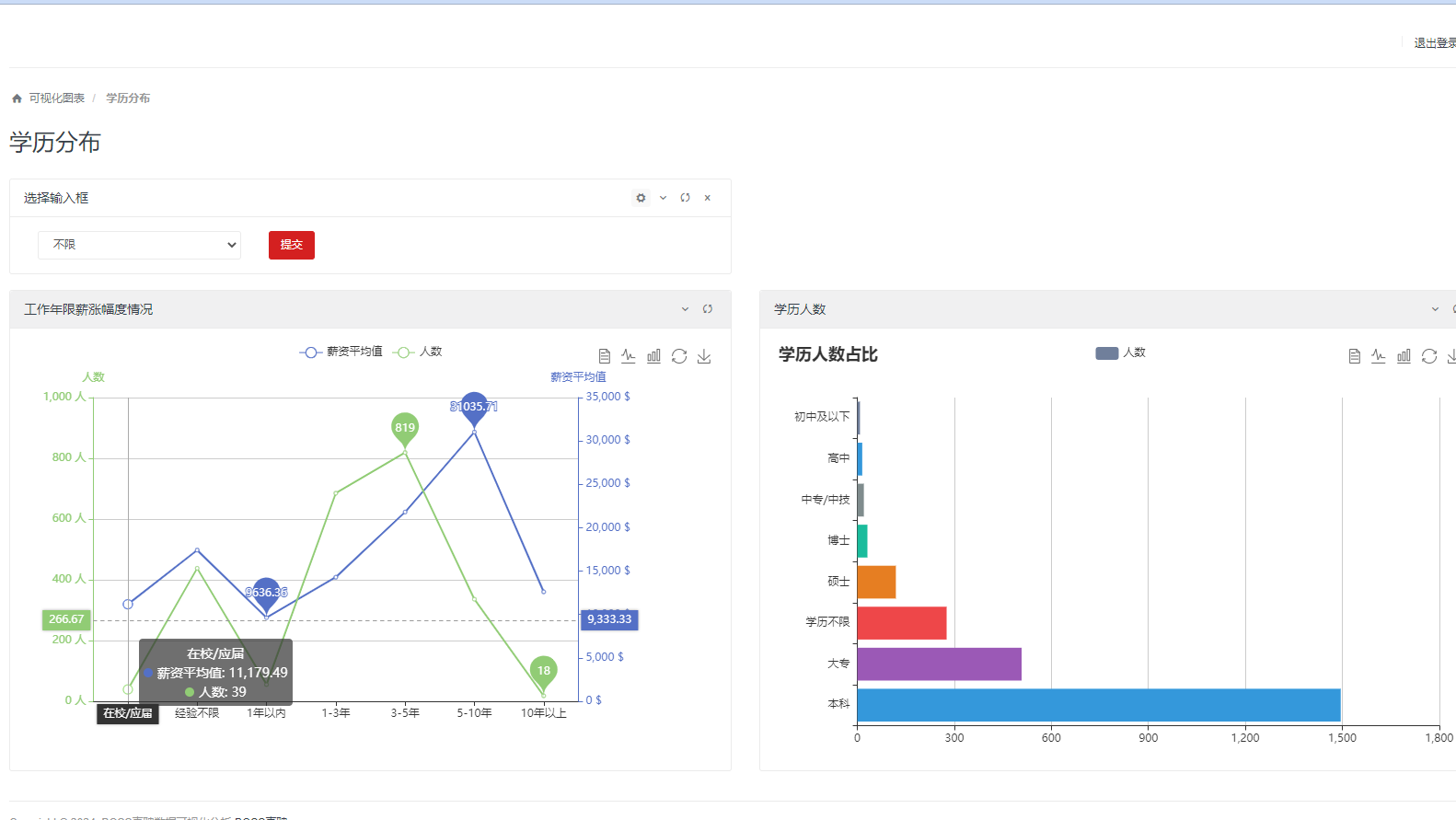

项目提供了多种数据可视化功能,帮助用户更好地理解招聘信息的分布情况:

- 薪资分析:展示不同岗位的薪资分布情况。

- 企业信息:展示不同公司招聘信息的分布与分析。

- 学历要求分布:展示不同职位的学历要求分布情况。

5 推荐阅读

6 源码获取

点赞、收藏、关注、评论啦!查看👇🏻获取联系方式👇🏻

精彩专栏推荐订阅👇🏻 不然下次找不到哟

2022-2024年最全的计算机软件毕业设计选题大全:1000个热门选题推荐✅

Java项目精品实战案例《100套》

Java微信小程序项目实战《100套》

感兴趣的可以先收藏起来,还有大家在毕设选题、项目以及文档编写等相关问题都可以留言咨询,希望帮助更多的人。