生成式人工智能带来了三类新风险:内容异常、数据保护和人工智能应用程序安全。使用或构建 GenAI 应用程序的 IT 领导者可以利用这项研究来了解市场动态,并评估新兴的 GenAI TRiSM 技术和解决新风险的提供商。

主要发现

-

在企业应用中集成大型语言模型(LLM )和其他生成式人工智能(GenAI)模型带来了三类新的风险:输入和输出风险、数据泄露和人工智能应用程序漏洞。

-

构建并通常托管 GenAI 模型的供应商并未提供一套完整的控制措施来减轻这些风险。相反,用户需要购买能够提供此类控制措施的解决方案来增强供应商有限的控制措施。

-

IT 领导者必须信任 LLM 供应商为最终用户的数据提供保护机制,而无需验证这些供应商的安全和隐私控制。

-

GenAI 信任、风险和安全管理 (TRiSM) 解决方案市场正在快速增长,但新兴解决方案仍未经过大量测试。目前,它的目标是保护 LLM 使用情况,而不是保护多模式模型的使用情况。

建议

-

继续使用已知的传统安全控制来保护敏感信息、应用程序堆栈和资产,但要认识到它们无法减轻LLM特有的风险,例如响应中的不准确、煽动性或受版权保护的输出。

-

设置概念证明来测试三个类别中新兴的 GenAI TRiSM 产品,以增强您的传统安全控制,并在它们按要求执行后将其应用于生产应用程序。

-

使用内容异常检测产品来减轻输入和输出风险,以执行可接受的使用政策,并防止不必要或非法的模型完成和 LLM 应用程序响应损害您组织的决策、安全和保障。

-

评估使用AI 应用安全产品来保护您的组织免受利用新的 GenAI 威胁载体来损害您的组织及其资产的黑客的侵害。

GenAI TRiSM市场仍是整个 AI TRiSM 市场的早期市场子集。在本创新指南中,我们定义了该市场的 GenAI 应用程序运行时执行部分及其功能,并列出了支持它的一些供应商。

市场定义

GenAI TRiSM 市场包括多个软件和服务部门,为 GenAI 应用程序和模型交互的采用者提供安全性、数据保护和风险缓解支持。GenAI TRiSM 工具包括以下解决方案:

-

内容异常检测

-

数据保护

-

人工智能应用安全

这些工具是对 GenAI 模型、应用程序和代理的构建者或所有者实施的相关 TRiSM 措施的补充。

GenAI TRiSM 市场是更大的AI TRiSM 市场的一个子集,其中包括多个软件部分,这些部分只能由 AI 模型、应用程序或代理的构建者或所有者实现。这些构建者或所有者创建、维护和管理这些实体。AI 模型的构建者或所有者有时是使用或与相同 AI模型交互的相同实体。对于大型基础模型,模型的用户通常与构建或拥有模型的人不同。

市场地图

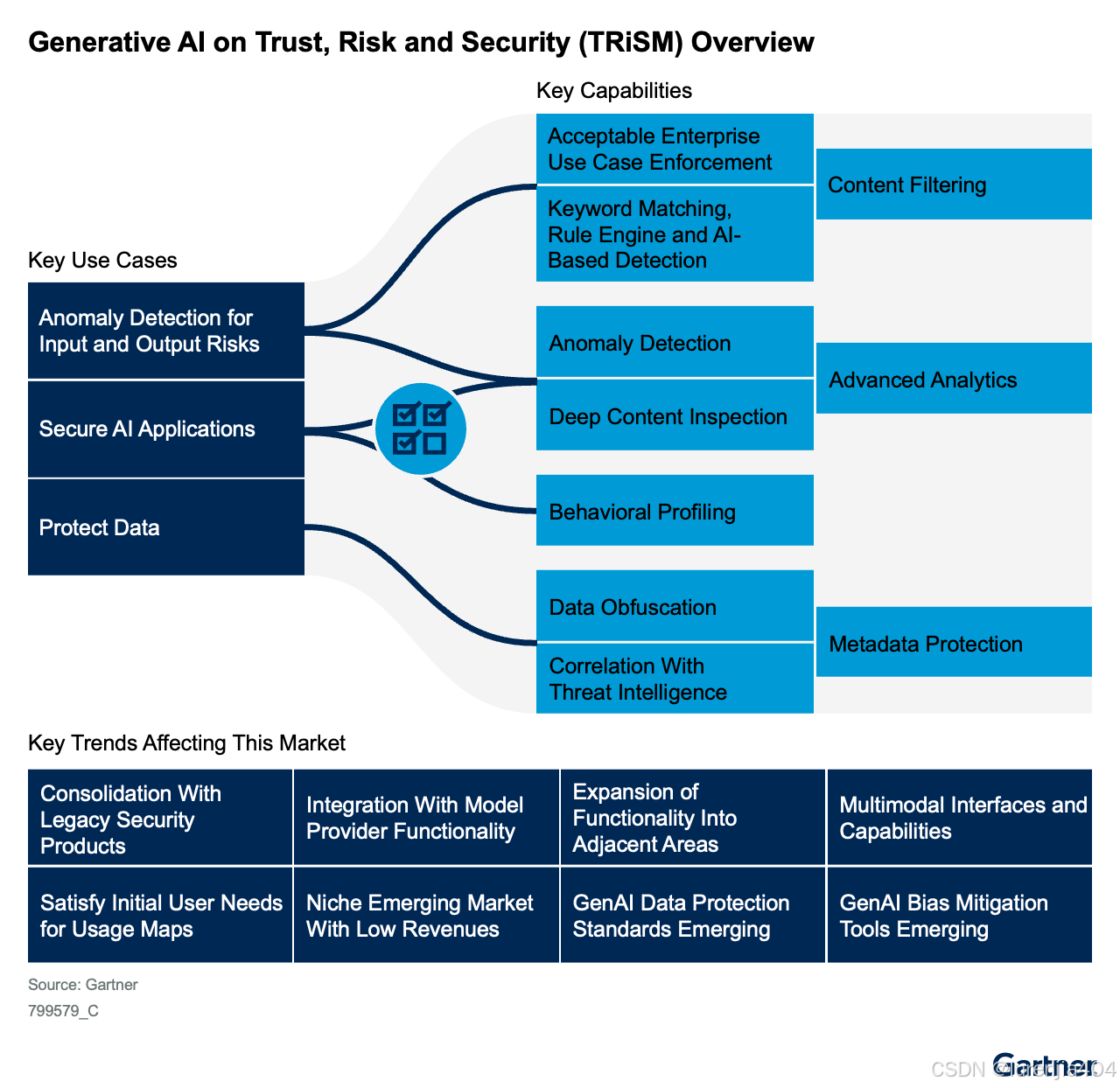

图 1:信任、风险和安全生成 AI (TRiSM) 概述

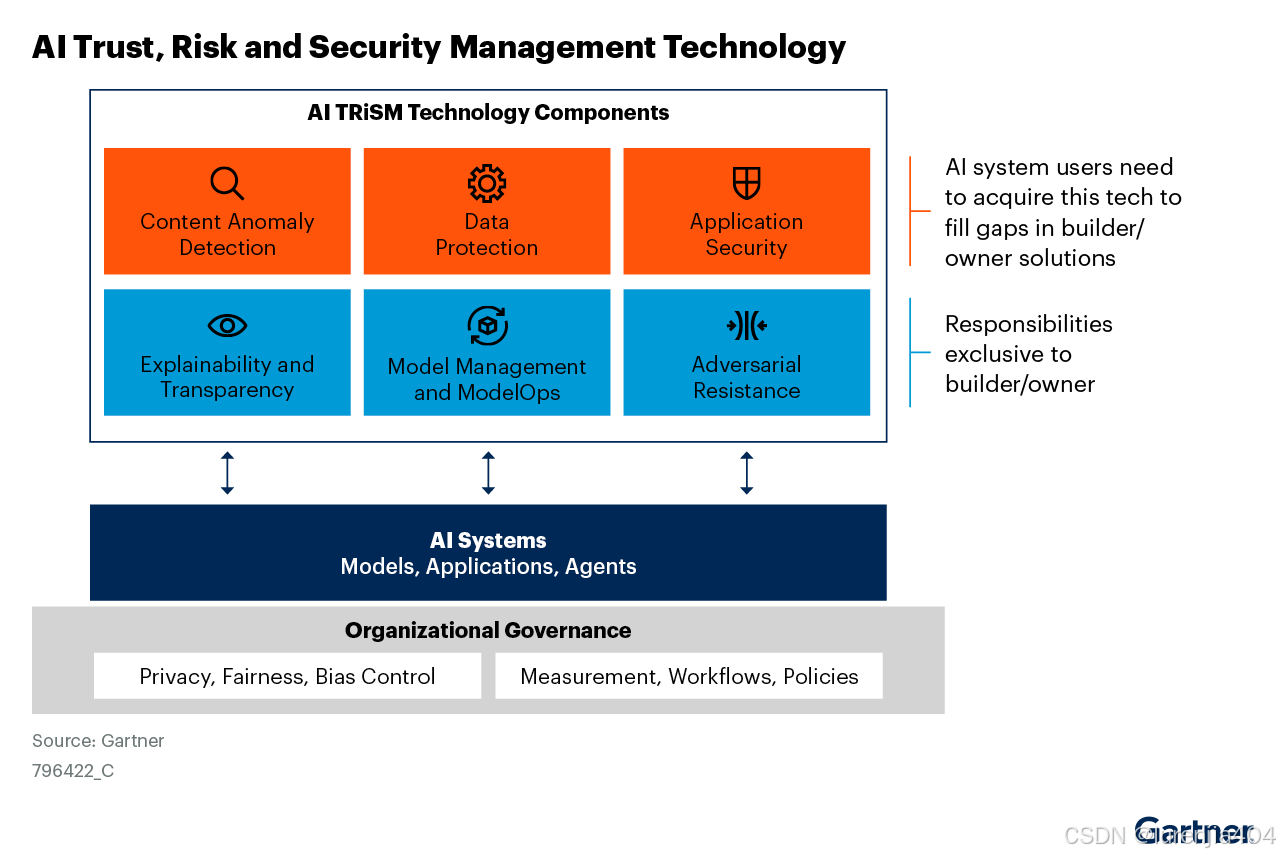

我们在 2023 年更新了我们的 AI TRiSM 架构,以区分 AI模型、应用程序和代理的构建者或所有者以及集成和使用它们的所有各方(包括构建者或所有者)独有的不同 TRiSM 职责。图 2 标识了这两方用于管理 AI 模型、应用程序和代理的这些方面的技术组件。

图2:AI信任、风险和安全管理技术

本研究针对支持 GenAI 的 AI 系统用户,详细阐述了橙色行中的三种 TRISM 技术组件,并列出了每个类别中的代表性供应商。《AI 信任、风险和安全管理市场指南》分析了这些功能,并在浅蓝色 AI TRiSM 架构行中列出了三种技术类别中的代表性供应商。

市场动态

使用托管的 LLM 和 GenAI 模型可以带来许多好处,但用户还必须应对三个主要类别的新独特风险:

1. 内容异常检测

o 不可接受或恶意使用

o 通过提示或其他方式传输的企业内容导致机密数据输入遭到泄露

o 幻觉或不准确、非法、侵犯版权或其他不受欢迎的输出,影响企业决策

2. 数据保护

o 托管供应商环境或内部自我管理环境中的数据泄露和机密性受损

o 无法管理外部托管环境中的隐私和数据保护政策

o 由于第三方模型的“黑箱”性质,难以进行隐私影响评估并遵守各个地区法规

3. 人工智能应用安全

o 对抗性提示攻击

o 矢量数据库攻击

o 黑客访问模型状态和参数

2023 年,我们对 700 多名网络研讨会参与者进行了调查,了解他们最担心的 GenAI 风险,调查验证了这些风险类别,并强调数据隐私是用户最担心的头号风险。

在使用外部托管的 LLM 和其他 GenAI 模型时,这些风险会加剧,因为企业缺乏直接控制其应用程序流程和数据处理和存储的能力。但企业托管和直接控制的内部模型仍然存在风险,尤其是在缺乏安全和风险控制的情况下。

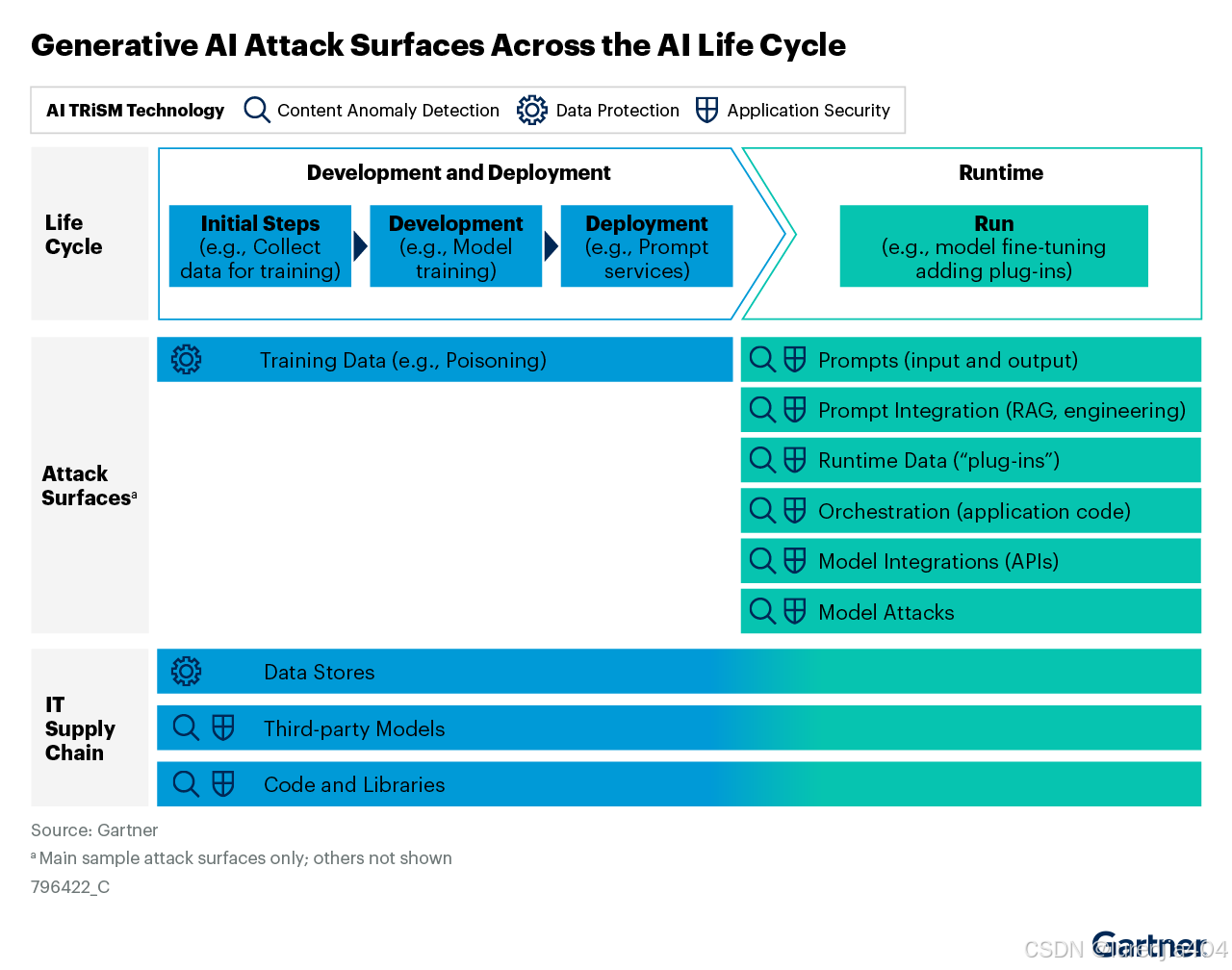

这三种风险类别在 AI 应用程序和模型运行时会向用户发出挑战。参见图 3,了解它们在 AI 模型生命周期中的表现,并注意影响 GenAI 用户的相关运行时攻击和危害面。这些新的攻击面推动了新 GenAI TRiSM 市场的发展。

图 3:整个 AI 生命周期中的生成 AI 攻击面

针对这些攻击和危害面实施缓解控制的责任主要分为两方,根据他们在人工智能模型、应用程序或代理方面的角色进行定义:

1. 人工智能模型、应用程序或代理的构建者或所有者——参与生命周期前三个组成部分的实体,如上图浅蓝色所示。

2. 与 AI 模型、应用程序或代理集成的用户(人类或机器)——参与生命周期运行时组件的实体,如上图浅绿色所示。

通常,建造者/业主和使用者是同一个实体。

市场演变

AI TRiSM 市场已经支离破碎,并未产生供应商所期望的收入。为了寻找更多的收入来源,AI TRiSM 供应商继续通过扩展到相邻的 GenAI TRiSM 类别(例如,扩展到 AI 应用程序安全或内容异常检测)来开发功能。

此外,AI TRiSM 供应商继续尝试向数据科学家和 AI 工程师展示其产品的价值。供应商希望在 AI 项目生命周期的早期就说服他们使用这些产品,而不是仅在项目投入生产时才部署它们。他们的卖点是正确的,即在 AI 项目中从一开始就将 TRiSM 构建到 AI 项目中可以提高 AI 项目的性能。

尽管如此,TRiSM 产品的普及仍然有限。2023年初开始的 ChatGPT 和 GenAI 的快速采用加速了企业对 AI TRiSM 产品的需求,因为最终用户组织现在更热切地寻求实施具体的措施和控制措施来减轻各种风险。因此,许多提供异常检测、模型监控和 AI 应用程序安全性的 AI TRiSM 供应商已迅速转向扩展其产品线以支持 GenAI TRiSM 功能。这些供应商包含在“代表性供应商”部分的表 1 中。

我们的期望

我们认为,许多企业最初将通过异常检测或安全 AI 应用程序来获取降低输入/输出风险的解决方案,以了解企业对 GenAI 应用程序和模型的使用情况。这包括使用现成的应用程序(例如 ChatGPT)或通过其他集成点(例如插件、提示或 API)进行交互。许多组织的首要任务是了解企业与 GenAI 的交互;这些产品可以提供这些交互的良好图谱。建立图谱后,组织可以逐步部署降低风险和安全威胁的核心功能。

我们预计 GenAI TRiSM 市场收入将在 2024 年稳步增长。我们还预计,到 2026 年底,当供应商将使用数据和内容异常检测的输入/输出风险缓解与 AI 应用程序安全相结合时,该市场将大幅整合。此外,我们预计大型现有安全供应商(尤其是在安全服务边缘和数据丢失预防业务方面)将收购 GenAI 初创公司,以扩大他们为客户提供的保护。

随着时间的推移,我们预计 GenAI TRiSM 供应商将扩展其产品以保护多模态模型的使用,而不仅仅是 LLM。随着企业对多模态模型的使用增加,这将在未来几年自然发生。

商业利益(用例)

传统的控制措施不足以减轻使用托管 GenAI 模型(例如 LLM)所带来的风险。用户在三个共享责任类别中遇到风险(如图 2 中 AI TRiSM 技术组件的顶行所示)。创业型第三方供应商正在帮助解决三个不同用例的这些漏洞。

使用内容异常检测来管理输入和输出风险

-

输入风险:如果将提交给 GenAI 模型的信息和数据发送到安全性和保护程度不够的环境(例如,如果它们在传输过程中未加密,如果存储时处于静止状态),则可能导致数据泄露。还必须对 GenAI 模型的输入进行筛选,以确保它们符合企业的可接受使用政策。如今,大多数此类输入都采用交互式提示的形式。安全主管必须解决利用更自动化输入形式的应用程序的输入和输出风险,例如来自其他应用程序的 API 调用以及直接传输到软件代理的输出。

o 在本地托管模型时,企业可以避免将数据提交到第三方环境带来的风险。但是,企业仍然必须保护其托管的数据。

-

输出风险:GenAI 模型的输出不可靠,因为事实错误和幻觉的发生率不可预测。输出也可能存在偏差,可能包含版权材料或其他不受欢迎、恶意、不合法或非法的信息。这使企业面临因非法使用 GenAI 模型应用程序输出的专有材料或做出错误决策而被起诉的风险。

此类别的供应商通常旨在减轻 LLM 输入和输出风险。(目前,其他类型的 GenAI 模型不属于其范围)。他们通过提供异常检测和内容过滤来实现这一目标,这些异常检测和内容过滤根据基于规则的系统或 AI 模型(位于企业和托管 LLM 之间)中体现的预设企业策略筛选输入和输出。这些异常检测器和内容过滤器会调解和验证针对它们的信息流。

管理数据保护风险,尤其是外部环境固有的风险

使用私人、专有、敏感或机密信息作为托管 GenAI 模型的输入存在数据泄露风险,并且可能违反现有法规。组织必须在托管这些供应商的模型或应用程序的环境中监控和执行隐私、数据机密性和治理。

当企业在本地托管模型时,由于不使用模型,因此可以自动降低第三方环境中的数据泄露风险。但是,他们仍然必须考虑所用(个人)数据的合法性,并保护所有处理和托管的数据——尤其是当数据将与外部各方(客户、合作伙伴)共享时。

数据保护领域的新兴供应商仍然很少。他们提供工具来加密和/或以其他方式混淆发送到托管矢量数据库、LLM 或应用程序等的数据。

通过保护新的 GenAI 攻击媒介来管理AI 应用程序的安全风险

AI 应用程序包括用于协调模型使用的新组件。这带来了传统应用程序安全控制尚未解决的安全威胁,例如:

-

对抗性提示,包括提示护栏“劫持”和提示注入攻击

-

矢量数据库泄露

-

恶意黑客访问模型状态和参数

-

与第三方应用程序模型的易受攻击和可利用的集成点(例如,API 调用或插件和其他连接器)

-

软件供应链风险

许多组织正在利用其现有的安全服务边缘 (SSE) 或数据丢失防护 (DLP) 提供商来过滤对 GenAI Web 应用程序的访问和输入。此类别的供应商使用一系列技术来扫描、检测和预防与第三方托管的 GenAI 应用程序和模型交互(直接通过提示或通过企业应用程序)所特有的网络安全风险。

管理风险

与新兴市场的新兴创业公司或小型供应商合作时,供应商生存风险是固有的,因为从长远来看,这些供应商可能无法在财务上维持自身发展。要管理这种风险,请确保您拥有自己的数据和逻辑,并且如果供应商的情况发生变化,可以随时从供应商的平台中提取数据。此外,请确保您彻底了解供应商提供的功能,以便您可以更轻松地过渡到类似的供应商,同时最大限度地减少业务中断。

持续监控您的供应商在市场中的地位以及其增长和盈利能力,并在出现危险信号时准备 B 计划。

按照市场演变部分所述为市场整合做好准备,如果您的企业倾向于使用更少、更成熟、财务稳定的供应商,请使用更大的现任安全供应商来扩展他们的产品组合以管理 GenAI TRiSM 风险。

最后,管理供应商无意(或有意)泄露或泄露您的数据的风险。仔细检查产品是否存在与安全和风险相关的漏洞,并通过合同规定供应商只有在您明确批准的情况下才能访问您的数据。确保实施技术控制,以默认配置禁用供应商访问您的数据,无论产品是在本地还是在云中运行。

代表供应商

本创新指南中列出的供应商并非包含所有供应商,旨在帮助您更好地了解市场及其产品。

表1 :代表性 GenAI TRiSM 供应商

| 供应商 | 内容异常检测 | 隐私和数据保护 | 人工智能应用安全 |

| ActiveFence | 是的 | ||

| Adversa AI | 是的 | ||

| AGAT Software | 是的 | 是的 | |

| Aim Security | 是的 | 是的 | |

| Apex | 是的 | 是的 | 是的 |

| Aporia | 是的 | 是的 | |

| Arize AI | 是的 | ||

| Arthur | 是的 | ||

| Backplain | 是的 | ||

| Bosch AIShield | 是的 | ||

| CalypsoAI | 是的 | 是的 | |

| Copyleaks | 是的 | ||

| Cranium | 是的 | 是的 | |

| Deepchecks | 是的 | ||

| DeepKeep | 是的 | 是的 | 是的 |

| Duality | 是的 | ||

| eSentire | 是的 | ||

| Fiddler AI | 是的 | ||

| Flow Security (2024年3月被 CrowdStrike 收购) | 是的 | ||

| Galileo LLM Studio | 是的 | ||

| Harmonic Security | 是的 | ||

| HiddenLayer | 是的 | ||

| Holistic AI | 是的 | 是的 | |

| IronCore Labs | 是的 | ||

| Klarytee | |||

| Lakera | 是的 | ||

| Lasso Security | 是的 | 是的 | 是的 |

| Lumeus | 是的 | 是的 | 是的 |

| NVIDIA NeMo Guardrails | 是的 | ||

| Patented | 是的 | ||

| 是的 | 是的 | ||

| Preamble | 是的 | ||

| Privya | 是的 | ||

| Prompt Security | 是的 | 是的 | 是的 |

| Protect AI | 是的 | 是的 | |

| Protopia AI | 是的 | ||

| Rebuff AI | 是的 | ||

| Robust Intelligence | 是的 | 是的 | |

| Securiti | 是的 | 是的 | 是的 |

| Skyflow | 是的 | ||

| TrojAI | 是的 | 是的 | |

| TruEra (2024 年 5 月宣布收购 SnowFlake 的协议) | 是的 | ||

| 是的 | 是的 | 是的 |

资料来源:Gartner(2024 年 9 月)